7B新王登基!Zamba 2完胜同级模型,推理效率比Llama 3提升20%,内存用量更少

7B新王登基!Zamba 2完胜同级模型,推理效率比Llama 3提升20%,内存用量更少Zamba2-7B是一款小型语言模型,在保持输出质量的同时,通过创新架构实现了比同类模型更快的推理速度和更低的内存占用,在图像描述等任务上表现出色,能在各种边缘设备和消费级GPU上高效运行。

Zamba2-7B是一款小型语言模型,在保持输出质量的同时,通过创新架构实现了比同类模型更快的推理速度和更低的内存占用,在图像描述等任务上表现出色,能在各种边缘设备和消费级GPU上高效运行。

Mistral 7B诞生一周年之际,法国AI初创公司Mistral再次连发两个轻量级模型Ministral 3B和Ministral 8B,性能赶超Llama 3 8B。

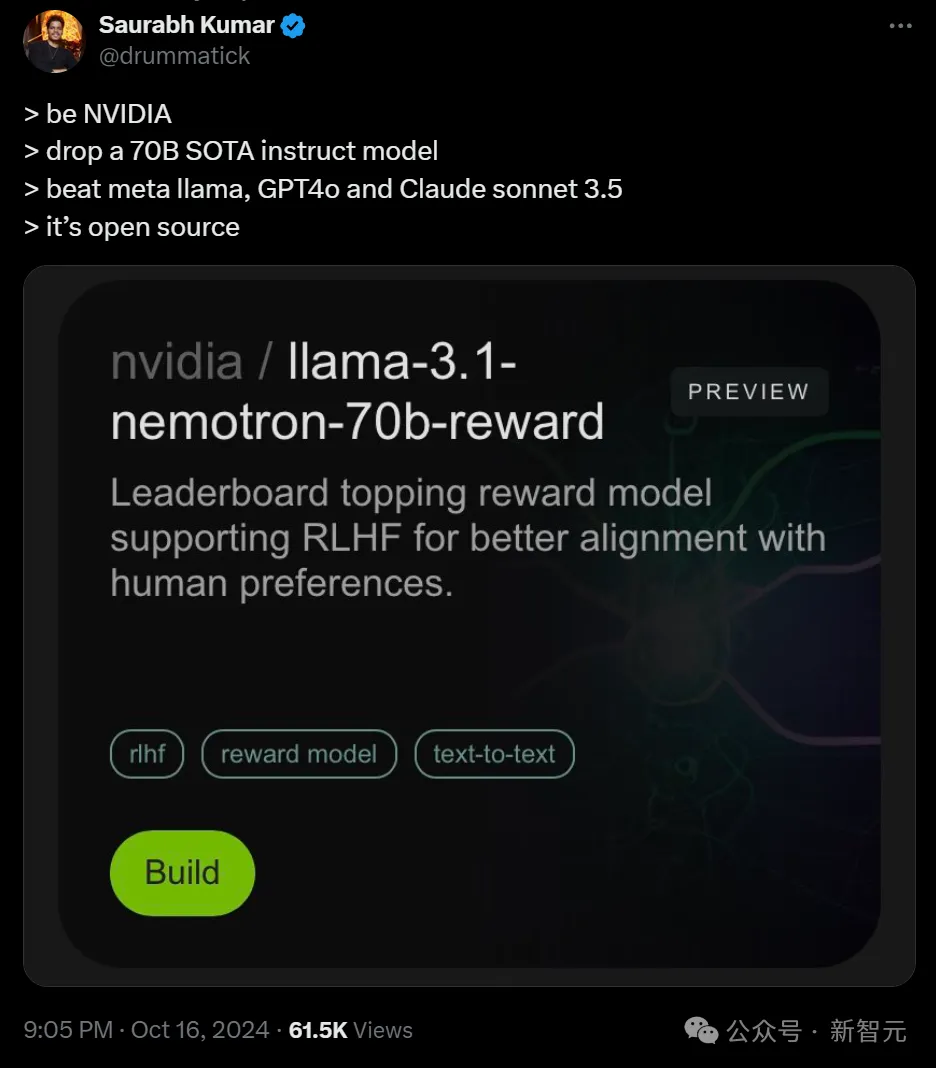

英伟达开源了超强模型Nemotron-70B,后者一经发布就超越了GPT-4o和Claude 3.5 Sonnet,仅次于OpenAI o1!AI社区惊呼:新的开源王者又来了?业内直呼:用Llama 3.1训出小模型吊打GPT-4o,简直是神来之笔!

欧洲的OpenAI,也不Open了。

微软 10 年「老兵」选择离开。

大语言模型市场的整合与差异:大语言模型市场存在整合的趋势。一方面,人工智能发展的基础产业是资本密集型的,市场整合对于大语言模型市场的资本支撑是必要的。另一方面,为尽可能提高算法的泛化能力,单个大语言模型也需要集成多种创新功能。市场集中度的提高使得企业需要进一步考虑大语言模型的差异化。

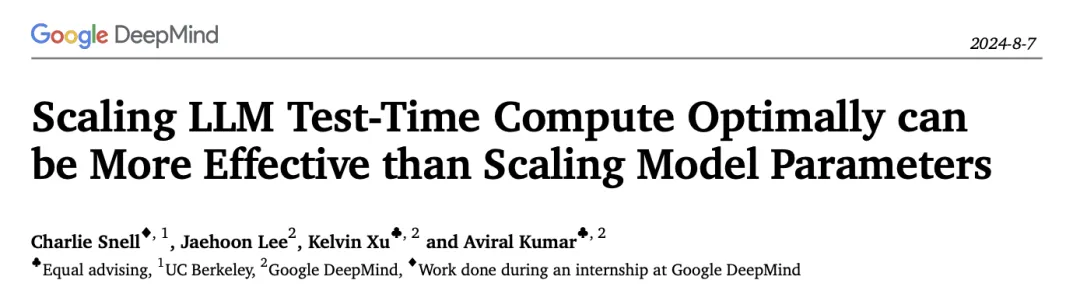

不必增加模型参数,计算资源相同,小模型性能超过比它大14倍的模型!

你敢相信 4B 参数小模型,性能却超越千亿量级的 GPT-3.5 !OpenAI、谷歌、微软、苹果等一众海内外巨头还没做到的事,被一家中国大模型公司抢先了!

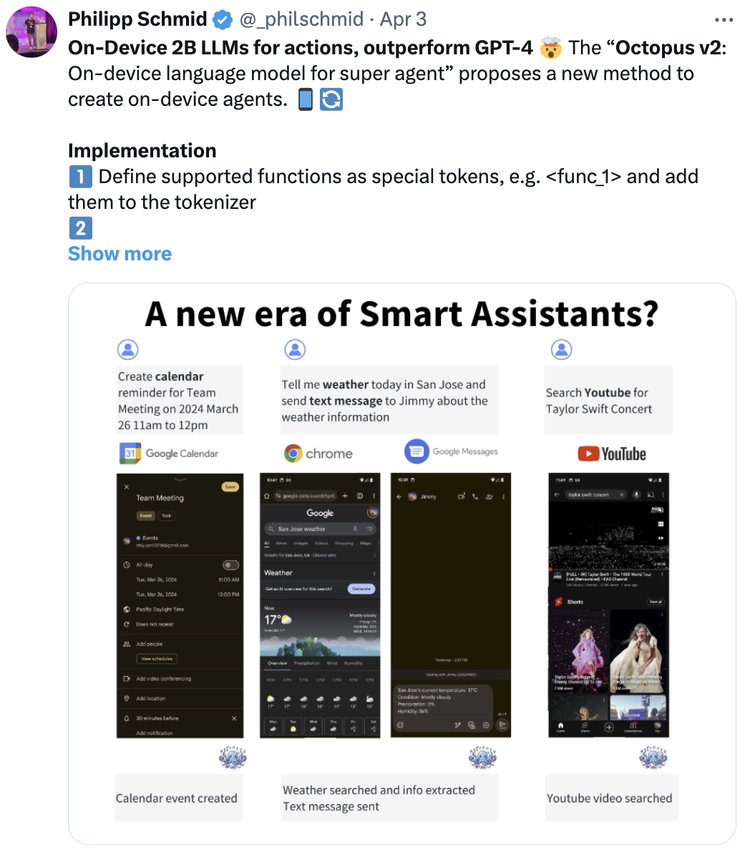

比OpenAI最强的GPT-4o更快,函数调用能力与GPT-4相当,同时比它小N倍,且只需要一张卡来做推理。

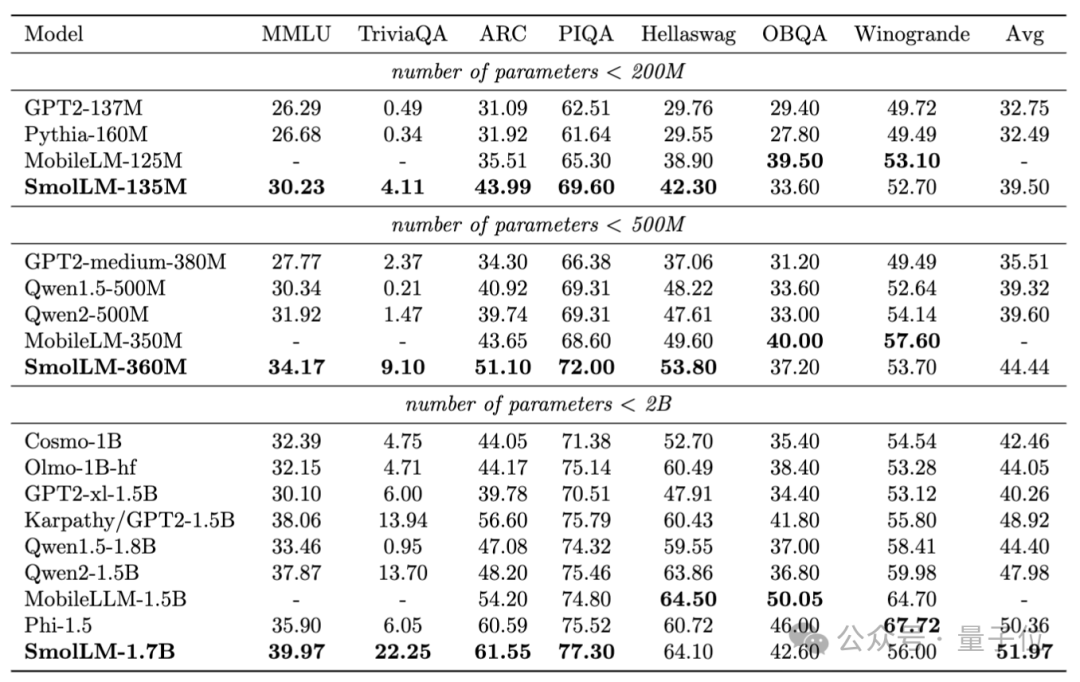

浏览器里直接能跑的SOTA小模型来了,分别在2亿、5亿和20亿级别获胜,抱抱脸出品。