Robinhood创始人再创业研发超级数学AI,已接近国际数学奥赛选手,红杉领投近亿美金

Robinhood创始人再创业研发超级数学AI,已接近国际数学奥赛选手,红杉领投近亿美金人工智能虽然其提供了广泛的信息,却缺乏解决复杂问题所需的深入、结构化的推理能力,同时还存幻觉的局限。形式逻辑和相关数学工具为 AGI 的逻辑推理能力提供了必要的理论基础和技术支撑。

人工智能虽然其提供了广泛的信息,却缺乏解决复杂问题所需的深入、结构化的推理能力,同时还存幻觉的局限。形式逻辑和相关数学工具为 AGI 的逻辑推理能力提供了必要的理论基础和技术支撑。

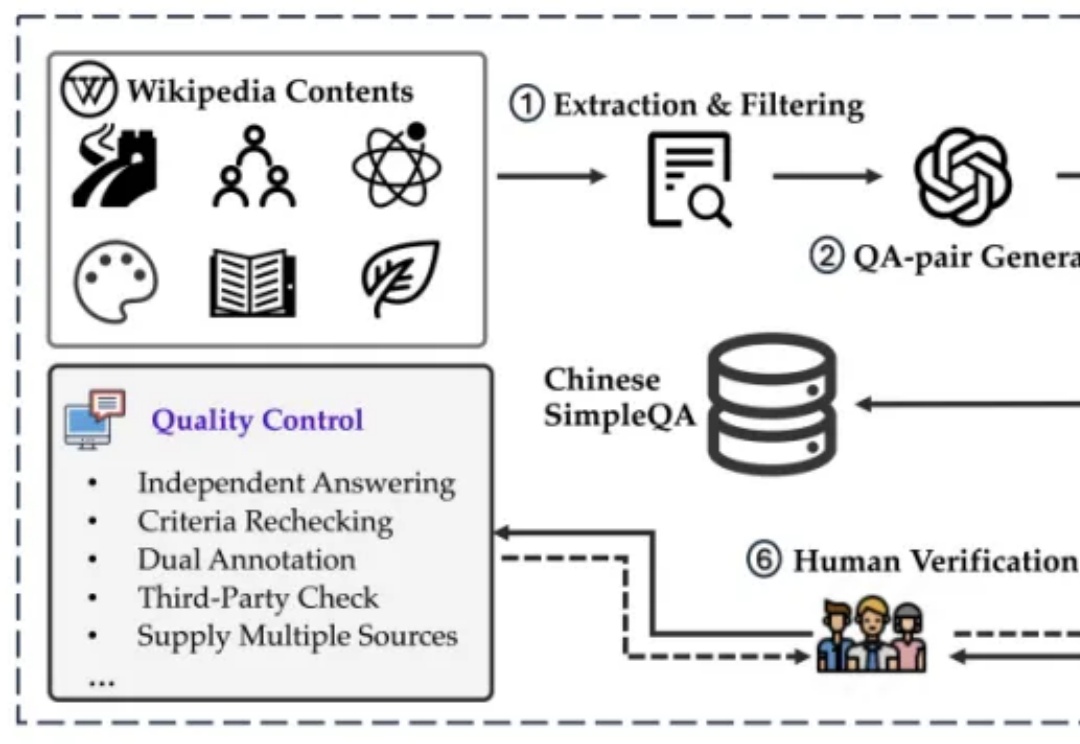

如何解决模型生成幻觉一直是人工智能(AI)领域的一个悬而未解的问题。为了测量语言模型的事实正确性,近期 OpenAI 发布并开源了一个名为 SimpleQA 的评测集。而我们也同样一直在关注模型事实正确性这一领域,目前该领域存在数据过时、评测不准和覆盖不全等问题。例如现在大家广泛使用的知识评测集还是 CommonSenseQA、CMMLU 和 C-Eval 等选择题形式的评测集。

在AI来了之后,其实对各行各业的挑战都非常大,因为很多情况都是第一次出现,之前并没有案例可以参考。例如我这两天看到我的律师同学转发了一条新闻,是关于一群懂技术的律师利用AI的漏洞来牟利,非常有代表性,我给大家简单聊一下。

“过去24个月,AI行业发生的最大变化是什么?是大模型基本消除了幻觉。”11月12日,百度创始人李彦宏在百度世界2024大会上,发表了主题为《应用来了》的演讲,发布两大赋能应用的AI技术:检索增强的文生图技术(iRAG)和无代码工具“秒哒”。文心iRAG用于解决大模型在图片生成上的幻觉问题,极大提升实用性;无代码工具“秒哒”让每个人都拥有程序员的能力,将打造数百万“超级有用”的应用。

Infactory.ai作为一款专注于事实审查的AI搜索引擎,旨在通过使用大语言模型理解搜索意图,而非直接生成搜索结果,以此来提供准确、透明的搜索结果,从根本上避免了搜索结果的幻觉问题,同时依然能提高用户使用搜索工具的效率。

大模型幻觉,究竟是怎么来的?谷歌、苹果等机构研究人员发现,大模型知道的远比表现的要多。它们能够在内部编码正确答案,却依旧输出了错误内容。

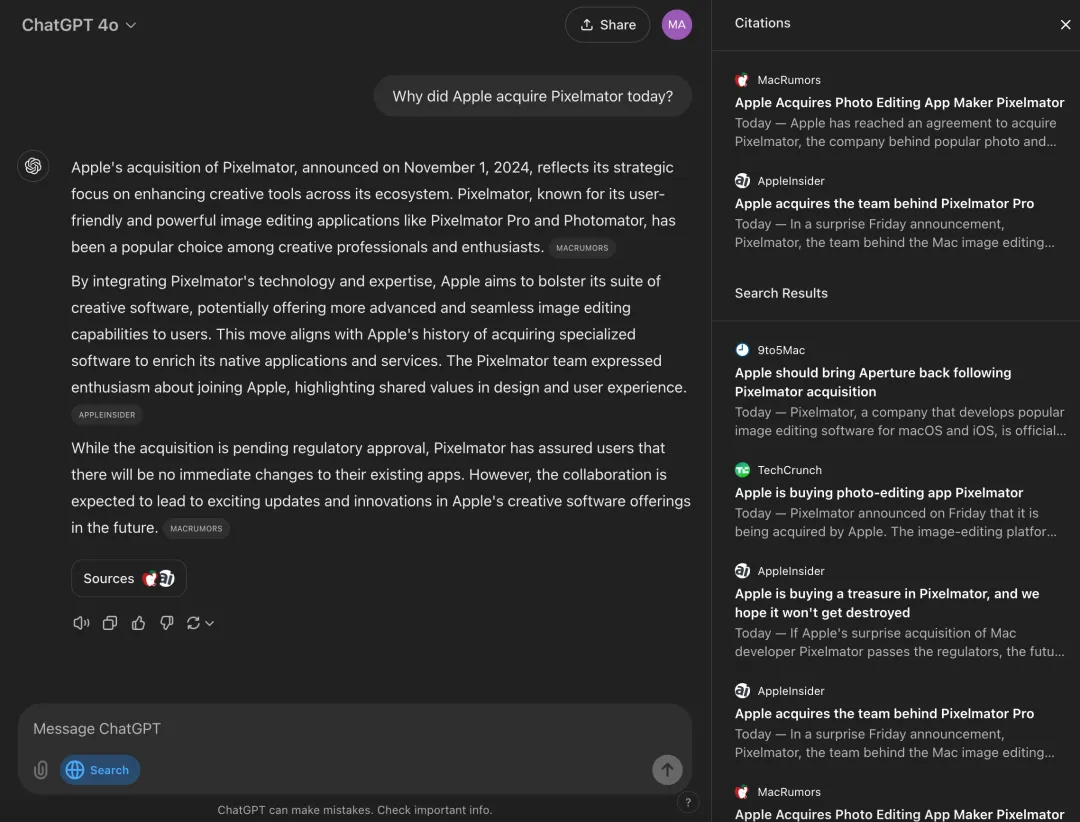

OpenAI 发布了备受期待的搜索产品,ChatGPT 搜索,以挑战谷歌。业界已经为这一时刻准备了几个月,这促使谷歌在今年早些时候将 AI 生成的答案注入其核心产品,并在此过程中产生了一些尴尬的幻觉。这一失误让许多人相信 OpenAI 的搜索引擎将真正成为“谷歌大杀器”。

在人工智能领域,大型预训练模型(如 GPT 和 LLaVA)的 “幻觉” 现象常被视为一个难以克服的挑战,尤其是在执行精确任务如图像分割时。

如今,人们选择餐厅,多半会打开app搜索一番,再看看排名。然而美国奥斯汀的一家餐厅Ethos的存在证实这种选择机制多么不可靠。Ethos在社交媒体instagram宣称是当地排名第一的餐厅,拥有7万余粉丝。

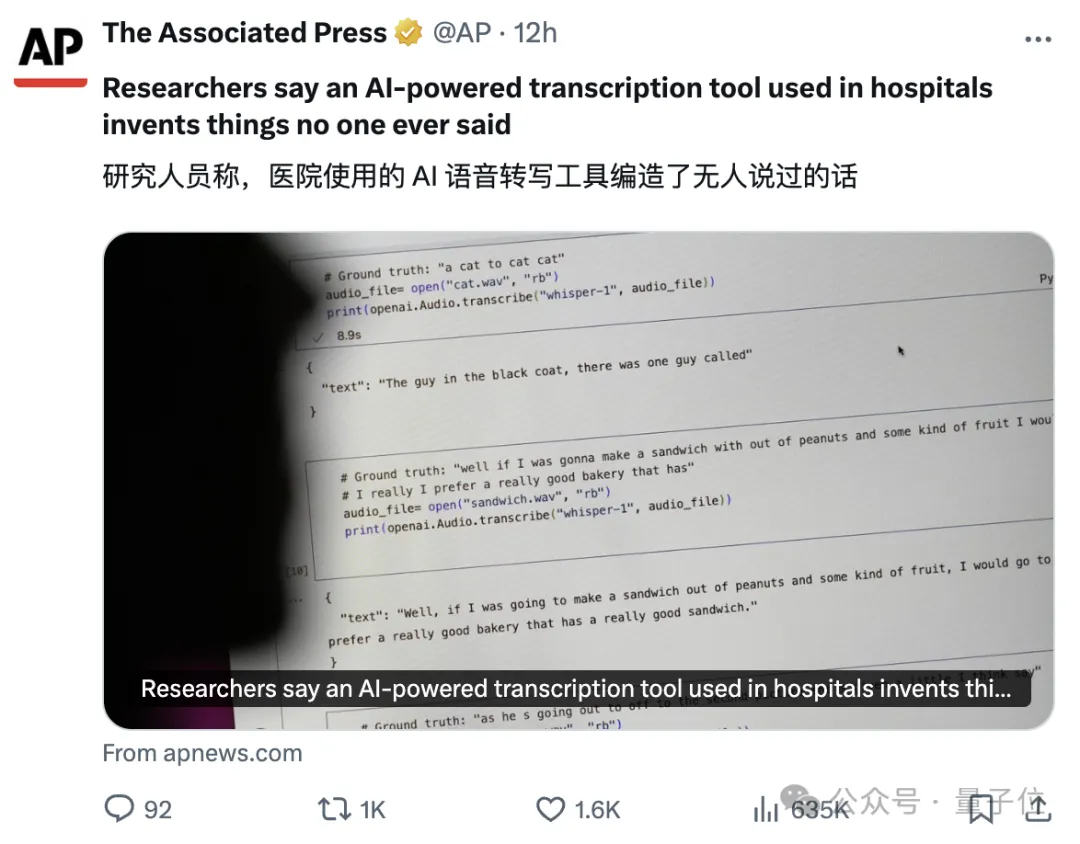

OpenAI的AI语音转写工具,那个号称近乎“人类水平”的Whisper,被曝幻觉严重—— 100多小时转录,被工程师发现约一半都在瞎扯。 更严重的是,美联社还爆料有医疗机构利用Whisper来转录医生与患者的会诊,瞬间引发大量网友关注。