「专业智能体指导」让小模型学会数学推理!微调Mistral-7B实现86.81%准确率

「专业智能体指导」让小模型学会数学推理!微调Mistral-7B实现86.81%准确率对于小型语言模型(SLM)来说,数学应用题求解是一项很复杂的任务。

对于小型语言模型(SLM)来说,数学应用题求解是一项很复杂的任务。

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

Llama 3诞生整整一周后,直接将开源AI大模型推向新的高度。

近期,大语言模型、文生图模型等大规模 AI 模型迅猛发展。在这种形势下,如何适应瞬息万变的需求,快速适配大模型至各类下游任务,成为了一个重要的挑战。受限于计算资源,传统的全参数微调方法可能会显得力不从心,因此需要探索更高效的微调策略。

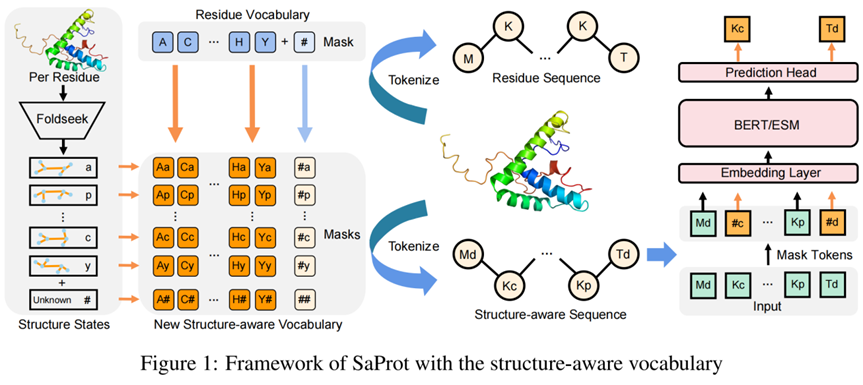

蛋白质结构相比于序列往往被认为更加具有信息量,因为其直接决定了蛋白质的功能

在2023年的「百模大战」中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题

在 2023 年的 “百模大战” 中,众多实践者推出了各类模型,这些模型有的是原创的,有的是针对开源模型进行微调的;有些是通用的,有些则是行业特定的。如何能合理地评价这些模型的能力,成为关键问题。

OpenAI,去日本建办事处了。 而且,他们还发布了一个专门针对日语微调的GPT-4模型……

新版GPT-4是在Q*的输出上微调的在竞技场重回榜一的新版GPT-4 Turbo,成功再次踩中大家嗨点

随着大模型的参数量日益增长,微调整个模型的开销逐渐变得难以接受。 为此,北京大学的研究团队提出了一种名为 PiSSA 的参数高效微调方法,在主流数据集上都超过了目前广泛使用的 LoRA 的微调效果。