告别冷启动,LoRA成为大模型「氮气加速器」,提速高达300%

告别冷启动,LoRA成为大模型「氮气加速器」,提速高达300%如果 AI 是一辆豪华跑车,那么 LoRA 微调技术就是让它加速的涡轮增压器。LoRA 强大到什么地步?它可以让模型的处理速度提升 300%。还记得 LCM-LoRA 的惊艳表现吗?其他模型的十步,它只需要一步就能达到相媲美的效果。

如果 AI 是一辆豪华跑车,那么 LoRA 微调技术就是让它加速的涡轮增压器。LoRA 强大到什么地步?它可以让模型的处理速度提升 300%。还记得 LCM-LoRA 的惊艳表现吗?其他模型的十步,它只需要一步就能达到相媲美的效果。

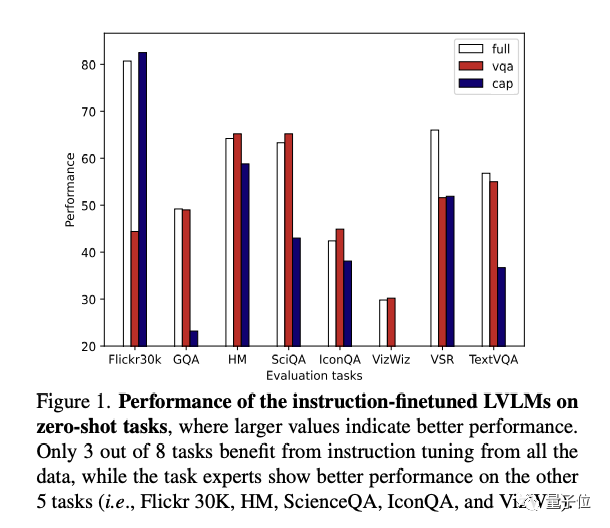

多模态大模型做“多任务指令微调”,大模型可能会“学得多错得多”,因为不同任务之间的冲突,导致泛化能力下降。

向量存储检索是个真需求,然而专用向量数据库已经凉了。

即便是GPT-4 API「灰盒」也逃不过安全漏洞。FAR AI实验室的团队从微调、函数调用、搜索增强三个方向入手,成功让GPT-4越狱。

面对当前微调大模型主要依赖人类生成数据的普遍做法,谷歌 DeepMind 探索出了一种减少这种依赖的更高效方法。

相比GPT-3,GPT-4 (包括GPT-3.5) 的能力有了非常巨大的进步。这背后其实得益于一个很重要的过程引入:微调。

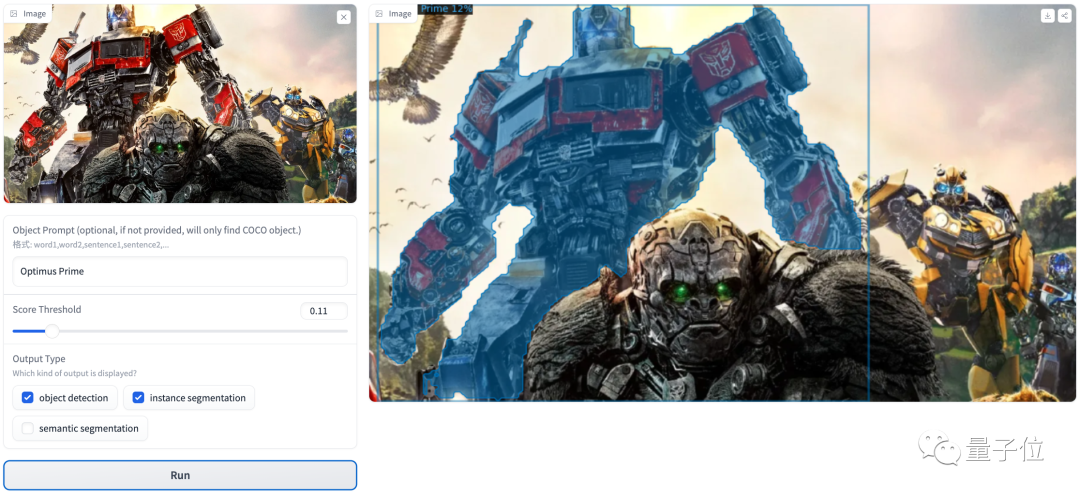

由厦门大学等机构提出的全新视觉感知基础模型APE,只需一个模型外加一套参数,就能在160个测试集上取得当前SOTA或极具竞争力的结果。而且训练和推理代码以及模型权重全部开源,无需微调,开箱即用。

随着大模型技术的发展与落地,「模型治理」已经成为了目前受到重点关注的命题。只不过,在实践中,研究者往往感受到多重挑战。

用多模态大模型来做语义分割,效果有多好?一张图+文字输入想分割的物体,大模型几秒钟就能识别并搞定!

苹果M系列芯片专属的机器学习框架,开源即爆火!现在,用上这个框架,你就能直接在苹果GPU上跑70亿参数大模型、训练Transformer模型或是搞LoRA微调。