应对AI时代挑战 微软、OpenAI等牵头建立教师培训学院

应对AI时代挑战 微软、OpenAI等牵头建立教师培训学院美国教师联盟与美国教师联合会、微软、OpenAI和Anthropic合作,耗资2300万美元成立“国家人工智能教学学院”;

美国教师联盟与美国教师联合会、微软、OpenAI和Anthropic合作,耗资2300万美元成立“国家人工智能教学学院”;

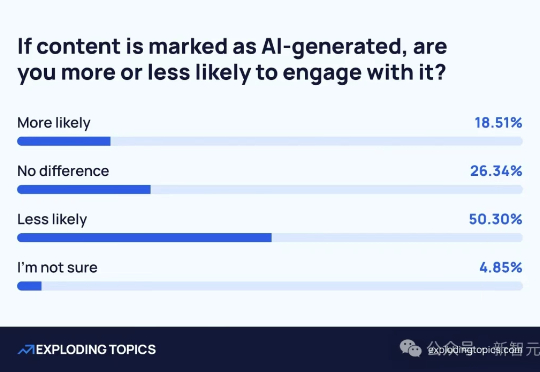

最新调查称,全球仅有8%的人愿意为AI买单!然而,科技巨头们正以「创新」之名,将AI硬塞进日常软件中。一位外国小哥Ted Gioia发文吐槽自己被微软AI全家桶绑架,每月不得不花冤枉钱。

据The Information报道,微软正在重绘其自研人工智能服务器芯片的产品路线图,将在未来几年内专注于推出设计更保守、开发难度更低的芯片版本,目标是在2028年前克服当前导致研发延迟的一系列问题。

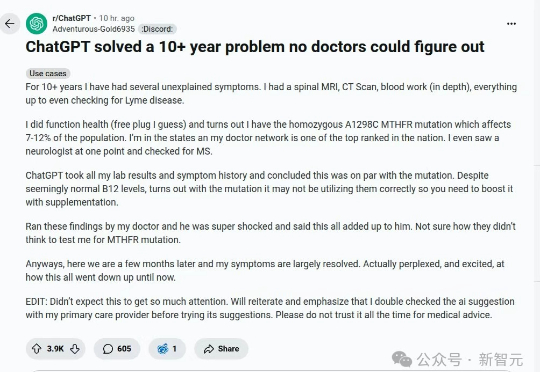

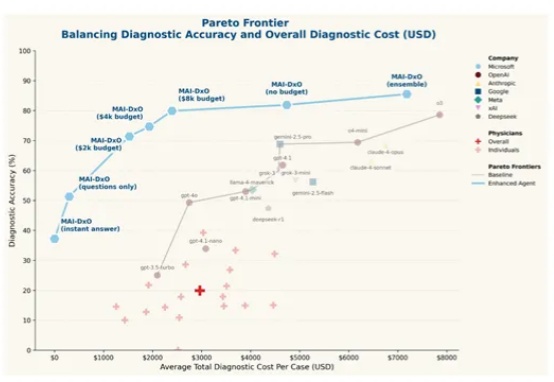

十多年,患者求医无果、束手无策,但将所有病史输入ChatGPT,病因竟被一眼识破:基因突变!微软、OpenAI等巨头的医疗AI已悄然登场,准确率超越专业医生!未来的医疗,或将彻底改写!

灾难前兆,再一次预警。就在最近,微软又裁掉了9000人,最黑色幽默的是,Xbox一位高管甚至建议被裁员工用AI来疗伤?虽然2025年才过了一半,但全美科技行业中已有94000人被裁,接下来这个数字恐怕只会越来越多。

7月2日,韩国专注于AI癌症诊断和治疗的企业Lunit宣布与Microsoft达成合作,加速提供人工智能驱动的医疗保健解决方案。

上个月,微软分享了将 VS Code 打造成开源 AI 编辑器的计划。今天,微软在 VS Code 官网表示已经达成了第一个里程碑:GitHub Copilot Chat 扩展程序现已在 GitHub 上根据 MIT 许可证 开源。

微软首席执行官Satya Nadella在社交平台分享了,微软最新发布的突破性医疗AI系统MAI-DxO。

刚刚,由上海交通大学人工智能学院Agents团队提出的AI专家智能体,在OpenAI权威基准测试MLE-bench中击败了业界AI顶流微软,夺冠登顶!

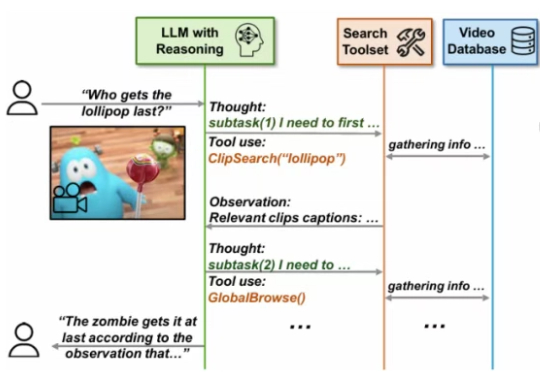

尽管大型语言模型(LLMs)和大型视觉 - 语言模型(VLMs)在视频分析和长语境处理方面取得了显著进展,但它们在处理信息密集的数小时长视频时仍显示出局限性。