AI出图更快、更美、更懂你心意,高美感文生图模型修炼了哪些技术秘籍?

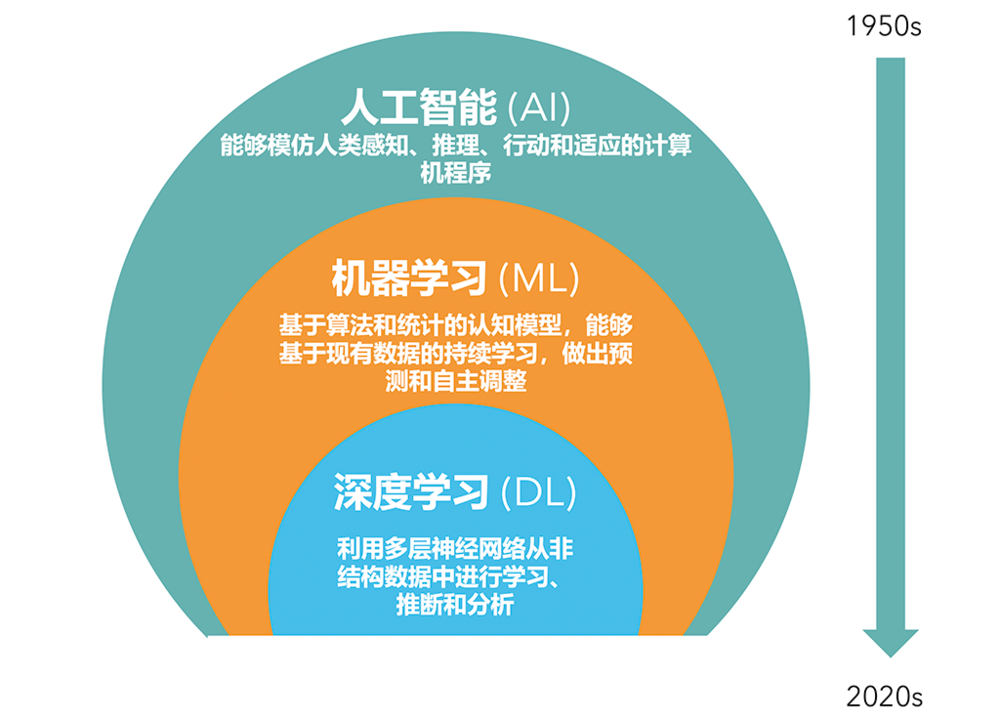

AI出图更快、更美、更懂你心意,高美感文生图模型修炼了哪些技术秘籍?随着大模型的落地按下加速键,文生图无疑是最火热的应用方向之一。

随着大模型的落地按下加速键,文生图无疑是最火热的应用方向之一。

近日,来自加州大学尔湾分校等机构的研究人员,利用延迟掩蔽、MoE、分层扩展等策略,将扩散模型的训练成本降到了1890美元。

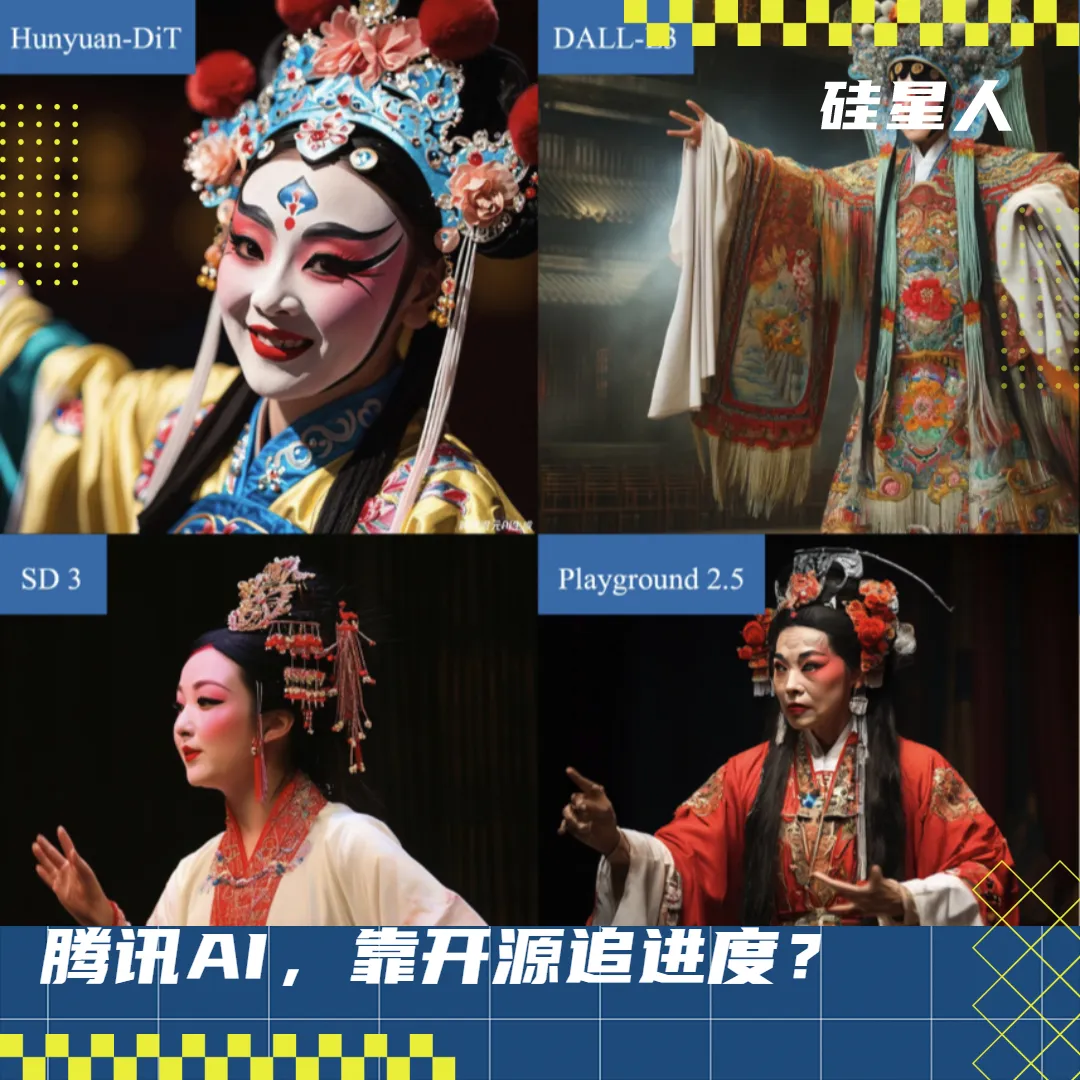

最强开源文生图模型一夜易主! 智东西8月2日报道,昨日晚间,开源文生图模型霸主Stable Diffusion原班人马,宣布推出全新的图像生成模型FLUX.1。

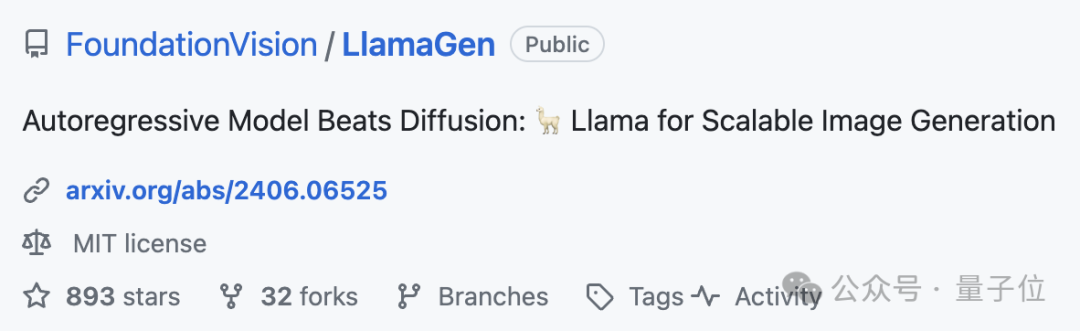

只需Image Tokenizer,Llama也能做图像生成了,而且效果超过了扩散模型。

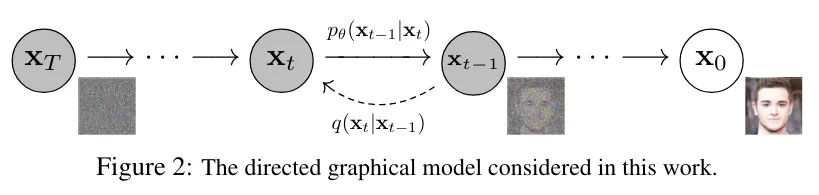

超越扩散模型!自回归范式在图像生成领域再次被验证——

OpenAI在5月14日推出了新一代人工智能模型GPT-4o,支持文本、音频和图像的任意组合输入,并能够生成文本、音频和图像的任意组合输出。仅仅一天后,谷歌就在新一届I/O开发者大会上发布、更新了十多款产品,包括AI助手Project Astra、文生图模型Imagen3、对标Sora的文生视频模型Veo,以及备受瞩目的大模型Gemini 1.5 Pro的升级版。

文生图模型成熟之后,有多少人苦练Midjourney咒语,还是调不出可用的图像?

北京时间 5 月 15 日凌晨,在 OpenAI 春季发布会的第二天,2024 年谷歌 I/O 召开,这是一场充满了 AI 的发布会,谷歌对其旗下的多款 AI 产品发布了大更新,从基座模型 Gemini 到新的 AI 助手 Astra、新的文生视频模型 Veo,以及更强大的文生图模型 Imagen 3。

近期,大语言模型、文生图模型等大规模 AI 模型迅猛发展。在这种形势下,如何适应瞬息万变的需求,快速适配大模型至各类下游任务,成为了一个重要的挑战。受限于计算资源,传统的全参数微调方法可能会显得力不从心,因此需要探索更高效的微调策略。

众所周知,开发顶级的文生图(T2I)模型需要大量资源,因此资源有限的个人研究者基本都不可能承担得起,这也成为了 AIGC(人工智能内容生成)社区创新的一大阻碍。同时随着时间的推移,AIGC 社区又能获得持续更新的、更高质量的数据集和更先进的算法。