马斯克找老黄插队拿显卡:72亿GB200订单,加价也要

马斯克找老黄插队拿显卡:72亿GB200订单,加价也要抢疯了!马斯克找老黄加价插队拿显卡——为了加速xAI产品研发。

抢疯了!马斯克找老黄加价插队拿显卡——为了加速xAI产品研发。

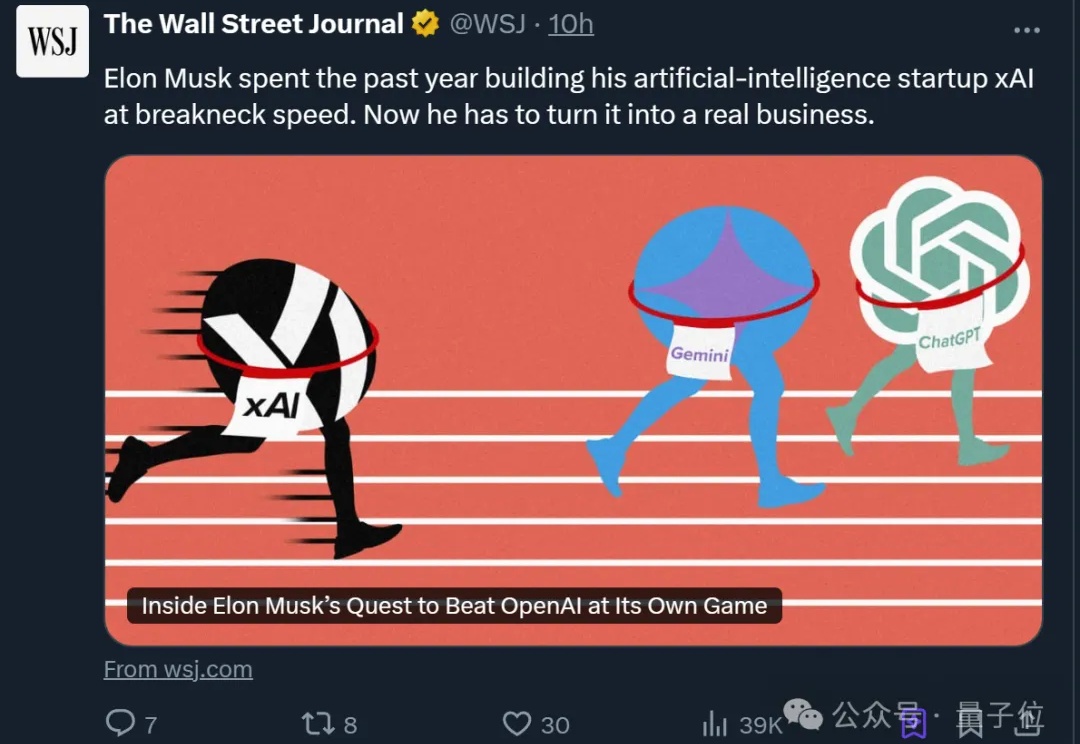

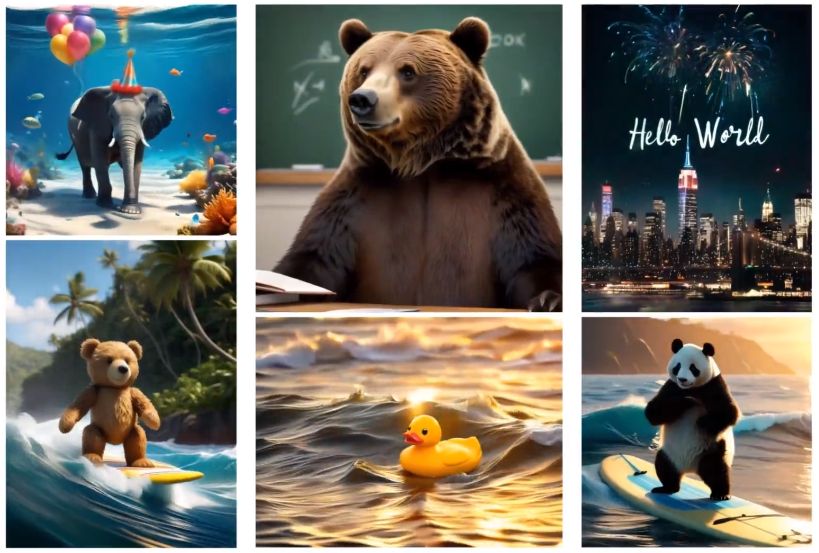

【新智元导读】刚刚,一款专为消费级显卡设计的全新非自回归掩码图像建模的文本到图像生成模型——Meissonic发布,标志着图像生成即将进入「端侧时代」。

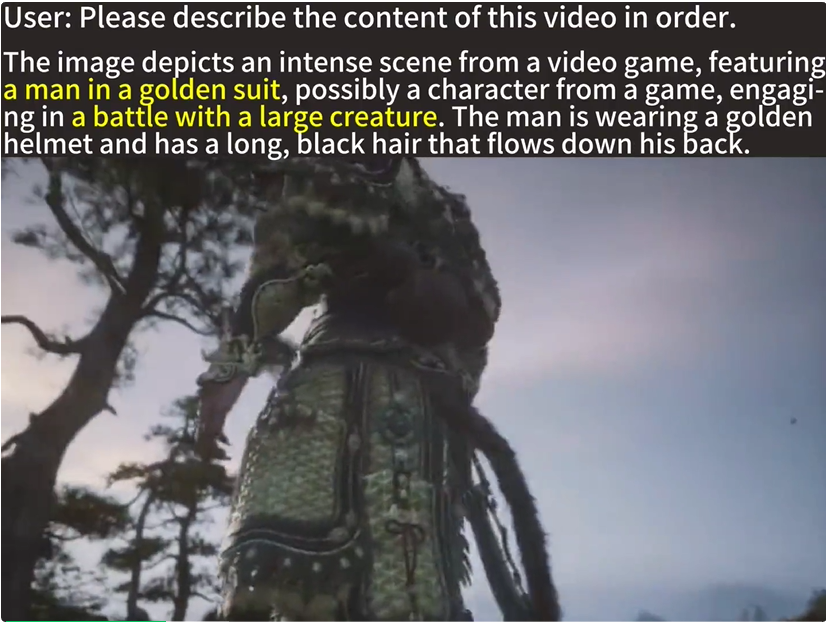

长视频理解迎来新纪元!智源联手国内多所顶尖高校,推出了超长视频理解大模型Video-XL。仅用一张80G显卡处理小时级视频,未来AI看懂电影再也不是难事。

仅需1块80G显卡,大模型理解小时级超长视频。 智源研究院联合上海交通大学、中国人民大学、北京大学和北京邮电大学等多所高校带来最新成果超长视频理解大模型Video-XL。

英伟达不仅要做显卡领域的领先者,还要在大模型领域逐渐建立起自己的优势。

GPU计算驱动AI。

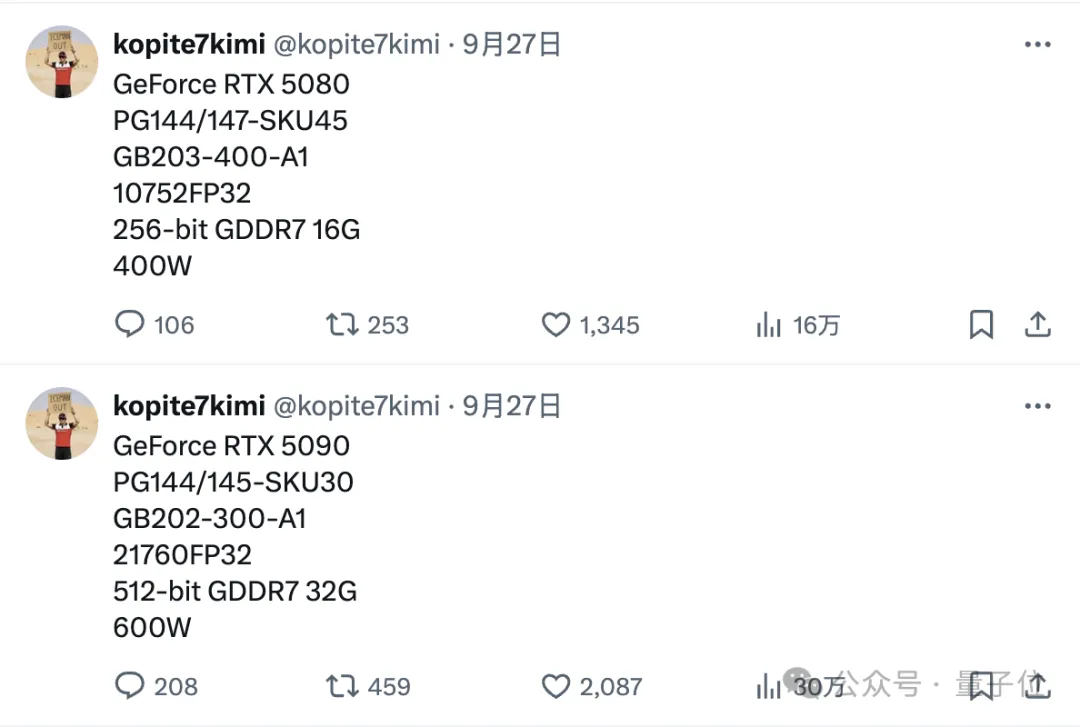

32GB GDDR7内存,CUDA核心数21760个——

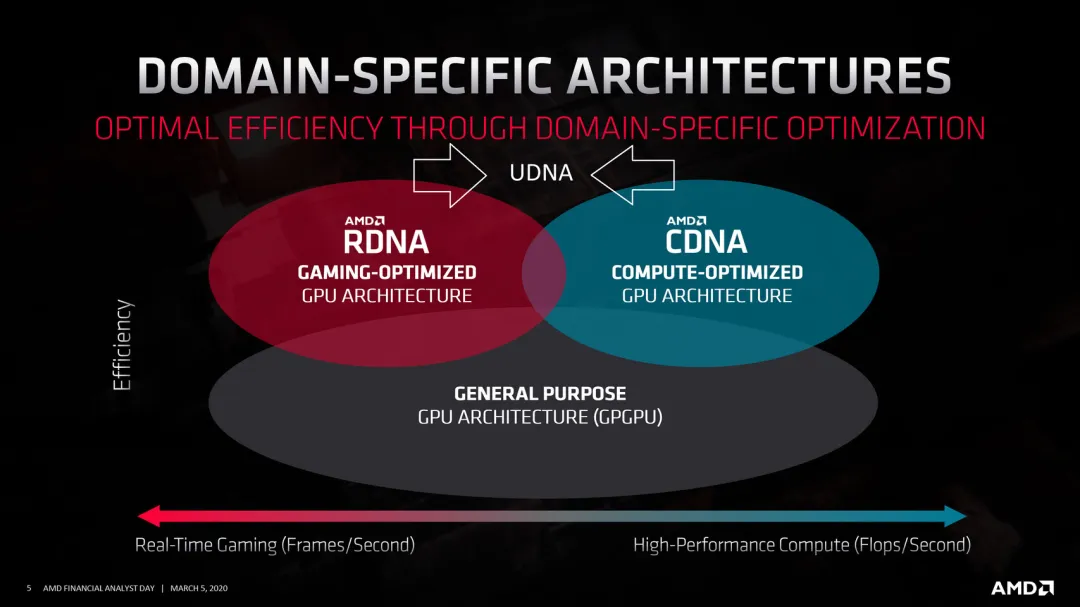

既然要扬长避短,选择自然也就只剩下了一个。

短短几天内,AMD连续宣布两项颠覆性的转变

近日,开源社区又迎来一款强力的「视频生成」工作,可以在消费级显卡 (如 GeForce RTX 3090) 上生成任意分辨率、任意宽高比、不同风格、不同运动幅度的视频,其衍生模型还能够完成视频扩展、视频回溯的功能…… 这便是 360AI 团队和中山大学联合研发的 FancyVideo,一种基于 UNet 架构的视频生成模型。