推理与操控能力双提升!具身机器人双系统VLA模型新突破

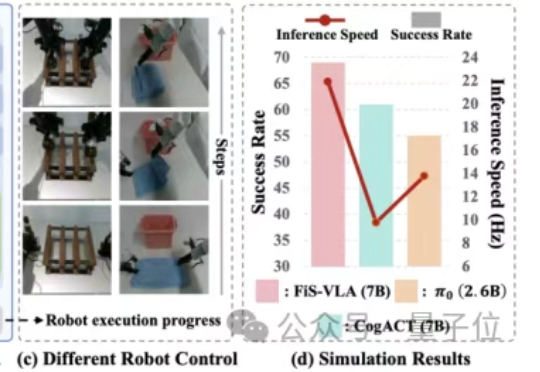

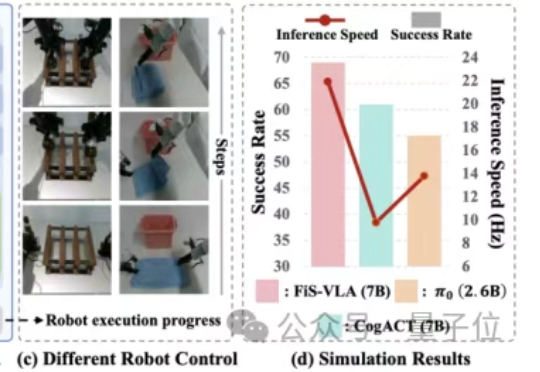

推理与操控能力双提升!具身机器人双系统VLA模型新突破让机器人学会聪明且快速精准执行,一直是机器人操控领域的难题。为了解决这个问题,香港中文大学、北京大学、智平方和北京智源研究院联合创新性地提出了Fast-in-Slow(FiS-VLA),即一个统一的双系统VLA模型。

让机器人学会聪明且快速精准执行,一直是机器人操控领域的难题。为了解决这个问题,香港中文大学、北京大学、智平方和北京智源研究院联合创新性地提出了Fast-in-Slow(FiS-VLA),即一个统一的双系统VLA模型。

您有没有遇到过这样的场景:为了调试一个LLM应用的效果,您需要在一大堆Python代码中翻找那些零散的提示词字符串?每次想要A/B测试不同的提示时,就像在做开颅手术一样小心翼翼。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

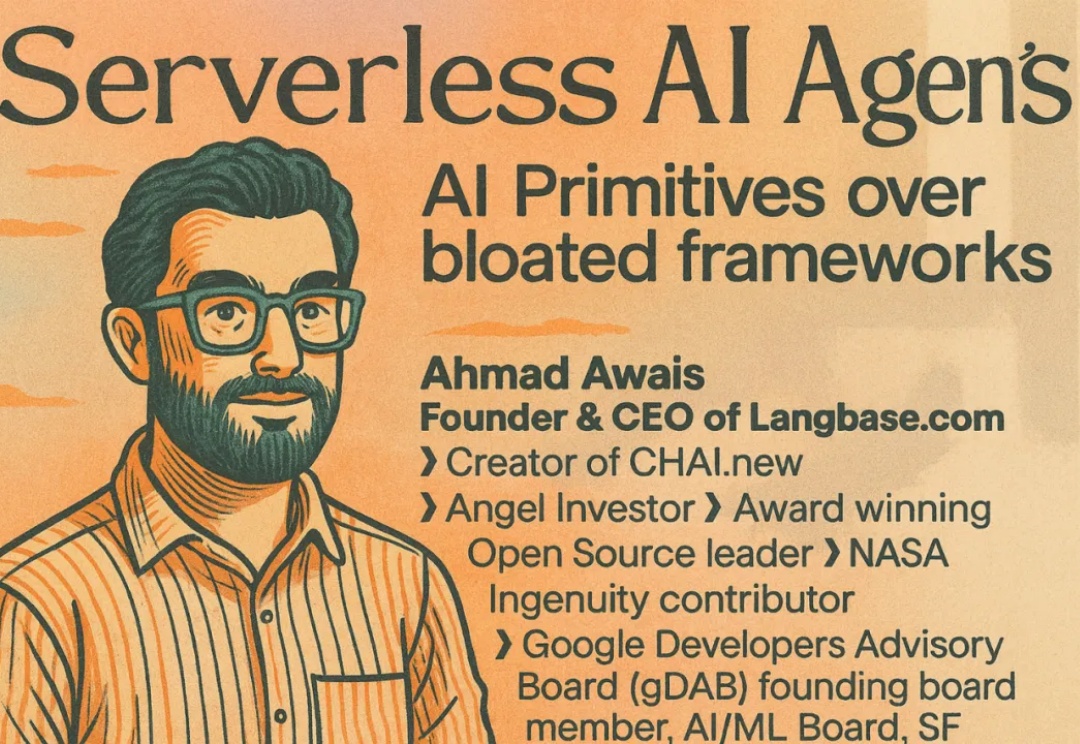

你有没有想过,为什么 Cursor、v0、Perplexity、Lovable、Bold 这些服务数百万用户的顶级 AI agent 产品,竟然都有一个惊人的共同点?它们全部都不是基于任何 AI 框架构建的。

「Tokenization(分词)是 Transformer 模型为弥补自身缺陷不得不戴上的枷锁。」

LLM用得越久,速度越快!Emory大学提出SpeedupLLM框架,利用动态计算资源分配和记忆机制,使LLM在处理相似任务时推理成本降低56%,准确率提升,为AI模型发展提供新思路。

自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。

编者按:vibe coding不是编程的终点,而是Context Engineering驱动的协作智能的起点。那些能够最早理解并应用这种整合视角的人,将在下一轮技术变革中获得决定性优势。

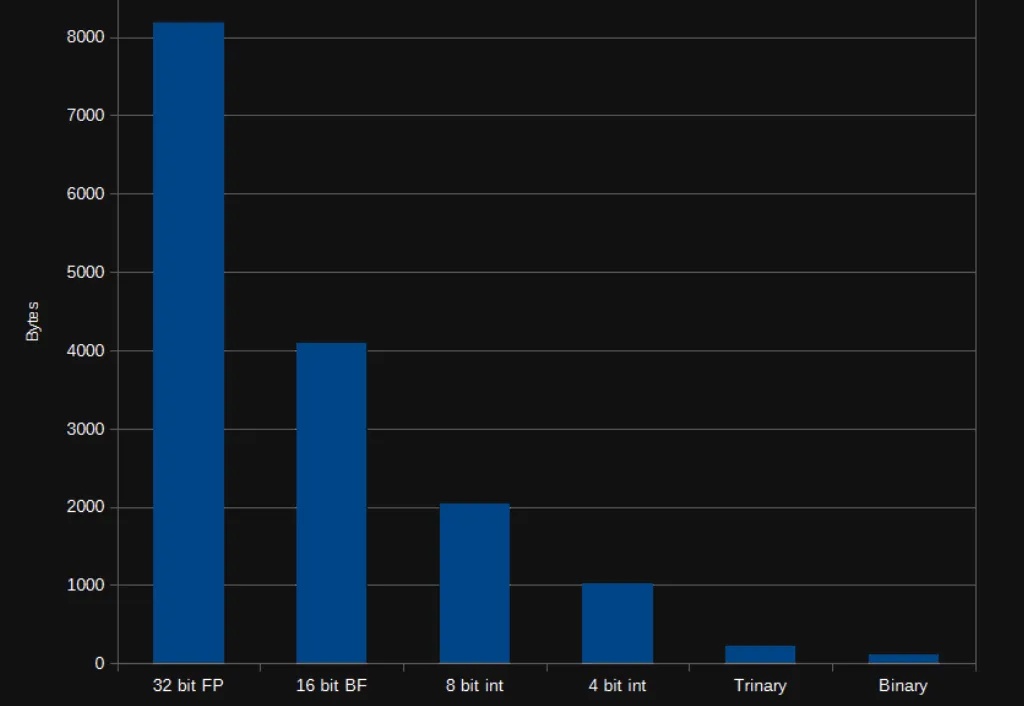

在 AI 领域,我们对模型的期待总是既要、又要、还要:模型要强,速度要快,成本还要低。但实际应用时,高质量的向量表征往往意味着庞大的数据体积,既拖慢检索速度,也推高存储和内存消耗。

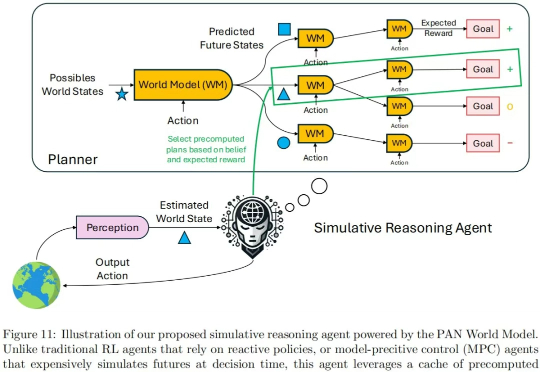

现在的世界模型,值得批判。 我们知道,大语言模型(LLM)是通过预测对话的下一个单词的形式产生输出的。由此产生的对话、推理甚至创作能力已经接近人类智力水平。