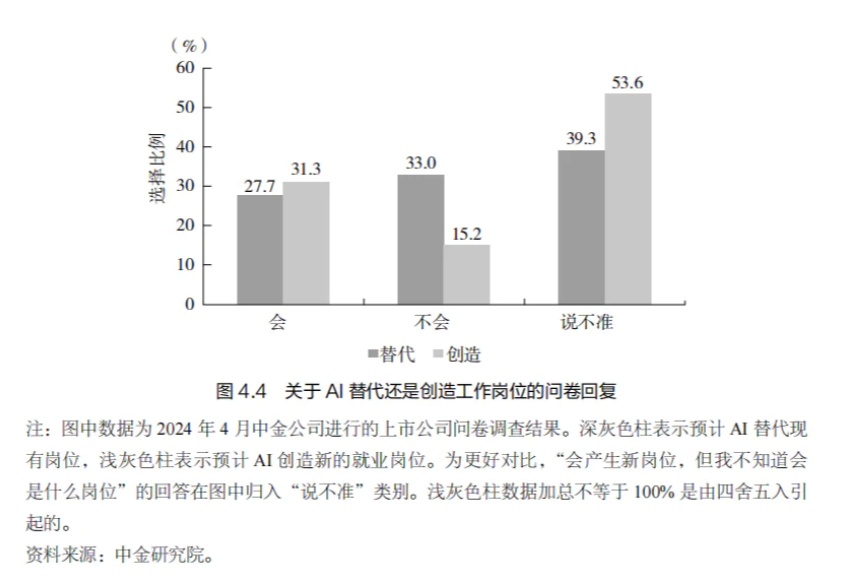

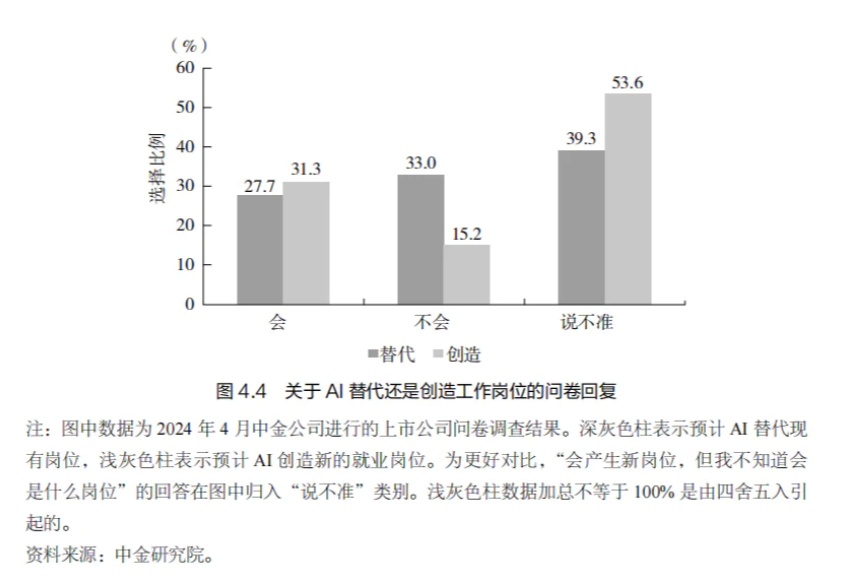

AI 冲击就业市场:是危机还是转机?

AI 冲击就业市场:是危机还是转机?2022 年,以ChatGPT 大语言模型(LLM)的发布为标志, AI 神经网络的类人学习能力取得了里程碑式的进展,在全球范围内掀起了一股 AI 热潮。

2022 年,以ChatGPT 大语言模型(LLM)的发布为标志, AI 神经网络的类人学习能力取得了里程碑式的进展,在全球范围内掀起了一股 AI 热潮。

北京大学研究团队开发的FAN模型能有效捕捉数据中的周期性模式,相比传统模型在多项任务中表现出色,同时降低了参数量和计算量,增强了对周期性特征的建模能力,应用潜力广泛。

5年,5000万个神经网络,这个世界从未被扫描过的角落,我们都能看到了。宝可梦GO团队,竟然抢先实现了李飞飞的「空间智能」?而「Pokémon Go」的玩家可能没想到,自己居然在训练着一个巨大的AI模型。

周期性现象广泛存在,深刻影响着人类社会和自然科学。作为最重要的基本特性之一,许多规律都显式或隐式地包含周期性,例如天文学中的行星运动、气象学中的季节变化、生物学中的昼夜节律、经济学中的商业周期、物理学中的电磁波以及数学运算和逻辑推理等。因此,在许多任务和场景中,人们希望对周期进行建模,以便根据以往的经验进行推理。

在人工智能(AI)领域,特别是深度学习和神经网络训练中,GPU(图形处理单元)已经成为不可或缺的硬件。但为什么AI对GPU的要求高,而不是CPU(中央处理单元)呢?让我们通过一个生动的比喻来揭开这个谜团。

多年来,浙江大学周晟老师团队与阿里安全交互内容安全团队持续开展产学研合作。近日,双⽅针对标签噪声下图神经⽹络的联合研究成果《NoisyGL:标签噪声下图神经网络的综合基准》被 NeurIPS Datasets and Benchmarks Track 2024 收录。本次 NeurIPS D&B Track 共收到 1820 篇投稿,录⽤率为 25.3%。

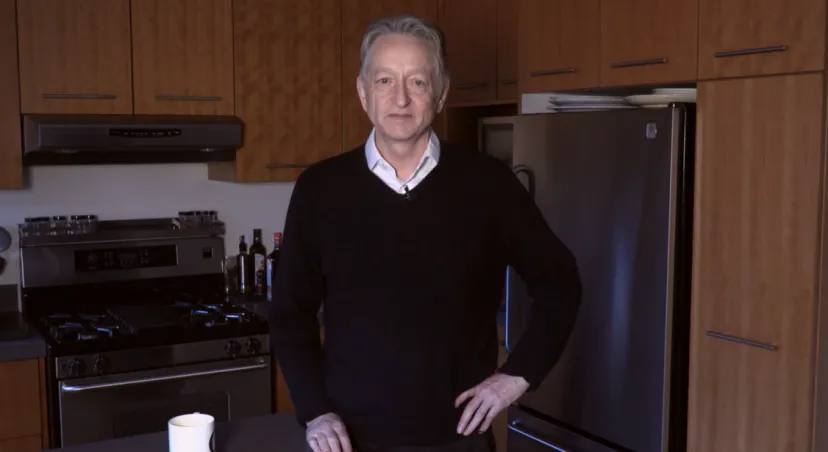

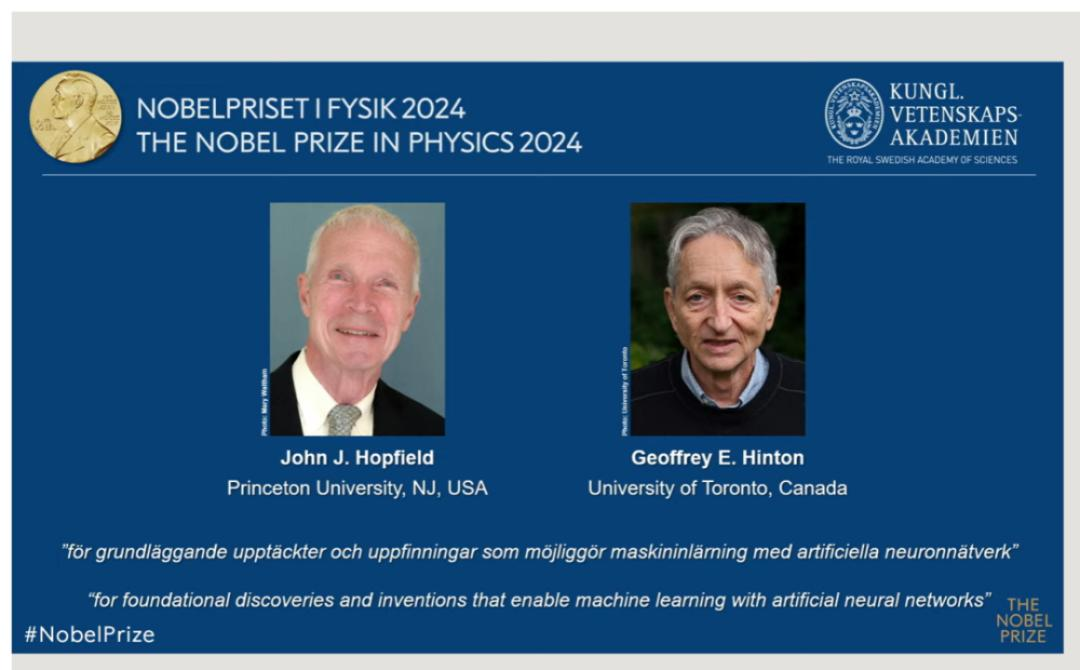

2024年诺贝尔物理学奖的结果引发了广泛的讨论,原因是其中一位获奖者Geoffrey Hinton(杰弗里·辛顿),并非是传统意义上的物理学家,而是一位极具声望的人工智能研究科学家,被誉为深度神经网络的奠基人和人工智能“教父”。

Hinton在人工智能领域的贡献极其卓越,被誉为 “神经网络之父”、“人工智能教父”。他的主要贡献包括:反向传播算法的改进与推广、深度学习模型的创新(深度置信网络、卷积神经网络等多个深度学习网络结构)。Hinton还为AI行业培养了包括OpenAI前首席科学家伊尔亚・苏茨克维(Ilya Sutskever)在内的诸多人才。

AI,新世界的“钥匙”

Alexnet对人工智能世界具有象征意义,因为现代人工智能的三个基本要素第一次汇聚在一起,第一个要素是神经网络,第二个要素是大数据,即使用ImageNet,第三个要素是GPU计算......