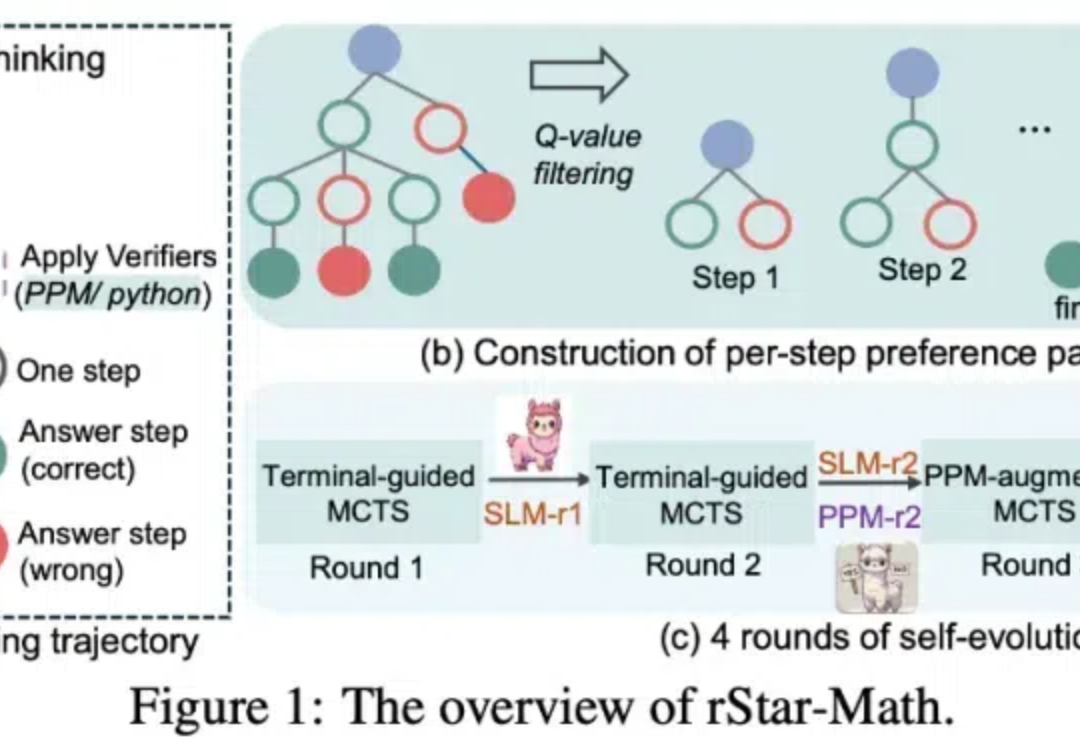

让7B千问模型超越o1,微软rStar-Math惊艳登场,网友盛赞

让7B千问模型超越o1,微软rStar-Math惊艳登场,网友盛赞OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

老黄在CES上发布的迷你超算Project DIGITS,开启了AI超算的PC时刻。 但随即也引发了不小争议,还遭到了大佬的贴脸嘲讽。

GPU万卡集群,小米下场了!摩尔线程智算集群扩展至万卡!中国移动将商用三个自主可控万卡集群......一系列标题的袭来,让笔者突然意识到,仿佛在不经意间,智能算力建设已然迈入万卡时代。

抢人、抢算力、重启“APP工厂”。

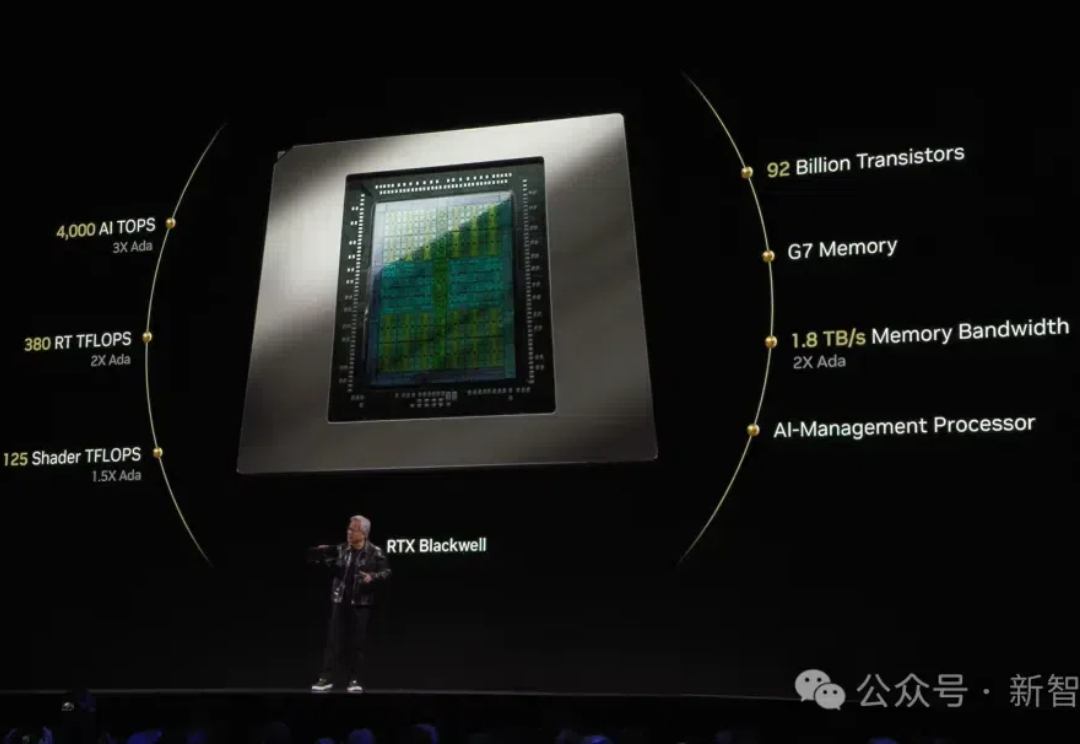

就在刚刚,RTX 5090震撼发布,国行版定价16499元!同时震撼亮相的,还有全球最小AI超算Project Digits,在办公桌上就能跑出数据中心级算力!这一刻老黄摆出别致pose,吸引了全球目光。

DeepSeek-v3大模型横空出世,以1/11算力训练出超过Llama 3的开源模型,震撼了整个AI圈。

2024 年初,我们明显感受到 GenAI(生成式人工智能)仍将是技术发展和风险投资的重点方向。在顶尖的 AI 实验室算力需求的推动下,模型层继续吸引了最多的资本投入。代码辅助、营销和客户支持等场景的落地正在加速,同时随着巨头们加入这场军备竞赛,全球资本支出也在增加。

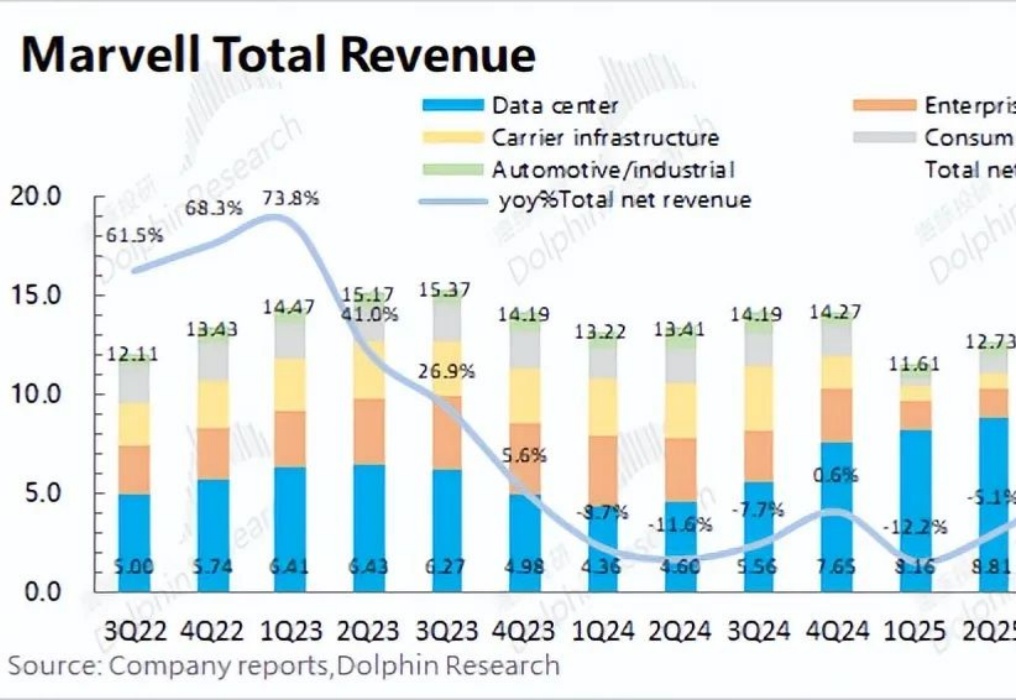

AI算力变革的持续推动功不可没。

近日,AIP GROUP完成天使轮融资,融资金额数百万美元,由算力基金Coevolution独家投资。AIP GROUP旗下产品AIPGPT为AI驱动的一站式IP短视频创作平台,自上线后已在国内、北美等多个城市和地区提供服务。

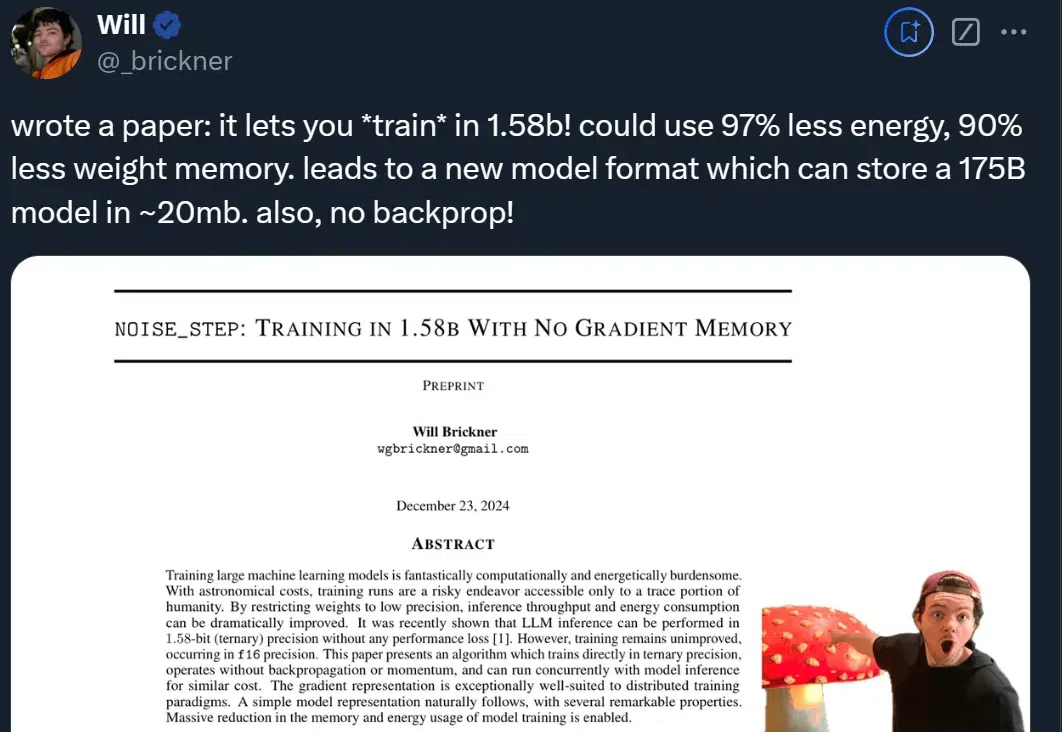

好家伙!1750亿参数的GPT-3只需20MB存储空间了?! 基于1.58-bit训练,在不损失精度的情况下,大幅节省算力(↓97%)和存储(↓90%)。