「芯片创投教父」陈立武闪辞英特尔,惊人内幕曝出!

「芯片创投教父」陈立武闪辞英特尔,惊人内幕曝出!老牌芯片巨头英特尔,再失一位半导体行业老将。最近,陈立武宣布辞去董事会一职,因对公司官僚主义、规避风险文化感到沮丧,并在中层裁员意见上出现分歧。消息一出公司股价暴跌6%,现如今市值不过千亿美金。

老牌芯片巨头英特尔,再失一位半导体行业老将。最近,陈立武宣布辞去董事会一职,因对公司官僚主义、规避风险文化感到沮丧,并在中层裁员意见上出现分歧。消息一出公司股价暴跌6%,现如今市值不过千亿美金。

智东西8月28日消息,据路透社报道,因在公司代工业务发展方向上,与英特尔高层存在分歧,半导体行业资深人士陈立武上周主动辞去其董事会职务。

MICRO 全称 IEEE/ACM International Symposium on Microarchitecture,与 ISCA、HPCA、ASPLOS 并称为体系结构「四大顶会」,囊括了当年最先进的体系结构成果,被视作国际前沿体系结构研究的风向标,见证了诸多突破性成果的首次亮相,包括谷歌、英特尔、英伟达等企业在半导体领域的多项技术创新。

一场未完成的投资改变了什么?

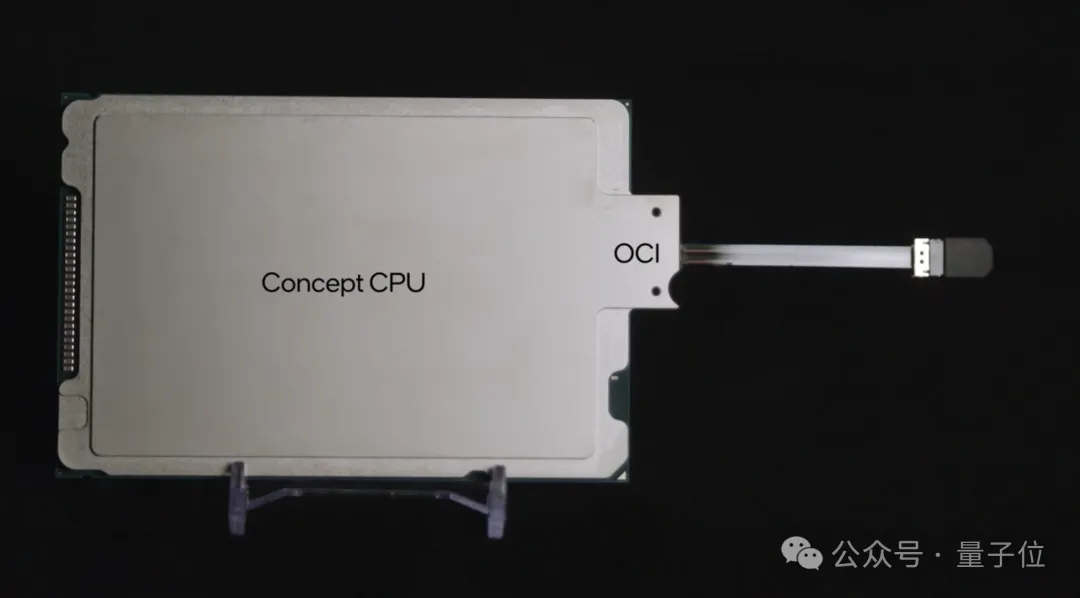

英特尔用“光”,突破了大模型时代棘手的算力难题—— 推出业界首款全集成OCI(光学计算互连)芯片。

为期三天的2024年台北电脑展(Computex 2024),6月7日已落下帷幕。在这一次的展会上,AI成为贯穿一切的主题。英伟达、AMD、英特尔、高通等芯片大厂的话事人们纷纷做了主题演讲,也让这次展会的参与人数比上一届暴涨了 80%。

今日,英特尔推出英特尔® 至强® 6能效核处理器,每个 CPU 拥有多达 144 个内核,机架密度提高达3倍1,以高性能、高密度、高能效和低TCO,满足多样的云级工作负载,是数据中心高效能之选。

如何制服AI吞电兽? 这两天,Computex上演了一出“神仙打架”的戏码,英伟达、英特尔、AMD、高通、Supermicro、恩智浦等厂商的演讲一个比一个重磅。可以说,基本上所有的终端都已经被AI所加持,人们页感叹,全民AI时代,真的来了。

英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

英特尔终究还是学了苹果。