阿里深夜开源万相2.1,这是AI视频领域的DeepSeek啊。

阿里深夜开源万相2.1,这是AI视频领域的DeepSeek啊。昨天的AI新闻有点太密集了,肝快废了。

昨天的AI新闻有点太密集了,肝快废了。

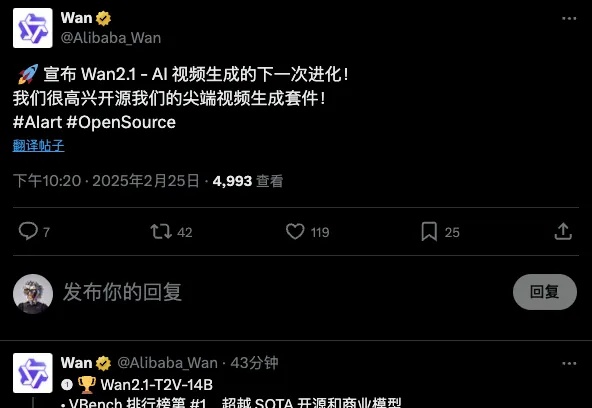

Google 已悄然公布了 Veo 2 的定价,这款视频生成 AI 模型于去年 12 月发布。

刚刚,阶跃星辰联合吉利汽车集团,开源了两款多模态大模型!新模型共2款:全球范围内参数量最大的开源视频生成模型Step-Video-T2V行业内首款产品级开源语音交互大模型Step-Audio多模态卷王开始开源多模态模型,其中Step-Video-T2V采用的还是最为开放宽松的MIT开源协议,可任意编辑和商业应用。

开源AI短剧神器来了!来自昆仑万维,一次性开源两大视频模型——国内首个面向AI短剧创作的视频生成模型SkyReels-V1;国内首个SOTA级别基于视频基座模型的表情动作可控算法SkyReels-A1。

这应该是我知道的第一家有自己大模型的大厂,第一次在面向C端的AI助手应用中,第一次接入DeepSeek R1。这个意义影响还是非常深远的,腾讯在AI这一步上,好像走的格外的开放,从之前的批量开源MoE、混元绘图模型、混元视频模型、混元3D模型,还有今天这神之一手接入DeepSeek R1。

如今,AI爆发趋势势不可挡,从去年开始,内容生成领域就备受瞩目,无论是文生还是图生,都让创作变得轻而易举,也让更多的非原专业人士能够参与其中,体验用极短的时间制作出心仪的内容。

对 LLM 来说,Pre-training 的时代已经基本结束了。视频模型的 Scaling Law,瓶颈还很早。具身智能:完全具备人类泛化能力的机器人,在我们这代可能无法实现

AI视频模型正以意想不到的方式影响着世界各地每个人的生活,也包括一位远在大洋彼岸的60岁老奶奶。

今天中午,Vidu突然发了他们的AI视频模型Vidu2.0。

通义万相视频模型,再度迎来史诗级升级!处理复杂运动、还原真实物理规律等方面令人惊叹,甚至业界首创了汉字视频生成。现在,通义万相直接以84.70%总分击败了一众顶尖模型,登顶VBench榜首。