手术刀式去噪突破LLM能力上限,从头预训练模型下游任务平均提高7.2% | 中科院&阿里

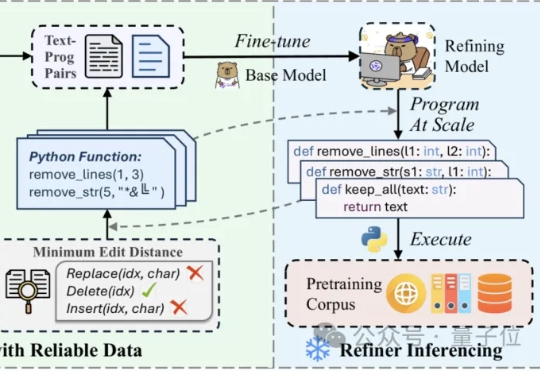

手术刀式去噪突破LLM能力上限,从头预训练模型下游任务平均提高7.2% | 中科院&阿里在噪声污染严重影响预训练数据的质量时,如何能够高效且精细地精炼数据? 中科院计算所与阿里Qwen等团队联合提出RefineX,一个通过程序化编辑任务实现大规模、精准预训练数据精炼的新框架。

在噪声污染严重影响预训练数据的质量时,如何能够高效且精细地精炼数据? 中科院计算所与阿里Qwen等团队联合提出RefineX,一个通过程序化编辑任务实现大规模、精准预训练数据精炼的新框架。

在大模型狂飙的时代,AI 创业被裹挟进一种“技术正统性”的焦虑:要不要训练模型?有没有算力资源?底层自研是不是护城河?但 Yiran,一位本科学钢琴、靠一段自动发邮件脚本开启创业旅程的 00 后女性创业者,选择了另一种路径——她不训练模型,不押技术论文,而是把 AI 做成一个真正能“成事”的销售助理。

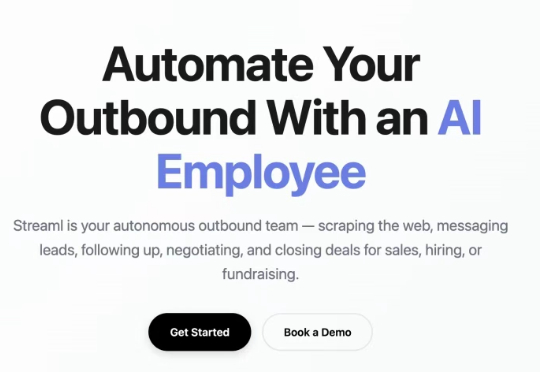

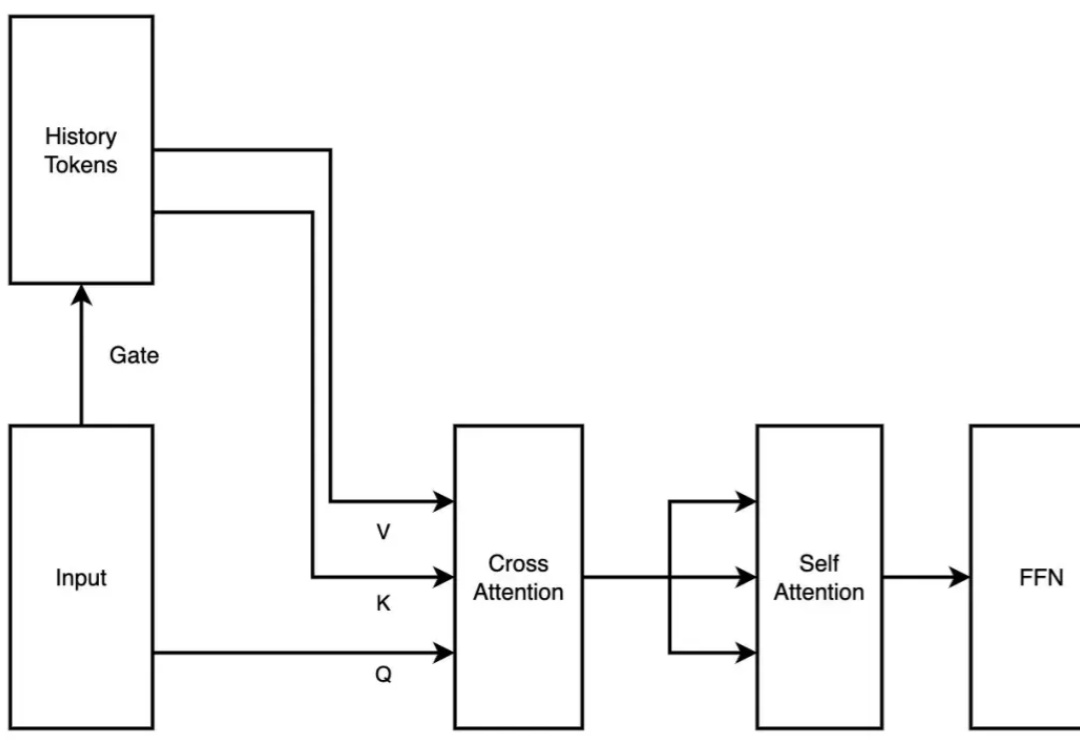

预训练模型能否作为探索新架构设计的“底座” ? 最新答案是:yes!

近年来,众多原告——包括书籍、报纸、计算机代码和照片的出版商——起诉人工智能公司使用受版权保护的材料来训练模型。所有这些诉讼中的一个关键问题是,人工智能模型如何轻易地从原告的受版权保护的内容中逐字摘录。

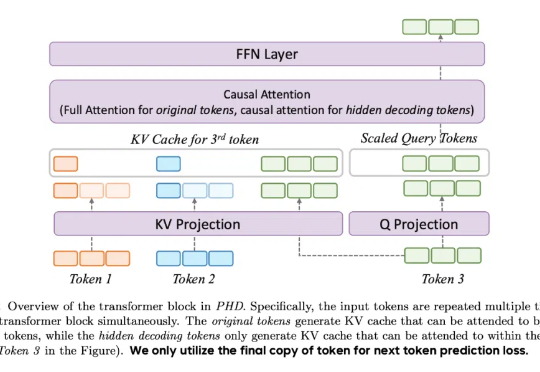

近日,NVIDIA 联合香港大学、MIT 等机构重磅推出 Fast-dLLM,以无需训练的即插即用加速方案,实现了推理速度的突破!通过创新的技术组合,在不依赖重新训练模型的前提下,该工作为扩散模型的推理加速带来了突破性进展。本文将结合具体技术细节与实验数据,解析其核心优势。

本文由匹兹堡大学智能系统实验室(Intelligent Systems Laboratory)的研究团队完成。第一作者为匹兹堡大学的一年级博士生薛琪耀。

一夜之间,老黄天塌了(doge)。

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

模型即产品?

2 月 18 日,月之暗面发布了一篇关于稀疏注意力框架 MoBA 的论文。MoBA 框架借鉴了 Mixture of Experts(MoE)的理念,提升了处理长文本的效率,它的上下文长度可扩展至 10M。并且,MoBA 支持在全注意力和稀疏注意力之间无缝切换,使得与现有的预训练模型兼容性大幅提升。