融合ChatGPT+DALL·E 3,贾佳亚团队新作开源畅玩:识图推理生图一站解决

融合ChatGPT+DALL·E 3,贾佳亚团队新作开源畅玩:识图推理生图一站解决在开源社区中把GPT-4+Dall·E 3能⼒整合起来的模型该有多强?

在开源社区中把GPT-4+Dall·E 3能⼒整合起来的模型该有多强?

刷爆多模态任务榜单,超强视觉语言模型Mini-Gemini来了! 效果堪称是开源社区版的GPT-4+DALL-E 3王炸组合。

近,来自澳大利亚蒙纳士大学、蚂蚁集团、IBM 研究院等机构的研究人员探索了模型重编程 (model reprogramming) 在大语言模型 (LLMs) 上应用,并提出了一个全新的视角

为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

大语言模型的效率,正在被这家「清华系」创业公司发展到新高度。

大语言模型(LLM),通过在海量数据集上的训练,展现了超强的多任务学习、通用世界知识目标规划以及推理能力

近日,来自佐治亚大学、新泽西理工学院、弗吉尼亚大学、维克森林大学、和腾讯 AI Lab 的研究者联合发布了解释性技术在大语言模型(LLM)上的可用性综述,提出了 「Usable XAI」 的概念,并探讨了 10 种在大模型时代提高 XAI 实际应用价值的策略。

大语言模型潜力被激发—— 无需训练大语言模型就能实现高精度时序预测,超越一切传统时序模型。

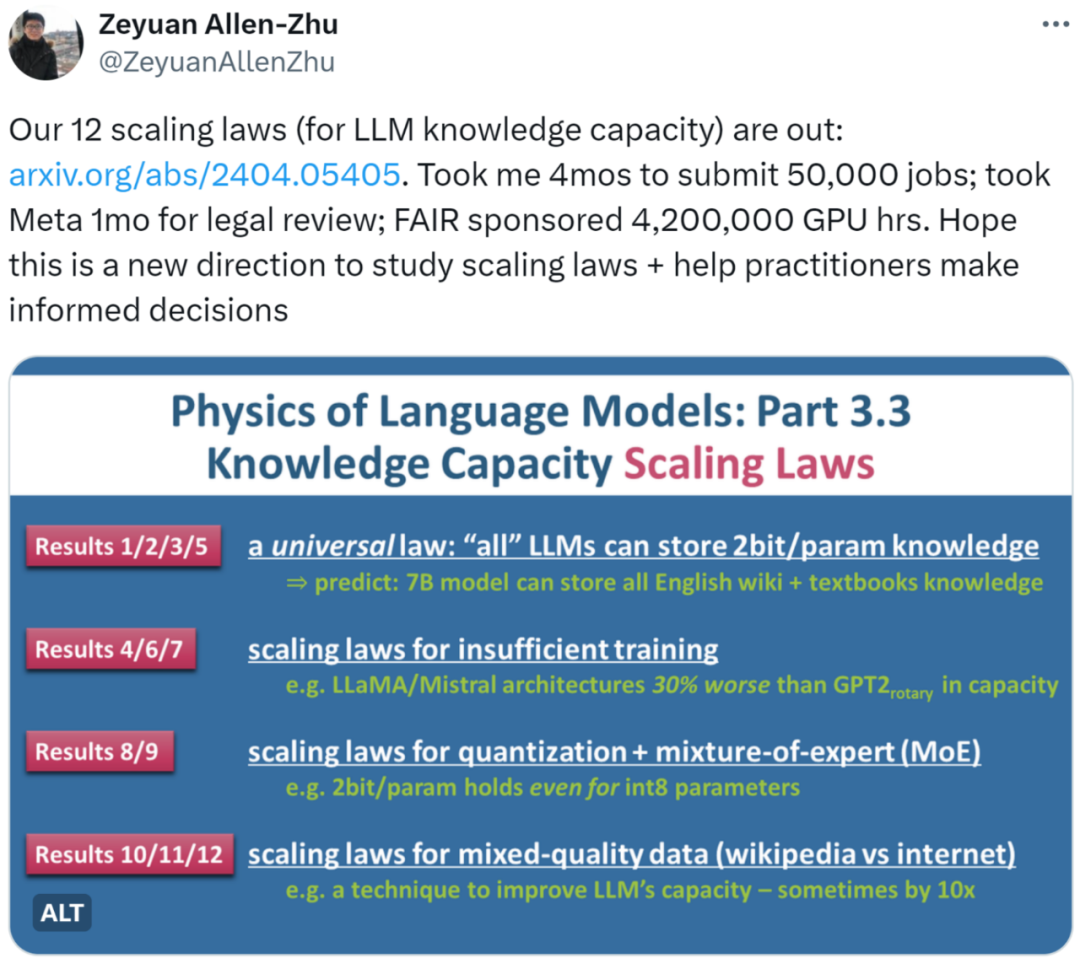

近日,朱泽园 (Meta AI) 和李远志 (MBZUAI) 的最新研究《语言模型物理学 Part 3.3:知识的 Scaling Laws》用海量实验(50,000 条任务,总计 4,200,000 GPU 小时)总结了 12 条定律,为 LLM 在不同条件下的知识容量提供了较为精确的计量方法。

在社交活动中,大语言模型既可以是你的合作伙伴(partner),也可以成为你的导师(mentor)。在人类的社交活动中,为了更有效地在工作和生活中与他人沟通,需要一定的社交技能,比如解决冲突。