刚刚,DeepMind最强「基础世界模型」诞生!单图生1分钟游戏世界,解锁下一代智能体

刚刚,DeepMind最强「基础世界模型」诞生!单图生1分钟游戏世界,解锁下一代智能体谷歌DeepMind最新基础世界模型Genie 2登场!只要一张图,就能生成长达1分钟的游戏世界。从此,我们将拥有无限的具身智能体训练数据。更有人惊呼:黑客帝国来了。

谷歌DeepMind最新基础世界模型Genie 2登场!只要一张图,就能生成长达1分钟的游戏世界。从此,我们将拥有无限的具身智能体训练数据。更有人惊呼:黑客帝国来了。

爆炸消息—— ViT三大核心作者集体离职谷歌DeepMind。下一站:OpenAI! 他们分别是翟晓华(Xiaohua Zhai)、卢卡斯·拜尔(Lucas Beyer)、亚历山大·科列斯尼科夫(Alexander Kolesnikov)。

亚马逊云科技上演了一场生成式 AI 能力的「王者归来」。

谷歌最火爆大模型产品,背后团队刚刚集体离职创业了!

当地时间周一(12月2日),总部位于荷兰的人工智能基础设施公司Nebius Group NV在官网宣布,已与精选的机构和投资者达成最终协议,获得7亿美元的融资。

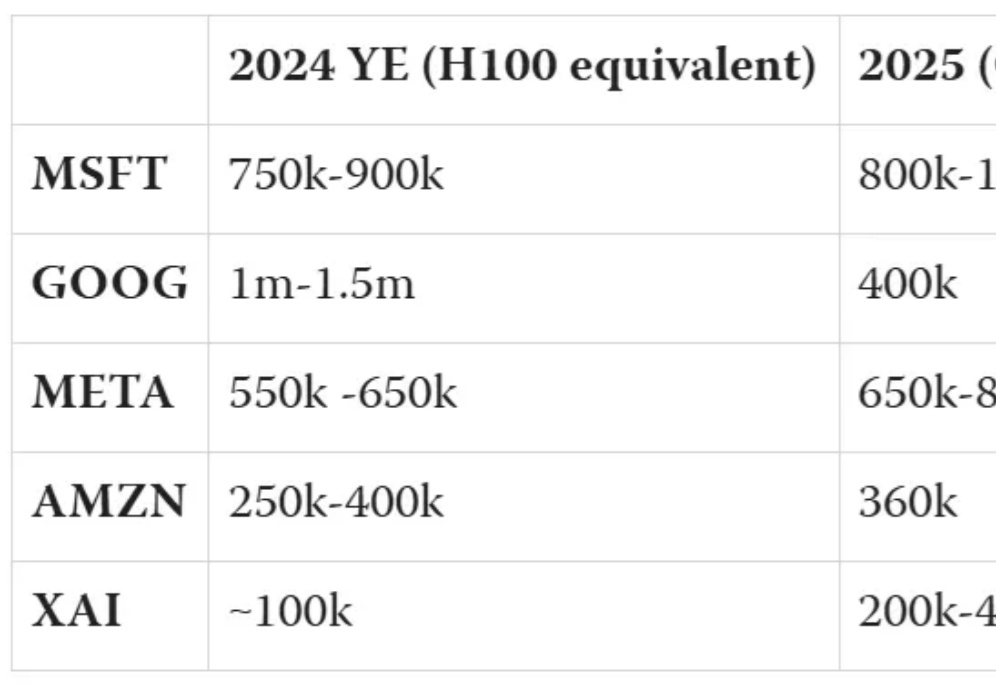

AI巨头的芯片之争,谷歌微软目前分列一二。而xAI作为新入局者,正迅速崛起。这场竞争中,谁会成为最后赢家?

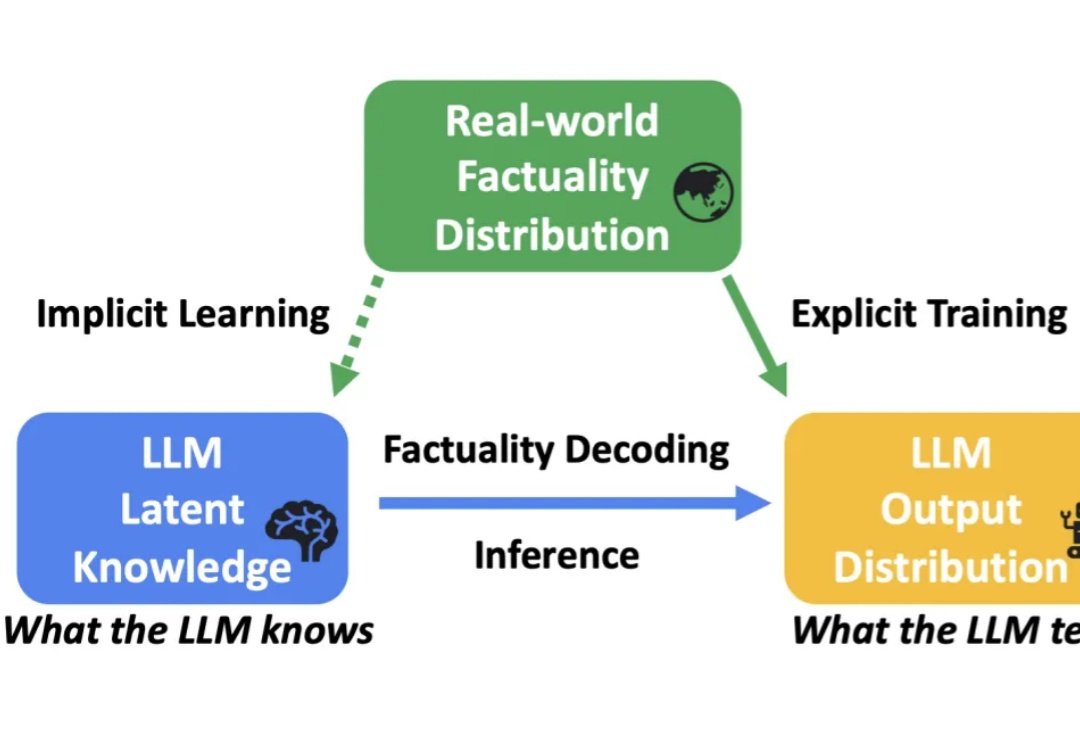

大语言模型(LLM)在各种任务上展示了卓越的性能。然而,受到幻觉(hallucination)的影响,LLM 生成的内容有时会出现错误或与事实不符,这限制了其在实际应用中的可靠性。

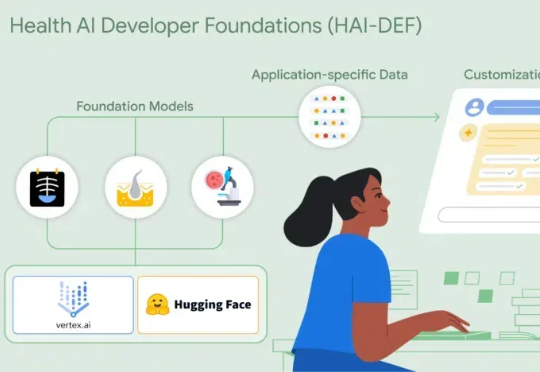

Google研究院健康AI团队于近日推出了全新的开源模型套件——Health AI Developer Foundations(HAI-DEF)。在本次HAI-DEF的首次发布中,Google推出了三个专注于医疗影像应用的重要模型。首先是CXR Foundation胸部X光模型,其次是Derm Foundation皮肤影像模型,第三个是Path Foundation病理学模型,它基于ViT-S架构

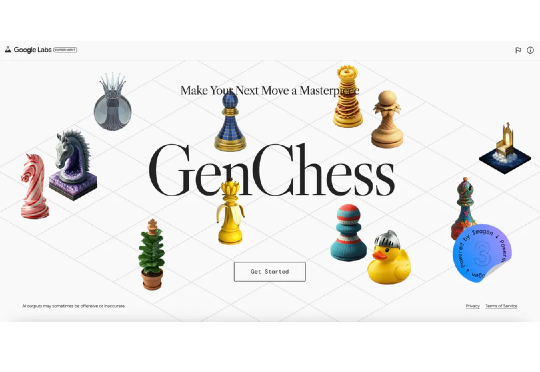

上周我们受谷歌邀请,来到了国际象棋世界冠军赛的现场。其中最激动的就是采访世界冠军丁立人老师(中国第一个男子国际象棋世界冠军!采访稿过几天会发布!)以及体验谷歌的 AI 展区!展区包括 AI 象棋解说(Chatting Chess),帮助小白和观众通俗易懂地学习如何下棋;

2024年,企业对AI的投资激增至138亿美元,显示了行业从实验到实际应用的转变,AI技术正逐渐渗透到各行业核心,推动效率和创新。同时,企业在AI应用上趋向于采用多模型策略,且越来越重视自主智能体技术。