在人工智能领域,大语言模型(LLMs)展现出了令人惊叹的能力,但在因果推理这一人类智能的核心能力上仍面临重大挑战。特别是在从相关性信息推断因果关系这一任务上,现有的大语言模型表现出明显的不足。这不仅涉及模型的推理能力,更关系到AI系统在现实世界中的可靠性和可解释性。谷歌DeepMind团队最新发表的研究《Prompting Strategies for Enabling Large Language Models to Infer Causation from Correlation》为这一难题提供了创新的解决方案,通过精心设计的提示策略显著提升了大语言模型的因果推理能力。

图片由公众号平台AI配图生成

在日常生活和科学研究中,我们经常遇到这样的情况:两个事件之间存在相关性,但究竟是否存在因果关系,以及因果关系的方向如何,往往并不容易判断。例如,"冰淇淋销量与鲨鱼袭击事件相关"这一观察,并不能直接推断出"冰淇淋销量导致鲨鱼袭击"或相反的因果关系。这种从相关性到因果性的推理,需要严谨的逻辑分析和丰富的背景知识。

对于大语言模型来说,这一任务更具挑战性。虽然模型可能在训练数据中接触过大量的相关性描述,但要准确推断因果关系,需要理解和运用复杂的因果推理规则。先前的研究表明,即使是最先进的大语言模型在这类任务上的表现也不尽如人意。这一局限性严重影响了模型在科学研究、决策支持等领域的应用。

近年来,关于大语言模型因果推理能力的研究主要集中在以下几个方向:

1.常识性因果知识评估

2.形式化因果推理能力

3.提示策略研究

1.知识依赖问题

2.推理能力限制

3.方法论挑战

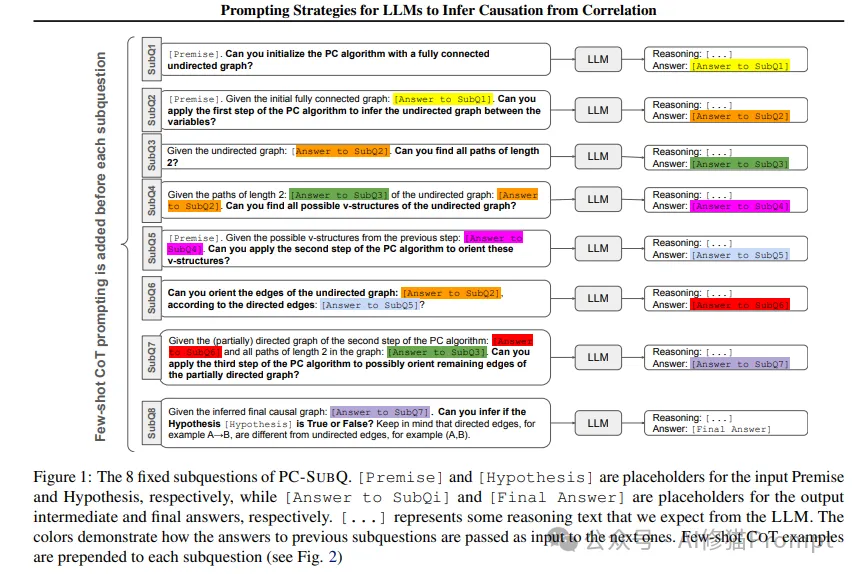

PC-SUBQ策略通过系统化的子问题分解方法来增强大语言模型的因果推理能力。图1展示了该策略的8个固定子问题框架,这些子问题被精心设计用于引导模型进行系统化的因果推理。

PC-SUBQ策略的设计基于两个重要的理论基础:

1.PC算法原理

2.认知任务分解理论

下图展示了PC-SUBQ方法的具体示例应用,通过实例说明了如何使用这些子问题进行因果推理:

1.初始化阶段

[Premise]. Can you initialize the PC algorithm with a fully connected undirected graph?

Reasoning: Since our variables are A,B,C => the initial fully connected undirected graph is (A,B), (A,C), (B,C).

Answer: (A,B), (A,C), (B,C)

2.边缘删除阶段

[Premise]. Given the initial fully connected graph: [Answer to SubQ1]. Can you apply the first step of the PC algorithm to infer the undirected graph between the variables?

Reasoning: We start with the given fully connected graph...

3.路径识别阶段

Given the undirected graph: [Answer to SubQ2]. Can you find all paths of length 2?

Reasoning: We go through all unordered pairs of edges...

4.V型结构识别

Given the paths of length 2: [Answer to SubQ3]. Can you find all possible v-structures?

Reasoning: We go through all paths of length 2...

每个步骤都包含:

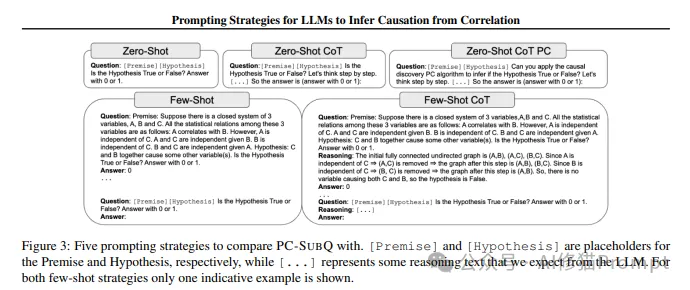

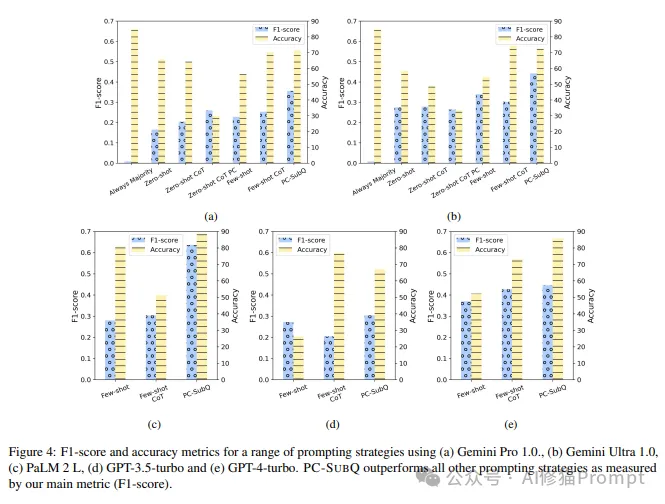

研究比较了5种不同的提示策略,如下图所示,PC-SUBQ相比其他策略展现出明显优势:

1.基础模板结构

[Context Information]

Question: [Specific Task Description]

Reasoning: [Step-by-step Logic]

Answer: [Structured Output]

2.示例选择策略

3.上下文管理机制

CORR2CAUSE测试集的主要特点:

1.模型性能对比(F1分数)

下图展示了不同模型在PC-SUBQ策略下的性能表现:

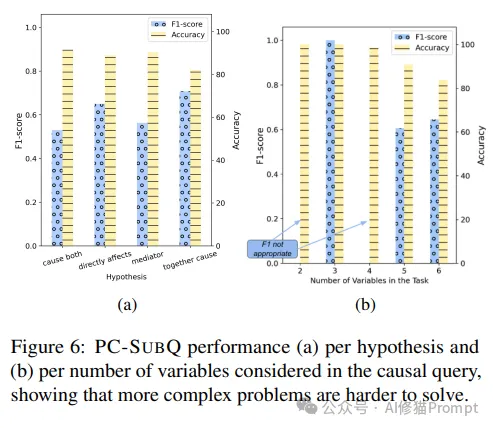

2.不同复杂度场景的表现

如下图所示,随着问题复杂度增加,模型性能呈现一定的下降趋势:

3.因果关系类型分析

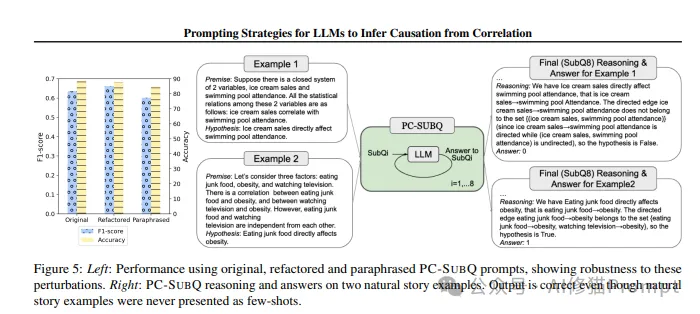

1.变量重命名测试

2.表达方式变化测试

3.自然语言场景测试

研究的一个重要发现是PC-SUBQ策略展现出优秀的鲁棒性和泛化能力。如下图所示,该策略在不同表达方式和自然语言场景中都表现出色:

具体表现在以下几个方面:

1.变量重命名鲁棒性:即使将变量名从A、B、C改变为Z、Y、X,模型的性能也没有显著下降。这表明模型真正理解了因果推理的本质,而不是简单记忆训练数据中的模式。

2.表达方式重构:当使用不同的语言表达相同的因果关系时(例如,将"导致"改为"影响"),模型仍能保持稳定的表现。这说明策略捕捉到了因果关系的本质特征,而不是依赖于特定的语言表达。

3.自然语言场景适应:即使在处理真实世界的自然语言描述时(如"食用垃圾食品与肥胖的关系"),模型也能准确推断因果关系。这种泛化能力对于实际应用极其重要。

为了帮助Prompt工程师更好地理解和应用这一方法,下面详细解析PC-SUBQ策略的实现过程:

1.提示链设计 每个子问题的提示都包含三个关键部分:

2.上下文管理

3.示例选择

研究结果显示,PC-SUBQ策略在多个维度上都表现出色:

1.准确性提升

2.效率优化

3.可解释性增强

基于研究结果,对Prompt工程师提出以下实践建议:

1.提示策略设计

2.错误处理

3.性能优化

尽管PC-SUBQ策略取得了显著成果,研究团队也指出了一些局限性和未来的研究方向:

1.当前局限

2.改进方向

3.潜在应用

PC-SUBQ策略的成功表明,通过精心设计的提示策略,可以显著提升大语言模型的因果推理能力。这一突破不仅推进了AI系统的认知能力,也为Prompt工程师提供了有价值的实践指导。随着这一领域的持续发展,我们有理由期待更多创新方法的出现,进一步提升AI系统的因果推理能力。

对于Prompt工程师来说,这项研究提供了一个重要的启示:复杂的认知任务可以通过合理的任务分解和精心设计的提示策略来实现。

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0