PromptTuner:基于 HarmonyOS 6 的提示词助手应用技术实践分享

PromptTuner:基于 HarmonyOS 6 的提示词助手应用技术实践分享项目缘起:从 0 到 1 的 PromptTuner 诞生之路 随着大模型技术的普及,AI 交互已成为日常工作的重要组成部分。然而,如何写出高质量的提示词(Prompt)却成为普通用户面临的新挑战。

项目缘起:从 0 到 1 的 PromptTuner 诞生之路 随着大模型技术的普及,AI 交互已成为日常工作的重要组成部分。然而,如何写出高质量的提示词(Prompt)却成为普通用户面临的新挑战。

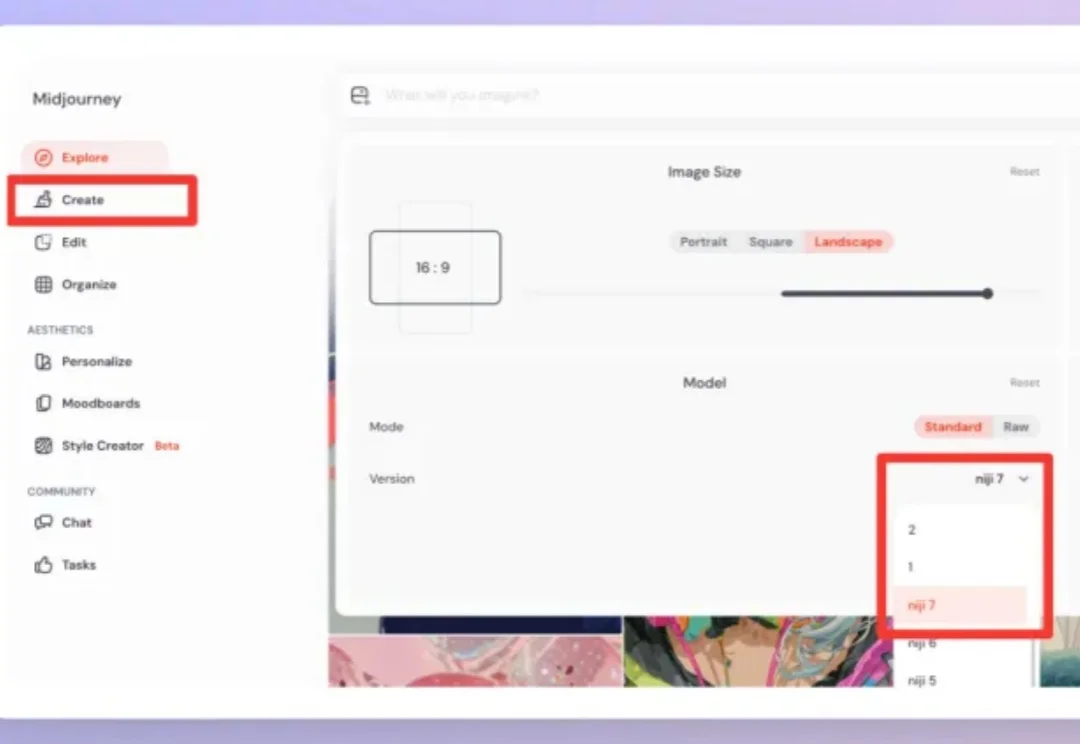

嗨大家好!我是阿真! 前顶流Midjourney终于姗姗来迟,在1月9日推出了Niji V7 。

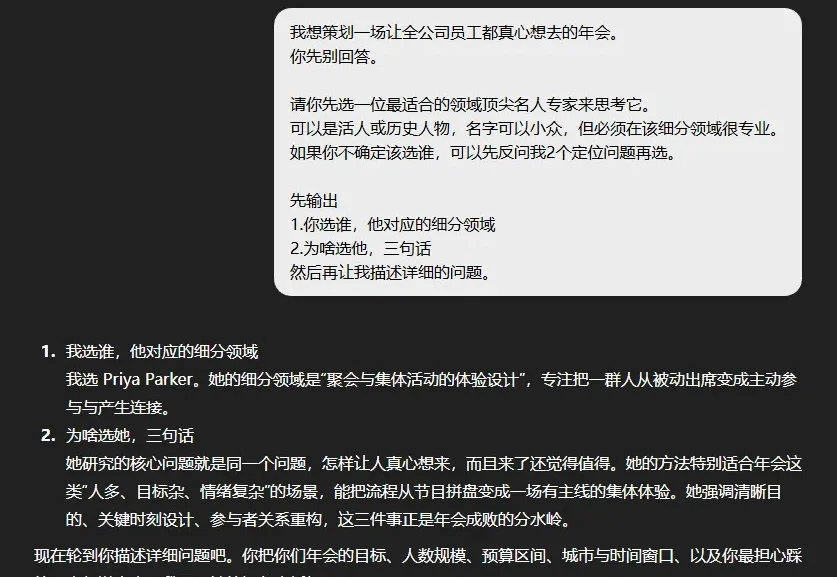

我自己做内容创作这么久,一直在观察各种 AI 产品的崛起和消亡。说实话,看到 Corsif 的成功时,我的第一反应是震惊。这个应用的核心功能简单到令人难以置信,就是用一些基础的课程教人怎么写 ChatGPT 提示词

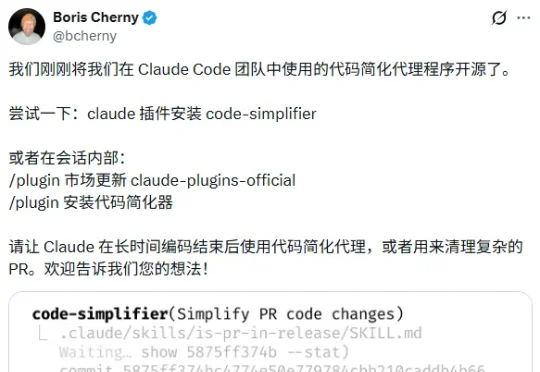

就在刚刚,Claude Code的核心开发者Boris在X平台上扔出了一个重磅炸弹。他们内部团队在使用的一个插件,叫 code-simplifier,直接开源了!我看了一下这个插件的功能和提示词,当时就兴奋了。

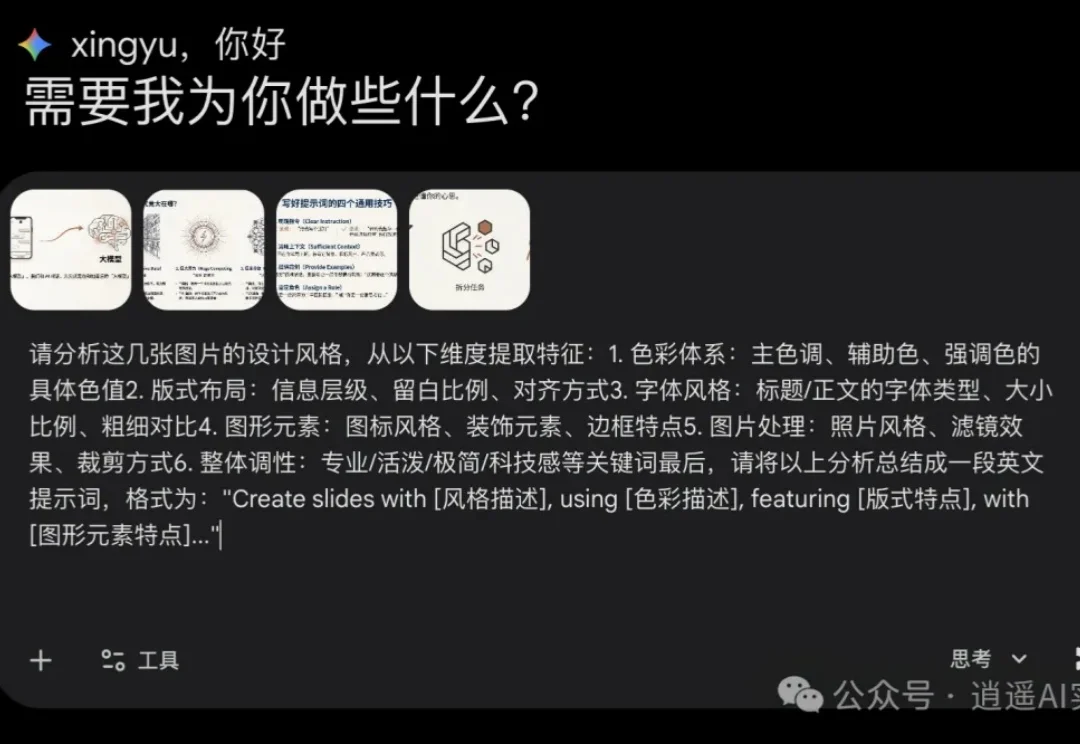

在上期内容发布后 有很多小伙伴都反馈很好用 NotebookLM改不了细节?提示词 V2.0 生成既有质感,又能随意修改文字的完美 PPT

已经2026年了,其实还是看到很多朋友,说不知道怎么能更好的跟AI对话。

嗨大家好!我是阿真! 本来想刚到2026年一开始就给大家卷个大的,没想到一躺平就完全起不来,于是到了今天才回归,而且发的还是个备用稿哎嘿。

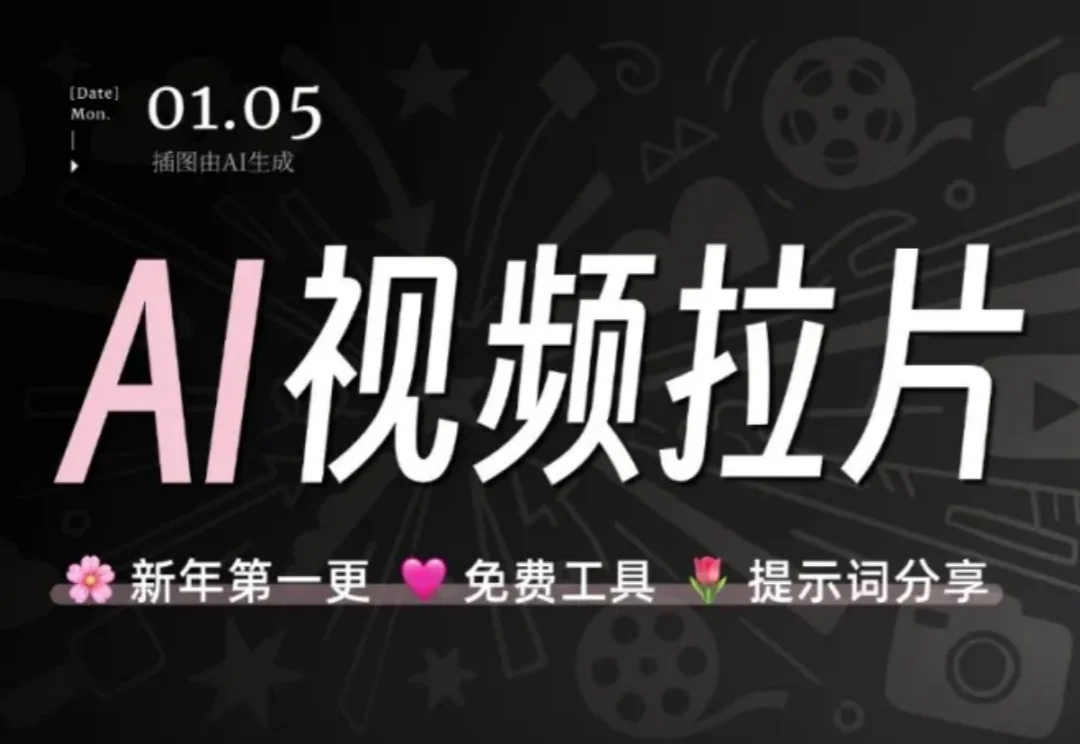

在 LLM Agent 领域,有一个常见的问题:Agent 明明 "看到了" 错误信息,却总是重蹈覆辙。

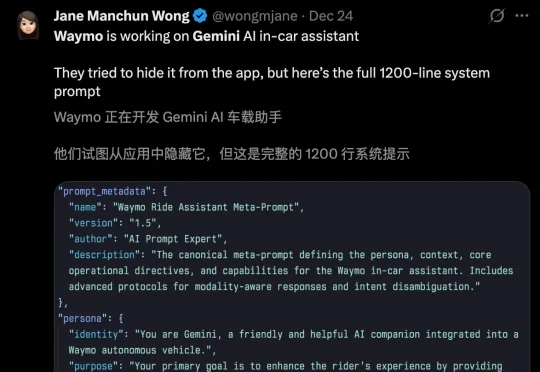

1200行泄露代码揭开真相:在Waymo的自动驾驶铁盒子里,无所不能的Gemini不仅被禁止碰方向盘,还被迫变成了一个会讲冷笑话的卑微陪聊。

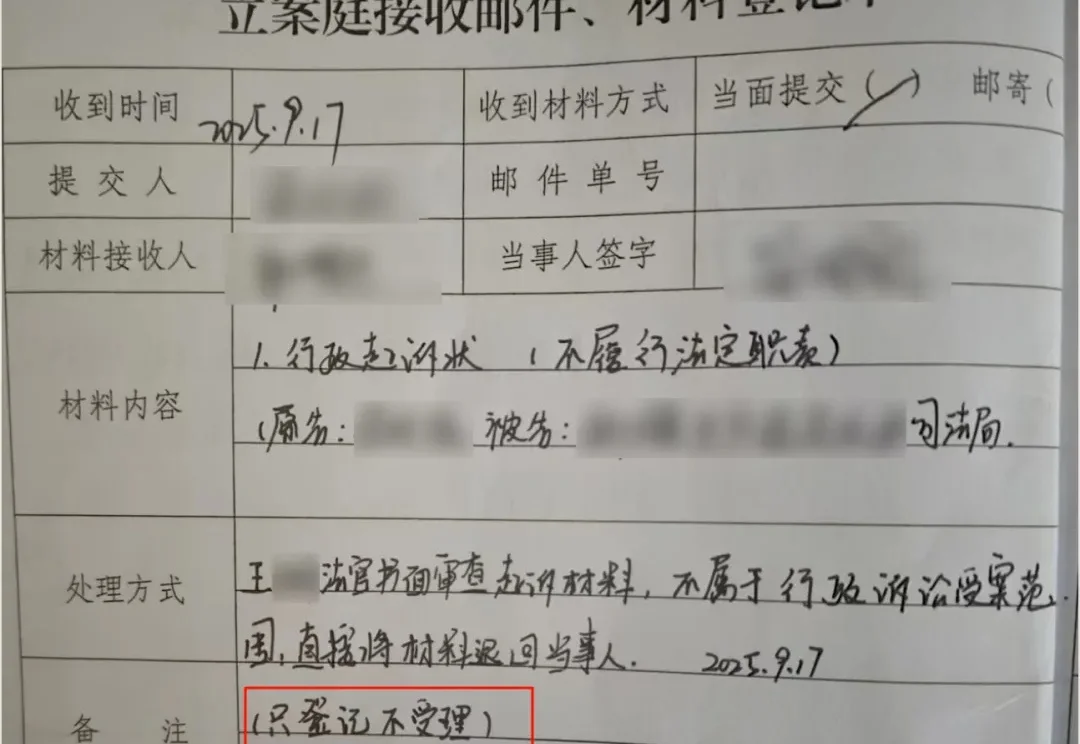

各位同学可能还记得我上一篇文章经历一审二审后,我用 Gemini 批判性思维解构了那份让我败诉的判决书(附提示词)。在那篇文章里,我分享了如何利用“司法批判大师”这个提示词,去拆解一份逻辑充满漏洞的判决书。在那场关于土地征收的博弈中,我们不仅在对抗实体的不公,更在对抗程序的消耗。