如果要你负责企业培训,培训结束需要出一份考试题目,那如今你可以选择将培训材料交给大模型,由大模型来负责出题并给出参考答案。

不过由大模型给出的考题,和人类出的题目究竟有没有差别,以及有哪些差别?

最近,加州大学伯克利分校、沙特阿拉伯阿卜杜拉国王科技城(KACST)和华盛顿大学的研究人员发表了一项研究,首次系统评价了大模型提问的能力,并指出大模型和人类的提问模式存在显著差异。

论文地址:https://arxiv.org/pdf/2501.03491

这项研究基于维基百科的文本,将文本拆分为86万个段落,之后通过亚马逊Mechanical Turk众包平台,由人类参与者为每个段落撰写对应的题目及答案,人类给出的文本将作为评估大模型的基准。

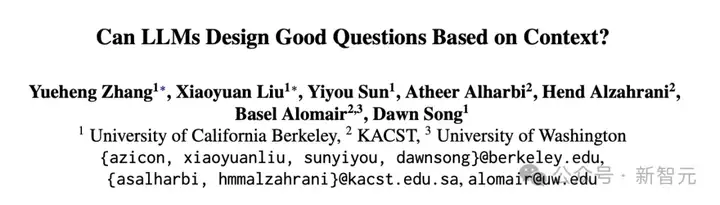

图1:大模型出题并评价的模式

之后,研究人员将这些段落交给主流的大模型,包括闭源的GPT-4o和开源的LLaMA-3.1-70b-Instruct,由大模型根据段落内容及上下文提问,之后对问题的评价也由大模型进行。

对问题的评价共包含6个指标,分为2组。前三个标准评估问题本身,而第二组标准负责评估反映问题质量的潜在答案。首先介绍与答案无关的标准。

1. 问题类型

对于人类来说,选择问哪个问题具有主观性。这项研究定义了十种问题类型,例如验证/确认问题,具体事实与数据问题及身份和归属问题等。

2. 问题长度

主要测量的是组成问题的单词数量。除了直接比较人类和大模型所生成的问题长度外,该研究还考察了问题长度与问题类型之间的关系。

3. 上下文覆盖率

上下文通常包括多个句子,问题可能只针对一个句子中的一个事实,或者需要跨越多个句子进行推理。这项标准旨在反映问题覆盖文本内容的长度,研究还分析了在生成过程中,大模型是否会有倾向性地关注上下文中的哪些特定部分。

4. 可回答程度

一个问题的关键质量标准是它是否可以在特定知识的基础上被精确地回答。具体来说,生成的提问应在提供上下文的情况下可回答,而非是模棱两可的。

5. 罕见性

大模型是在互联网上广泛可用的常识上进行训练。因此,即使没有明确提供上下文,大模型仍然可以进行提问,因此需要评估问题相对于其预训练数据的罕见程度,从而判断大模型究竟是有的放矢地提问,还是问给出一些泛泛而谈的问题。

6. 答案所需的长度

除了问题长度外,所需答案的长度是衡量提问模式的一个更有效的指标。然而,由于生成模型的回答往往冗长且包含很多无用细节,所以首先要明确提示模型提供最短的文本作为回答,并指导模型在一定的字数限制内生成答案。此外,研究者还会对这些答案进行额外评估,以确定是否可以用更少的词达到相同的质量评级。

研究结果显示,首先:在问题类型上,与人类相比,大模型更倾向于提出需要描述性、更长答案的问题,大约 44%的人工智能生成问题是这一类。

这可能是因为大模型在训练过程中接触到了大量描述性文本。而人类倾向于提出更直接、基于事实的问题,例如核查具体的事实和数字,或者人物、地点、事件等。

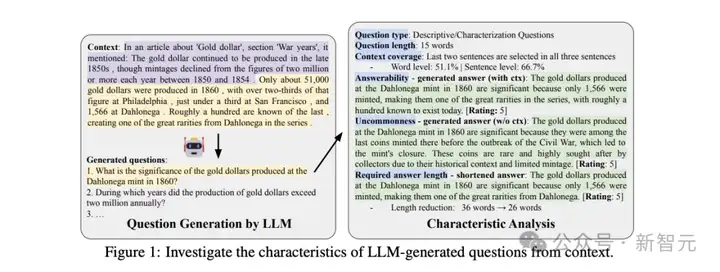

而在问题长度上,,大模型生成的问题长度更长,而且不同模型对问题长度的偏好有所不同,例如GPT-4o 生成的描述性问题更长。而人类生成的问题更短,且不同类型的问题间长度差异较大。

图2:大模型提问的问题长度,前两行是人类参与者的问题长度

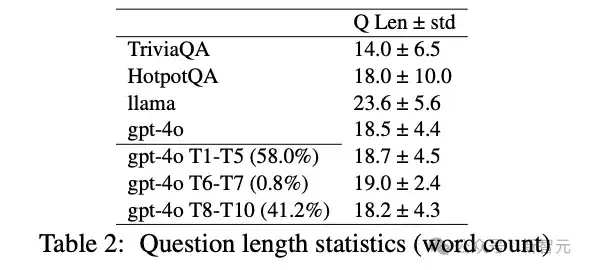

而在上下文覆盖上,人类产生的问题能更全面地覆盖上下文信息,包括句子级别和词语级别。这意味着相比人类,大模型的提问难以更全面地覆盖所有文本,往往会揪着一个细节去提问。

图3:大模型和人类提出问题对应的上下文在句子和单词层面的覆盖比

更值得关注的是,大模型更关注文本的前部和后部,而忽略中间部分,这一点之前的研究也有提及。

图4,大模型提问对不同位置的段落的覆盖情况

对于提出的问题是否可以被解答,需要根据上下文信息分别判断。如果提问所依据的文本包含了背景介绍,此时大模型生成的问题通常有清晰的答案。而如果文本中缺少上下文信息,缺乏常识的大模型生成的问题的可回答性会显著下降,甚至有些问题无法回答。

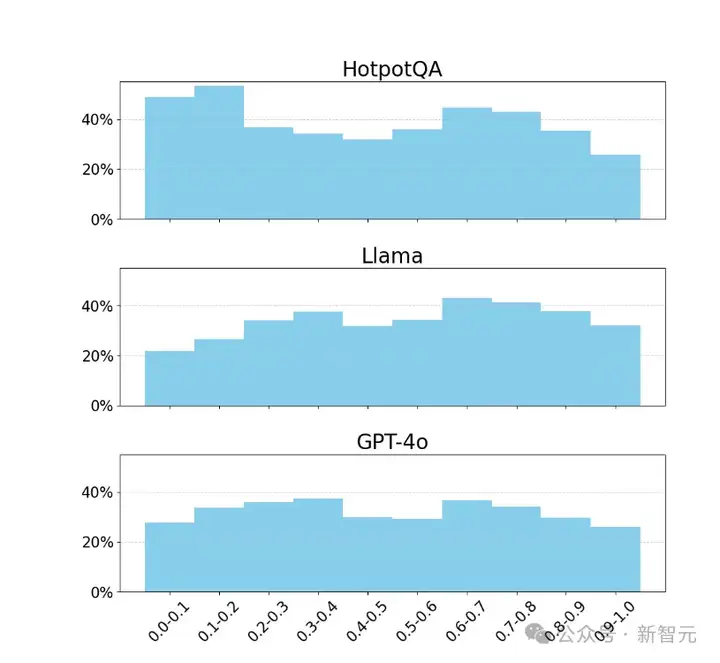

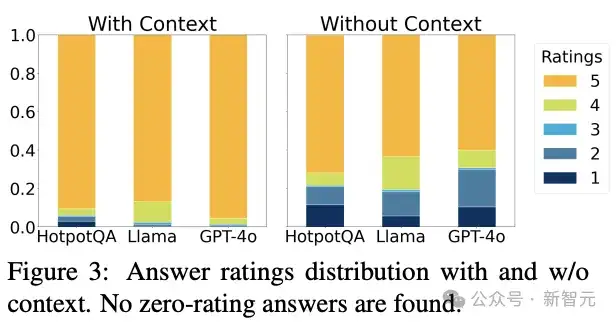

图5,对比文本包含上下文以及不包含上下文时,大模型提出的问题时具有可回答度的评分分布

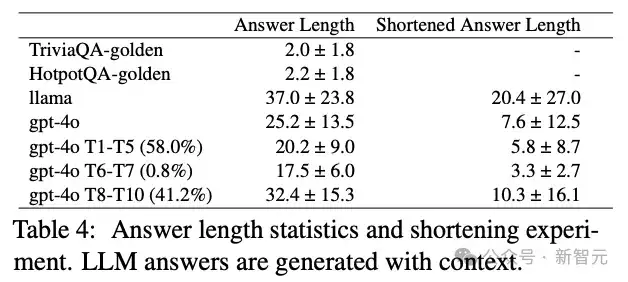

类似的,由于生成模型的特性,大模型生成的问题通常需要更长的答案、包含更多细节。同时大模型生成的答案可压缩性较差:尽管可以压缩,但仍然需要比人类更长的答案。

图6:大模型和人类提出问题对应的回答的长度

这项研究中,交给AI提问的只是一个段落,而非具有更丰富上下文的文章。未来的研究,需要考察的是大模型面对更长的文本,甚至是多篇长文本组成的书籍时会提出怎样的问题,并考察不同阅读难度、不同学科背景的文本。

如今AI生成的提问在商业产品中变得越来越普遍。例如,亚马逊的购物助手会建议与产品相关的问题,而 搜索引擎Perplexity和X的聊天机器人Grok则使用后续问题来帮助用户深入了解主题。

由于AI问题具有于区别于人类提问者的独特模式,我们就可以据此测试RAG系统,或识别AI系统何时在编造事实。

对大模型提问模式的了解,还可以帮助用户编写更好的提示词,无论是希望AI生成更类人的问题,还是要求有特定特征的问题。

随着人们越来越依赖大模型,本文最初描述的基于大模型出考试题,将会在未来变得越来越普遍,进而潜移默化地影响人类学生的思考模式,也许会让我们的下一代变得啰啰嗦嗦,或者看文章时只关注特定细节,尤其是头尾部的(考核中的重点)。

不过大模型的提问模式也是可以微调的,知道了大模型提问和人类的差异,我们就可以有针对性地进行改变。

参考资料:

https://arxiv.org/pdf/2501.03491

文章来自微信公众号 “ 新智元 ”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0