DeeSeek掀起的滔天巨浪,让全世界为之震颤。

短短几天,从R1复现狂潮,到登顶美榜APP Store,再到科技股集体重挫,这股东方神秘力量威力尽显。

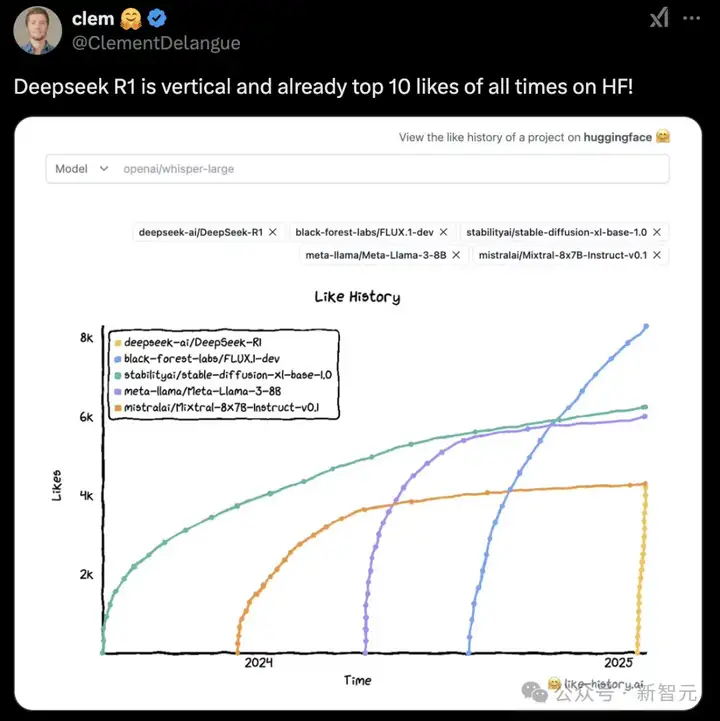

R1在Hugging Face中的like,从今年1月起直线飙升。

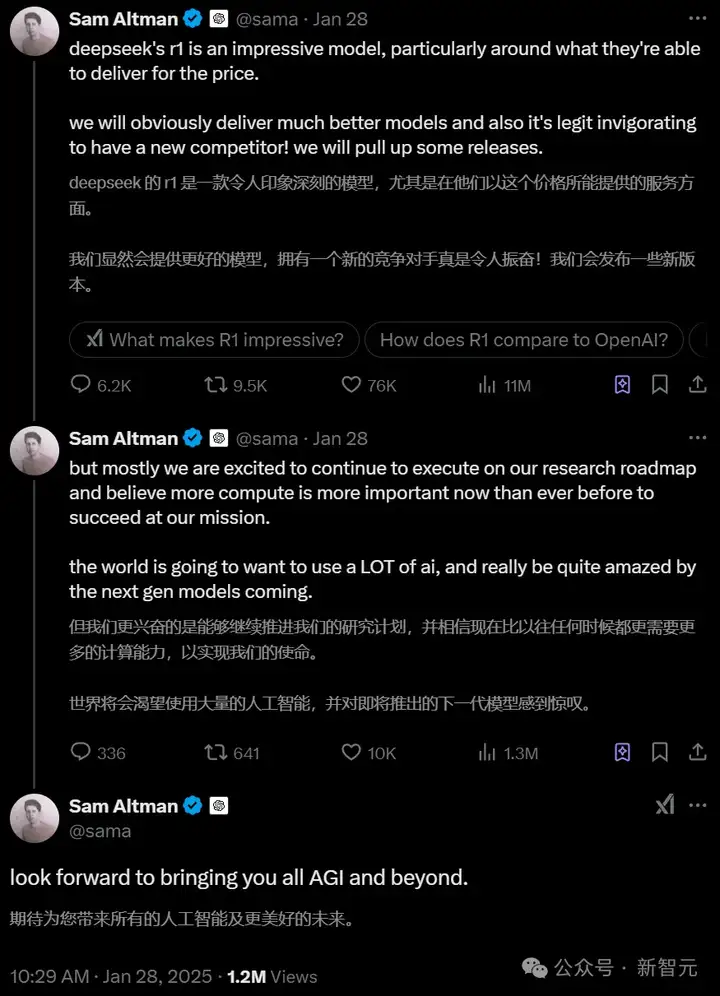

就连奥特曼本人也不得不打破沉默,公开承认DeepSeek的实力,并剧透了未来会有更多模型的发布:

DeepSeek R1是一款令人印象深刻的模型,特别是考虑到他们在这个价格范围内能够提供的能力。

我们显然会推出更好的模型,而且有一个新的竞争对手确实令人振奋!我们会加快一些版本的发布,但主要还是专注于推进OpenAI研究路线图。我们坚信,现在比以往任何时候都更需要更多的算力来实现我们的使命。

未来,世界将会需要大量的 AI,并对下一代模型感到惊叹。期待为大家带来 AGI 和更超前的技术。

与此同时,OpenAI首席研究官Mark Chen也承认道,DeepSeek的确独立发现了一些o1的核心idea。

但对于外界的各种分析,他显然是不认可的。

Mark Chen表示,现代AI系统采用了「预训练」和「推理」两大范式,提供了更灵活的优化空间。

在降低成本的同时,提升模型性能,未来OpenAI可以在这两个维度上持续发力。

而且,随着蒸馏技术日趋成熟,他们还发现成本控制和性能提升已经不再互相依赖。

换言之,OpenAI能以更低成本提供服务,也不代表就要牺牲模型的能力。

OpenAI研究科学家、德扑之父Noam Brow同样站出来表示,「算法突破和Scaling是互补的,而不是相互竞争的。前者使性能与计算量的曲线发生弯曲,而后者则是在曲线上进一步前进」。

作为「对冲」,OpenAI今天特意冒泡,发布了一个专为美国政府打造的ChatGPT Gov。

这场始于一篇22页学术论文的风暴,让一个约200人的团队,用一个模型摧毁华尔街,改变了整个硅谷对AI的看法。

恐怕连DeepSeek自己也没有想到,这将成为改写AI竞争格局的一记重拳。

论文地址:https://arxiv.org/pdf/2501.12948

DeepSeek R1论文发布之初,并未引起所有人的警觉。随着研究者逐渐消化论文内容,一个令人震惊的事实浮出水面:

R1竟以远低于科技巨头的成本,达到了可与顶级AI模型较量的水平。

更令人瞠目的是,这一突破并非依赖昂贵的算力堆砌,而是通过精妙的工程设计实现的。

当许多专家认为中国AI在竞赛中望尘莫及之时,R1的出现无异于平地惊雷。

纽约时报作者Kevin Roose就此发表了自己观点——R1似乎正在动摇美国科技产业的三个主要的假设。

首先,第一个假设是,要构建顶尖AI模型,需要在强大的芯片和数据中心上投入巨额资金。

不得不说,这一点早已成为世界公认的模型Scaling Law必备要素。

从微软、Meta、谷歌,到xAI等硅谷巨头们已经斥资数百亿美金,专为开发和运行下一代AI打造专用的基础设施。

在他们看来,这些投入远远不够。

上周,特朗普曾官宣了「星际之门」项目,计划4年内砸5000亿美金,在全美建造20座超算。

要知道,DeepSeek似乎只花费了这个数额的一小部分就打造了R1。

虽R1具体训练金额未知,业界从V3 550万美元推测,预计其成本要高于这一金额。

即便是R1训练成本是DeepSeek声称的10倍,考虑到其他成本,如工程师薪资或基础研究成本,这个数字仍然比美国人工智能公司开发其最强大模型的支出要低几个数量级。

其次,DeepSeek在成本上的突破,打破了近年来AI竞赛中「越大越好」的观点。

R1恰恰用实践证明了,经过精细的训练,相对较小的模型也可以媲美,甚至超越更大的模型。

反过来,这意味着,AI公司或许能以远低于此前预期的投资,就能实现非常强大的功能。

在研究论文中,揭示了一些关于R1实际构建方式的细节,包括「模型蒸馏」方面的一些前沿技术。

从这点可以看出,将大型AI模型压缩成更小的模型,不仅运行成本更低,同时不会损失太多性能。

此外,论文还有一些细节表明,将「普通」的AI语言模型转换为更复杂的推理模型,只需要在其基础上应用RL算法,即可实现。

第三,DeepSeek逆袭成功,也动摇了许多专家对中国在AI竞赛中处于落后地位的观点。

事实证明,美国的技术优势,可能并不如想象中的牢固。

多年来,许多AI专家一直认为美国至少领先世界几年,而且中国公司要快速复制美国的进展是极其困难的。

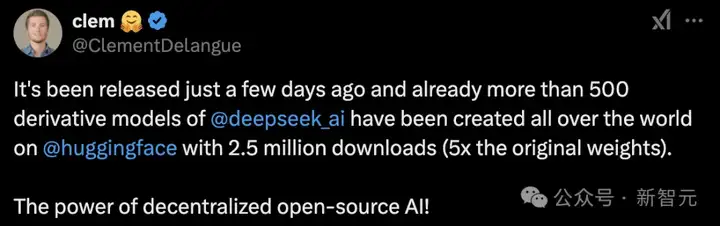

截止目前,已有超500个DeepSeek衍生模型登陆HF

但DeepSeek的结果表明,中国拥有可以匹配或超越OpenAI,以及其他美国人工智能公司模型的先进人工智能能力。

这场AI巨震带来的不仅是技术突破,更是对全球AI格局的深刻洗牌。

当整个市场还在为AI训练成本骤降而恐慌时,一些业内资深玩家却看到了不一样的未来。

硅谷众多业内人士认为,市场对DeepSeek最新模型的大规模抛售反应过度。

他们认为,该模型通过显著降低AI成本,将推动AI的更广泛应用和价值实现,从而持续维持市场对英伟达芯片的需求。

近期,前英特尔首席执行官Pat Gelsinger用实际行动给出了答案,在周一买入了英伟达的股票。

他在LinkedIn上发文表示,「市场的反应是错误的,降低AI成本将带来市场规模的扩张。DeepSeek是一项卓越的工程成就,将引领AI迈向更广泛的商业应用」。

英伟达也在周一表示,DeepSeek的创新将促进其业务的发展。

DeepSeek是一项杰出的AI技术进展,也是「测试时Scaling」的完美范例。这种推理运算需要大量英伟达GPU和高性能网络基础设施的支持。

业内专家TechInsights的G Dan Hutcheson分析更是令人深思。

在他看来,DeepSeek技术突破对英伟达的影响有限,真正应该担心的是OpenAI这样提供类似服务的公司。

而网友们在Mark Chen推文下面分享的真实体验,正是这一分析的验证。

对于机器学习研发社区而言,DeepSeek-R1是尤为重要的一个里程碑:

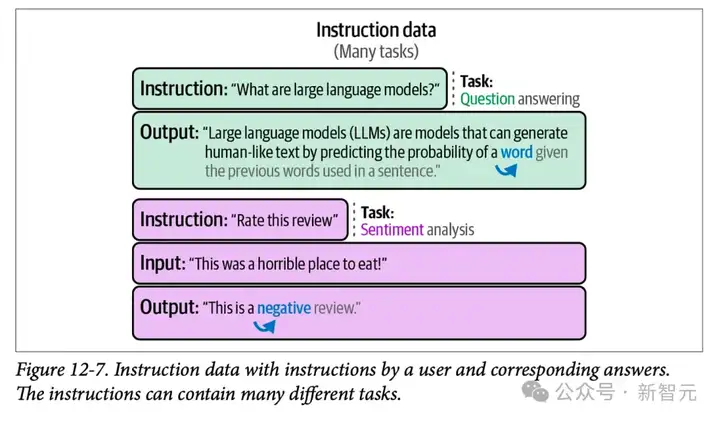

在最近的一篇博客中,就职于AI初创Chere的机器学习研究工程师Jay Alammar,便通过图解DeepSeek-R1的方式,分析了如何打造具有推理能力的大语言模型。

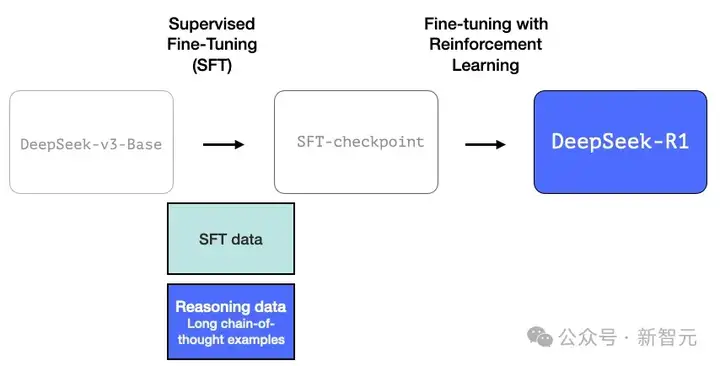

添加图片注释,不超过 140 字(可选)

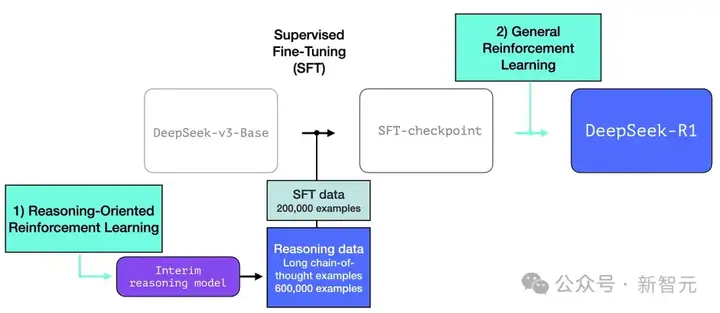

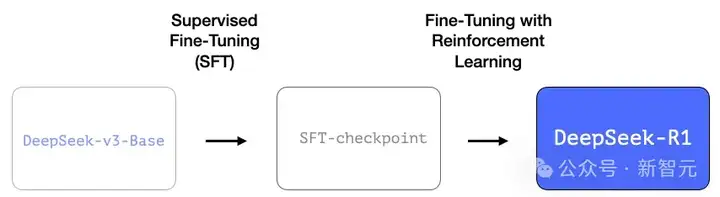

模型训练第一步的细节来自之前的DeepSeek-V3论文。

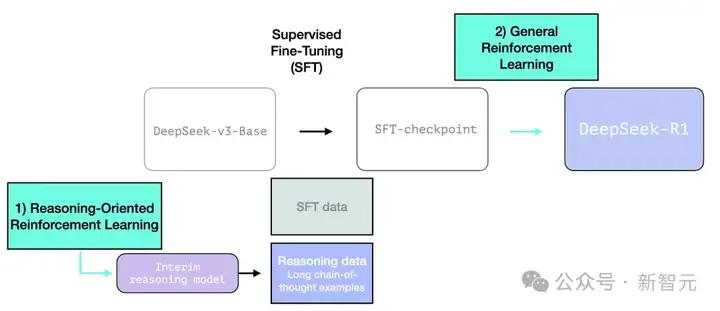

R1使用该论文中的基础模型,并仍然经过监督微调(SFT)和偏好微调步骤,但其执行方式有所不同。

这一过程包含了60万个长思维链推理示例。

然而,想要获取如此规模,并且还是人工标注的这类数据,既困难又昂贵。这就是为什么创建这些数据的过程成为第二个重要特点。

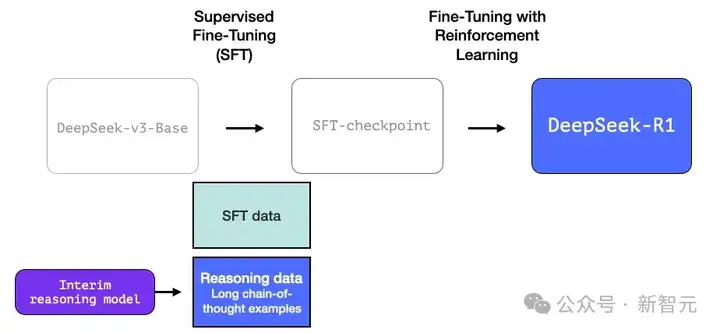

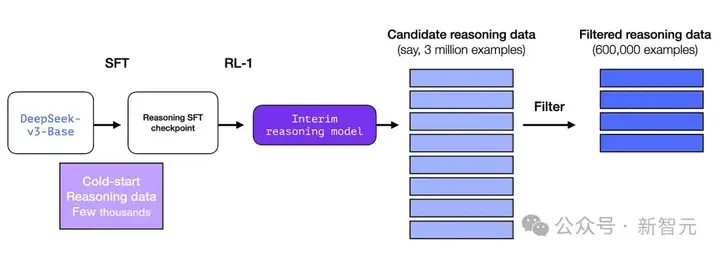

这些数据是由R1的前身——一个专注于推理的相关模型创建的。

其灵感来自于另一款被称为R1-Zero的模型。它的重要性不在于它是一个出色的通用大语言模型,而在于它仅需少量标注数据,通过大规模RL就能在解决推理问题方面表现优异。

这个专业推理模型的输出随后被用于训练一个更全面的模型,使其能够胜任其他非推理任务,达到用户对大语言模型的预期水平。

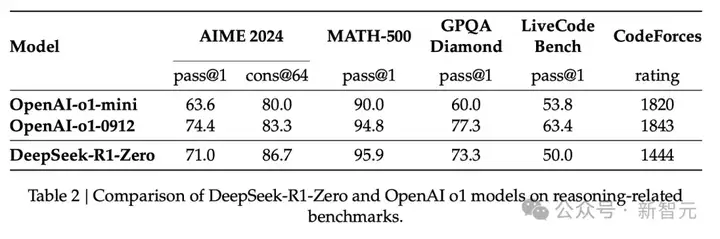

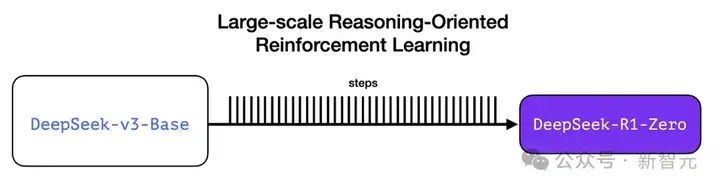

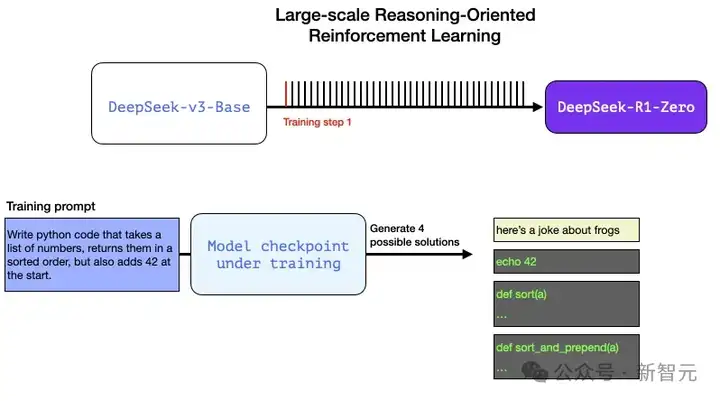

3.1 大规模面向推理的强化学习(R1-Zero)

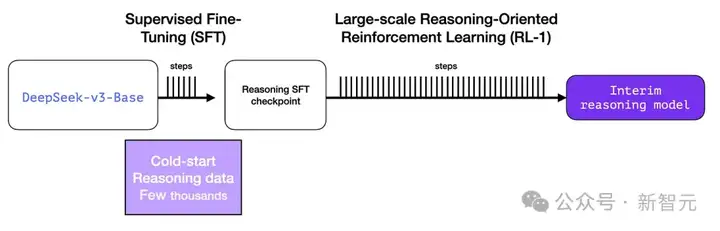

在这里,RL被用于创建临时推理模型,该模型随后用于生成监督微调的推理示例。

而使这一切成为可能的关键在于,此前创建的DeepSeek-R1-Zero模型的实验。

R1-Zero的独特之处在于,它无需标注的监督微调训练集就能在推理任务上表现优异,甚至可以与o1相媲美。

它的训练直接从预训练基础模型通过RL过程进行(无需监督微调步骤)。

一直以来,数据始终是决定机器学习模型能力的关键要素。那么这个模型是如何打破这一定律的?这涉及两个关键因素:

(1)现代基础模型已经达到了质量和能力的新高度(该基础模型在14.8万亿高质量token上进行训练)。

(2)与普通的聊天或写作任务相比,推理问题可以通过自动化方式进行验证和标注。

让我们通过一个例子来说明。以下是RL训练步骤中的一个典型提示词:

编写Python代码,接受一个数字列表,返回排序后的列表,并在开头添加数字42。

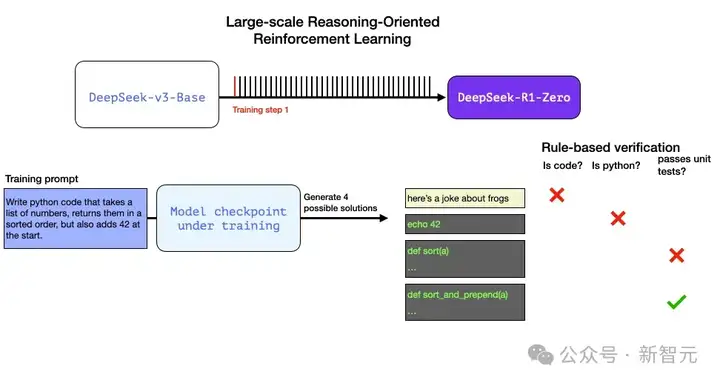

当正在训练中的模型收到这个问题并生成答案后,有很多种方式都可以实现自动验证:

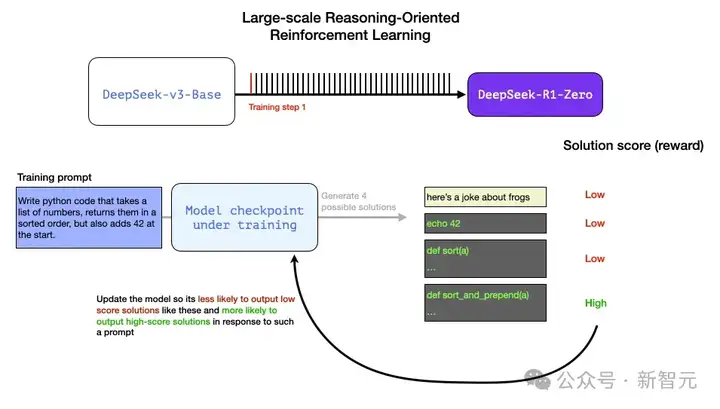

通过这种方式,我们可以在训练过程中向模型提供类似问题,并获得多种可能的解决方案。

通过自动检查(无需人为干预),我们可以发现:

这些信号都可以直接用来改进模型。当然,这种改进是通过大量示例(在mini-batch中)和连续的训练步骤来完成的。

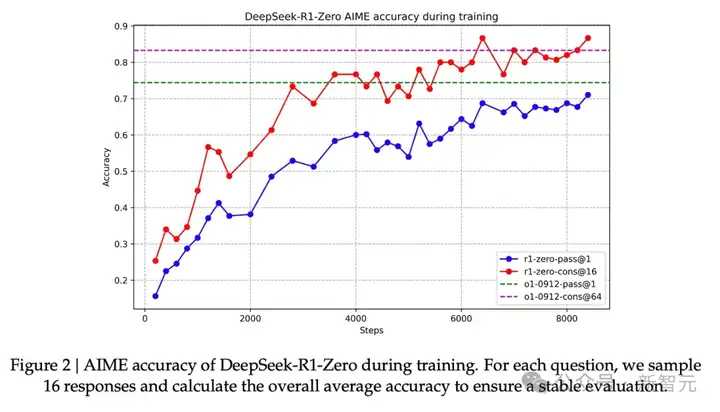

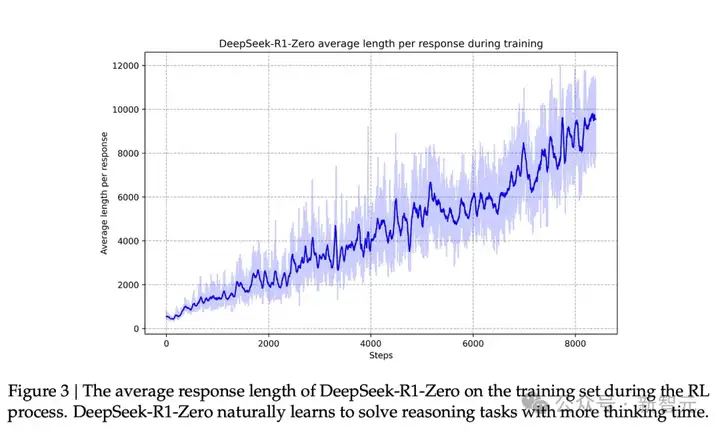

这些奖励信号和模型更新正是模型在RL训练过程中持续改进任务表现的方式,正如论文图2所示。

与这种能力的提升相对应的是,生成响应的长度变化——模型会生成更多的思考token来处理问题。

这个过程确实很有用,但R1-Zero却面临着其他影响其实用性的问题。

虽然DeepSeek-R1-Zero展现出强大的推理能力,并能自主形成令人惊喜的高效推理模式,但它仍然面临着一些挑战。比如,DeepSeek-R1-Zero在可读性和语言混合等方面存在明显的不足。

R1的目标是成为一个更实用的模型。因此,它并非完全依赖RL过程,而是在我们前文提到的两个方面加以运用:

(1)创建中间推理模型以生成SFT数据点

(2)训练R1模型以提升推理和非推理问题的处理能力(使用其他类型的验证器)

3.2 使用中间推理模型创建SFT推理数据

为了提升中间推理模型的实用性,需要对其进行监督式微调(SFT)训练,训练数据包含数千个推理问题示例(部分来自R1-Zero的生成和筛选)。论文将这些称为「冷启动数据」。

与DeepSeek-R1-Zero不同,DeepSeek-R1为了避免基础模型在RL训练初期出现不稳定的冷启动现象,我们构建并收集了少量思维链(CoT)数据来微调模型,将其作为初始RL代理。在数据收集过程中,我们探索了多种方法:采用长思维链作为示例进行少样本提示学习,直接通过提示词引导模型生成包含反思和验证的详细答案,以可读格式采集DeepSeek-R1-Zero的输出,并通过人工标注进行后期优化。

然而,既然我们已经拥有这些数据,为什么还需要依赖RL过程呢?

这主要是数据规模的限制。现有数据集可能只有5,000个示例,但训练R1则需要600,000个示例。

而中间模型正是弥合了这一数量鸿沟,使得生成如此大规模的高质量数据成为可能。

SFT训练示例

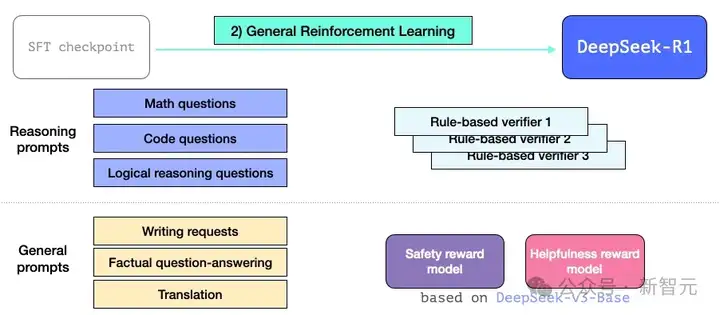

3.3 通用RL训练阶段

这使得R1不仅在推理任务上表现卓越,在非推理任务上同样可以取得优异成绩。

这一过程与前面提到的RL过程相似。但由于它延伸到非推理应用领域,因此针对这类应用的提示词,采用了有效性和安全性奖励模型(与Llama类似)。

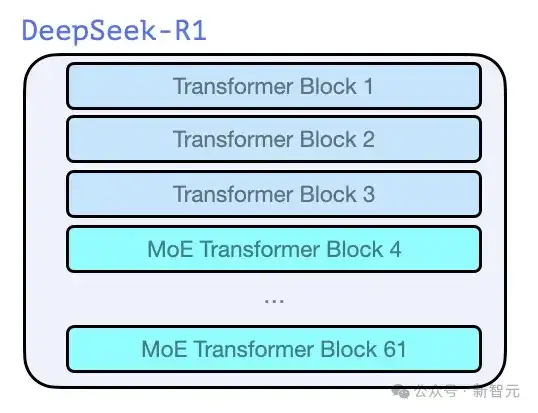

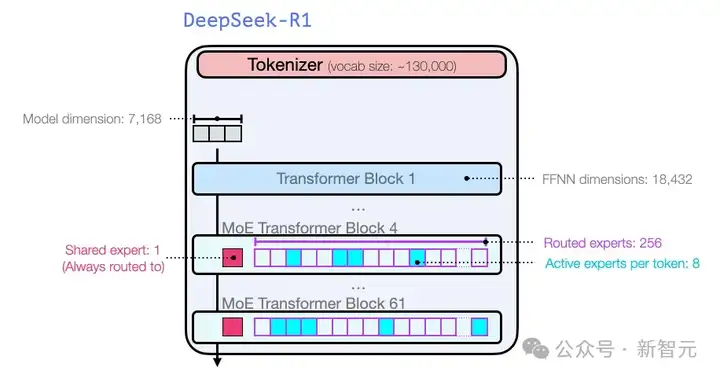

与GPT-2和GPT-3奠基时期的模型一样,DeepSeek-R1是由Transformer decoder块堆叠构成的。

它总共包含61个decoder块,其中前三个是全连接层(dense layer),其余则是专家混合(Mixture-of-Experts,简称MoE)层。

关于模型维度大小和其他超参数的配置如下:

参考资料:

https://www.ft.com/content/ee83c24c-9099-42a4-85c9-165e7af35105

https://www.nytimes.com/2025/01/28/technology/china-deepseek-ai-silicon-valley.html?unlocked_article_code=1.sk4.hgB2.qjaBLLlA_jiL

https://newsletter.languagemodels.co/p/the-illustrated-deepseek-r1

文章来自微信公众号 “ 新智元 ”

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0