如何将全模态大模型与人类的意图相对齐,已成为一个极具前瞻性且至关重要的挑战。

在当前AI领域的快速发展中,“强推理慢思考”已经成为主要的发展动向之一,它们深刻影响着研发方向和投资决策。如何将强推理慢思考进一步推广到更多模态甚至是全模态场景,并且确保和人类的价值意图相一致,已成为一个极具前瞻性且至关重要的挑战。

DeepDeek-R1多模态版本Align-DS-V开源地址:https://huggingface.co/PKU-Alignment/Align-DS-V

align-anything框架地址:https://github.com/PKU-Alignment/align-anything

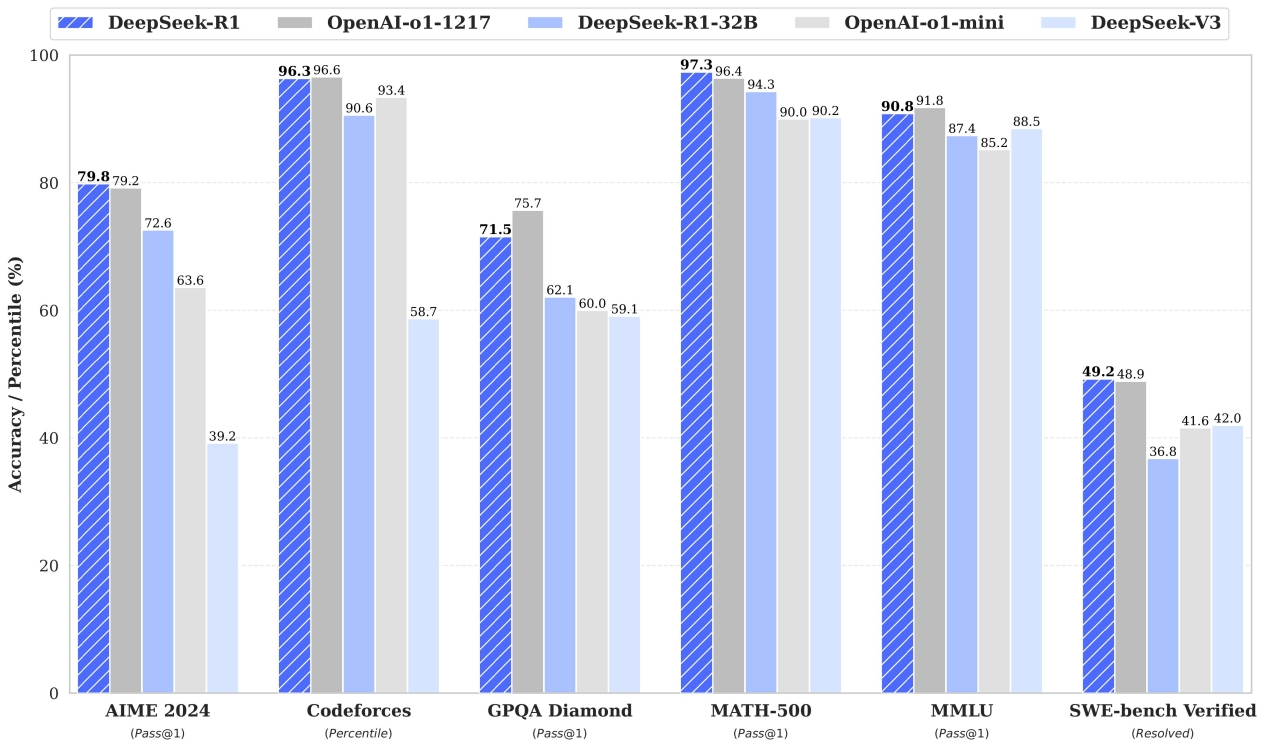

得益于强大的推理与长文本思考能力,DeepSeek R1自开源以来便备受关注。Deepseek R1在AIME2024上获得了79.8%的成绩,略高于OpenAI-o1-1217。在MATH-500上,它获得了97.3%的惊人成绩,表现与OpenAI-o1-1217相当,并明显优于其他模型。在编码相关的任务中,DeepSeek-R1在代码竞赛任务中表现出专家水平,在Codeforces上获得了2029 Elo评级,在竞赛中表现优于96.3%的人类参与者。

Deepseek R1-Zero 和 R1 的出现再次证明了强化学习的潜力所在。R1-Zero 从基础模型开始构建,完全依赖强化学习(RL),而不使用人类专家标注的监督微调(SFT)。在训练过程中,随着步骤增加,模型逐渐展现出长文本推理以及长链推理的能力。随着推理路径的逐步增长,模型还表现出自我修复的能力,能够发现并修复之前的错误。

Deepseek R1-Zero 和 R1 在纯文本模态上取得的优异表现十分惊艳,这也不经让人期待:多模态场景加持下Deepseek R1 深度推理模型将会是怎样的表现?

• 模态穿透和模态联动将有望进一步提升强推理能力。人类在日常生活中接收到的信息往往是全模态的,不同的感官渠道能够互相补充,帮助我们更全面地理解和表达复杂的概念。这种全模态的信息流对大模型范式转向通用人工智能也同等重要,研究人员开始尝试将大语言模型进行模态扩展,得到不仅能够处理语言,还可以理解并生成图像、音频、视频等多种信息的全模态模型,如GPT-4o、Chameleon等。

• 全模态扩展将成为Deepseek R1的下一个重大突破。首先,在复杂决策场景中构建起"感知-理解-推演"的闭环认知体系,在多个场景下扩展智能边界。例如,通过跨模态对齐技术,模型能将CT影像的灰度特征与病理报告的专业术语建立语义关联,在医疗诊断中同步分析X光片阴影分布与患者主诉症状。此外,这种时空关联推理能力使得自动驾驶系统能同时解析路况视频中的车辆轨迹、交通信号灯的闪烁频率以及周围环境的异常声响,实现更精确的多维度风险预判。

• 强推理能力在全模态场景下的扩展面临诸多挑战。文本模态场景下,许多复杂推理任务可以通过基于规则的奖励提供监督信号,作为人类意图和偏好的载体。而当从文本模态扩展到多模态甚至全模态场景下时,许多问题会随之呈现:随着模态数量增加,传统二元偏好或规则奖励是否能够捕捉人类意图的多元偏好或层次化偏好?当多模态扩展到全模态空间,模态交互更加复杂,RL方法需要做哪些改进?不同模态下,模态特有与模态共有的信息如何统一在奖励信号建模中?

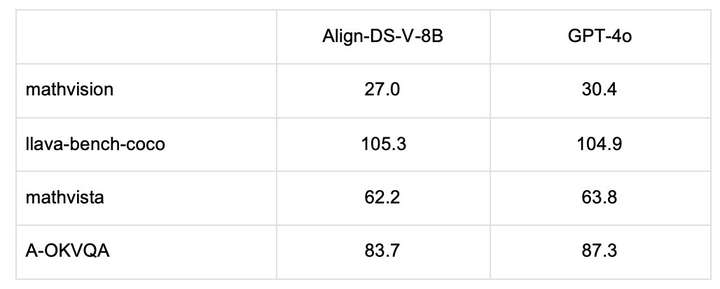

在Deepseek R1发布后,北大联合香港科技大学团队基于自研框架align-anything,在一周之内迅速地将Deepseek R1系列模型扩展至图文模态,并取得了优越的视觉理解表现,以下是部分评测结果:

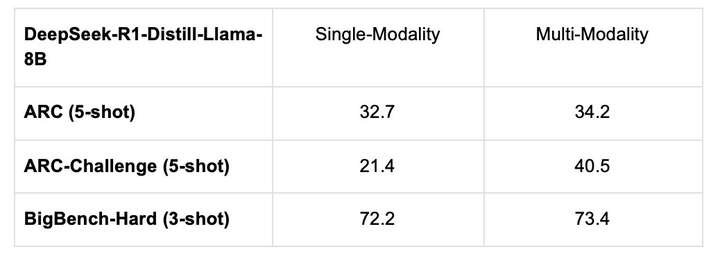

更重要的是,除此之外,该团队还发现了模态穿透对于模型文本模态推理能力的提升效果。

具体来说,团队在DeepSeek R1 的全模态化尝试中发现,经过多模态训练之后,模型在文本模态任务上的表现有所提升,在科学任务、复杂推理、数学代码等方面的表现均有提升。

团队认为,当下多模态大模型已具备强大的跨模态穿透与融合的感知能力,能够通过结合世界知识与上下文学习能力,实现多种模态(如图像、文本、音频、视频等)的高效推理与协同输出。

而基于慢思考强推理能力的持续自我进化,突破了单一模态的局限性,跨模态穿透深度显著提升。通过深度融合世界知识,模型在文本模态下的推理边界得以拓展。

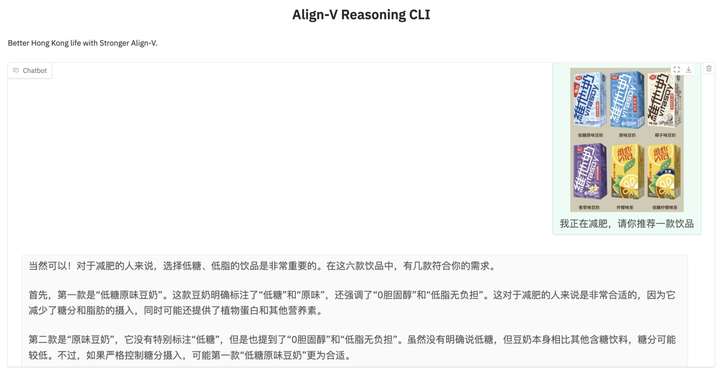

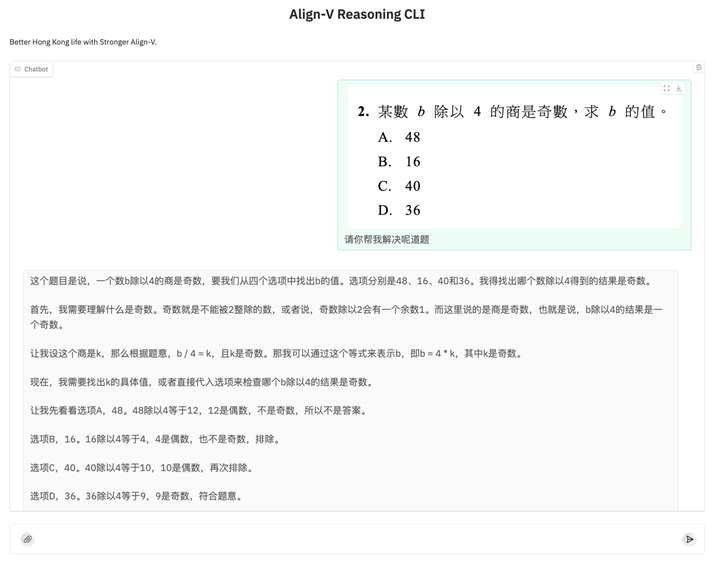

为验证全模态推理大模型在垂域应用的强大能力,研发团队对Align-DS-V面向进行香港地区价值观的本地化对齐,令Align-DS-V适应粤语/英语/普通话混合语言输入,深度整合港铁动态、台风预警及八达通缴费等香港本土生活场景。

在被图文询问到哪一款维他奶(香港地区的热门饮品)更加减脂时,Align-DS-V精确地选择了其中的低糖原味豆奶,并且也指出原味豆奶同样适合减脂饮用,为香港日常饮食选择提供便利。

而在面对包含繁体字的图文数学问题时,Align-DS-V能够准确联动图文模态信息,使用严密而逐步的数学推导展示求解过程,展示了被应用于教育等行业的可信前景。

大语言模型多模态化已是大势所趋,而支持任意的模态输入并生成任意模态的输出的全模态大模型将成为未来的里程碑。如何将全模态大模型与人类的意图相对齐,已成为一个极具前瞻性且至关重要的挑战。然而,随着模态的增加,输入输出空间的分布更加广泛,并增加了幻觉现象,使得全模态对齐变得更加复杂。事实上,为进一步促进社区的多模态对齐研究,研究团队在数据集、算法、评估以及代码库四大维度贡献了开源力量:

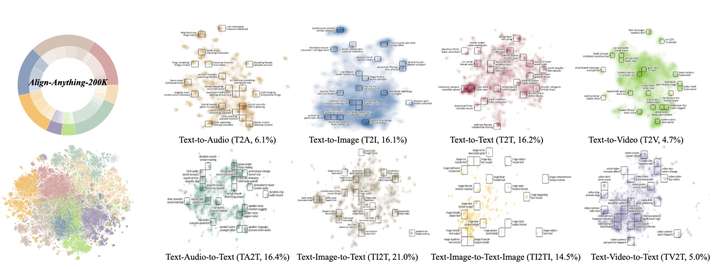

• 数据:200k包含人类语言反馈和二元偏好的数据集,包含图、文、视频、语音全模态。

• 算法:从语言反馈中学习的合成数据范式,大幅提升RLHF后训练方法的表现。

• 评估:面向全模态模型的模态联动与模态选择评估。

• 代码库:支持图、文、视频、语音全模态训练与评估的代码框架

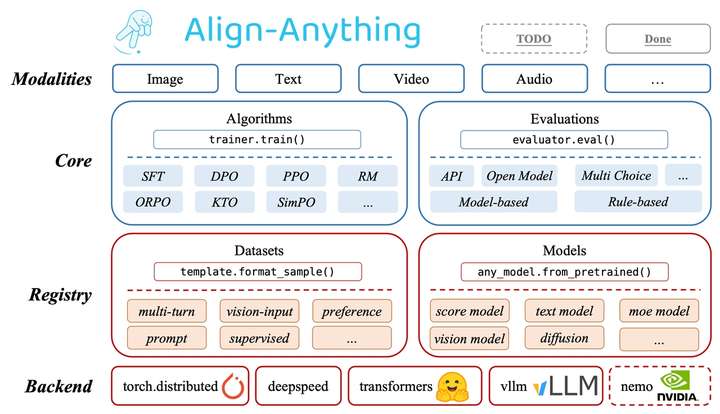

align-anything 框架致力于使全模态大模型与人类意图和价值观对齐,这里的全模态包括文生文、文生图、文图生文、文生视频等任意到任意的输入与输出模态,总体而言,框架设计了具备高度的模块化、扩展性以及易用性的对齐训练框架,支持由文本、图片、视频、音频四大基本模态衍生出的任意模态模型对齐微调,并验证了框架对齐算法的实现正确性。该框架具有以下特点:

• 高度模块化:对不同算法类型的抽象化和精心设计的API,用户能够为不同的任务修改和定制代码,以及定制化模型与数据集注册等高级扩展用法;

• 支持跨任意模态模型的微调:包含对如 LLaMA3.2、LLaVA、Chameleon、Qwen2-VL、Qwen2-Audio、Diffusion等跨越多种模态生成与理解的大模型的微调能力;

• 支持不同的对齐方法:支持任意模态上的多种对齐算法,既包括SFT、DPO、PPO等经典算法,也包括ORPO, SimPO和KTO等新算法;

• 支持多种开、闭源对齐评估:支持了30多个多模态评测基准,包括如MMBench、VideoMME等多模态理解评测,以及如FID、HPSv2等多模态生成评测;

同时,为了促进社区进一步开发全模态对齐模型,研究团队发布首个全模态人类偏好数据集align-anything。与专注于单个模态且质量参差不齐的现有偏好数据集不同,align-anything提供了高质量的数据,包括了输入和输出中的任何模态,旨在提供详细的人类偏好注释以及用于批评和改进的精细语言反馈,从而实现跨模态的全面评估和改进。

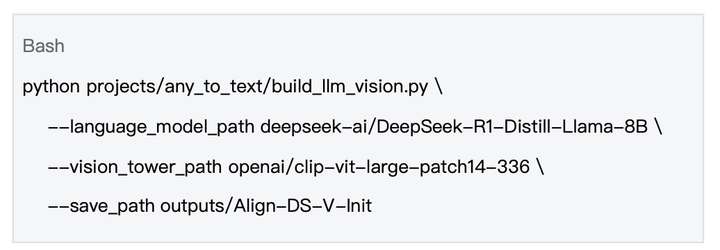

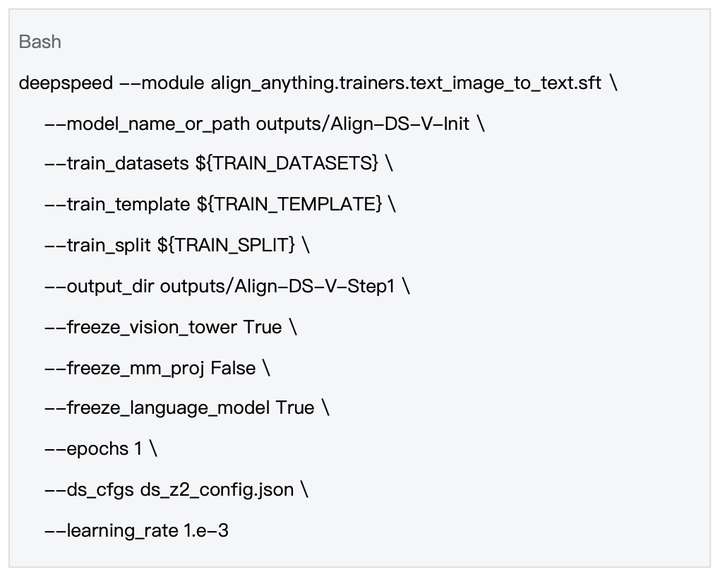

借鉴 LLaVA 的训练思路,通过训练投影层(Projector),团队将视觉编码器(Vision Encoder)输出映射到语言表征空间,从而扩展了 R1 的视觉模态。在 Align-Anything 库中,团队开源了训练的全部流程。首先,基于 Deepseek R1 系列模型,构建“文本 + 图片-> 文本”架构,例如以下脚本:

在新的多模态模型中,输入图像经过视觉编码器提取特征,生成中间表示,然后通过投影层进行映射,得到视觉表征 。与此同时,语言指令经过处理,生成语言表征。这些视觉和语言特征共同输入到语言模型,语言模型将两种信息结合进行推理,最终生成文本回复。

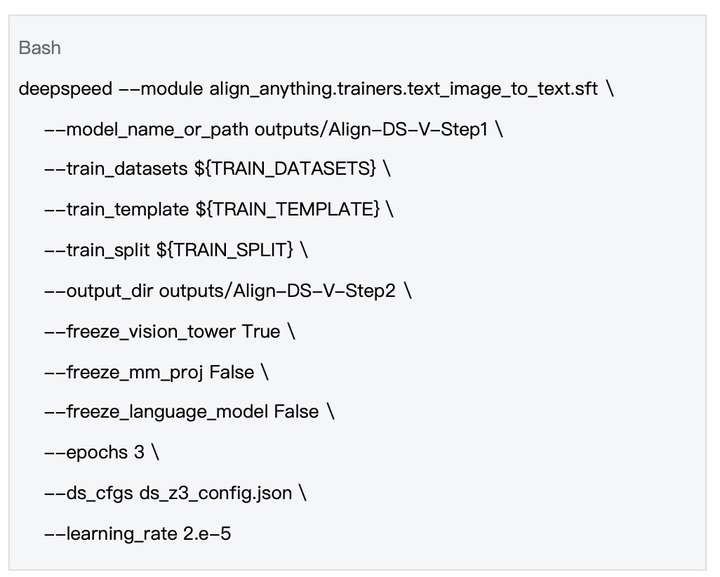

在构建好模态扩展的 R1 架构后,具体的训练分成两个步骤:

第一步,冻结除投影层 Projector 外所有模型参数,对投影层 Projector 进行预训练,使得投影层 Projector 能够将经过视觉编码器的视觉表征映射到语言表征空间。

第二步,同时微调投影层 Projector 和大语言模型,激发语言模型多模态推理能力。

同时,北大-灵初联合实验室在Align-DS-V的基础上正在VLA方面做进一步的探索。目前灵初正在研发的VLA模型在大脑端利用多模态大模型进行对齐和微调,并输出action token给到小脑端的控制器。小脑端的控制器再根据输入的token和其他模态的信息进行具体机器人控制指令的输出。在这两个过程中都需要使用到针对多模态大模型的后训练和微调技术。Align-DS-V的多模态强推理能力是VLA模型大脑端的核心,接下来利用其跨模态穿透的能力实现action穿透,实现真正高效的VLA模型。同样的后训练技术也可以应用于小脑端控制器的微调,实现更高的成功率,泛化性和鲁棒性。

本项目由北京大学联合香港科技大学联合开发,并进行长期维护,北京大学对齐团队专注于人工智能系统的安全交互与价值对齐,指导老师为北京大学人工智能研究院杨耀东助理教授。香港生成式人工智能研发中心(HK Generative AI R&D Center,HKGAI)成立于2023年10月。中心致力于推动香港人工智能生态系统的发展,由香港科技大学首席副校长,郭毅可院士领衔担任中心主任。

文章来自 “ 蓝驰创投 “

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner