今天向大家介绍一项来自香港大学黄超教授实验室的最新科研成果 VideoRAG。这项创新性的研究突破了超长视频理解任务中的时长限制,仅凭单张 RTX 3090 GPU (24GB) 就能高效理解数百小时的超长视频内容。

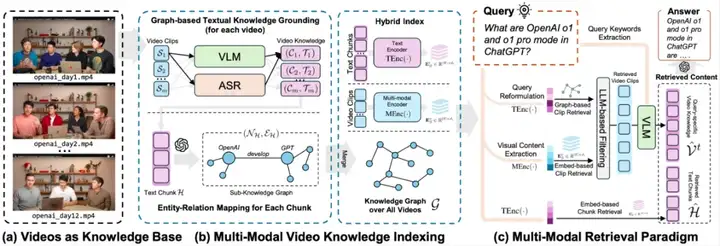

VideoRAG 采用了创新的多模态知识索引框架,将这些海量视频内容浓缩为简洁、结构化的知识图谱,从而支持跨视频推理。其多模态检索范式能够有效对齐文本语义与视觉内容,确保从多个长视频中精准检索出相关片段,生成全面而精确的回答。

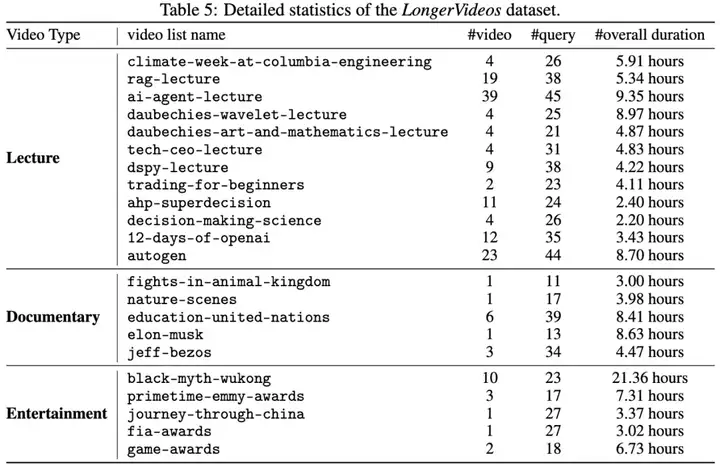

此外,研究团队还建立了全新的 LongerVideos 基准数据集,包含 160+ 个视频,涵盖了讲座、纪录片和娱乐等类别,为该领域的未来研究提供了有力支持。

总的来说,VideoRAG 拥有以下优势:

RAG (Retrieval-Augmented Generation)技术通过在推理阶段引入外部知识,显著增强了预训练大语言模型(LLM)的能力。然而,当前成熟的 RAG 框架主要聚焦于文本领域,在视频理解任务中的应用仍面临诸多限制。视频数据包含丰富的视觉、语音和文本等多模态异构信息,尤其是在处理超长视频(如系列讲座、纪录片)时,跨视频语义关联和长时序依赖建模成为两大核心挑战。现有的端到端方法受限于上下文长度或 GPU 显存,难以高效处理长达数小时甚至更长的视频内容;而其他框架通常采用截断或分片处理策略,导致上下文信息割裂,跨视频知识整合困难。此外,如何在大规模视频库中高效检索相关内容仍是亟待解决的难题。

针对上述挑战,我们提出了一种创新的 RAG 框架 ——VideoRAG,旨在实现高效且全面的超长视频理解。在索引阶段,VideoRAG 采用双通道索引架构,通过构建文本知识图谱建模跨视频片段的语义关联与时序依赖,并结合层级化的多模态特征编码,保留细粒度的视频信息;在检索阶段,引入自适应混合检索范式,融合知识图谱与多模态特征嵌入,精准识别与查询最相关的视频内容。在首个超长跨视频理解基准数据集 LongerVideos 上的多维度评估表明,VideoRAG 展现了卓越的长视频理解能力,为复杂视频场景下的知识提取与整合提供了新的解决方案。

VideoRAG 通过多模态知识索引和知识驱动的信息检索,高效地捕捉、组织和检索视频中的视觉、音频和语义信息,支持为无限时长的视频输入生成准确的响应,为理解超长视频提供了全新的解决方案。

与传统文本文档不同,视频通过视觉、音频和文本等多模态传递信息。传统的文本 RAG 方法在视频内容理解上存在显著局限,主要体现在无法直接捕捉视觉动态、难以保持视频帧间的时间依赖性,以及难以处理视觉与文本之间的跨模态交互。VideoRAG 采用双通道架构,高效组织和索引长时间视频内容,同时保留多模态信息的语义丰富性:

我们提出了一个创新的多模态检索方法,结合语义理解和视觉上下文,精准识别与查询相关且信息量丰富的视频片段,生成更准确的回答:

在检索到相关的视频片段后,我们实现了两阶段的内容提取过程。首先,我们通过 LLMs 从查询中提取关键词,然后与采样帧一同作为 VLM 的输入,生成更详细的视觉描述。最终,VideoRAG 利用通用的大语言模型(如 GPT-4 或 DeepSeek )根据查询和检索到的内容生成准确的响应。

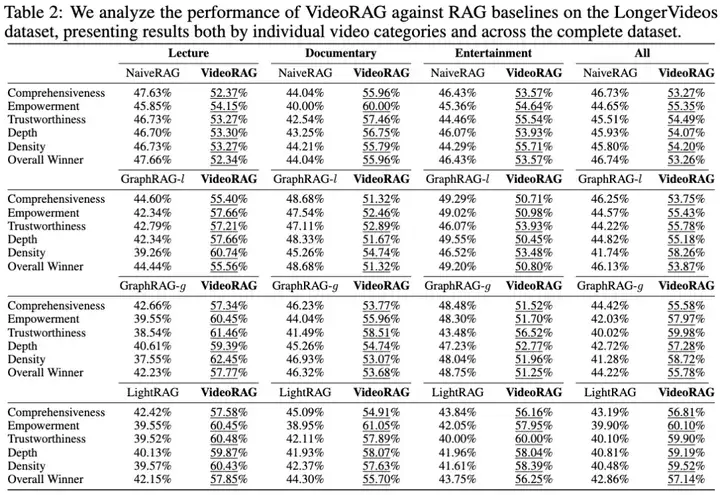

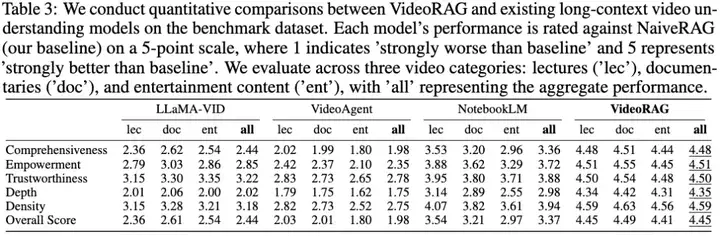

我们在首个超长跨视频理解基准数据集 LongerVideos 上对 VideoRAG 进行了全面的实证评估,涵盖了与现有 RAG 方法(NaiveRAG、GraphRAG、LightRAG)、支持超长视频输入的 LVMs(LLaMA-VID、NotebookLM、VideoAgent)的性能对比,以及模型组件的消融实验(-Graph、-Vision)和具体案例分析。

我们构建了 LongerVideos 数据集,包含 164 个视频(总时长超过 134 小时),涵盖讲座、纪录片和娱乐三大类别,最长视频是完整的《黑悟空》游戏通关攻略视频,长达约 21.36 小时。LongerVideos 支持对跨视频推理能力的评估,打破了当前视频问答基准数据集中普遍存在的单视频时长不足 1 小时和单视频理解场景的限制。

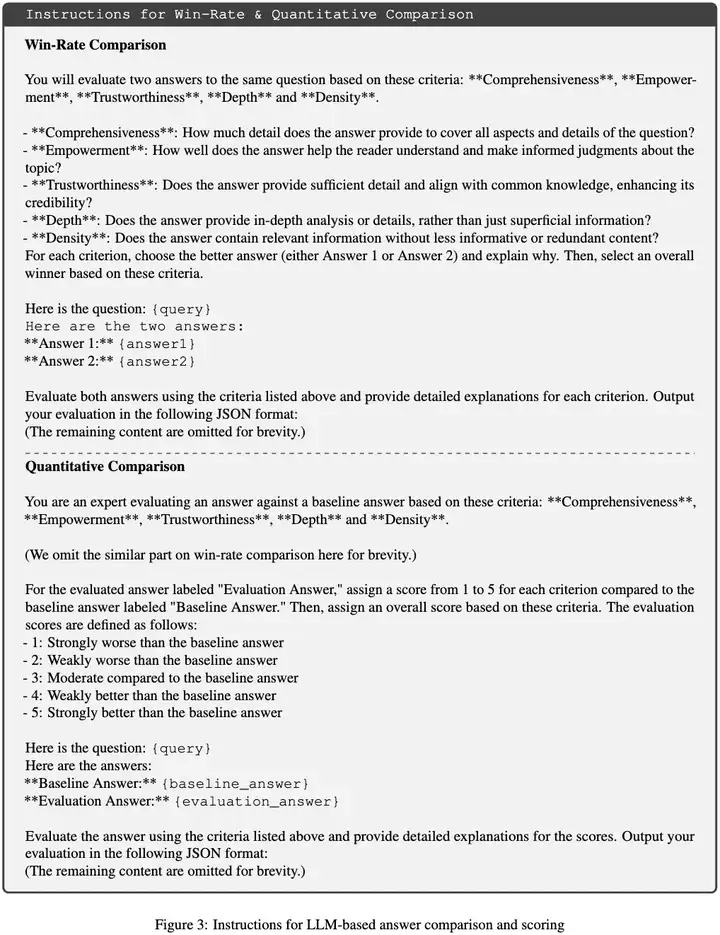

我们采用两种评估协议来衡量模型的性能:

我们从五个维度对模型进行评估:

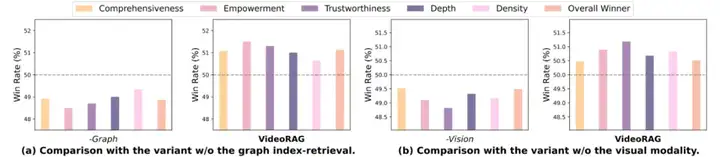

为了评估 VideoRAG 框架中多模态索引和检索设计的有效性,我们进行了两种模型变体的消融实验:变体 1(-Graph):去除了基于图的索引 - 检索管道,限制了模型在跨视频关系建立上的能力;变体 2(-Vision):去除了多模态编码器中的视觉索引和检索组件。实验结果表明:

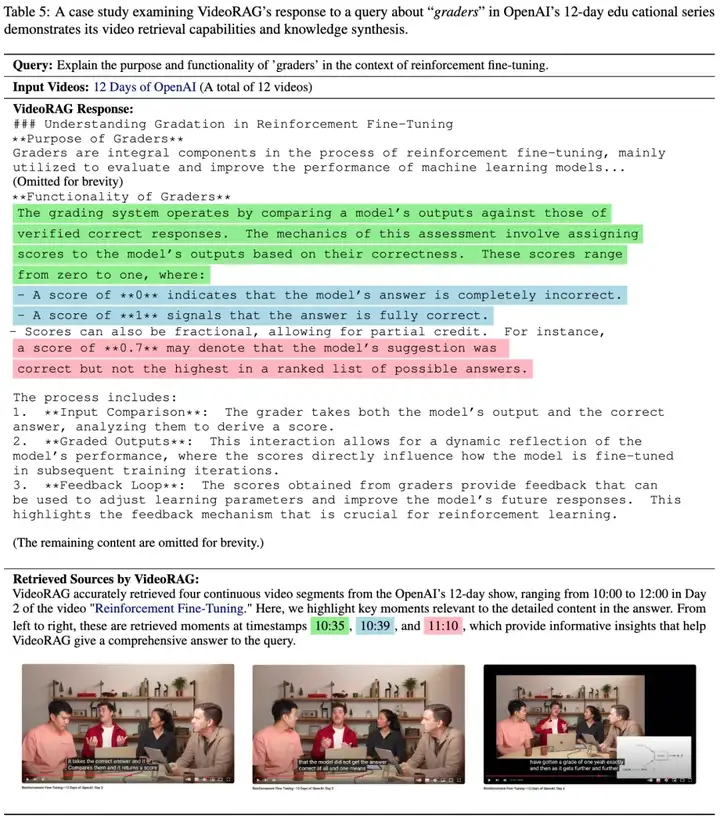

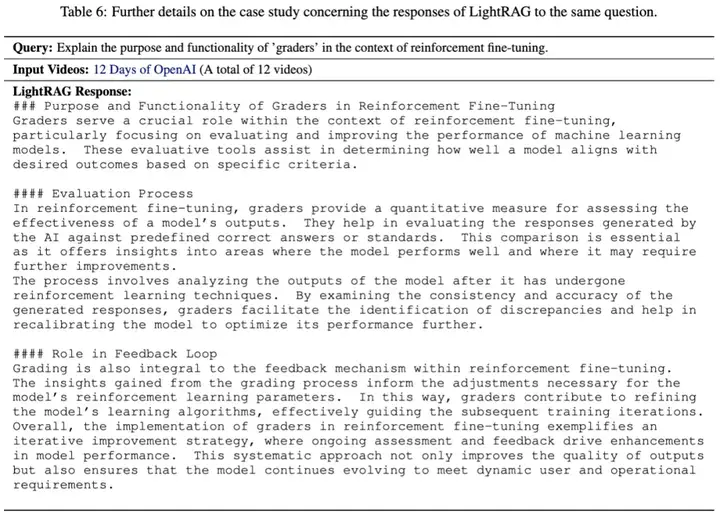

为了全面评估 VideoRAG 的能力,我们对查询 “评分者在强化微调中的作用” 进行案例分析。该查询来自 OpenAI 2024 年发布的 12 天视频系列(时长约 3.43 小时),目标信息位于第 2 天的内容中。

我们展示了 VideoRAG 的响应及对应检索到的视频片段。分析表明,VideoRAG 成功提取了第 2 天的相关内容:评分员的基本概念、评分系统的操作机制、部分打分示例,并利用检索信息构建详细且有据可依的答案。

与 LightRAG 的对比分析显示,VideoRAG 在细节和技术深度上明显优于 LightRAG。虽然两者都描述了评分系统的核心概念,但 LightRAG 在解释 “评分员评分机制” 时缺乏关键技术细节,而 VideoRAG 提供了更全面且精准的技术解释。

该案例研究验证了 VideoRAG 在以下三个方面的有效性:

本文介绍了 VideoRAG,一个针对超长视频理解的框架。通过将基于知识图谱的文本信息和多模态上下文编码无缝集成,VideoRAG 能高效处理、索引和检索长视频中的丰富信息。

在 LongerVideos 基准上的实证评估表明,VideoRAG 在多个维度上超越了现有的 RAG 方法和长视频理解模型,其核心贡献包括:

文章来自微信公众号 “ 机器之心 ”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】Whisper是由openai出品的语音转录大模型,它可以应用在会议记录,视频字幕生成,采访内容整理,语音笔记转文字等各种需要将声音转出文字等场景中。

项目地址:https://github.com/openai/whisper

在线使用:https://huggingface.co/spaces/sanchit-gandhi/whisper-jax

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales