超低成本图像生成预训练方案来了——

仅需8张GPU训练,就能实现近SOTA的高质量图像生成效果。

划重点:开源。

模型名为LightGen,由港科大Harry Yang团队联合Everlyn AI等机构打造,

借助知识蒸馏(KD)和直接偏好优化(DPO)策略,有效压缩了大规模图像生成模型的训练流程。

LightGen不仅显著降低了数据规模与计算资源需求,而且在高质量图像生成任务上展现了与SOTA模型相媲美的性能。

图像inpainting效果belike:

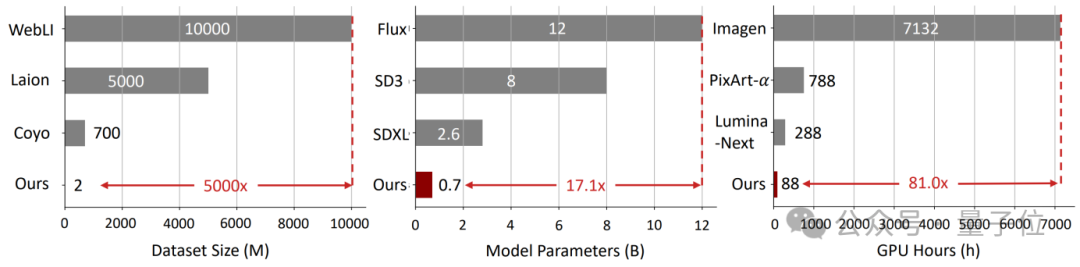

LightGen相较于现有的生成模型,尽管参数量更小、预训练数据规模更精简,却在geneval图像生成任务的基准评测中甚至超出了部分最先进SOTA模型。

此外,LightGen在效率与性能之间实现了良好的平衡,

成功地将传统上需要数千GPU days的预训练过程缩短至仅88个GPU days,即可完成高质量图像生成模型的训练。

以下是更多细节。

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,

其中以扩散模型(如Stable Diffusion、DiT等)和自回归(AR)模型为代表的方法取得了显著成果。

然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

为了解决这一难题,香港科技大学Harry Yang教授团队联合Everlyn AI和UCF,提出了LightGen这一新型高效图像生成模型,致力于在有限的数据和计算资源下,

快速实现高质量图像的生成,推动自回归模型在视觉生成领域更高效、更务实地发展与应用。

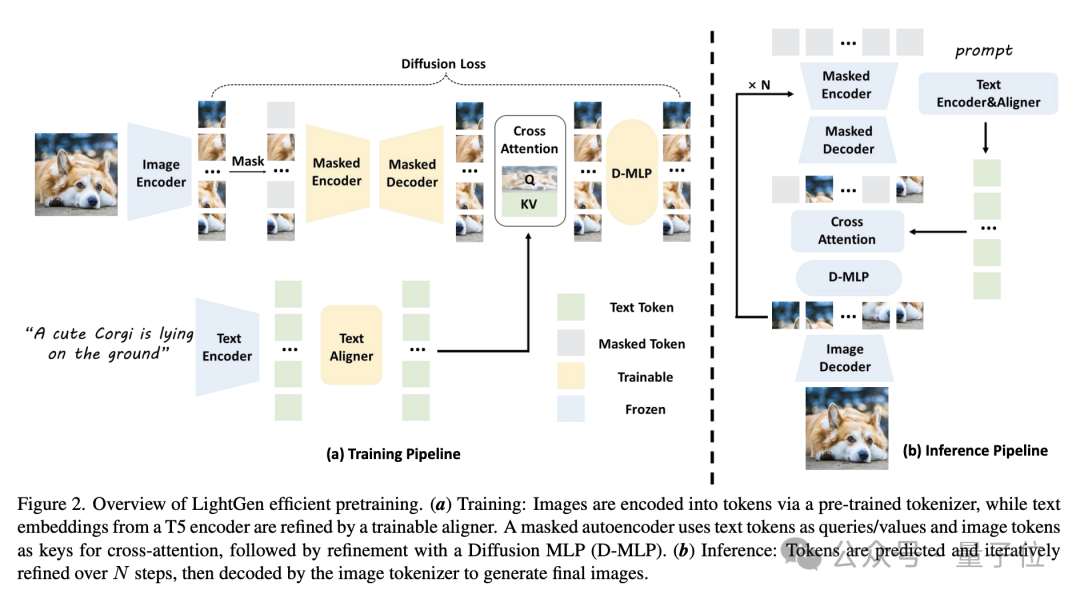

LightGen采用的训练流程主要包括以下关键步骤:

一、数据KD

利用当前SOTA的T2I模型,生成包含丰富语义的高质量合成图像数据集。

这一数据集的图像具有较高的视觉多样性,同时包含由最先进的大型多模态语言模型(如GPT-4o)生成的丰富多样的文本标注,

从而确保训练数据在文本和图像两个维度上的多样性。

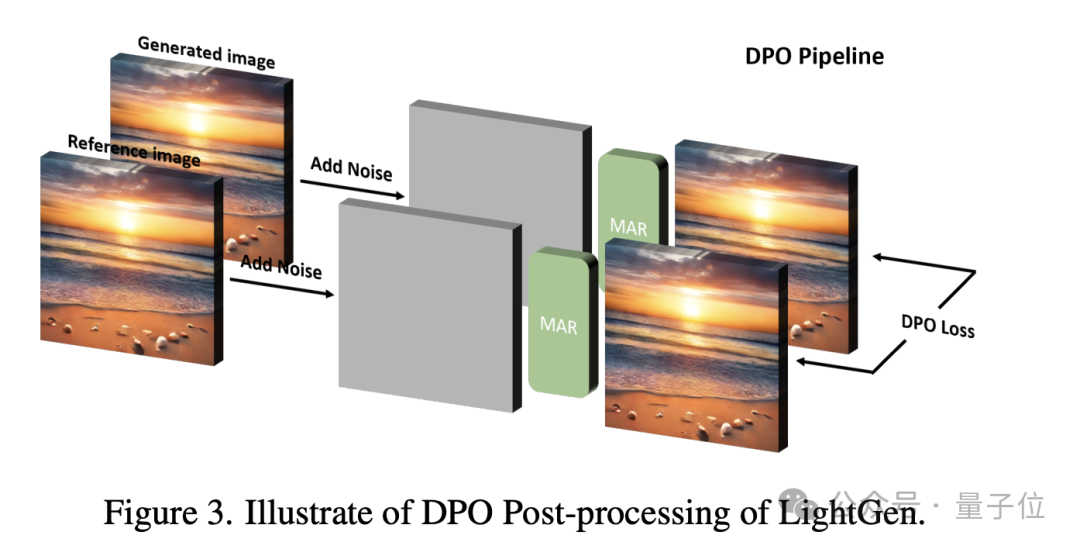

二、DPO后处理

由于合成数据在高频细节和空间位置捕获上的不足,作者引入了直接偏好优化技术作为后处理手段,

通过微调模型参数优化生成图像与参考图像之间的差异,有效提升图像细节和空间关系的准确性,增强了生成图像的质量与鲁棒性。

通过以上方法,LightGen显著降低了图像生成模型的训练成本与计算需求,展现了在资源受限环境下获取高效、高质量图像生成模型的潜力。

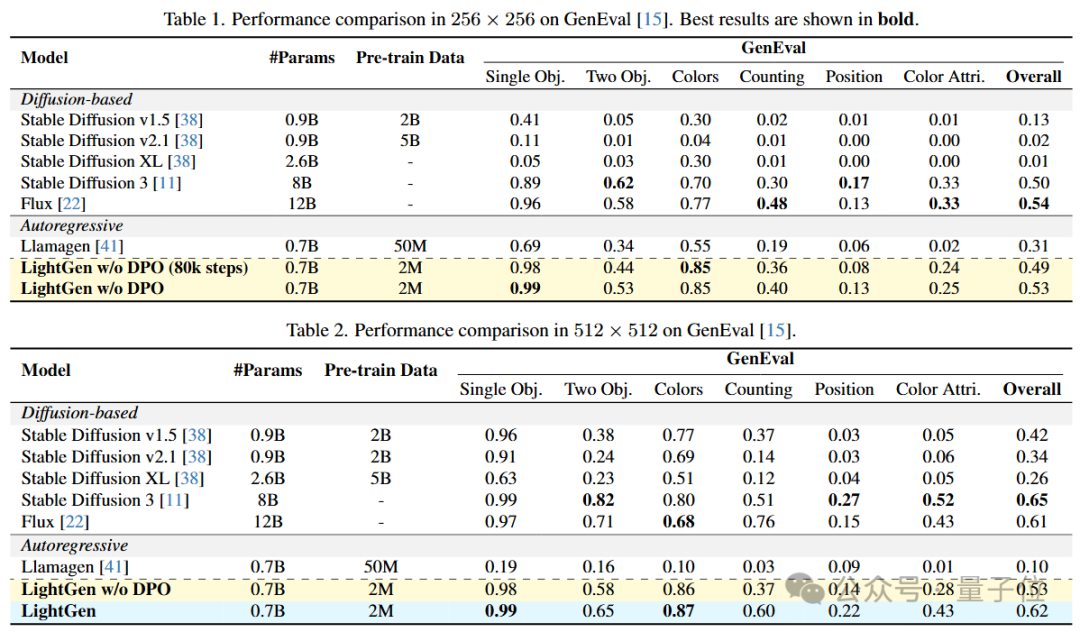

作者通过实验对比了LightGen与现有的多种SOTA的T2I生成模型,使用GenEval作为benchmark来验证LightGen模型和其它开源模型的性能。

结果表明,LightGen模型在模型参数和训练数量都小于其它模型的的前提下,

在256×256和512×512分辨率下的图像生成任务中的表现均接近或超过现有的SOTA模型。

LightGen在单物体、双物体以及颜色合成任务上明显优于扩散模型和自回归模型,

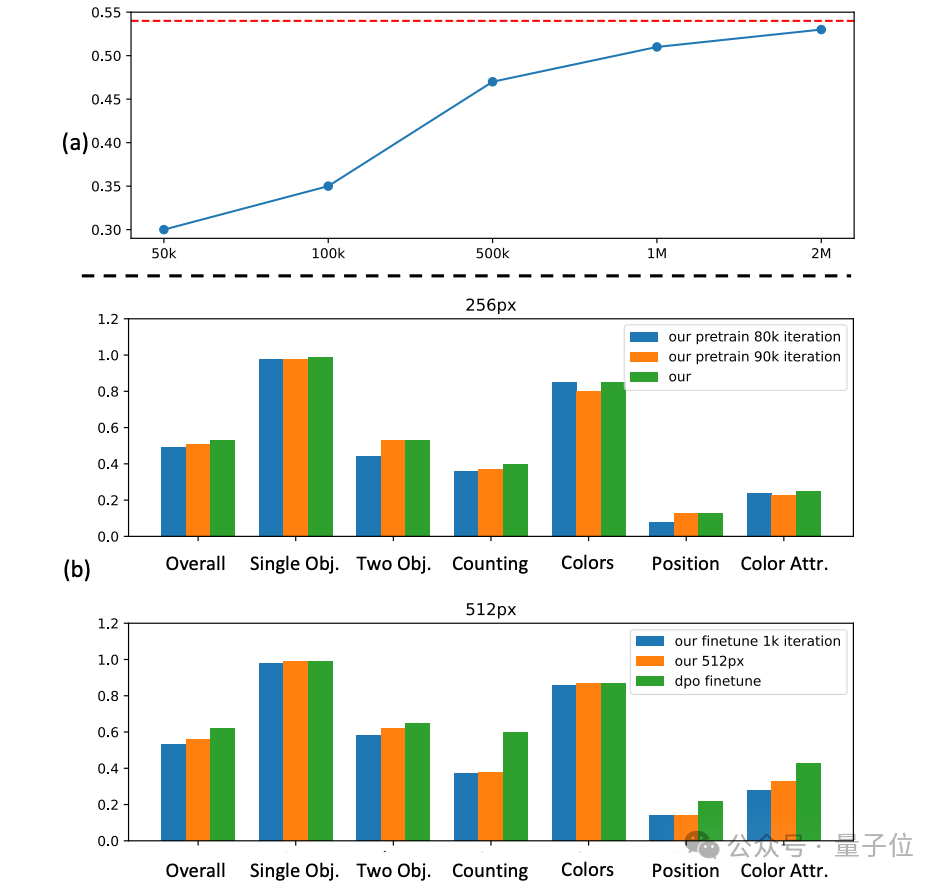

在不使用DPO方法的情况下,分别达到0.49(80k步训练)和0.53的整体性能分数。

在更高的512×512分辨率上,LightGen达到了可比肩当前SOTA模型的成绩,整体性能分数达到0.62,几乎超过所有现有方法。

特别地,加入DPO方法后,模型在位置准确性和高频细节方面的表现始终稳定提升,这体现了DPO在解决合成数据缺陷上的有效性。

除此之外,消融实验结果显示,当数据规模达到约100万张图像时,性能提升会遇到瓶颈,进一步增加数据规模带来的收益很有限。

因此,作者最终选择了200万张图像作为最优的预训练数据规模。

上图(b)探讨了不同训练迭代次数对GenEval在256与512分辨率下性能的影响。

值得注意的是,在256像素阶段,仅经过80k训练步数便能达到相当不错的性能,这突显了数据蒸馏方法在训练效率上的优势。

团队表示,未来研究可进一步探索该方法在其他生成任务(如视频生成)上的应用,推动高效、低资源需求的生成模型进一步发展。

论文链接:https://arxiv.org/abs/2503.08619

模型链接:https://huggingface.co/Beckham808/LightGen

项目链接:https://github.com/XianfengWu01/LightGen

文章来自于微信公众号 “量子位”,作者 :Everlyn

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner