Runway带着新一代视频生成模型Gen-4杀回来了!

功能强大到只要几张参考图和简单提示词,就可以生成电影级别的大片。

性能上则是主打世界一致性、高动态高保真和可控性,自称是新的SOTA模型。

比如在这段半分钟的视频里,女主先后进行了开车等一系列动作,出现了不同的视角,但角色形象始终都保持一致。

并且在物理规律理解上也表现出色,用Runway自己的话说是“理解物理世界的重要里程碑”。

不管是固液表面还是柔性物体,以及光学中的透射反射,Gen-4都能真实还原。

当然Runway的野心不止于此,在他们看来,Gen-4专为讲故事而设计,并指出“会讲故事”才是AI的新基准。

并且还放出了几个纯Gen4制作的微电影,每个时长都超过了100秒。

比如这段《The Lonely Little Flame》,讲述了主角渴望寻找朋友并最终得偿所愿的故事,整段视频从头到尾都是用Gen-4完成。

有网友评论说,之前自己并不看好Runway,但是现在Gen-4让他刮目相看,直接把牌桌掀翻了。

据Runway介绍,此次Gen-4主要有这样几个亮点:

Runway发布的宣传片中,演示了用两张照片生成影像级视频的整个过程。

创始人兼CEO Cristóbal Valenzuela拍摄了手中的玩具,然后上传了一张之前拍摄的街景图片,通过简单的指令就将玩具融入到了街景当中。

接着,Cristóbal利用得到的照片,生成了人们从玩具旁边走过的视频。

更精彩的在后面,随着玩具上的红色小球滚落,画面变成了雪地、沙漠等各种不同场景。

这就是Gen-4此次引入的生成式视觉特效(GVFX)技术。

结合这次Gen-4主推的一致性、高保真等特性,可以从头到尾只用Gen-4就能完成故事影片的制作。

包括开头展示的微电影“小火苗”在内,Runway这波一口气展示了五段作品。

《The Herd》讲述了一个讲述了一个年轻人在夜间被牛群追赶的故事。

关键在于,其画面仅通过简单的参考图和提示词就能得到,然后通过Act-One技术,这些镜头被串联成了完整故事。

《NYC is a Zoo》则将纽约变成了一个大型动物园,看上去十分有趣。

Runway介绍,影片中的每个场景都是通过Gen-4的Reference功能,将动物的真实照片与纽约街景照片相结合,然后用提示词描述每个场景的具体动作而创建的。

同样是动物题材的还有这段音乐舞蹈《Scimmia Vede》,不过跳舞的演员可不是人,而是一只猴子。

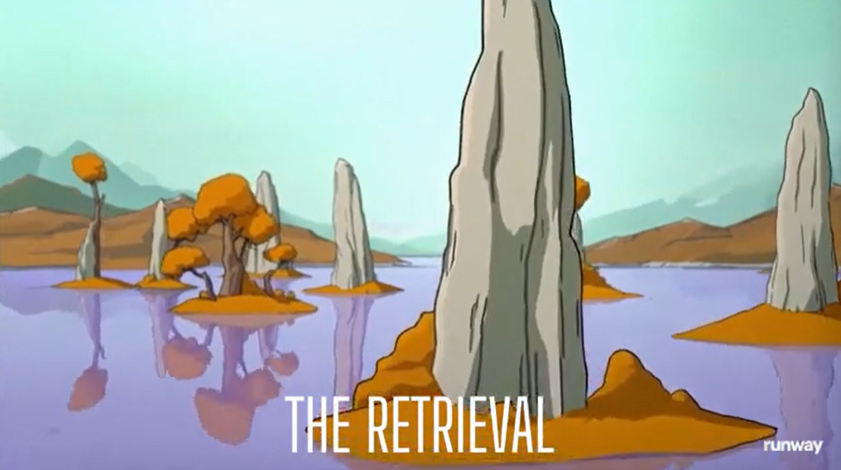

从画风上看,动漫风格也能轻松驾驭,并且比实景风格看上去更加没有AI感。

下面这段《The Retrieval》,就讲述了几位主角不断探险,寻找神秘之花的整个过程。

总之,Runway表示,Gen-4将成为一种故事创作的全新方式。

目前,Gen-4的图生视频功能已向付费用户和企业用户开放,制作短片时用到的Reference功能也即将上线。

BTW,创作者们已经在期待Reference的正式上线了。

参考链接:

[1]https://runwayml.com/research/introducing-runway-gen-4

[2]https://runwayml.com/gen-4-bts

[3]https://x.com/runwayml/status/1906718935778545964

文章来自于“量子位”,作者“克雷西”。