用文字合成3D图形的AI模型,又有了新的SOTA!

近日,清华大学刘永进教授课题组提出了一种基于扩散模型的文生3D新方式。

无论是不同视角间的一致性,还是与提示词的匹配度,都比此前大幅提升。

文生3D是3D AIGC的热点研究内容,得到了学术界和工业界的广泛关注。

刘永进教授课题组此次提出的新模型叫做TICD(Text-Image Conditioned Diffusion),在T3Bench数据集上达到了SOTA水平。

目前相关论文已经发布,代码也即将开源。

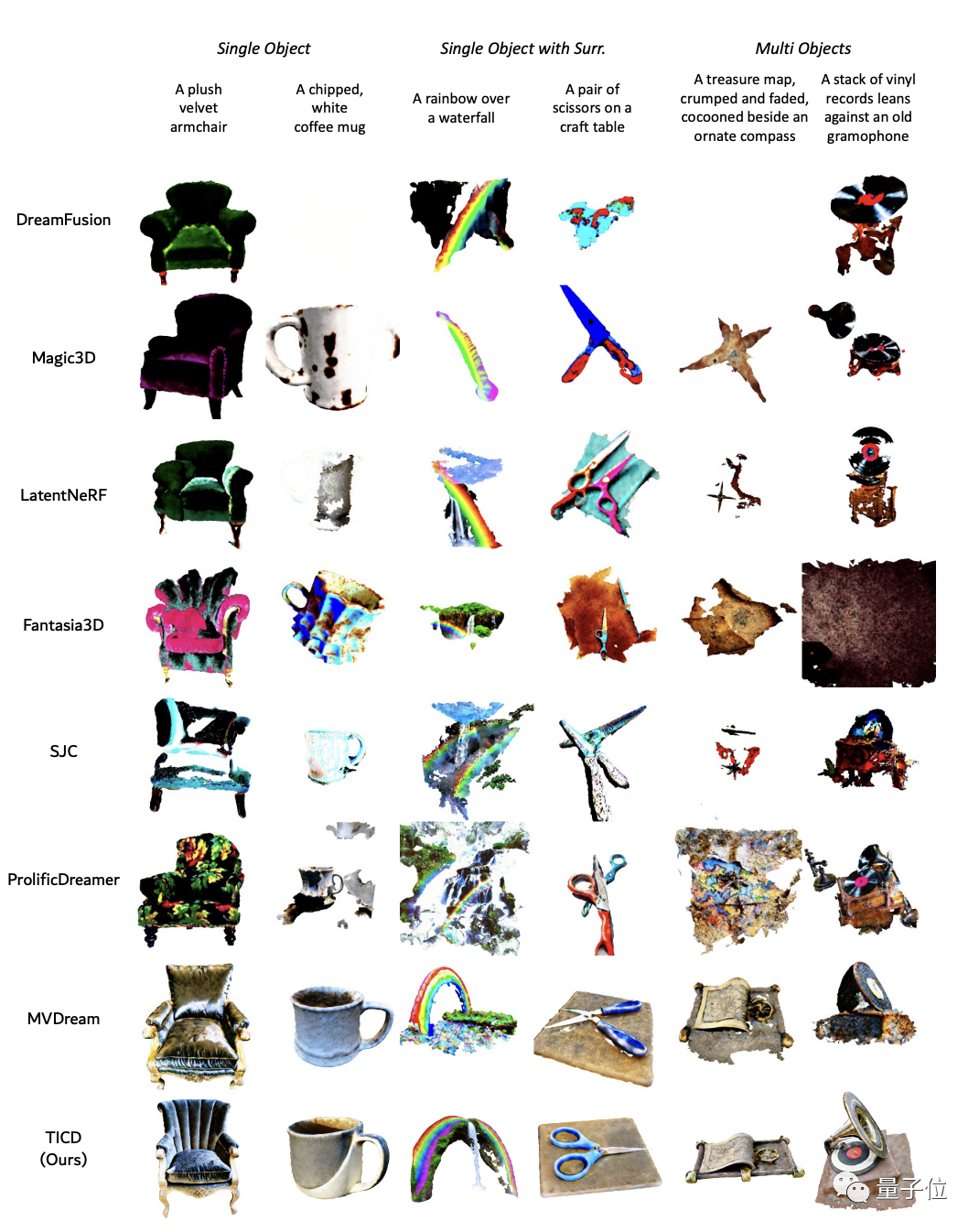

为了评估TICD方法的效果,研究团队首先进行了定性实验,并对比了此前一些较好的方法。

结果显示,用TICD方法生成的3D图形质量更好、图形更清晰,与提示词的匹配程度也更高。

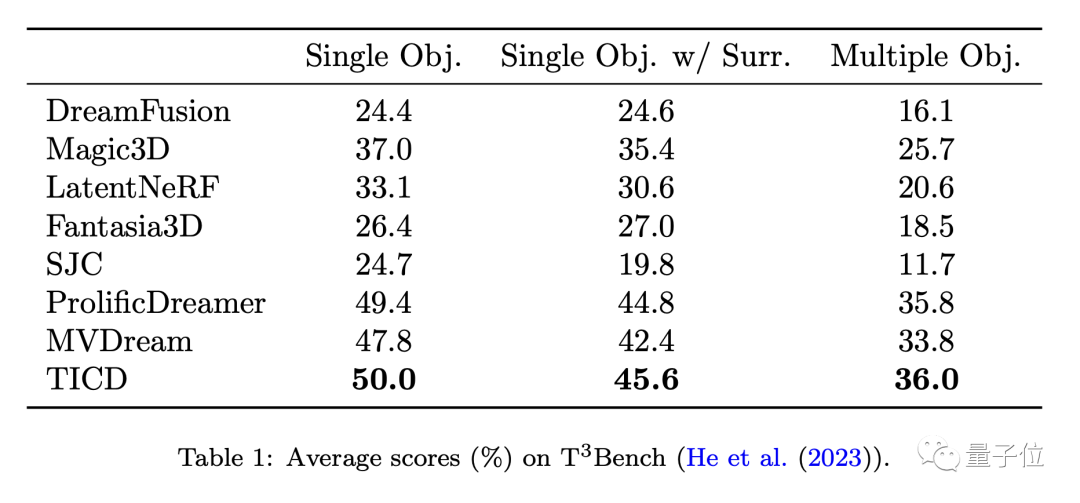

为了进一步评估这些模型的表现,团队在T3Bench数据集上将TICD与这些方法进行了定量测试。

结果显示,TICD在单对象、单对象带背景、多对象这三个提示集上都取得了最好的成绩,证明了它在生成质量和文本对齐性上都具有整体优势。

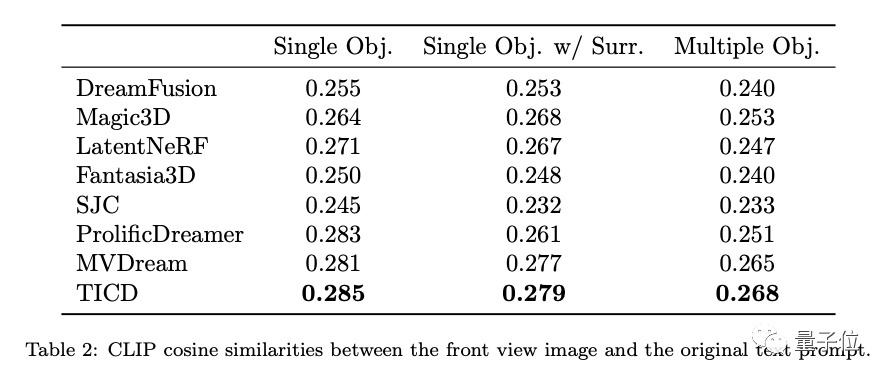

此外,为了进一步评估这些模型的文本对齐性,研究团队还对3D物体渲染得到的图片与原始提示词的CLIP余弦相似度上进行了测试,结果依然是TICD的表现最佳。

那么,TICD方法是如何实现这样的效果的呢?

目前主流的文本生成3D方法大多使用预训练的2D扩散模型,通过得分蒸馏采样(Score Distillation Sampling, SDS)优化神经辐射场(NeRF)来生成全新的3D模型。

然而,这种预训练扩散模型提供的监督仅限于输入的文本本身,并未约束多视角间的一致性,可能会出现生成几何结构较差等问题。

为了在扩散模型的先验中引入多视角一致性,一些最新的研究通过使用多视角数据对2D扩散模型进行微调,但仍然缺乏细粒度的视角间连续性。

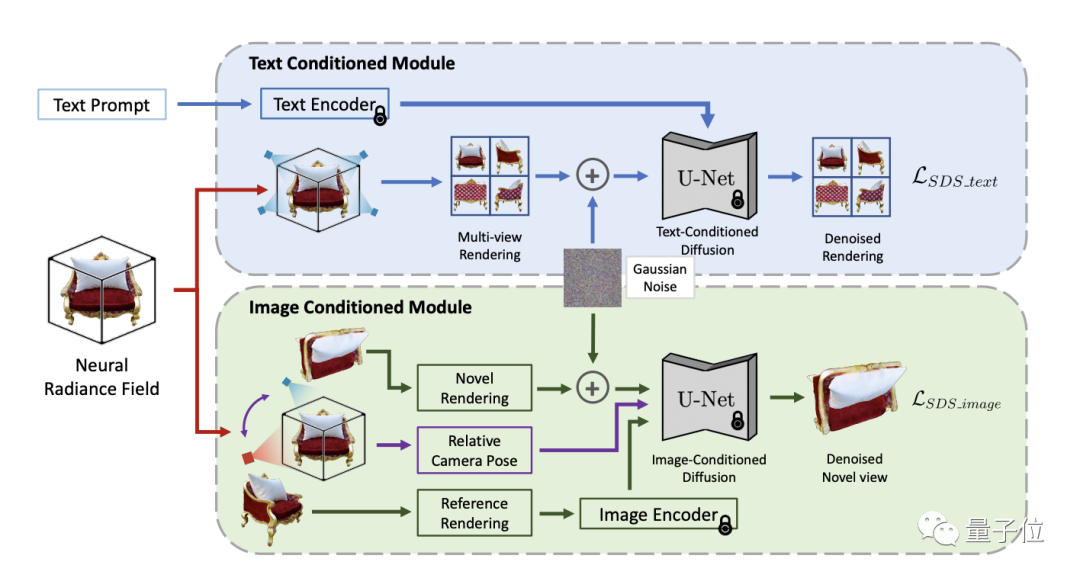

为了解决这一挑战,TICD方法将以文本为条件的和图像为条件的多视角图像纳入NeRF优化的监督信号中,分别保证了3D信息与提示词的对齐和3D物体不同视角间的强一致性,有效提升了生成3D模型的质量。

工作流程上,TICD首先采样若干组正交的参考相机视角,使用NeRF渲染出对应的参考视图,然后对这些参考视图运用基于文本的条件扩散模型,约束内容与文本的整体一致性。

在此基础上选取若干组参考相机视角,并对于每个视角渲染一个额外新视角下的视图。接着以这两个视图与视角间的位姿关系作为新条件,使用基于图像的条件扩散模型约束不同视角间的细节一致性。

结合两种扩散模型的监督信号,TICD可对NeRF网络的参数进行更新并循环迭代优化,直到获得最终的NeRF模型,并渲染出高质量、几何清晰且与文本一致的3D内容。

此外,TICD方法可以有效消除现有方法面对特定文本输入时可能产生的几何信息消失、错误几何信息过量生成、颜色混淆等问题。

论文地址:

https://arxiv.org/abs/2312.11774

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0