搞RAG开发,一个被普遍忽视却又至关重要的痛点是:如何避免Token分块带来的语义割裂问题。SAT模型通过神经网络驱动的智能分段技术,巧妙解决了这一难题。它不是RAG的替代,而是RAG的强力前置增强层,通过确保每个文本块的语义完整性,显著降低下游生成的幻觉风险。正如ContextGem文章中所提及的,高质量的输入是避免"垃圾进,垃圾出"的关键第一步。本文将深入剖析SAT如何重构文本分段技术,为您的Agent产品构建更可靠的文档理解基础。

🤗Model地址:huggingface.co/segment-any-text

论文地址:https://arxiv.org/abs/2406.16678

在修猫上一篇介绍的《精准提取数据太折磨人,试下pip install -U contextgem》文章中,我们探讨了ContextGem这一强大的结构化数据提取框架,其核心技术支柱之一便是今天要深入剖析的SAT模型。作为ContextGem的"第一道防线",SAT不仅解决了"垃圾进,垃圾出"的根本问题,更为整个提取流程提供了坚实的语义基础。

正如昨天所提到的,SAT以其强大的神经网络能力,彻底改变了文档分析的基础工作。今天,我们将揭开SAT模型的技术面纱,来看看它是如何实现的,以及它可能对RAG和Agent开发带来的改进。

如果您还没有阅读昨天的文章,强烈建议先了解ContextGem的整体架构,再深入探索SAT这一核心引擎的工作原理。这是一个把SAT用于实践的经典框架,作者富有深刻的科学哲学洞察力,和“道与术”流派空谈不同,升华了这项研究,定义了这个框架,同时又超越了它。

当您忙于优化大语言模型和精细调整提示工程时,文本分段这个看似简单的预处理步骤很可能成为限制Agent产品性能的隐形天花板。

特别是在构建依赖精确文档理解的Agent产品时,传统基于规则或简单统计的分段方法往往成为制约产品竞争力的关键瓶颈,而这一瓶颈恰恰被许多开发者所忽视。

在深入了解SAT模型之前,我们需要厘清一个常见的误解:SAT与RAG(检索增强生成)之间的关系和区别。

可以这么理解:SAT并非RAG的替代品,而是RAG系统的强大赋能工具和前置增强层。

在现代RAG架构中,SAT可以作为分块前处理器,为检索引擎提供更高质量的文本单元,从根本上提升检索质量。SAT的贡献在于它解决了"垃圾进垃圾出"的问题——无论您的嵌入模型、向量数据库和检索算法多么先进,如果输入的文本块本身就是语义破碎的,不可逆的误差累计导致最终检索和生成的质量必然受限。这个问题也是很多RAG生成幻觉的重要且隐蔽的原因之一。

通过SAT智能分段,RAG系统获得了更优质的语义单元,能够:

SAT(Segment Any Text)模型突破性地将文本分段从简单的规则匹配提升到语义理解的高度,成为一种全新解决方案。

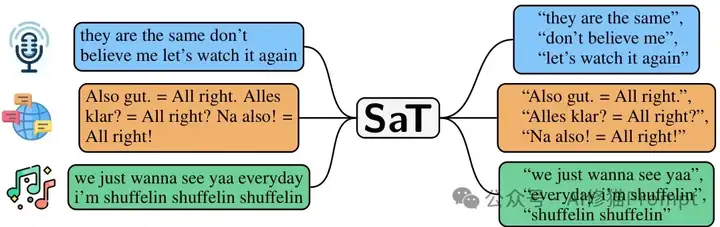

SAT分段示例

SAT模型在不同类型文本上的分段示例:(i)无标点ASR输出,(ii)多语言文本,(iii)歌词分段。SAT能够适应各种文本类型,不依赖标点符号或语言代码。

SAT模型的技术核心在于其创新的神经网络架构和训练方法,远超传统NLP工具的能力边界。

这种深度学习方法使SAT在语义理解层面超越了规则方法的局限,能够捕捉复杂的上下文依赖关系和跨语言通用特征。

SAT的多语言能力是其最显著的技术优势之一,为全球化Agent产品提供了坚实基础。

这种多语言适应性使SAT能在任何语言环境下为Agent提供一致的文档理解能力,无需为每种语言定制分段规则。

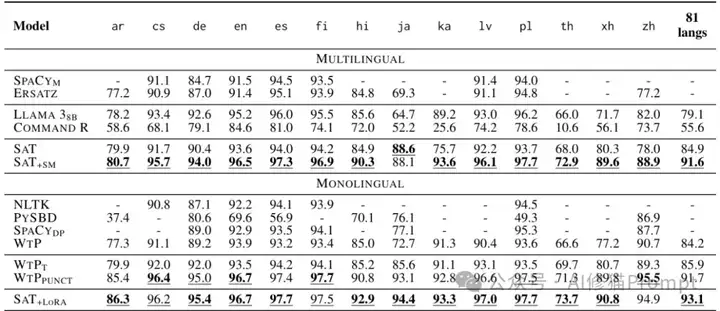

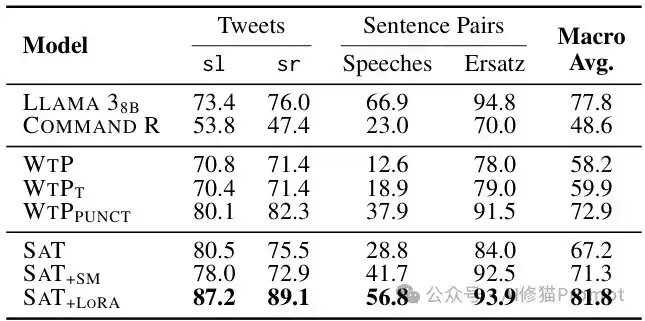

多语言性能对比

SAT在多语言文本分段上的性能对比。SAT+SM(监督混合)在14种代表性语言和81种语言平均性能上均优于传统方法和大型语言模型。

SAT模型设计了三种强大的适应机制,使其能够处理各种特殊文本类型和领域文档。

这三种适应机制使SAT成为真正通用的文本分段解决方案,能够满足不同Agent产品的多样化需求。

与传统分段方法相比,SAT模型在各种测试数据集上展现出压倒性优势。

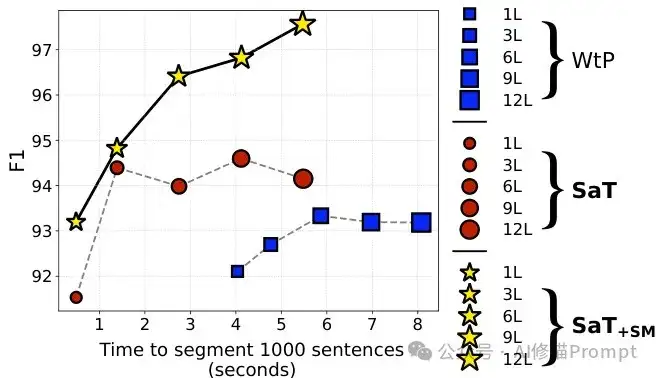

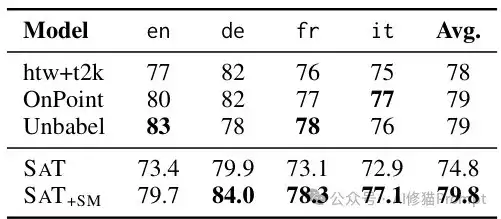

=SAT模型性能对比

SAT模型与WTP(先前最先进模型)的F1得分和推理时间对比。实验结果显示,不同层数的SAT模型均优于WTP,特别是在效率方面,3层SAT模型处理1000个句子仅需约0.5秒,比WTP快约3倍。

短文本和代码混合性能

SAT在短文本和代码混合文本上的性能,展示了SAT在处理特殊文本类型时的优势,特别是在多语言混合场景中。

在实际Agent产品开发中,SAT可以作为文档理解层的核心组件,与大语言模型和知识库无缝集成。

SAT可以与其他文档处理技术协同工作:

这种集成方式使Agent产品能够处理更复杂的文档理解任务,扩展应用场景范围。

领域适应性能

图5SAT在特定领域(ASR转录文本)的性能表现,与专门针对该任务优化的系统相比,SAT+SM仍然表现优秀。

将SAT模型整合到您的Agent产品中非常直接,可以通过开源框架如ContextGem或直接使用Hugging Face模型。

1.通过ContextGem安装SAT:

pip install -U contextgem

2.自动下载并加载SAT模型(约1GB大小),无需额外配置

3.将SAT作为文档输入的第一道处理环节,为后续任务提供结构化文本

整合SAT通常能立即提升Agent的文档理解能力,无需改变现有提示或推理逻辑。

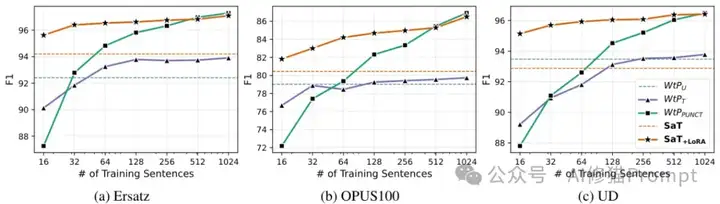

少样本适应性能

SAT的少样本适应能力展示。你敢想象吗?只需16个样本,SAT+LoRA就能有效适应新领域,比传统方法效率高得多。具体请您仔细阅读论文。

SAT模型代表了文本处理技术从简单规则向语义理解的质的飞跃。

在Agent产品开发中,文档理解能力直接决定了产品的竞争力和应用边界,而SAT作为文档理解的基石,为构建真正智能的Agent提供了坚实基础。

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】Whisper是由openai出品的语音转录大模型,它可以应用在会议记录,视频字幕生成,采访内容整理,语音笔记转文字等各种需要将声音转出文字等场景中。

项目地址:https://github.com/openai/whisper

在线使用:https://huggingface.co/spaces/sanchit-gandhi/whisper-jax

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales