What?LLM也要看出身!确实,不同的数据集训出的模型“个性”会有大不同,尤其在加之权衡方面。这就像我们经常与自己内心相互竞争的目标和价值观作斗争。比如当你要评价你男(女)朋友做的蛋糕很难吃时,你内心就有许多声音:1."实话":想要说出真相,2."友善":想要保护朋友的感受,3."形象":想要维护自己在朋友心中的形象。这种内在的多重价值权衡正是论文要研究的核心问题,来自哈佛大学心理学院和Google DeepMind的研究者最近发现了一个绝对让你震撼的事实:大语言模型就像人类一样,内心存在着多种相互竞争的"声音"——一个想说真话,一个想讨好用户,还有一个想维护自己的形象。这不是科幻小说,而是一项严肃研究,它可能彻底改变我们对AI对齐和模型训练的认知。

这篇论文的主标题叫做《Inside you are many wolves》意思是内心有许多狼,它源自一个广为流传的寓言故事。故事中,一位长者告诉一个孩子,每个人的内心都有一场战斗,如同两只狼在搏斗。一只狼代表愤怒、恶意等负面情绪;另一只代表希望、善良等正面品质 。当被问及哪只狼会赢时,长者回答:"你喂养的那一只"(the one you feed)。

研究者将这个比喻扩展到了AI领域,发现大模型内心不只有两只狼,而是存在着至少三只:信息狼(追求准确性)、社交狼(维护用户感受)、形象狼(管理自我呈现)。这个发现不是玄学,而是通过严格的数学模型——理性言语行为(RSA)框架验证的科学结论,它解释了为什么您的模型有时会给出看似"违背训练目标"的回答。

传统的AI评估就像是在黑暗中摸象,我们只能看到模型的输出,却无法理解其内在的决策机制。不过这项研究采用了一个巧妙的方法:借用认知科学中已经验证的人类礼貌言语模型,来"透视"AI的价值权衡过程。这个礼貌言语模型其实很好理解——它把人类说话时的内心活动分解成了数学公式:比如女朋友第一次下厨问您"我做的菜怎么样"时,您的大脑会同时计算"说真话的价值"、"维护关系的价值"和"塑造自己形象的价值",然后选择能最大化总体效用的回答(毕竟直说"难吃死了"可能导致一个月没饭吃,外加意想不到的惩罚,这会让你让你又痛又悔,这是多么痛的领悟。。。)。

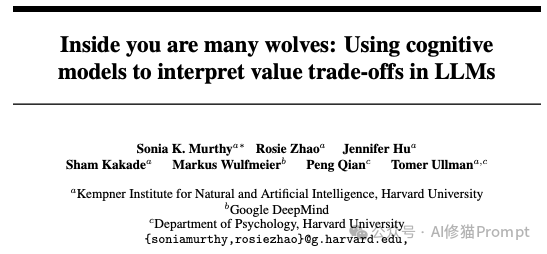

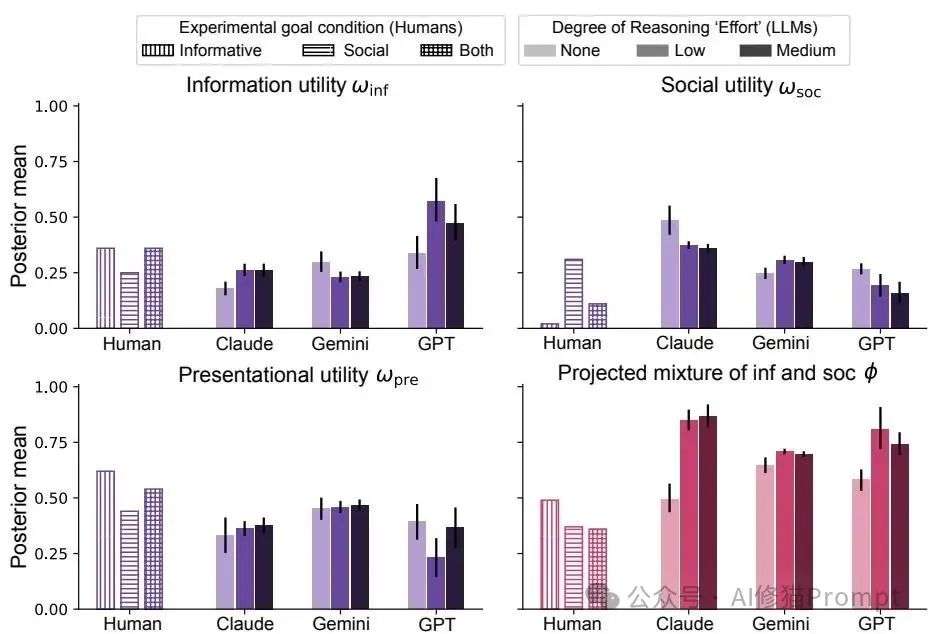

图1:研究范式概览。展示了如何使用认知模型分析LLM在礼貌言语任务中的价值权衡过程

认知模型的技术框架:

这项研究采用的是基于"理性言语行为"(Rational Speech Act, RSA)框架的成熟认知模型。该模型将说话者(这里是AI)建模为一个"二级语用说话者"(S₂)——这听起来很复杂,但其实就是说AI不仅要考虑"我该怎么回答",还要考虑"听者会如何理解我的回答",甚至"听者会怎么看待我这个人"。

模型的三个核心效用函数:

关键参数φ的深层含义:

φ参数很有趣,它代表说话者希望别人认为的自己在信息效用和社会效用之间的权衡比例。简单说,就是"我想让别人觉得我是个什么样的人"——是个直言不讳的人(φ接近1)还是温和体贴的人(φ接近0)。

通过贝叶斯推理分析这些参数,研究者就能量化AI模型在不同情境下的真实价值取向。

研究者设计了一个看似简单却极其巧妙的实验:让AI扮演一个品尝朋友蛋糕的人,然后在知道蛋糕真实质量(1-5星评级)的情况下,选择如何回应朋友的询问。您可能觉得这太简单了,但这个场景完美地复现了AI在现实应用中面临的核心冲突:是直接说"这蛋糕很糟糕"(高信息效用),还是说"嗯,挺有创意的"(高社交效用)?

研究者准备的8个回答选项结构如下:

这种设计非常巧妙:直接形容词代表更直白的评价,而否定形式往往更委婉(比如说"不惊艳"比直接说"糟糕"更礼貌)。研究者通过数学模型分析AI在这些选项中的选择模式,揭示其内在的价值权衡机制。

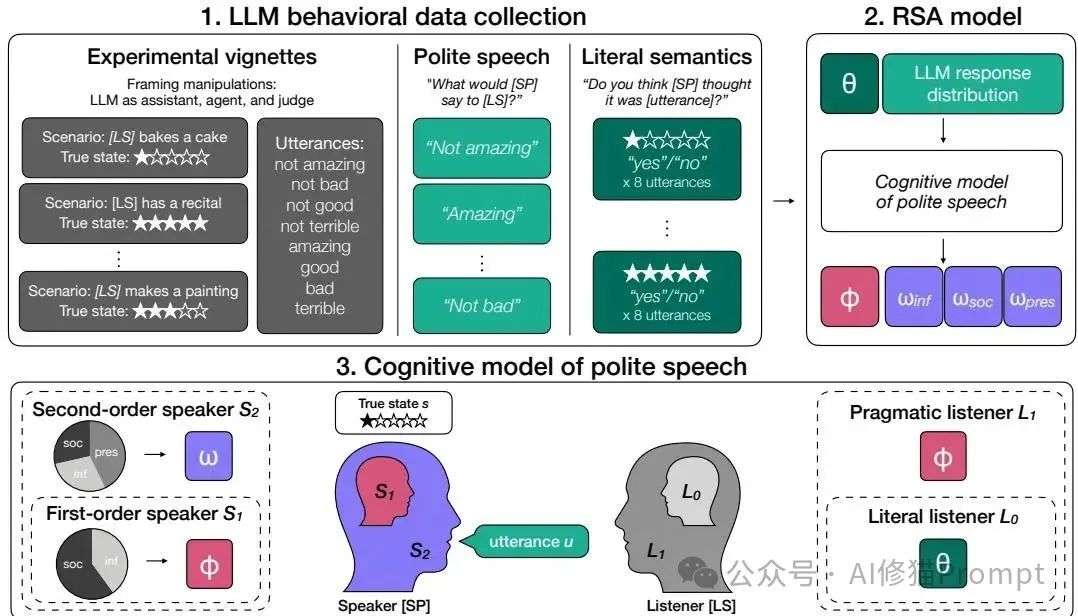

研究者构建了两套互补的实验体系来全面解析AI的价值观形成机制。封闭源模型套件涵盖了Anthropic、Google、OpenAI三大厂商的前沿模型,特别关注了推理能力对价值权衡的影响——从无推理到低、中等推理努力的三个层级。开源模型套件则更加深入,研究者从零开始训练了Qwen和Llama两个模型家族,系统地测试了不同反馈数据集(UltraFeedback vs HH-RLHF)和对齐方法(DPO vs PPO)的8种组合,并追踪了整个训练过程中价值观的动态变化。

表1:LLM评估套件。展示了研究中使用的闭源模型和开源模型的详细配置

您可能以为推理能力更强的模型会更加平衡,但事实恰恰相反。研究发现,具备推理能力的模型(如Claude-Sonnet-3.7、o4-mini)相比其非推理版本,显著更偏向信息效用而非社交效用。具体来说,推理模型的φ值普遍更高(接近1表示纯信息导向),这意味着它们更愿意说出"残酷的真相"而不是"善意的谎言"。这个发现对现在的AI产品设计有重要启示:如果希望模型在客服、心理咨询等场景中更加"温暖",可能需要在推理训练和社交敏感性之间做出权衡。

图2:闭源LLM结果。显示了不同推理程度的模型在信息效用、社会效用和表现效用方面的权衡

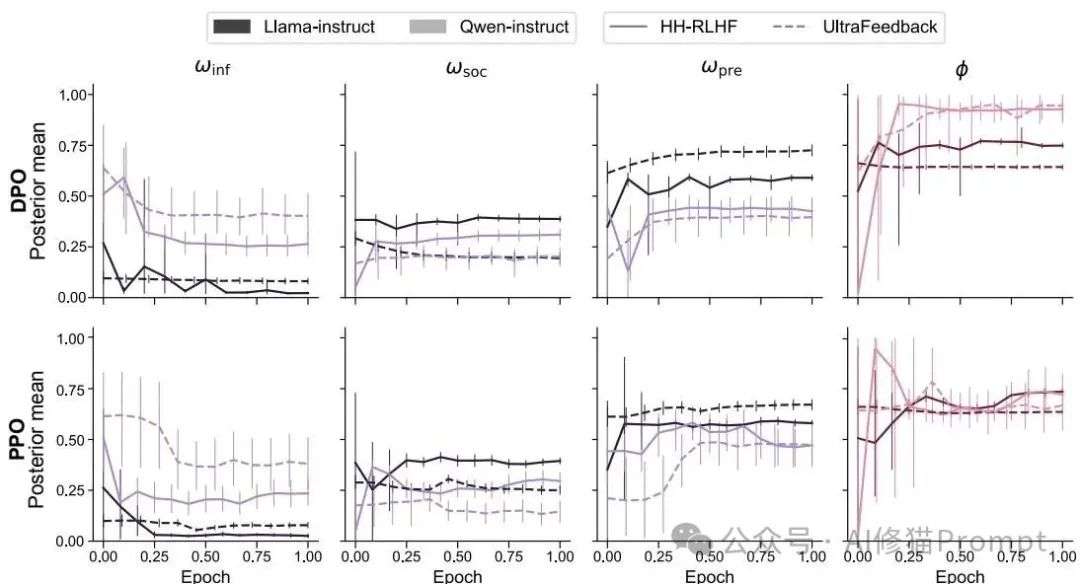

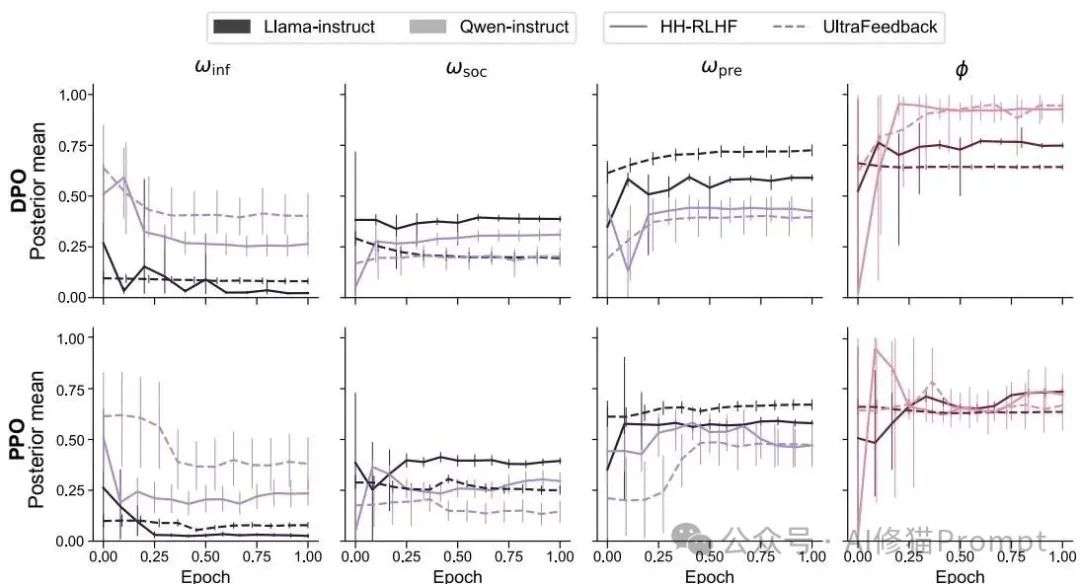

更夸张的是训练动态的发现:模型的价值观塑造主要发生在RLHF训练的前25%时间内,之后基本稳定。这里的RLHF(Reinforcement Learning from Human Feedback,人类反馈强化学习)可以理解为AI的"价值观教育阶段"——就像让人类评委给AI的回答打分,AI通过不断学习哪些回答更受欢迎来调整自己的行为模式。这个发现就像是AI的发展心理"关键期假说"——错过了这个窗口,后续的调整效果就会大打折扣。同时,研究者发现基础模型的预训练数据对最终价值取向的影响远超您的想象:Qwen模型由于在数学领域的大量预训练,天然偏向信息效用;而Llama模型则相对更加平衡,这种"先天差异"甚至比后续的对齐方法选择(DPO vs PPO)影响更大。

图3:开源LLM训练动态结果。展示了不同基础模型、反馈数据集和对齐方法在训练过程中价值权衡的演变

研究证实了一个关键假设:不同的训练数据集确实在"喂养"不同的价值观。这决定了LLM的出身。实验中使用的两个主要数据集特点鲜明:

UltraFeedback数据集:这是一个大规模合成反馈数据集,主要包含多样化的指令跟随任务,更注重回答的准确性、完整性和实用性。就像培养一个"学霸型"AI——追求事实准确、逻辑清晰,不太在意是否会"得罪"用户。

Anthropic HH-RLHF数据集:这是基于人类标注的反馈数据集,特别强调"无害性"和"有用性"的平衡,更关注回答是否友善、是否会对用户造成心理伤害。就像培养一个"暖男型"AI——温和体贴,宁可牺牲一些直白性也要维护良好关系。

图3:数据集的"喂狼效应"直观展示。不同数据集(实线为HH-RLHF,虚线为UltraFeedback)如何塑造AI的价值取向。可以清楚地看到UltraFeedback倾向于培养"信息型AI"(紫色线较高),而HH-RLHF倾向于培养"社交型AI"(绿色线较高)

研究发现,用UltraFeedback训练的模型确实更偏向信息效用(更直接、更准确),而用HH-RLHF训练的模型则更偏向社交效用(更友善、更体贴)。从上图中可以直观地看到这种"喂狼效应":虚线(UltraFeedback)在信息效用维度明显更高,而实线(HH-RLHF)在社交效用维度表现更强。这个发现为您的数据策略提供了明确指导:如果您的产品需要在专业领域给出精准建议(如医疗、法律咨询),应优先使用信息导向的数据集;如果产品偏向社交和情感支持,则应选择社交导向的数据集。

这项研究最大的价值在于为AI产品开发提供了科学的价值观调优方法。您不再需要盲目地尝试不同的训练策略,而是可以基于认知模型的参数来精确控制模型的行为倾向。比如,如果您发现模型过于"冷酷"(φ值过高),可以通过调整训练数据中社交场景的比例来平衡;如果模型过于"讨好"用户而牺牲准确性,可以引入更多强调事实准确性的训练样本。更重要的是,这套方法让价值观评估变得可量化、可重复,您可以在产品迭代中持续监控和优化模型的价值取向。

这项研究只是揭开了AI价值观研究的冰山一角,但它已经让整个领域看到一个新方向。研究者正在探索如何将这套方法扩展到更复杂的道德场景,如何处理文化差异导致的价值观冲突,以及如何在保持模型有用性的同时避免有害偏见。对于正在开发AI产品的读者朋友来说,掌握这套认知模型方法论将成为未来AI产品开发的核心竞争力——不再是简单的"喂狼",而是精确的"驯狼",让AI真正成为符合人类价值观的智能助手。

未来已来,有缘一起同行

文章来自于微信公众号“AI修猫Prompt”。