最近,微软宣布了一项新功能的公开预览。该功能使 Azure Logic Apps(标准版)能够充当 MCP 服务器,为开发者提供了一种灵活的方式来构建和管理代理。

模型上下文协议(MCP)是一个开放标准,使大型语言模型(LLM)、AI 代理和 MCP 客户端能够以安全、可发现和结构化的方式与外部系统和工具进行交互。该标准定义了如何描述、运行及认证对工具的访问,使代理能够与现实世界的系统进行交互,如数据库、API 和业务工作流。

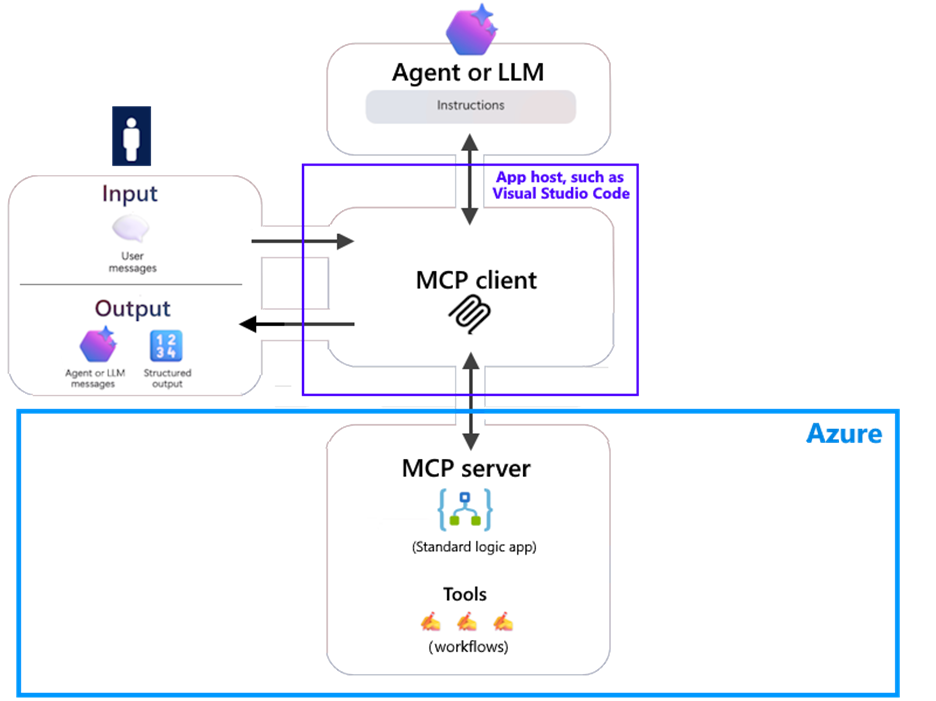

通常情况下,LLM 会与 AI 代理协同工作,后者会使用预构建的工具来处理和响应请求,如发送电子邮件、查询数据库或触发工作流。在 Azure Logic Apps 中,用户可以重新配置 Standard Logic App 使其充当远程模型上下文协议(MCP)服务器,快速启动这些工具的构建工作。

微软首席项目经理 Kent Weare 写道:

通过将这些工具动态组合到 Logic Apps 中,开发者可以快速构建既可扩展又适应复杂企业场景的代理。这样做有很多好处,既能降低开发开销,提高可重用性,简化集成不同系统的路径,还能保持 Logic Apps 平台的灵活性和强大功能。

根据微软的说法,这项能力使用户能够将现有的工作流作为工具暴露出来,LLM、AI 代理和 MCP 客户端就可以利用这些工具与企业资源和资产进行交互。在这个上下文中,“远程”指的是 MCP 服务器运行在 AI 代理接口所在的环境之外。

例如,使用在 Azure 上运行的基于 Standard Logic App 的 MCP 服务器,并使用本地安装的 Visual Studio Code 作为 MCP 客户端,用户可以远程连接到 MCP 服务器。

图片来源:Microsoft Learn

在 LinkedIn 上,微软高级云架构师 Sneha Daggubati 在一篇博文下评论道:

机会:一夜之间就可以为 MCP 实现数千项集成,大大降低了访问 SDC 和本地系统的门槛,并加速了采用。

挑战:在大规模采用这种模式之前,我们需要明确可扩展性、可靠性和长期战略。

此外,微软认证培训师 Parveen Singh 补充道:

难点在于产品化:连接器节流、幂等重试、模式版本控制以及从 Copilot Studio 到 Logic App 运行的端到端追踪。

此外,SharePoint 开发者 Muhammad Urwah Umer 在 LinkedIn 的另一篇博文下评论道:

我喜欢这个方向;将 Logic Apps 作为 MCP 服务器开辟了令人难以置信的可能性。我很好奇,在使用如此多的企业连接器的情况下,组织如何实现治理的平衡。

要了解详细信息,可以查看文档页面或这个指南 Demo。

原文链接:

https://www.infoq.com/news/2025/09/microsoft-logic-apps-mcp-servers/

文章来自于微信公众号 “InfoQ”,作者 “InfoQ”

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)