Mistral-Medium竟然意外泄露?此前仅能通过API获得,性能直逼GPT-4。

CEO最新发声:确有其事,系早期客户员工泄露。但仍表示敬请期待。

换句话说,这个版本尚且还是旧的,实际版本性能还会更好。

这两天,这个名叫“Miqu”的神秘模型在大模型社区里炸了锅,不少人还怀疑这是LIama的微调版本。

对此Mistral CEO也做出了解释, Mistral Medium是在Llama 2基础上重新训练的,因为需尽快向早期客户提供更接近GPT-4性能的API, 预训练在Mistral 7B发布当天完成。

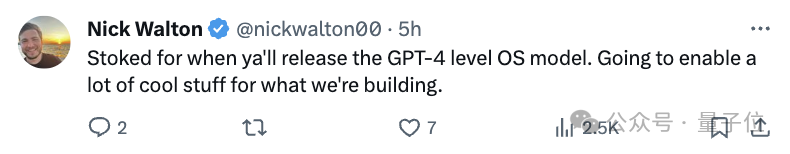

如今真相大白,CEO还卖关子,不少网友在底下戳戳手期待。

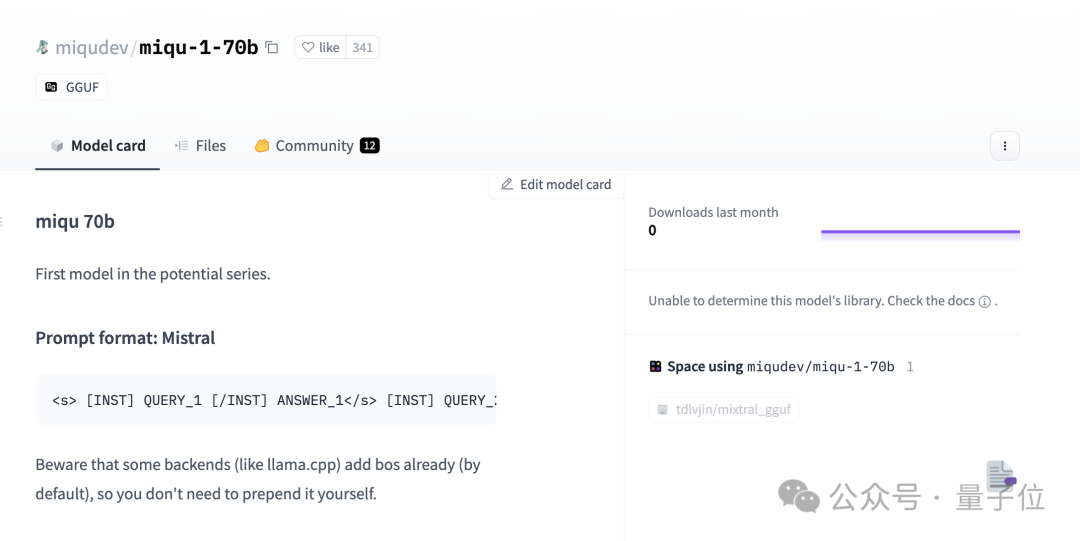

我们还是重新来回顾一下整个事件。1月28日,一个名叫Miqu Dev的神秘用户在HuggingFace上发布一组文件“miqu-1-70b”。

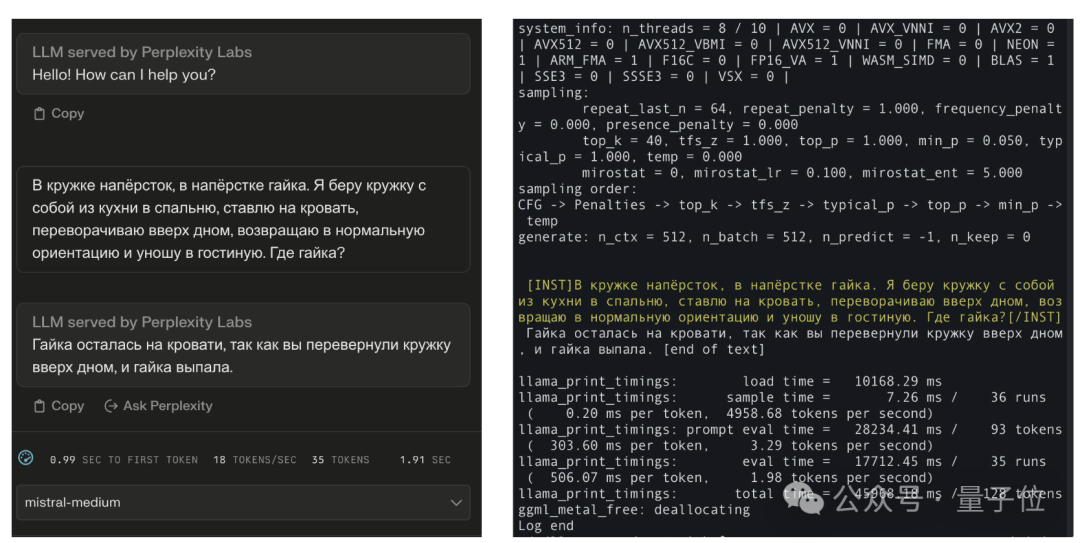

文件指出新LLM的“提示格式”以及用户交互方式同Mistral相同。

同一天,4chan上一个匿名用户发布了关于miqu-1-70b文件的链接。

于是乎一些网友注意到了这个神秘的模型,并且开始进行一些基准测试。

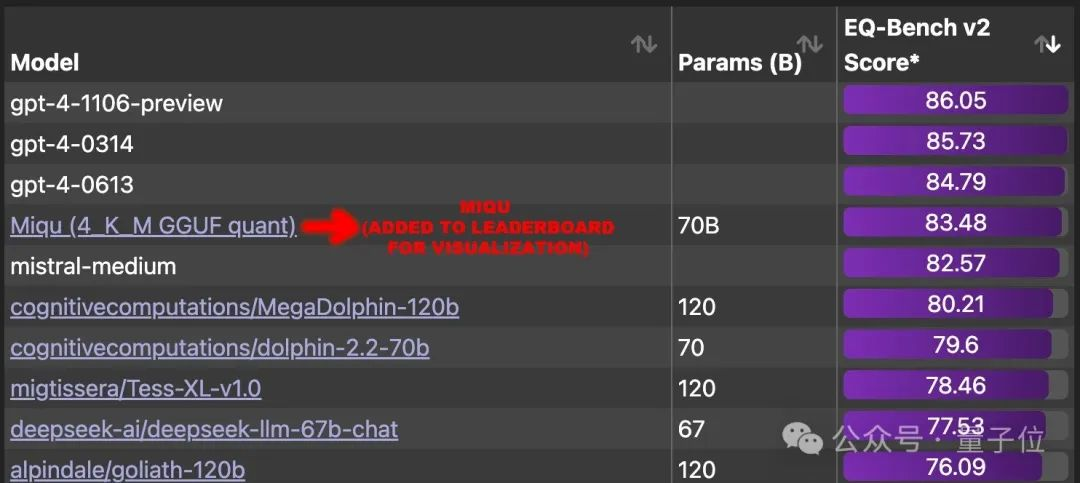

结果惊人发现,它在EQ-Bench 上获得83.5 分(本地评估),超过世界上除GPT-4之外的所有其他大模型。

一时间,网友们强烈呼吁将这个大模型添加到排行榜中,并且找出背后的真实模型。

大致怀疑方向主要有三个:

有网友晒出了对比效果:它知道标准答案还说得过去,但不可能连俄语措辞也跟Mistral-Medium完全相同吧。

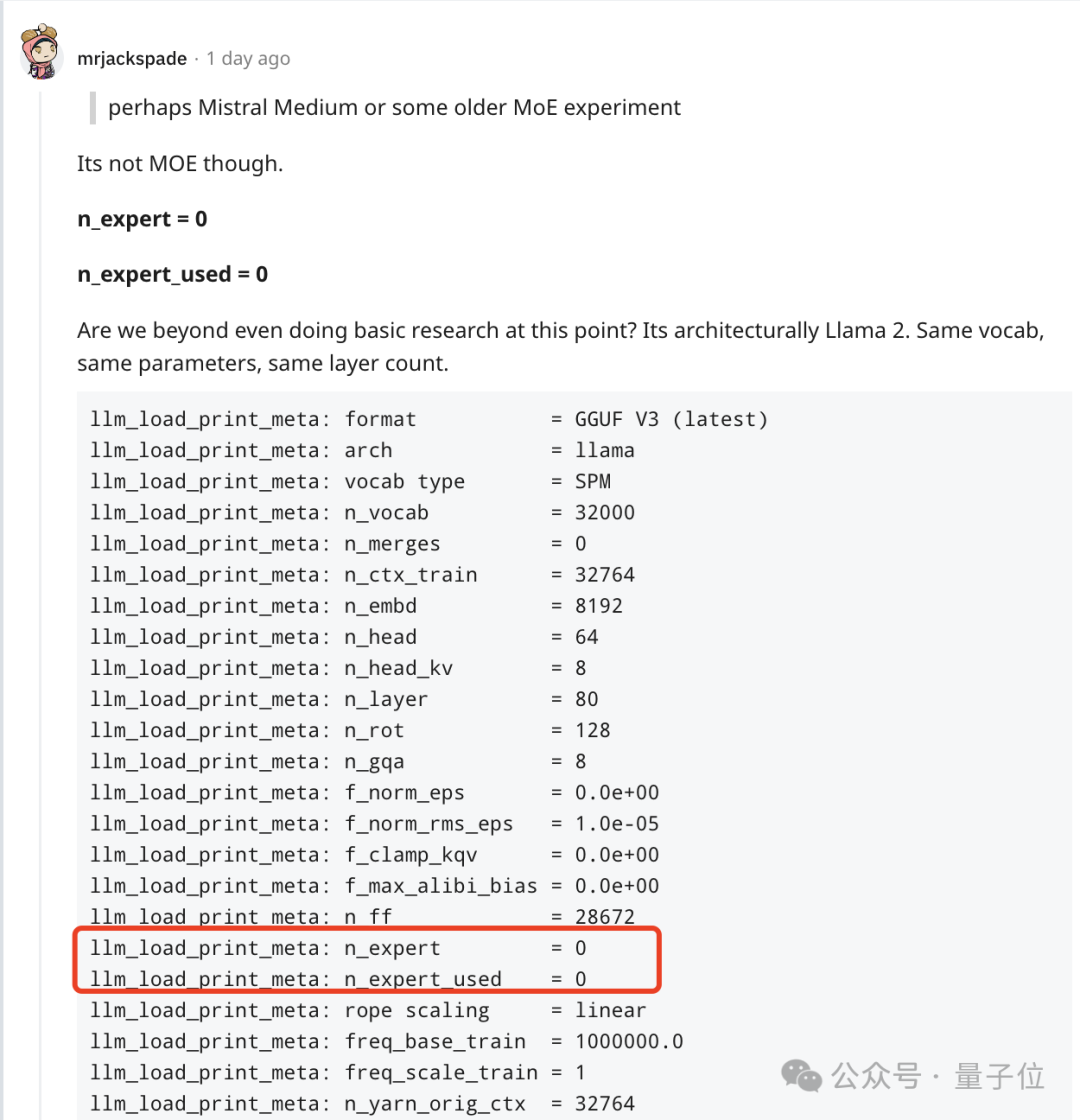

但另外的网友发现,它并不是MoE模型,并且同LIama 2架构相同、参数相同、层数相同,。

不过马上就受到其他网友的质疑,Mistral 7b也具有与 llama 7B 相同的参数和层数。

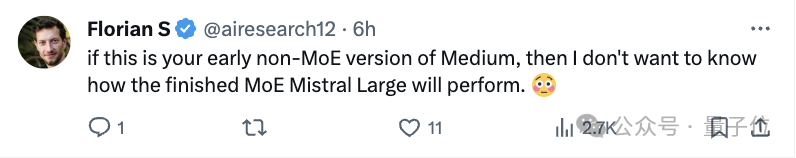

相反,这更像是Mistral早期非MoE版本模型。

不过讨论来讨论去,不可否认的是在不少人心中,这已经是最接近GPT-4的模型了。

如今,Mistral 联合创始人兼首席执行官 Arthur Mensch承认泄露,是他们一位早期客户员工过于热情,泄露了他们训练并公开发布的一个旧模型量化版本。

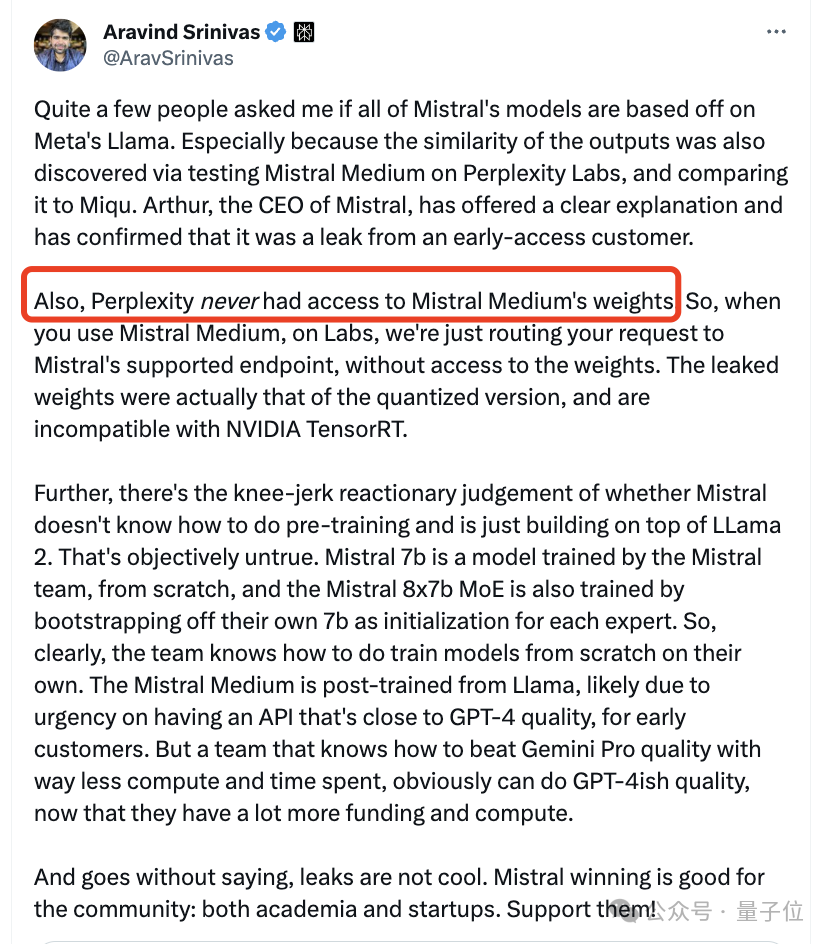

至于Perplexity这边CEO也澄清说,他们从未获得过Mistral Medium的权重。

网友担心是否会撤下这个版本。

有趣的是,Mensch并没有要求删除HuggingFace上的帖子。

而是留下评论说:可能会考虑归属问题。

参考链接:

[1]https://www.reddit.com/r/LocalLLaMA/comments/1af4fbg/llm_comparisontest_miqu170b/

[2]https://twitter.com/teortaxesTex/status/1752427812466593975

[3]https://twitter.com/N8Programs/status/1752441060133892503

[4]https://twitter.com/AravSrinivas/status/1752803571035504858

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner