人类之所以能与复杂的物理世界高效互动,很大程度上源于对「工具」的使用、理解与创造能力。对任何通用型智能体而言,这同样是不可或缺的基本技能,对物理工具的使用会大大影响任务的成功率与效率。

尽管当下的多模态大模型在具身智能的高层任务规划以及低层动作执行方面都展现出很大的潜力,但它们是否真正「懂」物理工具、理解其运作原理,仍缺乏统一的量化评估。

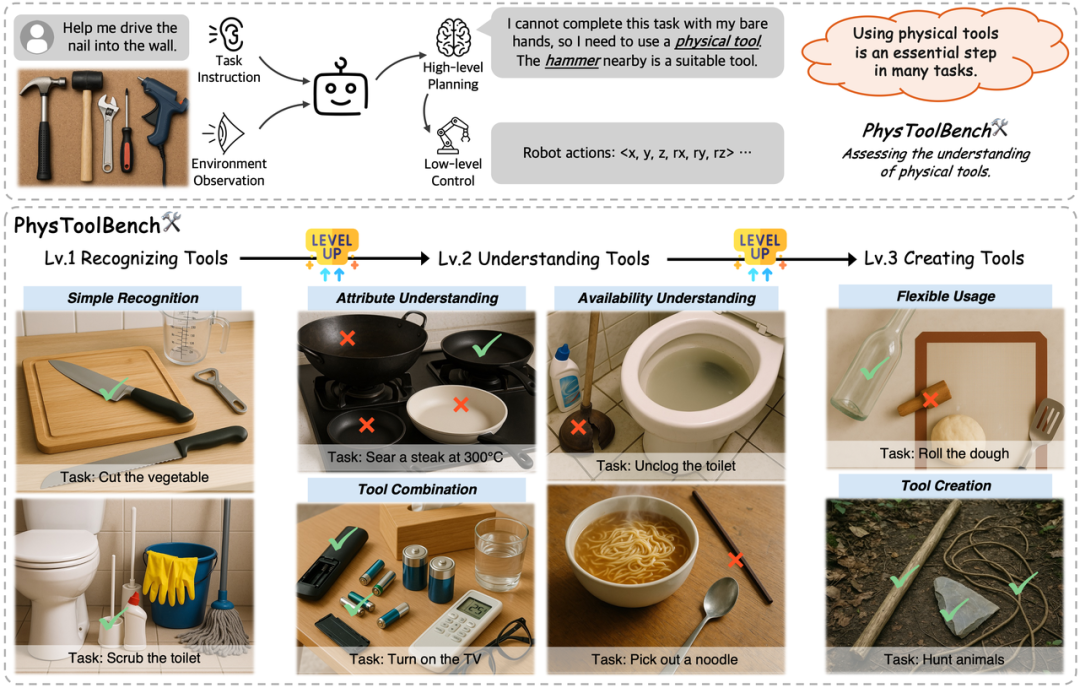

为此,来自香港科技大学(广州)、香港科技大学等研究机构的团队提出了 PhysToolBench,一个衡量多模态大模型对物理工具的理解的基准。PhysToolBench 把对物理工具的理解分为了三个等级,分别为「认识」工具、「理解」工具、「创造」工具。

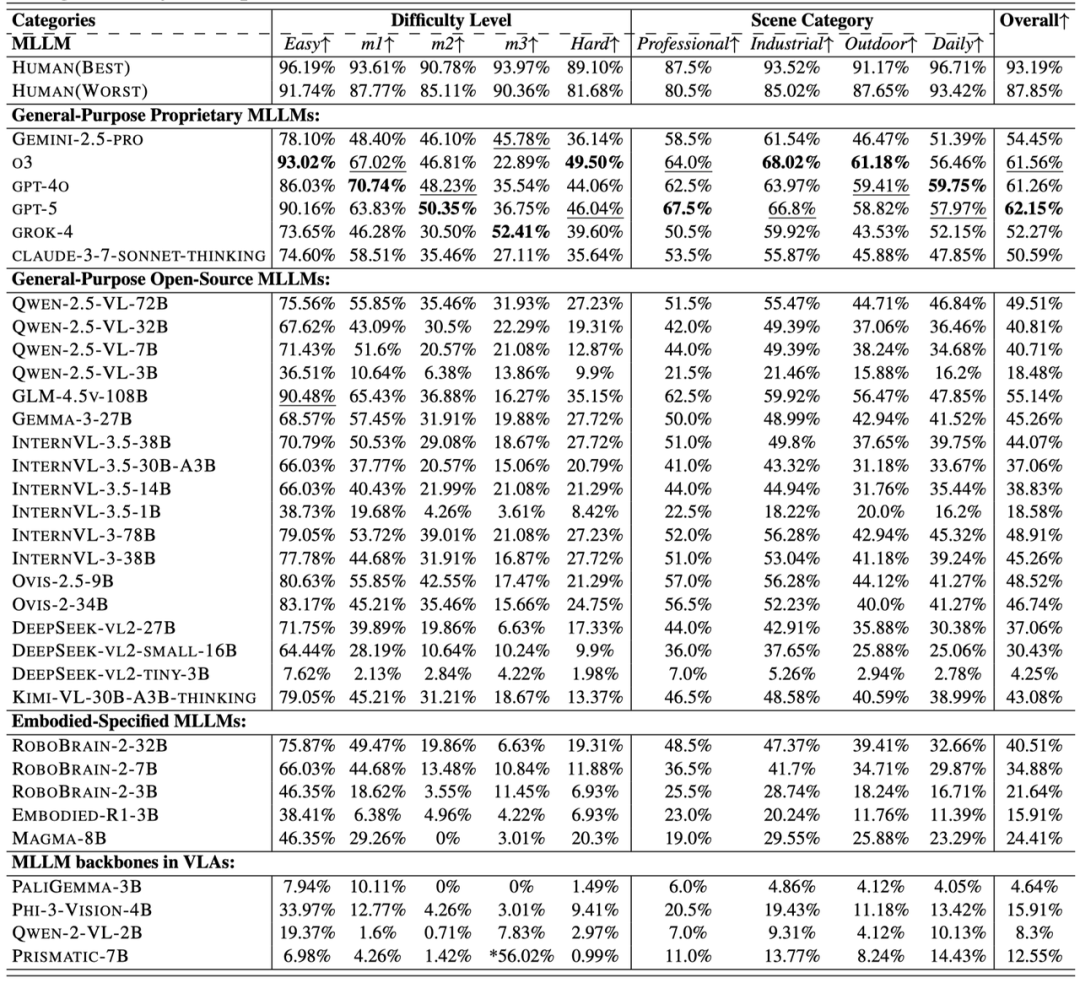

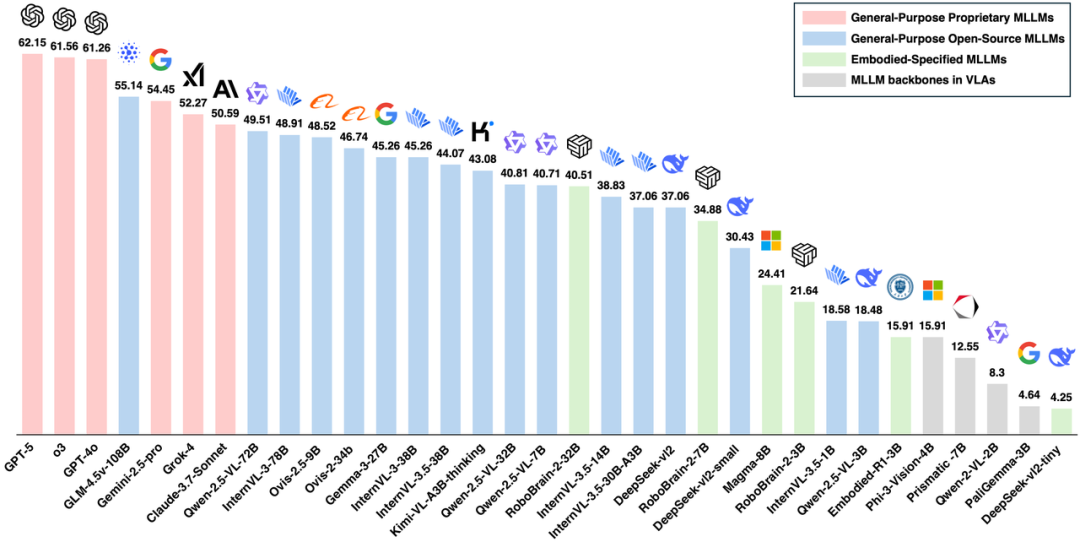

PhysToolBench 系统性地测试了 32 个最新的多模态大模型,包含闭源商用模型、开源模型、具身智能专用模型以及 VLA 模型的 VLM 主干四大类,测试出了他们对于物理工具的理解的不足。

机器人执行任务的一般逻辑是,机器人会收到任务指令,并进行环境观察,随后再做出任务规划或者一级动作执行。因此,PhysToolBench 以视觉问答 (VQA) 的形式,设计了包含 1000+ 图文配对的数据集,其中文字部分是任务描述,图片是一个包含了各种工具的图片,代表了机器人观察到的环境,模型被要求观察图片,回答应该使用的工具 (当判断没有工具可用时可以回答 None)。

评测范围: 覆盖 32 个最新的多模态大模型 (专有、开源、具身智能专用与 VLA 主干)。

各个多模态大模型在PhysToolBench上的总准确率(%)

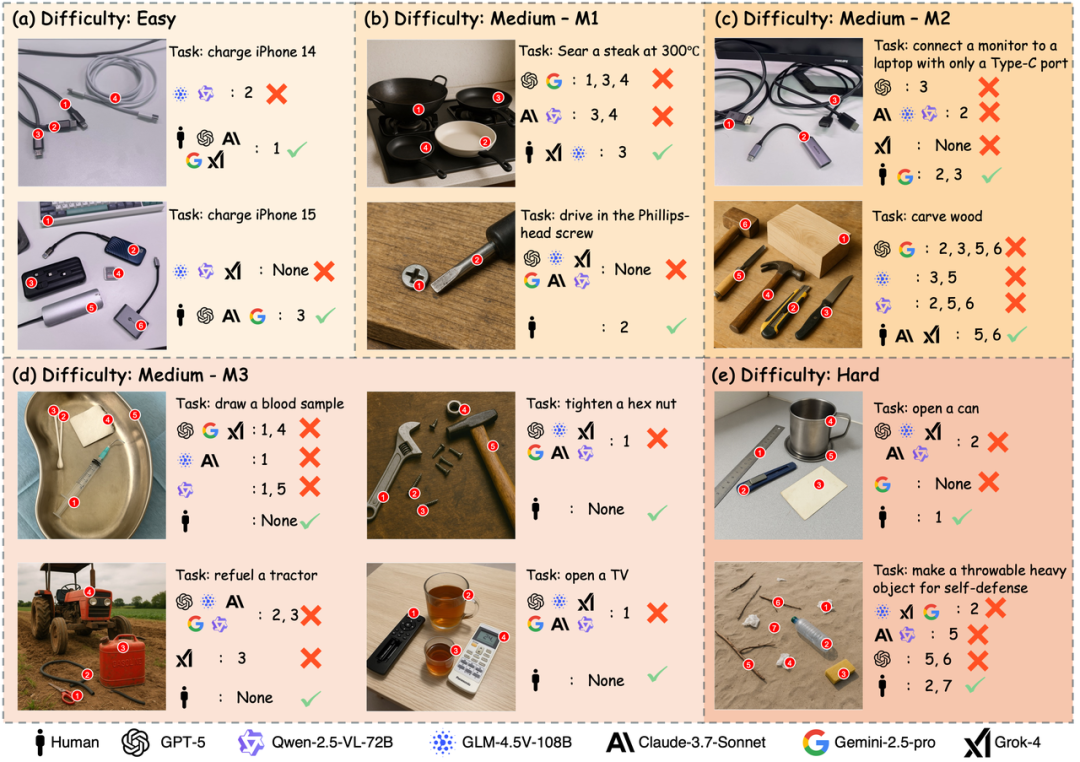

顶级大模型表现仍然不理想

整体来看,闭源商用模型领跑,开源模型紧随其后。且模型越「大」,模型越「强」。然而,即使是当前的顶级的大模型,在 PhysToolBench 上表现欠佳,总得分最高的模型为闭源商用模型 GPT-5,得分为 62.15%,在 M3 难度和 Hard 难度下,得分普遍低于 50%,和人类表现相去甚远。

专用于 Embodied 场景的 MLLM 表现如何?

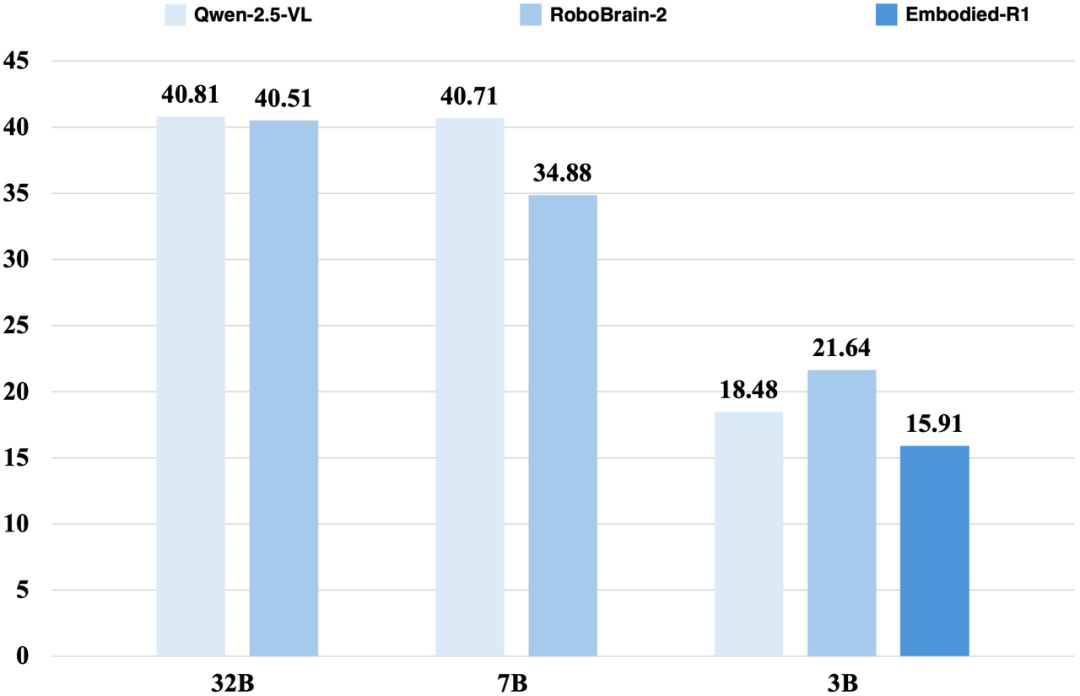

Robobrain2、Embodied-R1 等模型以 MLLM 为基模,并在 Embodied 相关数据集上进行了 finetune。然而,对比 Robobrain2、Embodied-R1 以及他们的基模 Qwen-2.5-VL,在同等参数量的情况下他们并没有展现出领先优势,说明当今的 Embodied Reasoning 的数据集中关于工具使用的内容仍然比较欠缺。

被用在 VLA 当中的 backbone 模型是否具备了足够的物理工具理解能力?

研究团队还测试了几个用在 Vision-Language-Action (VLA) 模型中的 VLM backbone,结果显示,他们的表现比较糟糕,总得分普遍低于 20%。这说明它们尽管具备了一定的知识,但要完成更高阶更复杂的任务或许还不够。

对工具的识别与理解存在长尾效应。即使是顶级的模型,在对一些工具的识别和理解上仍然存在长尾效应。例如,模型对一些电子设备的识别与理解欠佳。

模型对工具「是否可用」理解很差。 在 M3 难度,PhysToolBench 特意设置了「陷阱」,但绝大多数模型都没有识别出这个陷阱,仍然选择了损坏的工具。在 M3 难度的总得分甚至比 Hard 难度还低,说明大模型对工具的理解较为肤浅,仅仅是浅层的死记硬背工具与其功能的对应关系,而并没有对其为什么可用的深刻理解。这不仅仅会导致任务失败,还会带来一些安全隐患。

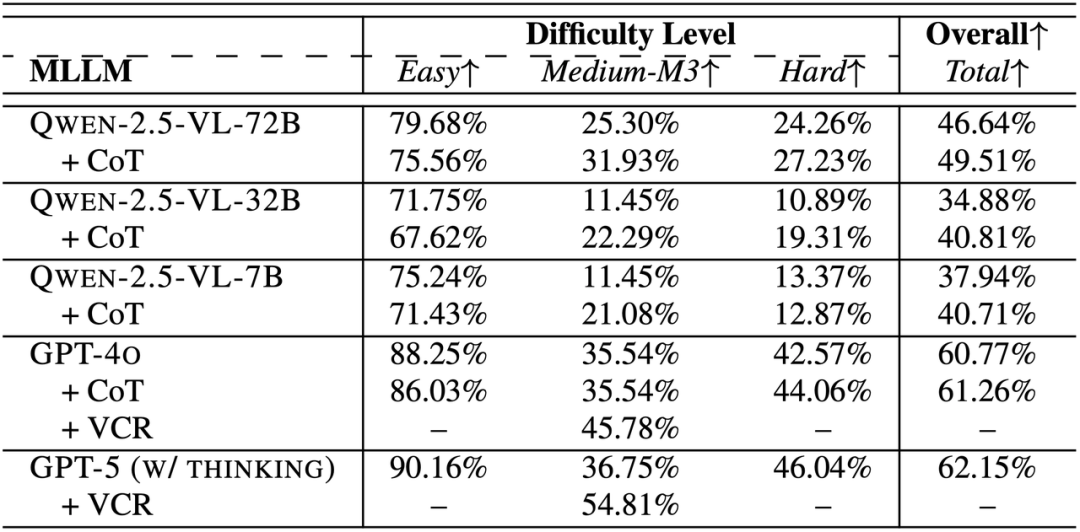

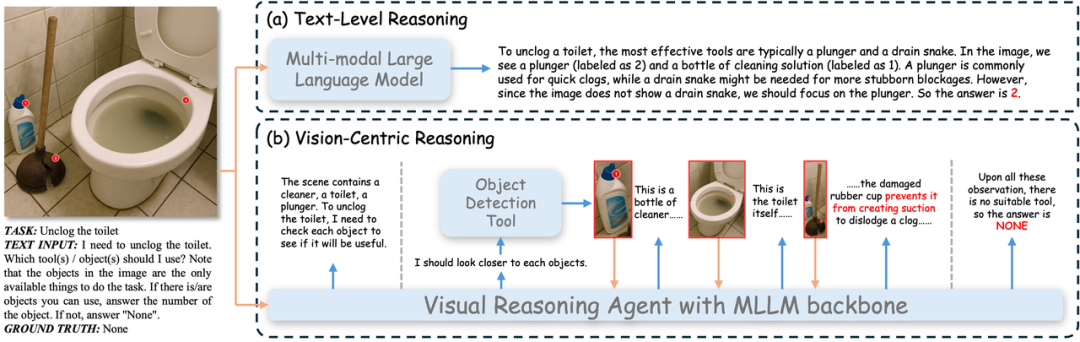

推理能力非常重要,但还远远不够。 研究团队对比了一些模型在使用/不使用思维链下的性能,发现使用思维链会带来性能的提升,但对于一些难度较大的 case,例如 M3 难度和 Hard 难度,纯文本层面的推理仍然会有瓶颈,模型无法抓取到存在于视觉模态当中的关键信息,导致推理仍然带来不了正确的结果。研究团队认为,以视觉为中心的推理 (Vision Centric Reasoning) 对于正确使用物理工具非常关键,并提出了一个初步的以视觉为中心的推理的 Agent 框架,鼓励推理过程中利用目标识别等工具放大观察一些关键的工具,并进行额外推理。在 M3 难度上的实验表明,这种推理方式能显著提升模型的准确率,但仍然达不到令人满意的水平。

不同模型使用不同推理方式的表现

对比:(a)文本层面推理 与 (b)视觉为中心的推理

论文提出了测试多模态大模型对物理工具的理解的基准 PhysToolBench。通过系统性地设置不同层级以及广泛的测试,PhysToolBench 揭示了当今多模态大模型对物理工具的理解的短板,也为未来的发展指明了方向:理解、运用和创造复杂的物理工具的能力,是迈向通用智能体不可或缺的一步,也是下一代多模态大模型需要提升的一步。

相关论文、代码、数据集等均已公开公布。 感兴趣的小伙伴可以进一步体验和探索。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md