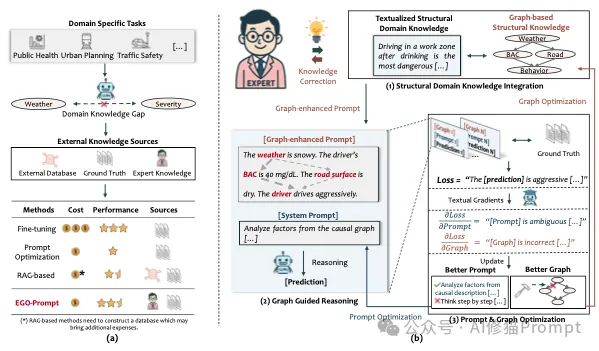

大型语言模型(LLMs)正迅速成为从金融到交通等各个专业领域不可或缺的辅助决策工具。但目前LLM的“通用智能”在面对高度专业化、高风险的任务时,往往显得力不从心。为了弥合这一差距,我们目前高度依赖领域专家,他们需要投入大量精力将复杂的领域知识和因果关系有效地整合到提示(Prompt)中来设计完美的“提示词”(Prompts),以达到能指导 LLM 进行正确推理的目的。

可问题在于,这种方式不仅成本高昂,而且专家也可能无意中将偏见或不完整的知识引入系统。那么,我们能否实现一个“自动化”系统,它不仅能优化提示,还能在学习过程中自动纠正和完善专家提供的领域知识?

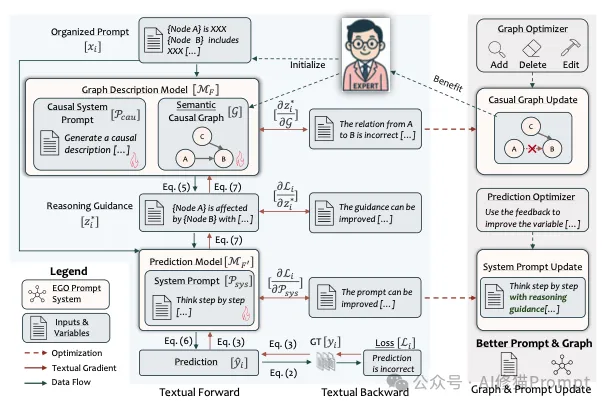

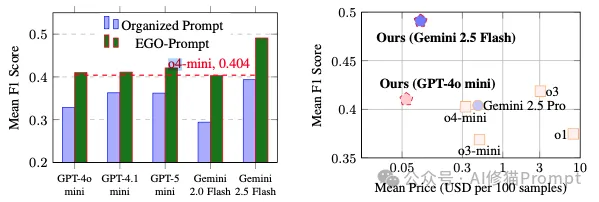

针对这一关键挑战,约翰·霍普金斯大学的研究人员提出了一个名为EGO-Prompt(Evolutionary Graph Optimization for Prompting)的自动化框架。该方法的核心思想是,不再将专家知识视为一成不变的“圣经”,而是将其视为一个可以进化的“草稿”。EGO-Prompt以一个由专家初步构建的、允许存在缺陷的“语义因果图”(SCG)为起点,再通过真实数据的“文本梯度”(textual gradients)循环修改提示词和因果图,让大模型既会用域知识、又能越学越好。实验证明在三类真实任务上明显好于强基线,而且能让小模型做到接近甚至超过更贵的大模型和推理模型。

这个框架就像一个“学生”、“教科书”和“导师”协同进化的过程:

如果说 LLM 是学生,SCG 是教科书,那么“文本梯度”就是“导师的辅导笔记”。

当学生(LLM)做完作业(做出预测)并对照“标准答案”发现自己错了时,他不会自己闷头苦思,而是会去找一个更博学、更强大的“导师”(即论文中的“反向引擎”,通常是一个更强大的模型如 GPT-4o)。

这位导师不会直接给答案,而是会写下一张详细的“辅导笔记”(即文本梯度),一针见血地指出学生出错的根本原因。

这张“辅导笔记”的神奇之处在于它有“两联”:

通过这个机制,“学生”的解题能力和“教科书”的知识准确性,就在这位“导师”的指导下,一轮一轮地共同进化了。

SCG 是一个有向无环图(DAG):节点是从任务输入中抽取的语义块(如“驾驶者状态”“道路条件”等),边是专家给出的因果性语义关联(用自然语言解释“谁影响谁”以及“如何影响”)。这里的关键是,这张初始的“逻辑草图(SCG)”不要求完整或完全正确,因为后面会通过算法自动修正与进化;它也不是做严格因果识别,所以不强求满足因果马尔可夫或忠实性假设。这极大地降低了对人类专家的要求,也让整个系统具备了从不完美起点出发、最终臻于完善的潜力。这张草图为AI的初步推理提供了一个骨架,但AI接下来的任务,正是在实践中去验证、修正和扩充这张地图。

论文分别给出了多个任务的 SCG 例子。例如在交通事故严重度任务里,专家会写出诸如“血液酒精浓度(BAC)显著提高致命事故概率”“在施工路段行驶会抬高严重/致命事故概率”等因果陈述,作为图中的边。

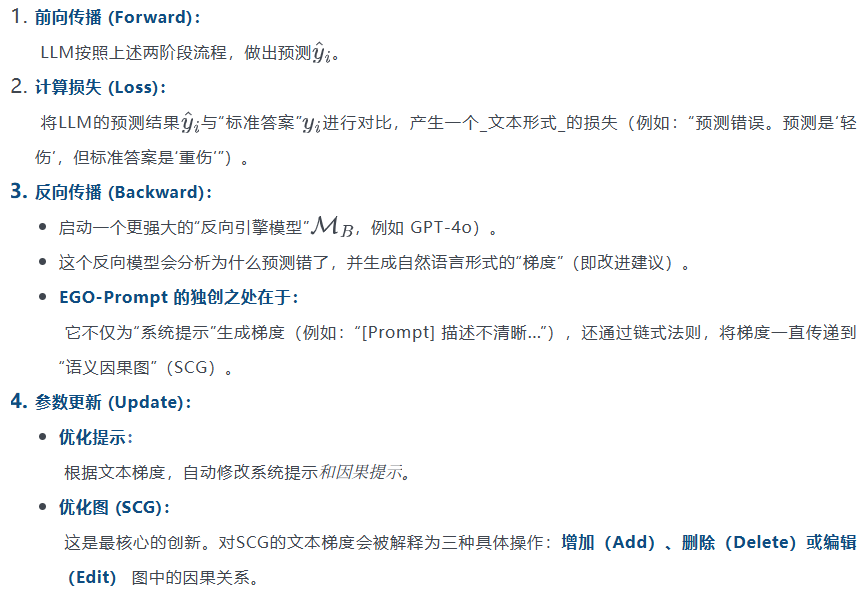

这是实现“进化”的关键。EGO-Prompt 使用“文本梯度”技术(借鉴了 TextGrad 等先前工作),将深度学习中的“反向传播”思想用自然语言来实现:

通过在数据集上不断迭代这个循环,提示和因果图会共同进化,变得越来越准确。

理解了两大神器后,我们来看看EGO-Prompt是如何将一个“万能实习生”培养成“领域专家”的。整个过程可以分为四步:

第一步:专家设定起点——提供“教材”和“初步逻辑图”

任务开始时,一位领域专家需要做两件事:

这两样东西共同构成了AI学习的“初始教材”。

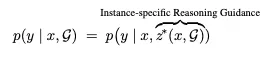

第二步:两阶段推理——“分析师”与“决策者”的分工协作

当一个新案例(比如一份具体的交通报告)输入系统时,EGO-Prompt并不会粗暴地将所有信息都丢给一个模型处理。它设计了一个更精巧的两阶段流程:

这种分工协作的模式,极大地提高了推理的效率和相关性,避免了模型在无关信息的海洋中迷失方向。

第三步:实践与反思——“文本梯度”驱动的自我修正

“决策者”做出预测后,系统会将其与“标准答案”(Ground Truth)进行比对。如果预测错误,神奇的“文本梯度”机制就会启动。一个更强大的“导师模型”会介入,生成一份详细的“改进意见书”,指出原始提示或SCG中可能存在的问题。

第四步:进化与成长——改写“教材”和“逻辑图”

系统根据“改进意见书”自动执行修改操作。这些操作被严格限定为三种:

整个过程会不断迭代。经过多轮“实践-反馈-修改”的循环,最初由专家提供的那份粗糙的“教材”和“逻辑图”,逐渐被千锤百炼,变得越来越精确、高效和强大。AI也从一个只会照本宣科的“实习生”,成长为一个真正懂得如何在复杂领域中进行细致推理的“专家”。

理论听起来很完美,但实际效果如何?研究团队在真实世界专业领域数据集上测试了EGO-Prompt:

我用Kimi-k2系列模型运行了EGO-prompt,以下是我得到的结果:

基线分数0.2434,最优0.3624,绝对提升+0.1190(+11.90 个百分点),相对提升约 +48.9%。

以下是首个默认提示

最终结果

欢迎您加群一起探讨!

EGO-Prompt的出现,为所有AI从业者带来了深刻的启示,它可能预示着我们工作范式的根本性转变:

1. 重新定义“提示工程师”的角色:未来的“提示工程师”可能不再需要像程序员一样,逐字逐句地编写天书般的复杂指令。他们的角色将更像一位“AI教练”或“课程设计师”。他们的核心工作是为AI设定一个好的起点——定义清晰的任务目标,并提供一份包含核心领域逻辑的、允许不完美的“初始教材”(SCG)。然后,将AI“投放”到真实的训练数据中,监控其“自我进化”的过程,并在必要时进行宏观调控。

2. 拥抱“人机协同”的知识管理:EGO-Prompt证明,人类的先验知识与机器从数据中学习的能力可以形成一个完美的闭环。我们应该构建这样的系统:人类专家的知识可以作为AI学习的“冷启动”资产,而AI在学习过程中提炼出的新洞见和修正,又能反哺给人类,形成一个动态更新、持续增长的“活”知识库。

长期以来,我们训练AI的方式,更像是在进行一种“灌输式教育”,我们把海量的数据和固定的指令塞给模型,期望它能“死记硬背”下世界的规律。这种方式或许能培养出优秀的“模仿者”和“预测者”,但距离能够独立思考、举一反三的“理解者”,似乎总有一步之遥。

EGO-Prompt则为我们展示了另一种可能,一种“启发式、探索式”的教育。它承认初始知识的不完美,鼓励在实践中犯错,并提供强大的反思和修正机制,让智能体通过自身的“努力”去逼近真理。

这或许才是从“模仿”到“理解”的更现实、更有效的路径。我们需要的,可能不是一个无所不知、从不出错的“神谕”,而是一个能够与我们并肩作战,共同学习、共同成长,在探索未知中不断完善自身和我们认知的“伙伴”。EGO-Prompt,正是在这条进化之路上,迈出的坚实而又激动人心的一步。

文章来自于“Al修猫Prompt”,作者“Al修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0