尽管收集人类对模型生成内容的相对质量的标签,并通过强化学习从人类反馈(RLHF)来微调无监督大语言模型,使其符合这些偏好的方法极大地推动了对话式人工智能的发展。但由于 RLHF 是一个复杂且常常不稳定的过程,关于直接使用优化函数将人类的偏好和模型的结果进行对齐的研究成为时下的热点问题。

本文是 hugging face 上的一篇博客,针对时下常见的三种人类偏好优化算法进行了性能比较。作者进行了大量的实验,旨在通过不同的模型和不同的超参数,对无需强化学习(或偏好调整)就能调整语言模型的三种可行方法进行评估。这三种优化方法是:

本文五位作者

在这篇博客中,作者对三种优秀的 LLM 对齐算法进行了评估,分别是:直接偏好优化(DPO)、身份偏好优化(IPO)和 Taversky Optimisation 优化(KTO),并且在两个高质量的 7b 参数 大小的 LLM 上进行了实验。这些 LLM 经过了有监督微调,但没有进行人类偏好调整。作者发现,虽然确实能找到效果最好的算法,但要获得最佳结果,必须对一些关键超参数进行调整。

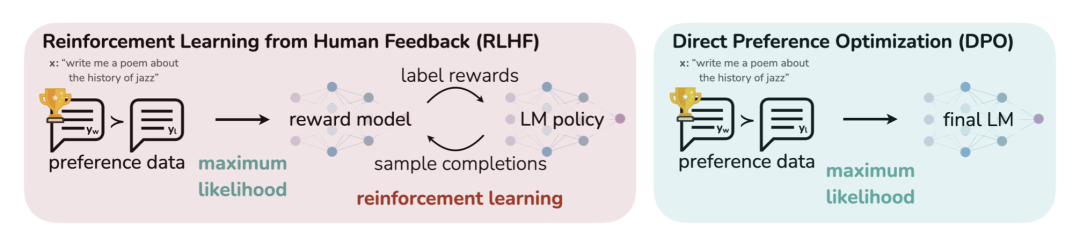

DPO 的原理示意图 (https://arxiv.org/abs/2305.18290)

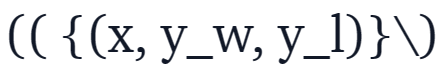

直接偏好优化(DPO)已成为将大型语言模型(LLM)与人类或人工智能偏好相结合的一种很有前景的方案。与基于强化学习的传统对齐方法不同,DPO 将对齐公式重新定义为一个简单的损失函数,该函数可以直接在偏好数据集{(x,y_w,y_l)}上进行优化,其中 x 是 prompt,y_w,y_l 分别是偏好的和非偏好的响应。

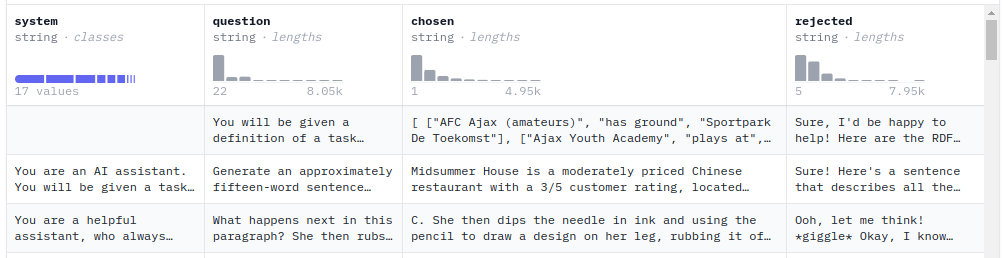

人类偏好调整数据集的示例

DPO 简单易用的特性使得它广受欢迎,并已成功应用于 Zephyr 模型和 Intel 提出的 NeuralChat 等模型的训练当中。

DPO 的成功激发了研究人员对新的损失函数进行研究,这些研究可以归纳为以下两个主要方向:

,能够根据一组标准(如有益性或有害性),来标记哪种模型响应更好。在实践过程中,创建这些数据是一项耗时且成本高昂的工作。ContextualAI 最近提出了一种有趣的替代方案,称为 Kahneman-Taversky 优化(KTO),它完全根据被标记为「好」或「坏」的样本(例如在聊天 UI 中看到的图标????或????)来定义损失函数。这些标签更容易获得,可以说 KTO 是一种很有前景的方法,可以不断更新在生产环境中运行的聊天模型。

,能够根据一组标准(如有益性或有害性),来标记哪种模型响应更好。在实践过程中,创建这些数据是一项耗时且成本高昂的工作。ContextualAI 最近提出了一种有趣的替代方案,称为 Kahneman-Taversky 优化(KTO),它完全根据被标记为「好」或「坏」的样本(例如在聊天 UI 中看到的图标????或????)来定义损失函数。这些标签更容易获得,可以说 KTO 是一种很有前景的方法,可以不断更新在生产环境中运行的聊天模型。与此同时,需要注意这些方法都有相应的超参数,其中最重要的是 β ,这是一个控制对使用模型的偏好程度的权重。随着这些方法已经可以通过第三方库(如 huggingface TRL)来使用,接下来自然而然的问题是「在这些方法和超参数中,哪个组合能产生最好的聊天模型?」

本文旨在通过对这三种方法进行实验分析来回答这个问题,并且还要对关键超参数逐个分析,例如 β 和训练步数,最后通过 MT-Bench 评估所得模型的性能。MT-Bench 是衡量聊天模型功能的常见基准。

源代码地址:https://github.com/huggingface/alignment-handbook

以下是相关资料的获取地址:

在进行对齐实验时,需要考虑两个主要因素:需要优化的模型和数据集。为了获得更多数据,作者考虑了两个模型,OpenHermes-2.5-Mistral-7B 和 Zephyr-7B-β-sft,以及两个对齐数据集:Intel 的 orca_dpo_paries 数据集和 ultrafeedback-binarized(https://huggingface.co/datasets/HuggingFaceH4/ultrafeedback_binarized)数据集。

在第一个实验中,作者使用了 OpenHermes-2.5-Mistral-7B,因为它是不使用任何对齐方法的条件下,最好的 7B 级聊天模型之一。然后,本文使用了 Intel 的 orca_dpo_paries 数据集,该数据集包含 13k 个 prompt,其中被选择的响应结果由 GPT-4 生成,不需要的响应由 Llama Chat 13b 生成。这也是 NeuralChat 和 NeuralHermes-2.5-Mistral-7B 使用的数据集。

由于 KTO 本身不需要成对的偏好数据,作者直接将 GPT-4 生成的响应归类为「好」标签,将 Llama Chat 13b 的响应视为「坏」标签。虽然 GPT-4 的响应可能比 Llama Chat 13b 普遍更受欢迎,但在某些情况下,Llama-Chat-13b 可能会产生更好的响应,但作者认为这只是小概率事件,可以忽略不计。

第二个实验基于 ultrafeedback-binarized 数据集,在 Zephyr-7b-β-sft 模型上进行了偏好比对。ultrafeedback-binarized 数据集包含 66k 个 prompt 以及成对的偏好与拒绝的响应。该数据集之前被用于训练原始 Zephyr 模型,该模型当时在许多自动化基准测试和人工评估方面是 7B 类模型中最好的。

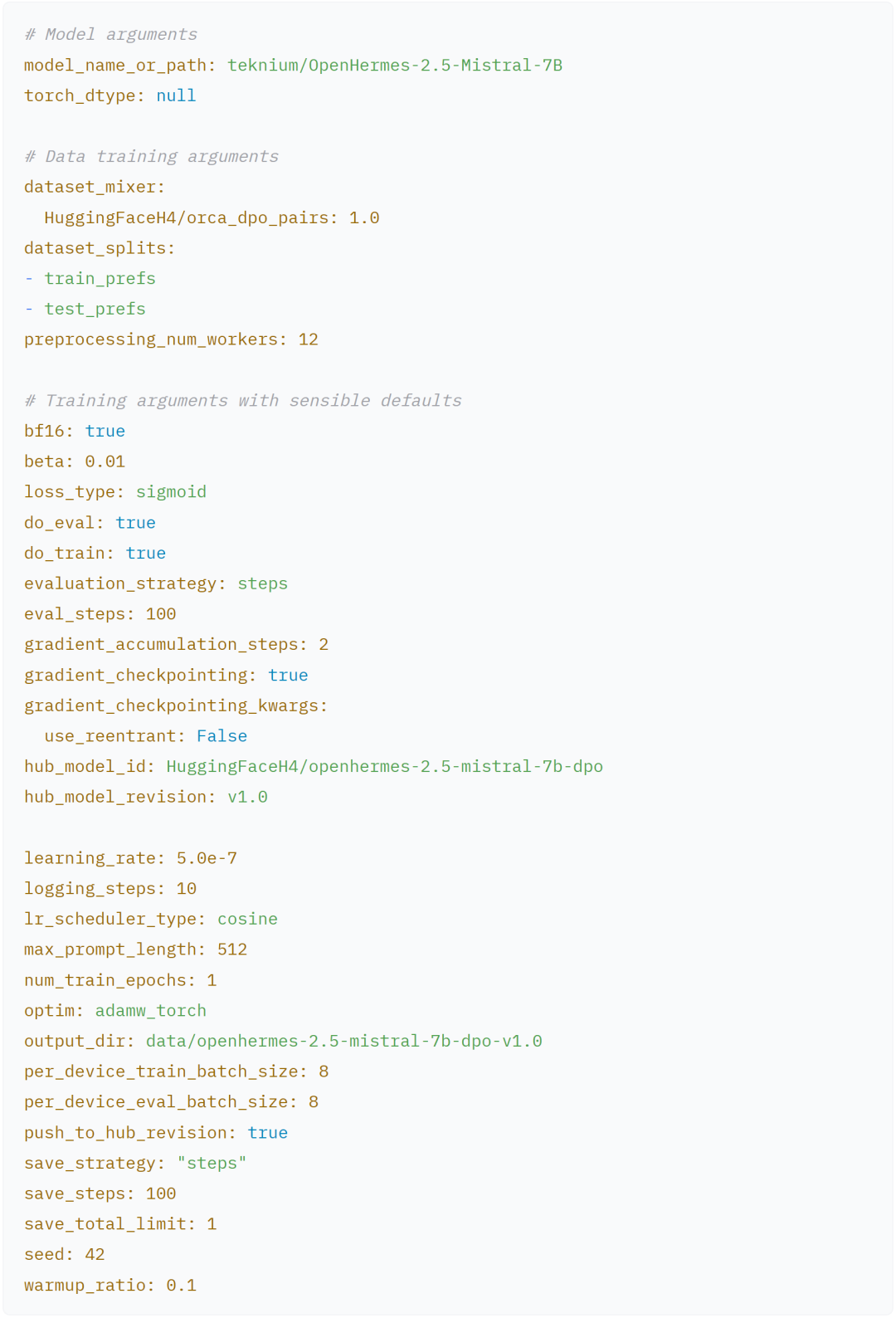

对齐手册提供了一种配置单个实验的简单方法,这些参数可以在 run_dpo.py 中配置。

作者在 Zephyr 上的实验配置也基本类似。

聊天模板由基本聊天模型中自动推断,OpenHermes-2.5 使用 ChatML,Zephyr 使用 H4。如果用户想使用自己的聊天格式,分词库现在已经启用了使用 jinja 格式字符串的用户定义聊天模板:

# Example of the Zephyr chat template

"{% for message in messages %}\n {% if message ['role'] == 'user' %}\n {{ '<|user|>\n' + message ['content'] + eos_token }}\n {% elif message ['role'] == 'system' %}\n {{ '<|system|>\n' + message ['content'] + eos_token }}\n {% elif message ['role'] == 'assistant' %}\n {{ '<|assistant|>\n' + message ['content'] + eos_token }}\n {% endif %}\n {% if loop.last and add_generation_prompt %}\n {{ '<|assistant|>' }}\n {% endif %}\n {% endfor %}"

如下可以将对话格式化:

# <|system|>

# You are a friendly chatbot who always responds in the style of a pirate.</s>

# <|user|>

# How many helicopters can a human eat in one sitting?</s>

# <|assistant|>

# Ah, me hearty matey! But yer question be a puzzler! A human cannot eat a helicopter in one sitting, as helicopters are not edible. They be made of metal, plastic, and other materials, not food!

实验中,作者逐次调整 β 值,分别在 0.01、0.1、0.2、…、0.9 时,对 DPO、IPO 和 KTO 三种方法进行实验。之所以包括 0.01,是因为作者观察到一些对齐算法对这个参数特别敏感。所有实验都只训练了一个 epoch。期间其他超参数保持不变,包括随机种子。

然后,作者使用上面定义的基本配置在 hugging face 的模型上逐个进行实验。

# Define an array containing the base configs we wish to fine tune

configs=("zephyr" "openhermes")

# Define an array of loss types

loss_types=("sigmoid" "kto_pair" "ipo")

# Define an array of beta values

betas=("0.01" "0.1" "0.2" "0.3" "0.4" "0.5" "0.6" "0.7" "0.8" "0.9")

# Outer loop for loss types

for config in "${configs [@]}"; do

for loss_type in "${loss_types [@]}"; do

# Inner loop for beta values

for beta in "${betas [@]}"; do

# Determine the job name and model revision based on loss type

job_name="$config_${loss_type}_beta_${beta}"

model_revision="${loss_type}-${beta}"

# Submit the job

sbatch --job-name=${job_name} recipes/launch.slurm dpo pref_align_scan config_$config deepspeed_zero3 \\

"--beta=${beta} --loss_type=${loss_type} --output_dir=data/$config-7b-align-scan-${loss_type}-beta-${beta} --hub_model_revision=${model_revision}"

done

done

done

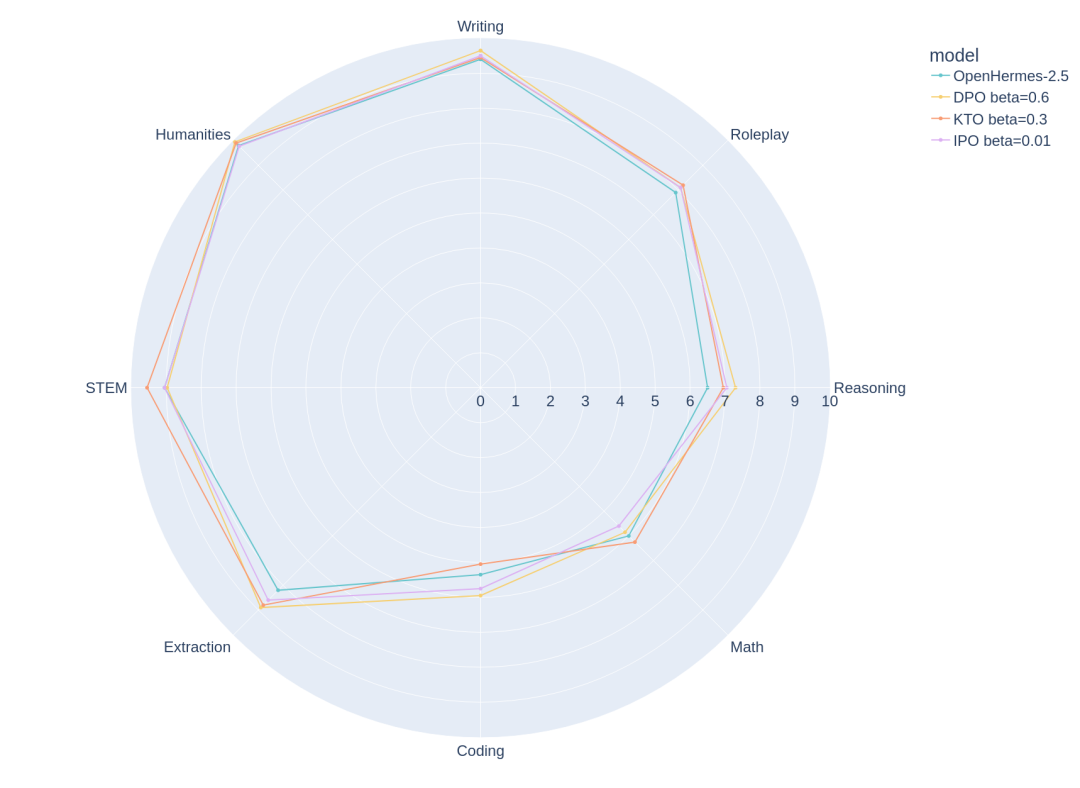

作者使用 MT Bench 评估了所有模型,这是一个多轮对话的基准。该基准使用 GPT-4 来判断模型在八个不同类别中的表现,分别是写作、角色扮演、推理、数学、编码、提取、STEM 和人文学科。虽然存在一些不完美的地方,但 MT Bench 仍然是评估会话 LLM 的好方法。

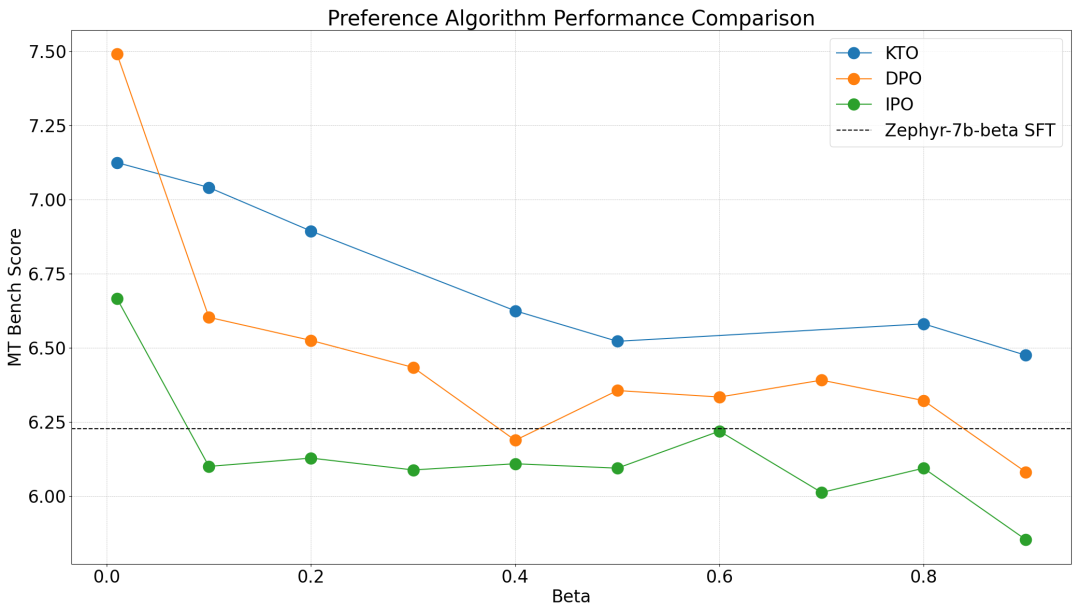

Zephyr-7b-β-SFT

不同 β 取值情况下,Zephyr 模型的在 MT Bench 上的评分。

对于 Zephyr 模型,作者观察到 β 值取 0.01 时,模型性能最佳。这个结论在测试的所有三种算法中都是一致的,一个有趣的后续实验是在 0.0-0.2 范围内进行更细粒度的扫描。虽然 DPO 可以获得最高的 MT Bench 分数,但我们发现 KTO(成对)在除一种超参数情况外的所有设置中都能获得更好的结果。IPO 虽然有更强的理论保证,但在除一种情况外的所有情况下似乎都比基础模式更糟糕。

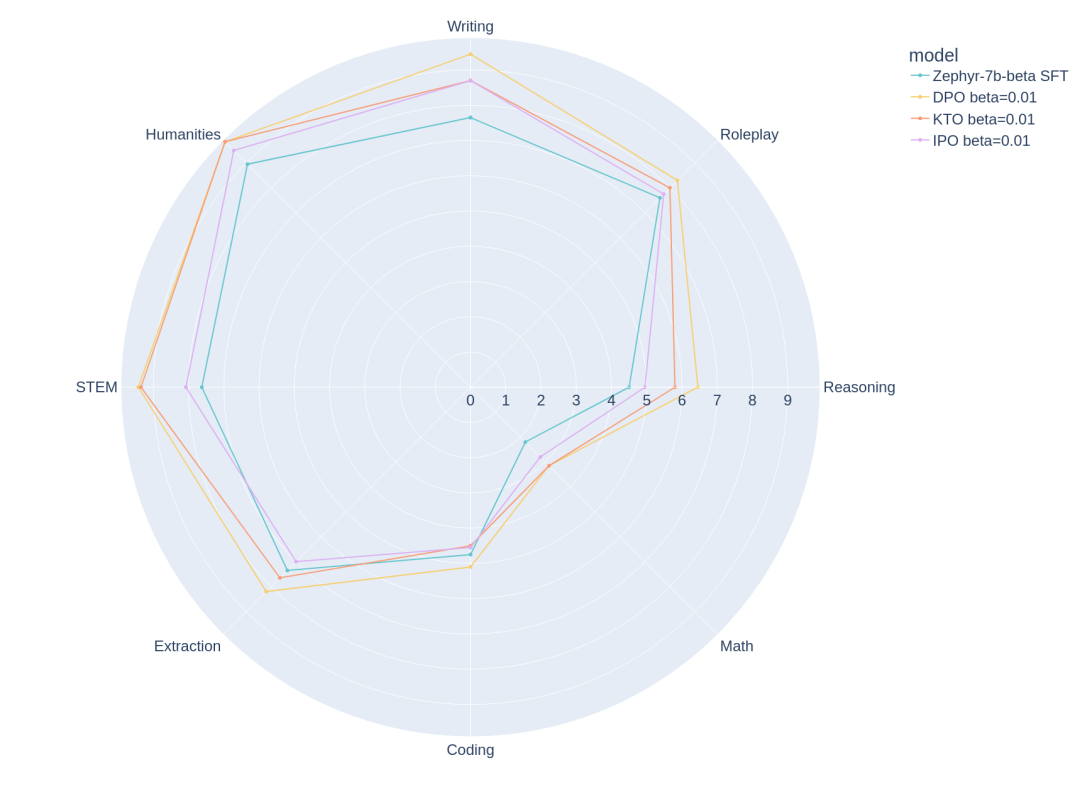

MT Bench 各类别中,每种算法在 Zephyr 模型上的最佳结果。

通过分解 MT bench 评估的各个类别中每个算法的最佳结果,可以确定这些模型的优缺点。可以看到,在推理、编码和数学问题上仍有很大的改进空间。

OpenHermes-7b-2.5

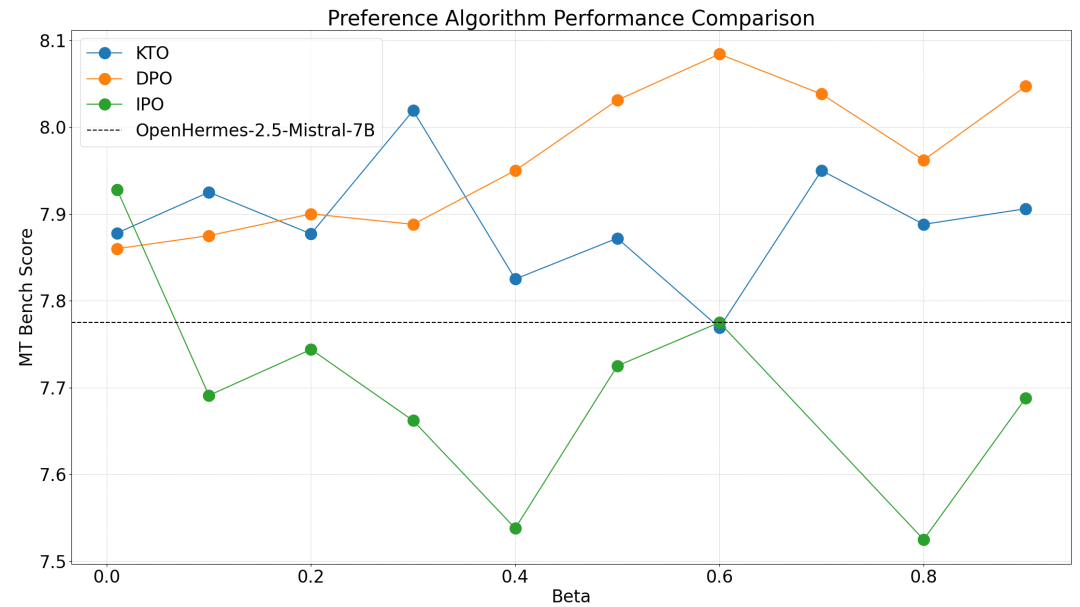

虽然在这个模型上对各算法的观察结果与 OpenHermes 保持一致,即 DPO>KTO>IPO,但 β 的最佳取值点不尽相同。DPO、KTO 和 IPO 的最佳 β 选择分别为 0.6、0.3 和 0.01。

OpenHermes 模型上,不同 β 的 MT Bench 得分。

OpenHermes-7b-2.5 显然是一个更强的基础模型,在人类偏好调整后,MT Bench 得分仅提高了 0.3。

MT Bench 各类别中,三种算法在 OpenHermes 模型上的最佳结果。

在这篇博客中,作者强调了在执行偏好对齐时选择正确的超参数的重要性。通过实验证明了 DPO 在成对偏好设置中优于 KTO,尽管有更强的理论保证,但 IPO 的性能似乎很差。

这些实验结果都是可复现的,代码和配置文件现在都可以在对齐手册中找到。同时还可以看到性能最好的模型及数据集。

作者将继续探索新的人类偏好对齐算法,并评估它们的性能。至少从目前看来,DPO 是最稳健和性能最好的大语言模型对齐算法。KTO 也同样具有发展前景,因为 DPO 和 IPO 都需要成对偏好数据,而 KTO 可以应用于任何含有正负面标签的数据集。

原文链接:https://huggingface.co/blog/pref-tuning?continueFlag=480af4490eaf8a2f4544fe3658589730

文章来自于微信公众号 “机器之心”,作者 “Kashif Rasul 等”

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0