这几天反复看Sora的技术报告,以及各方对Sora的技术分析。

基本三个角度:惊呼强大功能,分析Sora(实现)大法,评估巨大冲击。

冲击方面,主要关注点在于对影视、短视频、娱乐等领域的影响。

但是,Sora改变AI认知方式,开启走向「世界模拟器」的史诗级的漫漫征途,才是未来暴风眼,真正的重点。而世界模拟器,是远比AGI、具身智能、元宇宙更炸裂的智能未来。

Sora技术报告最有价值、最语焉不详、最容易产生不同理解的一句话是:「通过扩大视频生成模型的规模,我们有望构建出能够模拟物理世界的通用模拟器,这无疑是一条极具前景的发展道路」。

而本文所述世界模拟器,与Sora目前自述以及业内理解,可能不太一样。

很显然要么是Sora言过其实,要么是OpenAI留了一手,要么是现阶段技术局限使然。

1. Sora只是二维视觉的压缩扩散和时空表达,不是物理引擎,也不是世界模型

Sora不是英伟达高级科学家Jim Fan所称的数据驱动的物理引擎、一个可学习的模拟器或世界模型,也不会像周鸿祎所言能够让AGI一两年内就很快实现。

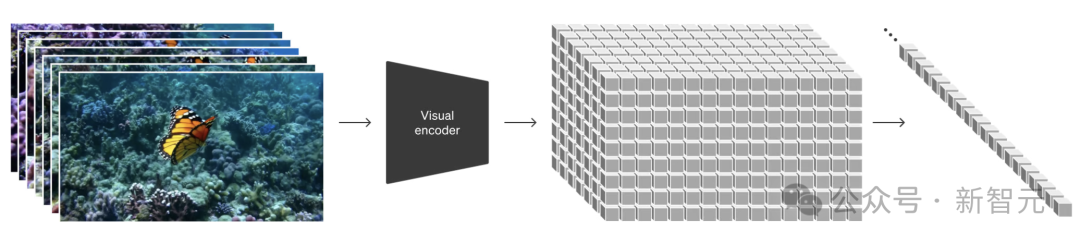

从LLM的文本Token/向量表征,到走向模拟器但还不是模拟器的Patches表达,是原理变化的核心。

技术报告在原理部分高度保留,极为简略,但其中一张图比较重要。Sora基于Transformer但是对Transformer进行了有力进化,结合了Difussion,Patches是关键。

不过Sora怎么看都还只是二维视觉的时空表达,处处压缩,Patches依然是图像内容关系信息,且有文本烙印,并不是物理世界规律的多维表征。世界模拟器前面加个定语——二维视觉世界模拟器,也许更准确。

三维图像是数字世界的空间构建,二维视觉其实是像素的运动变化组合。三维、二维视频都可以看上去像是「物理的」,但实质可以只是运动变化拟合了物理规律,而不是像粒子渲染、工业仿真一样进行了物理规则、内在性状的数字构建。

背后原因,如同你知道大模型输出的答案,知道大模型的计算原理,但是却像神经网络/深度学习之父Geoffrey Hinton和OpenAI前首席科学家Ilya Sutskever一样,其实不知道GPT是怎么「想」的。

Patches所携带的像素、位置、时空信息,以及与周围Patches的变化、运动、关系,在Transform的注意力机制和Difussion的正反向噪声过程,经过大规模视频数据训练,具有了解构和重构一切二维视觉的能力,面向用户表现为涌现式的生成,似乎充满创造力且符合物理规律,但背后其实是Sora「理解」了Patches/像素的变化、运动、位置在时空意义上的关系的数学、算法表征,这些变化和表征又拟合了物理世界的某些合理性。(Patches并非像素)

「理解」即算法,「思考」即模型。

好拗口,好抽象,好累人,但可能这就是事实。

比如,Sora的工程师可能投喂了数千万甚至数亿条视频让大模型来学习,但是可能没有写过哪怕一行与物理性状规则有关的代码。

再比如,Sora可能的确学习了一些3D引擎生成的素材,并且像当初通过DOTA2游戏对战来改进模型一样,引入3D引擎来校正模型生成视频在视觉意义上的物理运动表现,但是百分百可以肯定Sora目前并没有内置3D引擎。

Sora让用户以为它理解了物理世界、物理规律,就像用户头戴苹果Vision Pro的时候以为看到了物理世界,但其实只是在屏幕上看到了携带不断变化的RGB色彩信息的单目3648x3144个像素的各种变化。

甚至图像其实并不是连续的,而是以每秒90-96次的帧率不断刷新,拟合人眼视觉原理,让用户产生视频是连续的错觉。一旦快速甩头,画面就会产生运动模糊。重度游戏玩家甚至能体会到画面撕裂。

视频符合物理规律,不等于视频的生成基于物理规律,更不等于生成视频的大模型本身是数据驱动的物理引擎。所谓物理,可以只是视频画面整体与局部、前后帧统一的像素级的变化规律、表征关系。

在对Sora原理的各种猜测里,华人AI学者谢赛宁的分析最为贴近。但是局限于技术原理的框架性拆解以及对灵活、可扩展性的强调,反倒没有道出Sora的突变实质——大模型认知重启。

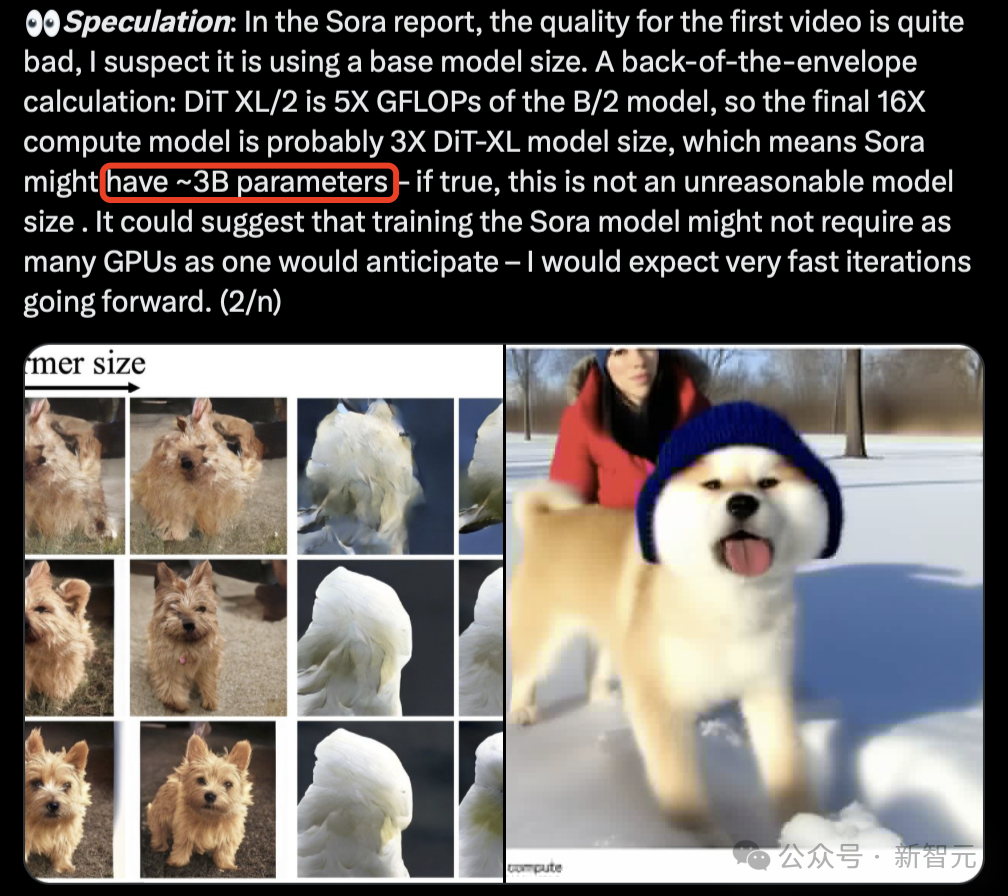

此外,直觉谢赛宁认为Sora目前只有30亿参数的估计也过于保守。

Sora被认为采用了以Transformer为主干的混合扩散模型DIT,其中DIT=VAE编码器+VIT+DDPM+VAE解码器。

此外,Sora还可能使用与Google的Patch n‘Pack(NaVit)类似的技术,以此适应不同分辨率、持续时间和⻓宽比。

尽管在视频标注、将提示词转化为详细说明等方面,Sora充满详实且强烈的文本色彩,但Sora实质上是完全基于视觉、面向视觉、以图像理解世界的大模型。

这一点和过去GPT「文本数据元」(不是神经元)意义上的Token有很大不同,Patches是碎片、补片、基本单元意义上的「视觉信息元」(也不是神经元),Sora里的文本只是人与机器之间、机器与视频之间的「翻译者」、「说明书」。

图像、视频的信息量其实远大于文本,呈现在视觉里的现实世界更是如此。海量视频样本,已经让Sora建立了视觉世界的宏观/微观时空变化的基本动态关系「理解」。

如果将Sora连接到全球各地的机器人、智能汽车、MR头显、智能手机等设备,借助数智之眼,大模型将能够:

Sora出现的最大意义,并非可以生成60秒、多个分镜头、主体统一的视频,而是意味着大模型由此可以「睁开眼睛」看世界,这是不亚于人类认知重启的AI的第一次认知重启,并且这还不是全部。

Sora还不是世界模拟器,但是表现出了这样的潜力。它没有产生终极答案,但是告诉了业者,隐约可行的方向在哪里。

尽管Sora还远不足以成为通用世界模拟器,但是Sora证明Token(1.0)、Patch(2.0)之后,物理世界的X(3.0)表征是可行的。从文本语义、视觉到物理,是大模型原理的三次飞跃,也是走向真正的通用(其实首先基于多领域专业模拟器)世界模拟器的进阶路径。

Sora还不是物理引擎,但是未来可以泛化为物理引擎。

Patch还只是 ((x,y,z), t )、关系、色彩、内容信息意义上的视觉信息元,并不是神经元,但是未来可以进化为数字神经元。Transformer大模型无论如何都不可能具备人脑一般的量子能力,但是高维全局注意力机制局部具备拟合量子态的潜力。

因为AI对智能进行表征的底层逻辑是数学的,相对人脑的直觉、模糊、随机、潜意识等特征,大模型的机械与恍惚同在。但是一如判断准确率从0、30%、50%、80%、90%以上一路走来,原理不断升维,时空不断转换,面向AGI的进化表现为不断接近高可用性、接近乃至超越人类智能的渐进过程。

但AGI不是终点,也不是圣杯,世界模拟器才是。

Sora有助于实现AGI,但Sora开启的漫漫征途的主要指向并不是AGI,而是世界模拟器。AGI的定义有多种,经典意义上的AGI是类GPT在数据、算力、算法进化到一定程度之后,在知识、内容、程序等工作与创作方面,表现出总体达到局部超越人类智能的能力。

AGI依然是工具,能够支持具身智能,但不是具身智能。AGI并不真正具备内生、自主能力,更多时候只是为人所用的工具。

说到这一点,一定有必要厘清智能发展的不同形态和不同阶段,由此才能看清GPT4、Sora、AGI、世界模拟器所处的生态方位和时空节点。

当我们在说智能的时候,其实同时有三种智能。Smart意义上的功能智能,昔日AI意义上的计算感知智能,也就是弱(的)智能(AI1.0),2020年以来(尤其2023年被视为正式开端)认知智能意义上的强智能(AI2.0)。

目前自动驾驶、机器人等智能水准严格意义上讲处于AI1.0也就是弱智能范畴。强智能(AI2.0)对智能汽车、机器人等智能设备的二次赋能,是正在到来的趋势。

这也是尽管国内人工智能发展如火如荼,但实质存在代差的原因。一些受不了此强彼弱的人,大呼「我们也不差」,认为GPT这一波是在制造威胁论。其实无须嘴硬,凡事都要先争个面子。只需实事求是,看清格局,抓住关键,迎头赶上就好。

如何看待Sora/GPT的背后,还有另一个实质:有没有看到战略高地、科技龙头、智能圣杯、变革引擎、暴风眼在哪里。强AI就是战略高地,AI for Science就是科技龙头,AGI就是眼前的智能圣杯,通用与各领域专业模型就是变革引擎,世界模拟器就是未来的暴风眼。

前面说的三种智能都还只是形态水准,并不是对智能发展的阶段区分。我将智能发展相对划分为五个阶段:计算功能智能、计算感知智能、认知智能、内生智能(EI)、自主智能(II)。

请注意,有一天AI人工智能这个提法会边缘化,因为智能不再是「人工」的。人工的AGI自然不是终点,智能将比我们对AGI的预期走得更远。这一点我在《走向第二曲线》有详细分析,此处不再赘述。

智能变革的核心是超级智能,超级智能的具身是AGI,AGI是AI2.0、认知智能的高级形态(但主要还是人工投喂人工增强的智能),AGI是现阶段所言AI的高级形态,但不是EI内生智能和II自主智能。AGI不会像某些人说的一两年內就会实现,但估计也就在GPT6前后。之后的阶段,属于内生智能(EI)、自主智能(II),属于世界模拟器。世界模拟器是EI基石,II基准。

超级智能是世界之脑,超级智能的母体是世界模拟器。世界模拟器是大模型里的母模型,未来科技里的根科技。

看看大模型在工业仿真、环境气候、材料预测、蛋白质分析、分子药物、基因研究等领域已经遍地开花的强力开局,就会知道,Sora与它们正在殊途同归:世界模拟器未来主要不是用来玩的,并不是元宇宙概念的炒资,而是科技生产力爆发点,是智能未来真正的炸裂点。

世界模拟器,科技里的母科技,AI for Science各领域的核心抓手,每个领域的交感、理解、复现、预测,未来世界的「CAE」仿真只是其基础特性之一。世界模拟器,是最接近智能母体的存在。

世界模拟器意味着「原力觉醒」,创新之源,科技驱动,战略高地,不容有失。

Sora放出的所有视频里,最具深度探讨价值的其实是那个水杯倾倒的片段。

Sora是如何拟合现实的,究竟是不是物理引擎,如何才能成为符合物理特性的引擎,未来又如何才能够成为世界模拟器。从中隐约可见答案。

CV发展初期,计算机能做到的只是杯子边缘轮廓特征提取和复现(比如Neocognitron),再后来可以识别到这是一个水杯(比如早期ImageNet),再后来可以「理解」水和杯子的关系(CNN&RNN),现在能够开始学习和复现水杯倾倒过程(Transformer/Sora),接下来会怎么样发展,也许只有大模型技术专家知道,也许都还在探索,并无定论。

我只是站在用户角度进行黑箱式的透析,超级智能接下来能不能够做到这几步?

以上都只是物理角度的简单引申,世界模拟器所需要对应到的科学领域,以及现实世界的复杂现象,甚至是目前数十个主要学科尚未能穷尽的。所以无论从过程还是领域而言,都是征途漫漫。但这才是星辰大海。

相应的几个循序渐进的问题是:

面向世界虚拟器的进化,远不止这些问题,更不只是这些维度……

总的来说,Sora部分拟合了「视觉规律」,但是还没有真的理解「物理世界」。目前的Sora本质上还是在视觉内容世界里,更多与视频、游戏、娱乐等相关。但并不妨碍Sora式的大模型下一步,进入机器人、智能汽车等主要智能设备,以及成为世界模拟器。

AI For Science是世界模拟器的关键落地场景,而AI For Science意义上的X(3.0)是物理世界与视觉世界的分叉点,就像Patch(2.0)是文本世界Token(1.0)与视觉世界的分叉点。

数据、学习、生成、预期是AGI四要素,信息内容感更强。交感、理解、复现、预测,是世界模拟器四要素,母体感知现实具身感更强。世界模拟器的Input和output,实质主要由机器智能系统自主完成,是具有自我强化和自主行为能力的智能。世界模拟器征途漫漫,必将通向EI、II。

态势1:Sora模型并非不可复制。

OpenAI如果短期内不正式推出Sora(快不了)给全球用户,其它竞争对手也会陆续发布自己的类似产品,Patches做法早已有之,并非独门暗器。

OpenAI和Google、Meta之间只有时间差。但是中小团队的数据差、资源差、算力差造成的竞争弱势,只有原理升维才可能弥补。Pika、Runway如果不能在原理层面完成超越,哪怕勉强能够追上Sora未来也是堪忧。另外,原理相似不等于效果相同,差之毫厘谬之千里。

态势2:拚原理>拚算力,模型原理升维才是能力跃迁关键,但算力必不可少且需求继续陡增。

Sora对prompt单次响应与output过程的算力消耗必然远超GPT4.0,但这并不是重点。Sora再一次证明,拚原理的重要性远大于拚算力,算力算什么(而不是算力)才见高下。

原理引起的格局翻覆往往就在一瞬间,今后也是,翻覆还将多次。但算力总体需求依然呈现为爆发式增长,因为要算的不再只是文本/Token,视觉/Patches会令算力需求陡增。

未来物理引擎、世界模拟器对各类传感的接入需要和计算需求,更会令算力吃紧。即使眼前线性地看,高质量海量数据总是优于小体量数据,参数量大总是优于参数量小,模型的深层、多阶段、反复思考总是优于单阶段,高分辨率高精度总是显著优于低精度,所以算力需求依然呈现为指数级增长。但总体而言,算力只是必要条件。

态势3:以Transformer为主干的大模型依然是主要演进方向,且具有巨大潜力。

Self-Attention机制在电子计算的层级模拟了量子态(只是神似),消除了信息元之间的距离限制、消解了CNN的场域阻隔,在量子计算可用之前,是以数学、电子计算为基础的最具脑特征的智能。

态势4:轻与重,大和小,单一与混合,始终是两种并行逻辑。

在计算机视觉模型走向大模型、进而走向世界模拟器的漫漫征途中,视频看上去「合理」的Sora走的是一条更轻的捷径,操控感、立体感、前后扩展自然不够理想。

3D建模、粒子渲染、光线追踪从算力、设备和人工投资来说,又笨又重,但更贴近本质,且操控感更强。就像自动驾驶的两条计算机视觉路线,一个靠CMOS图像数据来算,一个靠雷达来对物理空间进行点云建模。

目前只能说电影工业多了一个选择,倒还没有摧枯拉朽那么夸张。微电影、短视频倒是因此生发出无限可能。

态势5:功能瑕疵问题反倒不是问题,并且越往世界模拟器方向走,视频生成的这些小问题越无关大局。

时间线前后扩展、主体融合过渡、场景置换、连续性、3D运镜、多镜头、汉堡咬痕,这些只是目前的能力,Sora的可用性未来会更加超出预期。

目前存在的左右腿瞬移、多指多趾、人物消失、运动变形、人穿过栅栏等bug多多,但是瑕不掩瑜,而且这些问题随着训练规模增加、模型不断微调优化,必然迎刃而解。

态势6:Sora与Vision Pro的确是一对想象力组合,但是以为戴上头盔就可以念念有词的,一多半可能会失望。

此外,VR在向MR进,AR在向MR退,VR以后只是MR的一个功能,MR是产业科技目前能够到的交叉点,最难突破的AR未来才是主要形态。

态势7:OpenAI本身的4个可能与6个不可能。

可能方面:成为主流AI开发者平台,成为最大Store,形成数十亿用户生态,部分具身智能能力。

不可能方面:7万亿美元造芯,模型原理持续领先,开源开放,纵横整合产业链,成为具身智能/内生智能/自主智能,坚持初创理念不动摇不成为......

尤其7万亿美元AI造芯那条忽悠了不少人的吊诡信息,是WSJ援引所谓消息人士,并不是奥特曼本人,已投Rain股权中的沙特基金在被美帝劝退,还和中东主权基金合计在美投资数万亿美元的大规模芯片制造?绿钱不参与的话,找够相当于美元「风投+IPO」十几年总额的资金做AI芯片,要么是概念吹疯了,要么是常识缺位,要么是算数不会了。更重要的是,制造并不是AI计算突破重点。

态势8:全生态转变已开始,AI是主驱动但不是化学反应全部。

6个要素:感知(交互)、计算(数据)、智能(AI)、连接(网络)、协约(关系)、能量(能源)等。

态势9:变化非线形。

深层玩家不仅着眼算力提升,还在酝酿计算架构之变,变化不会是线性的,有可能业者讨论的未来其实是现在,而不是升维后的未来。下一步模型原理、计算架构包括芯片,都将不断有重大变化。

态势10:AI原力在底层,应用只是需求牵引力。

国内团队适合从应用着手说法没错,但过早定格一觉醒来发现楼塌了不是没有可能,还是需要有人聚焦底层之变,包括硬件底层,硬仗有人打,至少紧跟。

态势11:一定是云端边-大中小-PPP混合AI,如此战场方能展开;但不能只着眼AI,感数算智、软硬协同、形态创新等维度交织才是完整视角,也是价值展开的关键。

如果只是窄化为算力算法意义上的AI,轻量化为场景需求意义上的应用,无异于互联网思维,只可能第一天就卷,只可能是store里的一个GTPs、APPs,就像互联网时代曾经活成了「很厉害」的APP的样子;这是一场原力致胜的立体战役,最需要褪去的就是互联网思维;凡事偷轻,难堪重任;处处求简,难当多面;全生态全体系变革,仅应用不足以催化,仅算力算法数据模型意义上的AI不足以驱动。

态势12:压力陡增。

回到老难题,中美AI之争,李约瑟之问和钱学森之问。说实话GPT3.5、GPT4.0发布之际,压力不那么大,总觉得有得一追,毕竟都还在文本、代码、图片维度。但是Sora一出,压力陡增。升维比想象得快。竞争和发展不是二维、线性的。真正的物理世界模拟器,已经隐约能嗅到味道,且原理隐约可见。这才是AI未来竞争、大模型决胜的炸裂点。

朋友有句话说得好,当年Alpha Go/zero碾压人类围棋之后,事了拂衣去,一年后阿尔法Fold横空处世,重塑了人类对蛋白质结构认知与预测,这才叫伟大工程。Sora也是一样,如果只以为它是60秒视频生成神器,被网络喷子喷成「洋人的奇技淫巧」,无用之用,可以说与业外对早期AlphaGo的「下棋玩具」理解有几分神似。

但如果从大模型睁开眼睛看世界,AI认知重启,以及潜在的世界模拟器发展方向看,这显然是正在觉醒的原力。企业如果忽视趋势,在这一史诗级的漫漫征程中落伍,会被降维打击得连亲妈都认不出来。

AI认知重启,超级智能点亮亿万机器之心,世界虚拟器成为母模型根科技,不是科幻,这是一个时代的序幕。

那么,AI认知已然重启,人类的认知重启了吗?

胡延平,DCCI未来智库创始人,FutureLabs未来实验室首席专家,信息社会50人论坛成员。《全球创新前沿科技地图》及相关研究项目主导,科技畅销书《黑科技》(2017)共同作者与出品人。

历任《互联网周刊》总编、中国互联网协会交流发展中心主任等媒体与NGO职务,持续专注于前沿科技创新探索,角度专注于「从技术看产品,从产品看产业,从产业看生态」。

1997以来出版多部科技专著。《奔腾时代(硅谷)》(1997)作者、《数字蓝皮书》(2000)、《跨越数字鸿沟》、《第二次现代化》、《第四种力量》(2002)著者,《Google将带来什么》(2009)译者之一。

文章来自于微信公众号 “新智元”,作者 “胡延平”

【开源免费】LGM是一个AI建模的项目,它可以将你上传的平面图片,变成一个3D的模型。

项目地址:https://github.com/3DTopia/LGM?tab=readme-ov-file

在线使用:https://replicate.com/camenduru/lgm

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0