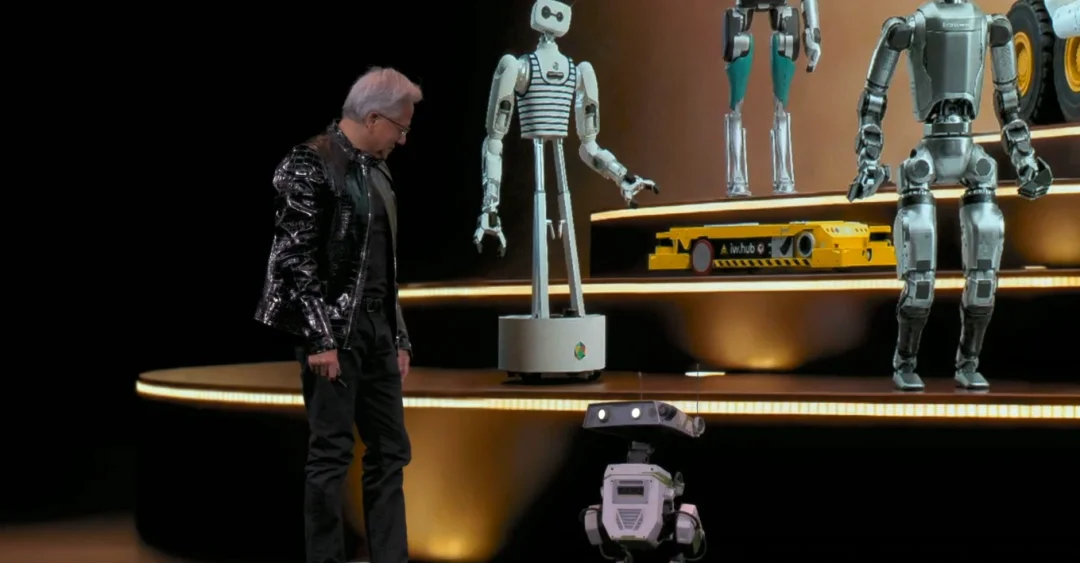

北京时间 1 月 6 日凌晨 5 点多,英伟达创始人兼 CEO 黄仁勋在 CES 2026 发表了主题演讲,演讲核心只有几个字——物理 AI。期间有一页 PPT 暂时没展示出来,他自嘲道演讲场地在拉斯维加斯所以应该是有人中了头奖导致的。期间,他和两台小机器人的互动,成为了本次演讲的名场面之一。

会上最重磅的发布便是 Vera Rubin。黄仁勋以美国天文学家维拉·鲁宾(Vera Rubin)的划时代发现为引,揭晓了下一代 AI 超级计算平台 Vera Rubin。

黄仁勋强调,AI 的发展正面临根本性挑战:模型规模每年增长十倍、推理过程从单次生成演变为多步思考、训练与推理所需算力呈指数级飙升。为突破传统芯片迭代的物理极限,英伟达做出了一个决定性选择,不再进行局部优化,而是对计算基础设施的每一个层级进行彻底的、协同的、系统性的重新发明。

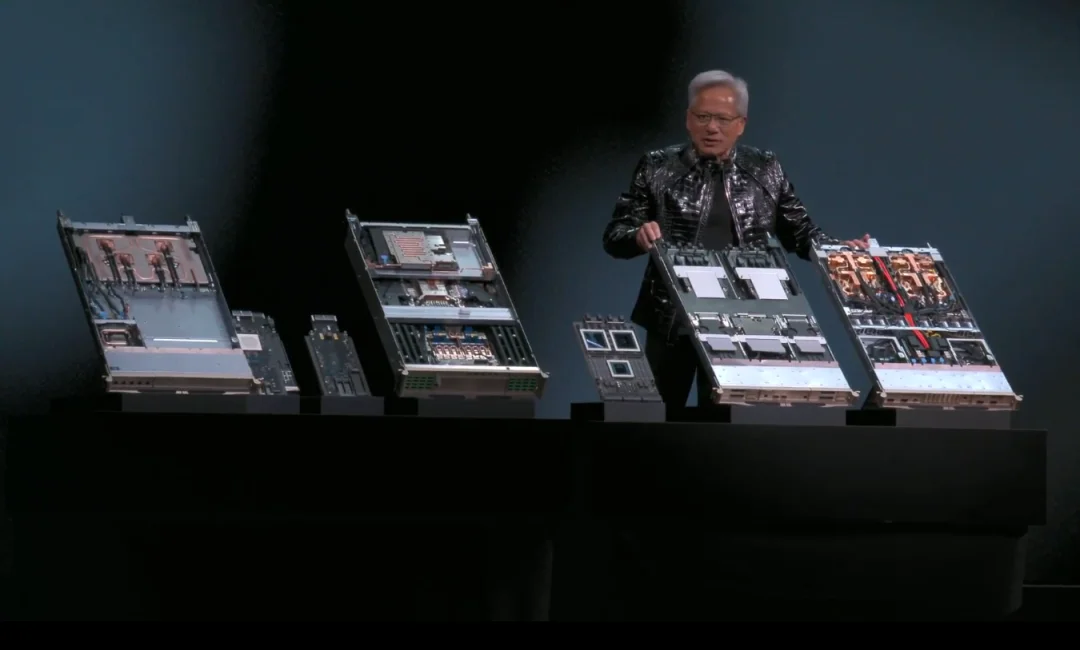

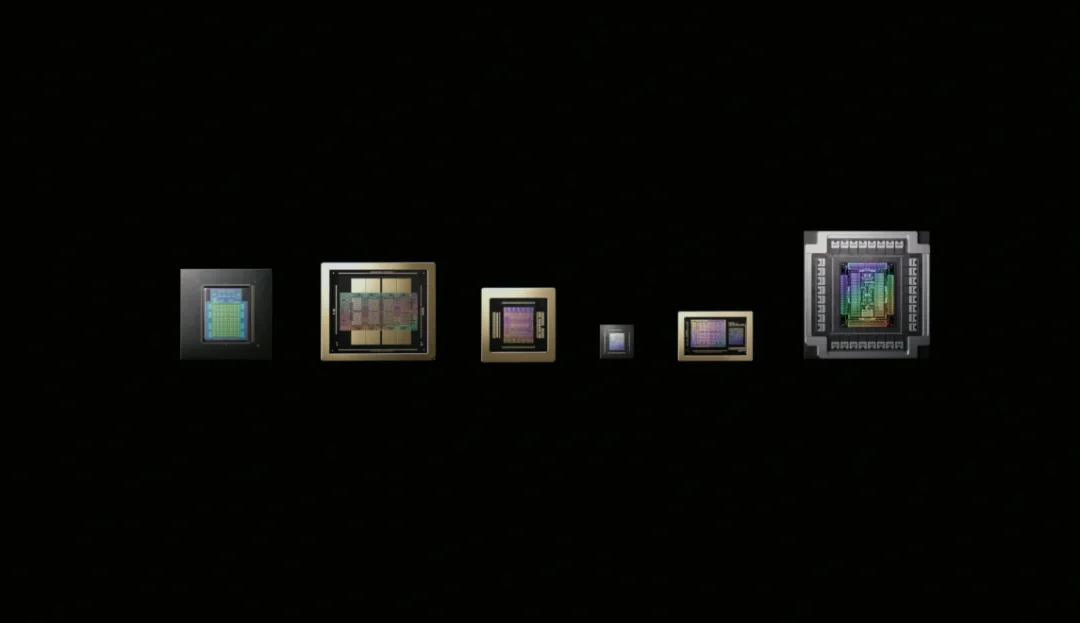

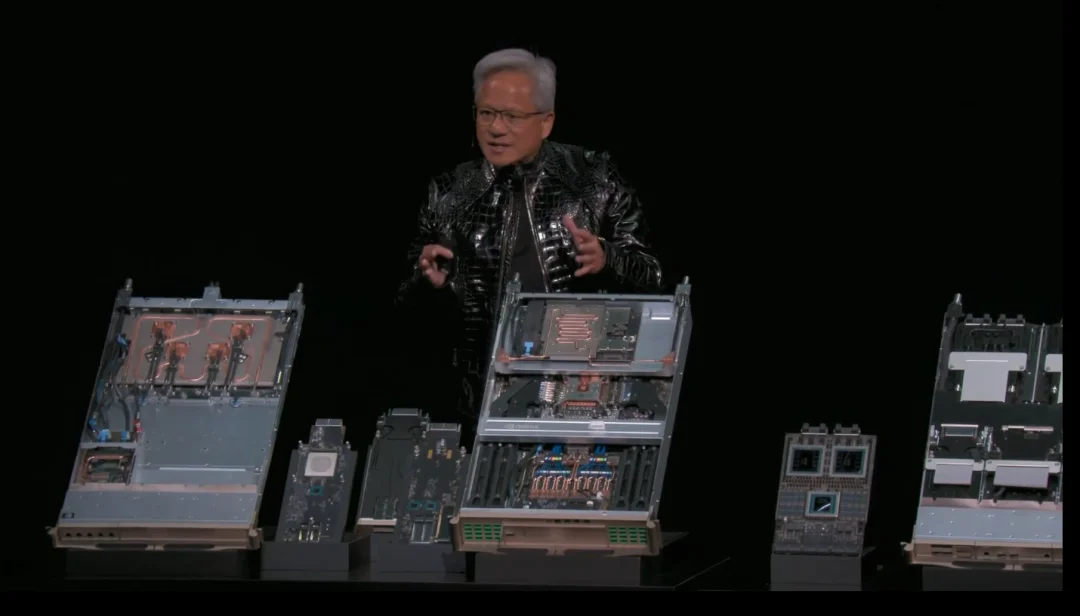

Vera Rubin 平台并非某一芯片的升级,而是一场涉及六大核心芯片的深度协同设计。

第一个是 Vera CPU:这是一款定制设计的服务器级 CPU,采用空间多线程架构,在 88 个物理核心上实现 176 个线程的全性能执行,其 I/O 带宽与能效比相较前代实现翻倍,专为驱动 AI 超级计算负载而优化。

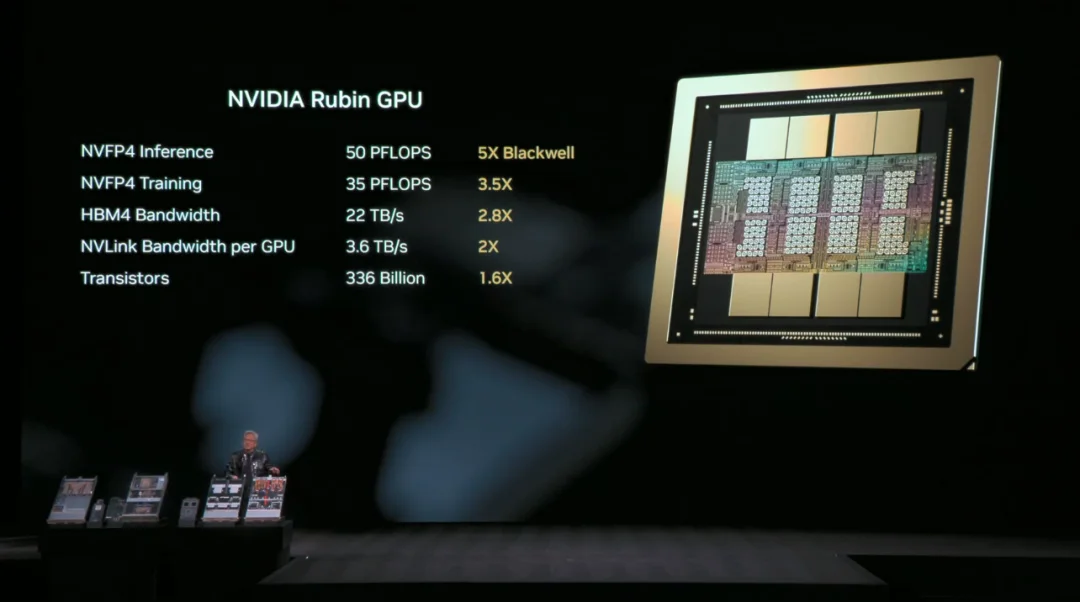

第二个是 Rubin GPU:这是 Vera Rubin 平台的计算核心,其 AI 浮点性能达到上一代 Blackwell GPU 的五倍。引人注目的是,这一性能飞跃是在晶体管数量仅增加 60% 的基础上实现的,其秘密在于 MVFP4 张量核心。该核心是一个具备自主调度能力的处理器单元,能实时分析 Transformer 模型各层的计算特性,动态调整数据精度与计算路径,从而在保证关键计算精度的同时,最大化整体吞吐效率。黄仁勋表示,这一设计有望成为未来 AI 计算芯片的架构标准。

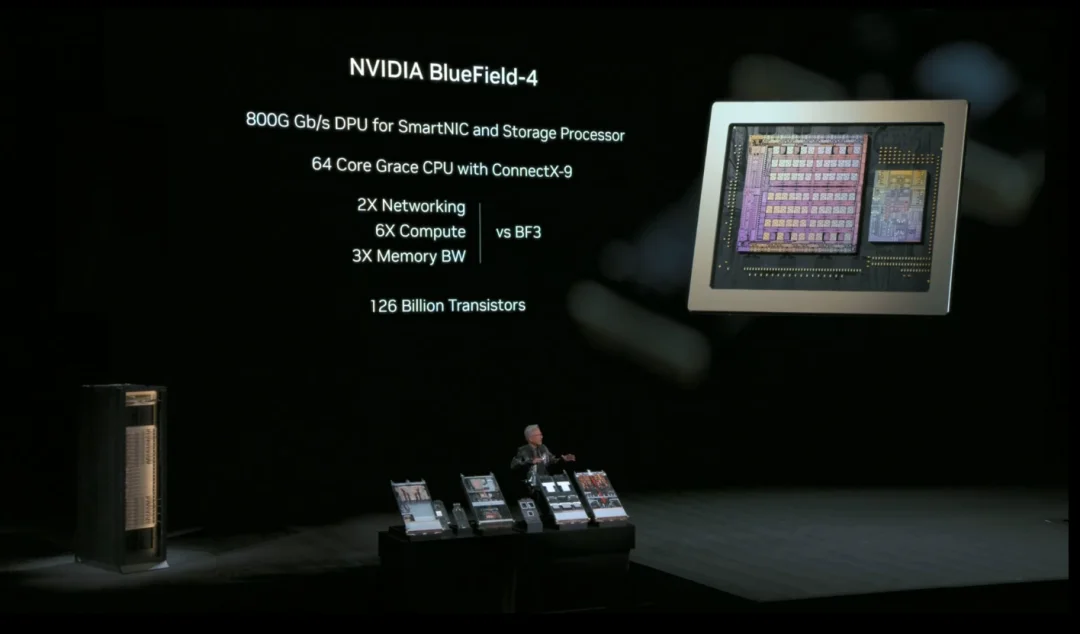

第三个是 BlueField-4 DPU:数据处理单元的里程碑之作。它不仅是卸载网络、存储和安全任务的协处理器,更肩负着革命性的新使命,即管理 AI 的上下文记忆系统。

第四个是 ConnectX-9 智能网卡:与 Vera CPU 协同设计,提供每秒 1.6TB 的超高带宽,并支持可编程的 RDMA 与数据路径加速,允许云服务商和 AI 实验室自定义数据流。

第五个是 Spectrum-X 以太网交换机:黄仁勋表示这是全球首款集成硅光子学(Co-Packaged Optics)的以太网交换机,拥有 512 个 200Gb/s 端口。它并非传统以太网交换机的升级,而是专为 AI 数据中心东西向流量模式设计的 AI 原生网络,解决了 AI 作业突发性、多对多通信带来的延迟与拥塞难题。

第六个是第六代 NVLink 交换机芯片:单个芯片即可提供每秒 400Gb 的交换能力,通过背板上的创新设计,在一个 Vera Rubin 机架内部构建了高达每秒 240TB 的 GPU 间互联带宽,这个数字是全球互联网总截面带宽的两倍以上,确保 144 个 GPU 芯片能如同一个巨型处理器般无缝协作。

据黄仁勋介绍,Vera Rubin 平台的硬件集成度达到了新高度。全新的液冷计算托盘完全摒弃了电缆和软管,所有芯片通过定制基板紧密互联,使系统组装时间从数小时缩短至几分钟。

每个托盘集成了 2 颗 Vera CPU、4 颗 Rubin GPU、1 颗 BlueField-4 DPU 和 8 颗 ConnectX-9 网卡,构成一个 100 PetaFLOPS 的 AI 计算单元。多个托盘通过 NVLink 交换机在机架内构成 Rubin Pod,再通过 Spectrum-X 交换机在数据中心规模横向扩展。

演讲中,黄仁勋花了大量篇幅阐述 AI 推理的独特挑战,即不断增长的上下文记忆。随着模型支持更长的对话、存储更多的临时知识,传统的 GPU 高带宽内存已无法容纳。

Vera Rubin 的解决方案是:在每个机架内,通过四颗 BlueField-4 DPU 直接管理一个高达 150TB 的共享、持久、高速的上下文内存池。该内存池通过超低延迟的机架内网络(与 GPU 互联同技术)与所有 GPU 直连,可以动态地为每个 GPU 分配高达 16TB 的专用上下文空间。这相当于为每个 GPU 配备了一个容量扩大 16 倍、且速度远超传统网络存储的外部大脑,彻底解决了长上下文 AI 应用的核心瓶颈。

尽管性能飙升,Vera Rubin 平台坚持使用 45 摄氏度温水冷却,无需能耗巨大的冷水机组,这一设计预计能为全球数据中心节省约 6% 的总电力消耗。Vera Rubin 平台还首次实现了全路径硬件加密的机密计算,从 GPU 到 GPU,从 CPU 到 DPU,所有内部总线数据均被加密,为多租户 AI 云服务提供了芯片级的安全隔离。

此外,系统级的动态功率平滑技术能够有效吸纳 AI 计算中特有的瞬时功率尖峰,允许数据中心以更接近平均功耗的容量进行供电配置,避免了巨额的基础设施过度投资。

黄仁勋用三组数据总结了 Vera Rubin 的商业价值:

首先是研发速度:训练一个 10 万亿参数规模的下一代前沿大模型,所需集群规模仅为使用 Blackwell 系统的四分之一,极大加速了从研究到产品的迭代周期。

其次是基础设施效率:在同等功耗和空间下,一个 Vera Rubin 数据中心的 AI 计算吞吐量预计将达到基于 Hopper 架构数据中心的约 100 倍,直接转化为惊人的营收能力提升。

再次是推理成本:大规模 AI 服务的 token 生成成本,预计将降至当前水平的约十分之一,为 AI 服务的普及和商业化扫清了关键障碍。

此次发布标志着英伟达的战略定位已从领先的 AI 芯片供应商演变为 AI 时代全栈计算基础设施的定义者和提供者。黄仁勋强调,英伟达的使命是构建从硅光子、芯片、系统、软件到开发工具的完整堆栈,从而让全球每一个开发者都能拥有探索 AI 下一个前沿的能力。

事实上,黄仁勋在此次演讲中将 Vera Rubin 平台的发布留在了末尾,而他在前面的演讲也很值得关注。

黄仁勋开篇即指出,计算机产业每 10 至 15 年经历一次平台重置,从大型机到 PC,再到互联网、云和移动。但当前这次变革截然不同:“这次有两个同时发生的平台转移。”其核心是计算范式的根本性转变。

他表示:“你不再编程软件,而是训练软件;你不在 CPU 上运行它,而是在 GPU 上运行它。”应用程序不再只是预编译和回放,而是能够理解上下文,并根据意图实时生成每一个像素、每一个 token。这意味着价值数十万亿美元的传统计算堆栈正在被加速计算和 AI 现代化改造。每年数千亿美元的风险投资和全球企业研发预算的显著部分,正从传统方法转向 AI。

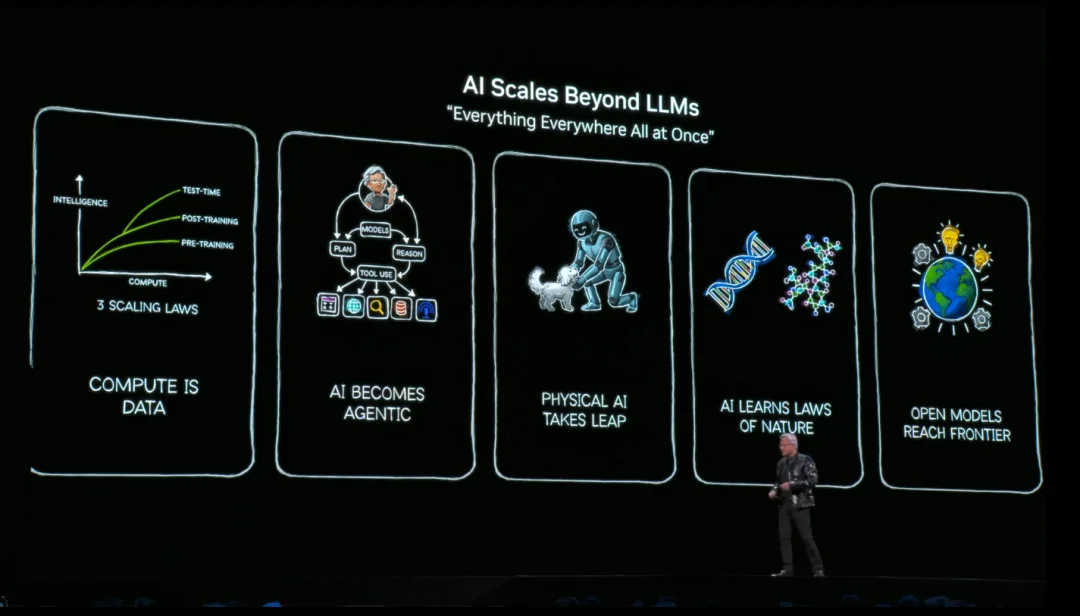

黄仁勋将未来 AI 应用的核心框架定义为智能体。它不再是单一的对话模型,而是一个具备推理、研究、使用工具、规划能力的多模态、多模型协同系统。他以开源代码助手 Cursor 和 AI 搜索引擎 Perplexity 为例,说明智能体如何通过组合不同模型包括专有前沿模型和本地定制模型和工具,来解决前所未有的复杂问题。

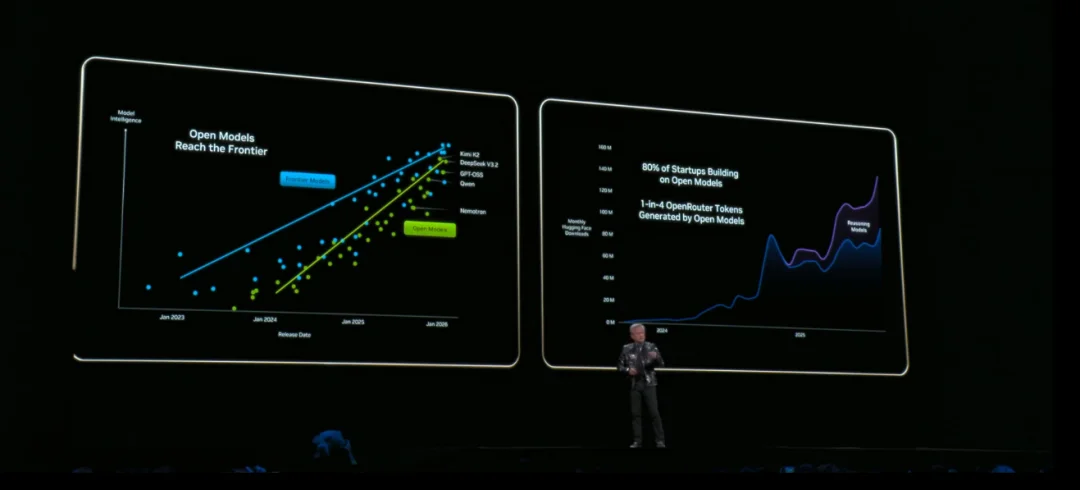

他强调,开放模型的兴起是去年 AI 领域最重大的进展之一。以 DeepSeek R1 等为代表的开源模型,虽然目前比前沿专有模型可能落后约六个月,但其快速发展激活了全球 AI 界。开放模型降低了参与 AI 革命的门槛,使初创公司、大型企业、研究机构乃至各个国家都能基于此构建自己的 AI 解决方案。

英伟达自身也在通过 DGX Cloud 超级计算集群,在蛋白质结构预测(OpenFold)、气候气象(ForecastNet)、世界模型(Cosmos)、机器人(GR00T)等多个前沿领域,构建和开源其前沿AI 模型。黄仁勋表示,英伟达不仅开源模型,还开源用于训练的数据集和全套工具链(Nemo 系列库),旨在让每个公司、每个行业、每个国家都能成为这场 AI 革命的一部分。

如前所述,物理 AI 是本次演讲的主题词,它指的是让 AI 理解并安全地与物理世界互动。黄仁勋宣布,这是英伟达耕耘八年的领域,其核心支柱是三台计算机架构:用于训练的 AI 超级计算机、用于部署的边缘推理计算机,以及用于合成数据生成和仿真的数字孪生计算机。

演讲中,他发布了英伟达的开放世界基础模型 Cosmos。它通过海量视频、真实驾驶数据和 3D 仿真进行预训练,能理解物理定律、生成逼真且物理合理的视频、进行轨迹预测和推理。黄仁勋称其为将计算转化为数据的关键,可用于解决自动驾驶等场景中难以穷尽的长尾问题。

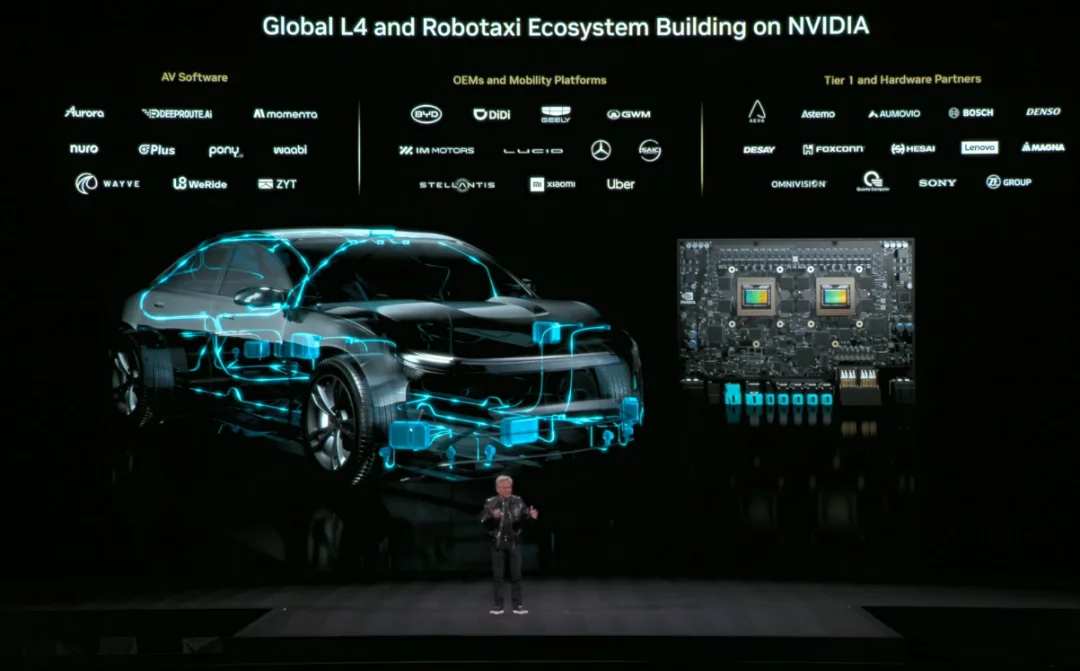

基于此,英伟达推出了其首个端到端训练的自动驾驶 AI 系统——Alpha Maye。它不仅从传感器输入直接控制车辆,还能解释其决策的理由和即将采取的行动轨迹。该系统融合了人类示范数据与 Cosmos 生成的海量合成数据。

黄仁勋宣布,首款搭载该系统的梅赛德斯-奔驰 CLA 车型(刚获 NCAP 最高安全评级)将于 2026 年一季度在美国上路,并陆续推向全球市场。他强调,该解决方案从芯片(如下一代 DRIVE Thor)、软件栈到安全系统均为英伟达与奔驰深度合作开发,并同时向更广泛的汽车行业生态系统开放。

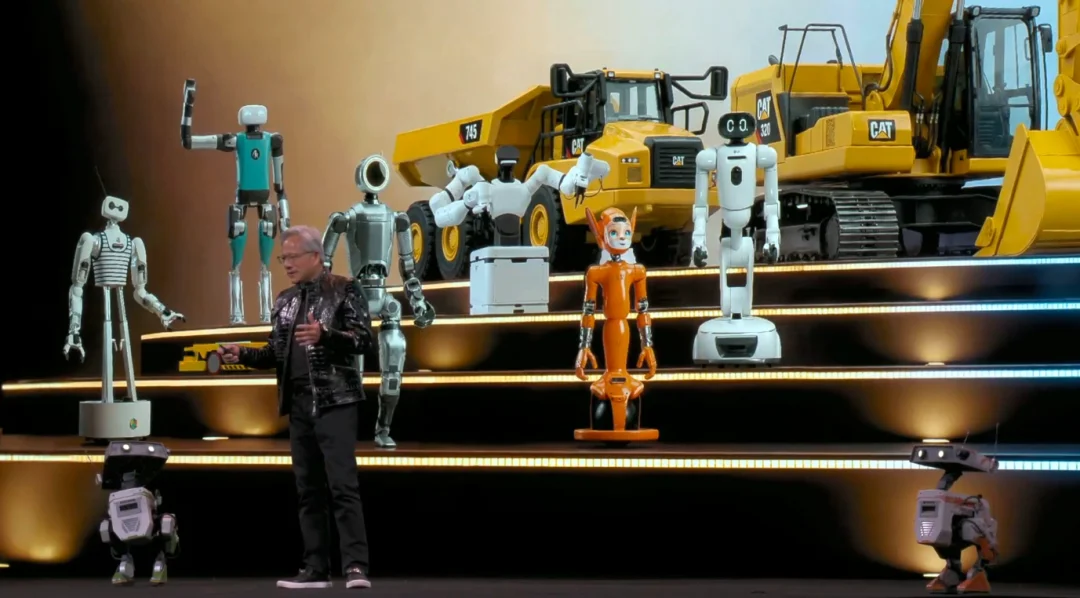

他断言,未来十年,自动驾驶的转折点已经到来,这将是第一个大规模的主流物理 AI 市场。而三个计算机架构和仿真技术,正推动更广泛的机器人革命。现场亮相的多款机器人合作伙伴产品也预示着,从物流机器人到人形机器人,一个庞大的新产业正在成型。

他同时宣布,英伟达的 CUDA-X 加速库、物理 AI、智能体模型正深度集成到 Cadence、Synopsys 和西门子等行业巨头的 EDA(电子设计自动化)、CAE(计算机辅助工程)和数字孪生平台中。

这意味着,未来的芯片和工厂将在虚拟世界中由 AI 辅助设计和优化,并由机器人自动化生产。黄仁勋对现场的机器人说道:“你们(指机器人)将在这些平台内被设计、被制造、被测试。”这标志着 AI 技术完成了一个循环:从由芯片产业孕育,到如今以更强大的能力,反过来彻底革新芯片设计与高端制造本身。

莎士比亚在戏剧《暴风雨》中说道:“凡是过去,皆为序章(What's past is prologue.)。”黄仁勋的演讲也表明了 AI 仍然正在引发一场覆盖所有层级的计算革命,也说明黄仁勋意图带领英伟达用物理 AI 来开辟新的天地。

参考资料:

https://www.nvidia.cn/events/ces/

文章来自于微信公众号 “DeepTech深科技”,作者 “DeepTech深科技”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/