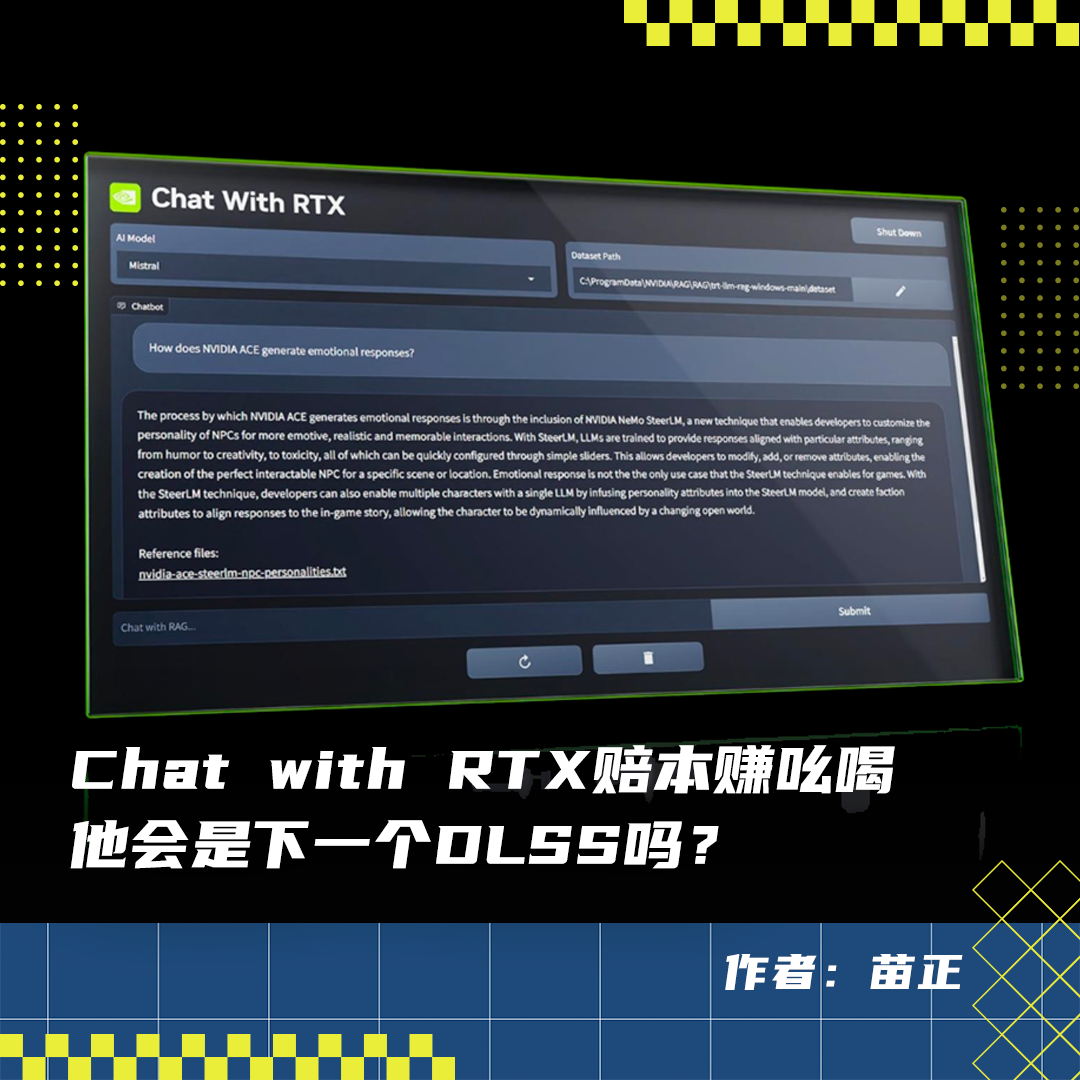

英伟达在2024年2月14号的时候推出了这么一个产品,叫做Chat with RTX。顾名思义,就是和英伟达的显卡聊天。简单来说Chat with RTX是一个本地部署的大语言模型工具,可以实现和大语言模型对话,还支持处理多种文件类型,用户可以与其进行文本、PDF、Word文档等多种格式内容的交互。

体验了一下,无论模型选择Mistral还是Llama 2,中文的交互都不太顺畅,倒是英文的表现还说得过去。Chat with RTX的确展现了相当出色的资料索引能力,能读懂绝大多数英文的资料。可是到看视频的部分,除了英伟达自己发布的一些视频外,Chat with RTX几乎没办法完全看懂任何一部视频。一开始我以为是跟显卡有关,我的显卡是3080,性能远不如现在的卡皇4090。但是当看到一位使用4090显卡的用户也有相同的吐槽后,我一下子就释怀了。

int4量化

可以看到,出现在Chat with RTX里的,并不是我们记忆里的Llama 2和Mistral,而是这两个模型后面还带着一行“小尾巴”,上面写着INT4。这个INTX代表的是量化级别,因为大语言模型需要在内存和显存里运行,所以当部署到本地的时候,考虑到个人电脑性能远不如服务器,所以需要量化来为模型继续拧“瘦身”。INT8量化是使用8位有符号整数来近似原本32位浮点数(FP32)的权重和激活值,其数值范围是-128至127。INT4量化是进一步压缩到4位整数,这意味着更少的数据存储空间,但数值范围仅为-8至7或0至15。INT4量化会带来更大程度的精度损失,因为它所能表达的数值更有限,可能导致更多的信息丢失,特别是在需要较高精度的任务中。

Chat with RTX最大的意义是它能真正意义上实现全程无联网,所有计算资源、资料库全部来自于本地数据。对于大语言模型而言,能实现到这种程度是非常难的。市面上几乎所有号称本地部署的模型,本质上并不能脱离联网状态,尤其是手机上的大语言模型。

这些模型的做法是把预处理和后处理这两个部分放到手机里,而训练和推理这些消耗资源比较大的部分放到云端来进行。我们讲大模型的整个运行过程都是要放在内存里来跑的,其中一个很重要的原因是大语言模型它是连续分布的,模型在内存中以连续的一块内存区域存放,确保了向量和矩阵操作的连续性和并行计算的可行性。

以个人电脑的硬件水平,如果不做特殊处理是根本不可能实现的,也就意味着它不可能完全将大语言模型本地部署,最低限度也要将训练和推理这两个消耗比较大的部分搬到网上。

Chat with RTX能把所有的部分全都在本地完成,而且整个运行过程中我没有感受到电脑丝毫的卡顿,响应速度也比ChatGPT、Gemini要快。

英伟达他是一个游戏公司啊。免费推出Chat with RTX的本意跟所有游戏厂商放出游戏demo的性质是一模一样的。比如就在Chat with RTX发布的前几天,科乐美发布的免费游戏《寂静岭:短信》,这个游戏一共两个小时流程,没有任何内购内容。难道科乐美买卖不干了,以后就指着发布免费游戏过瘾?并不是这样的,他是为了日后推出的《寂静岭》系列重置版打广告,赔本赚吆喝。

不过当你把Chat with RTX给拆开来就会发现,里面没有新技术,像是RTX加速、RAG,早就已经出现了。英伟推出这个产品最大的作用是打广告,尤其是Chat with RTX里面TensorRT这样的技术,此前只出现在H100、H200这种规格的GPU上,我们老百姓使用的30系列40系列显卡根本没有。而Chat with RTX则是完美地将这个技术呈现到了消费者层面。

但是要注意,Chat with RTX里面的TensorRT也好,RAG也好,想要调用他们几位大哥,都需要对应的权限。虽然我们硅星人是人工智能的媒体,不过我这里还需要先补充一些硬件知识,以便下文做铺垫。在计算机里,应用程序通常是不直接调用硬件资源的,而是通过系统API向操作系统申请使用硬件资源。比如我打游戏,计算机需要把游戏画面展示给我看,可应用程序并不会直接读写显卡内存,而是调用图形API如DirectX或OpenGL,由它们将指令转化为显卡可以理解并执行的操作。

而且不同软件对硬件资源的访问权限。这是由于系统为了保护系统的稳定性和安全性,不是所有软件都能随意访问任意硬件设备。只有经过授权或认证的软件才能获得必要的权限,比如管理员权限才能安装新的驱动程序或者访问敏感硬件。那么换句话说,如果今后所有开发者需要这些技术,就必须要和英伟达共同开发,变相地形成了裙带关系。而英伟达本身则可以利用这种局面,形成对人工智能软件市场的垄断。

基于RTX显卡的技术可以大幅度加快大语言模型的运行速度,以实现脱网运行。根据英伟达官网给出的信息,英伟达50系列搭载了第四代张量核心,人工智能领域的计算性能是上一代的4倍。还支持FP8精度数据类型的加速,并提供独立的浮点和整数数据路径,以加速混合浮点和整数计算的执行。有了它,Chat with RTX的性能肯定会大幅度增加。

那么与之相对的,开发者就更要打点好和英伟达的关系。这其中就存在一个裹挟的问题,经常玩游戏的朋友肯定清楚英伟达DLSS的故事。2018年,随着RTX系列显卡的发布,英伟达推出了第一代DLSS技术。这一技术的核心思想是通过训练一个神经网络模型来预测高分辨率图像,从而替代传统的超级采样方法。相较于DLSS,传统超级采样需要对每个像素进行多次渲染以减少锯齿并提高画面质量,但计算量巨大,非常消耗GPU资源。

就拿那时候最火的游戏《赛博朋克2077》来说,采用3060Ti显卡,开启DLSS后画面能来到75FPS,关闭后连60FPS都够呛。那么好,接下来几乎所有大作都必须得使用DLSS,除了像《荒野大镖客2》这种索尼限时独占的游戏外,不走DLSS几乎没办法达到预期的画面表现力。

Chat with RTX的出现,其实也是一种预示,预示英伟达将在大模型领域开启新的敛财模式,即贩卖开发套件。你开发商不买我的开发套件没问题,但是你没权限调用我的张量核心,你大模型没办法在离线跑起来,就这么简单。对消费者和企业大客户,你必须使用英伟达新的GPU产品才能满足人工智能领域的新需求;对开发者,你必须购买英伟达的人工智能开发套件才有权限调用。大模型成为了英伟达的聚宝盆。

文章来自于微信公众号 “硅星人Pro”,作者 “苗正”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI