我在 iPhone 17 Pro Max 上跑 AI 模型,体验了一把十年前「越狱」的快乐

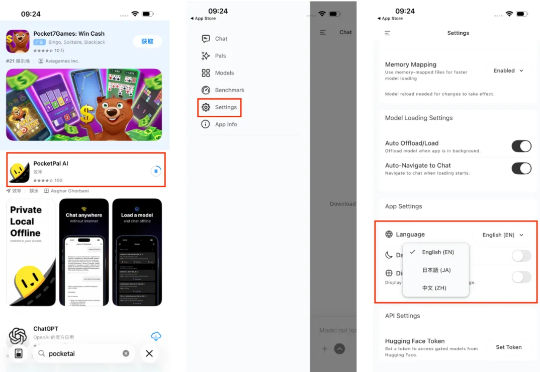

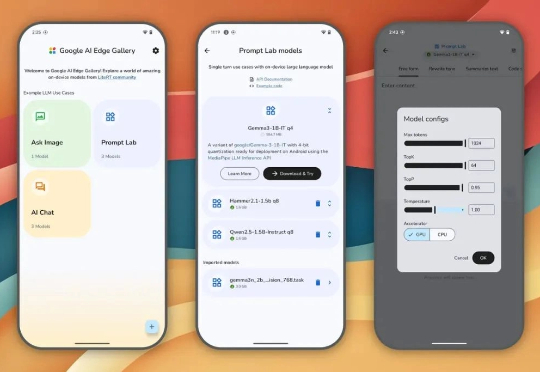

我在 iPhone 17 Pro Max 上跑 AI 模型,体验了一把十年前「越狱」的快乐在 iPhone 上部署端侧 AI 模型,成了互联网的新显学。在 iPhone 上体验端侧模型,门槛其实不算高。打开 App Store,搜索 PocketPal AI,下载安装。如果不习惯英文界面,可以在设置 (Setting) 里找到语言 (Language) 选项,切换成中文。

在 iPhone 上部署端侧 AI 模型,成了互联网的新显学。在 iPhone 上体验端侧模型,门槛其实不算高。打开 App Store,搜索 PocketPal AI,下载安装。如果不习惯英文界面,可以在设置 (Setting) 里找到语言 (Language) 选项,切换成中文。

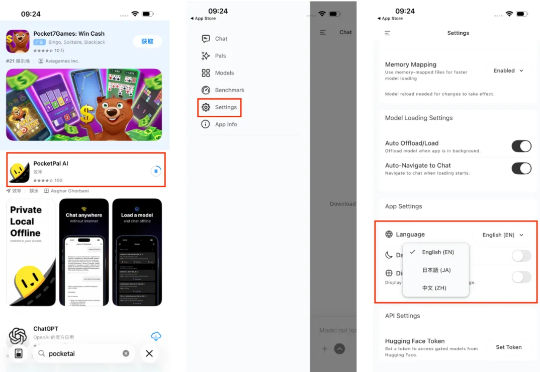

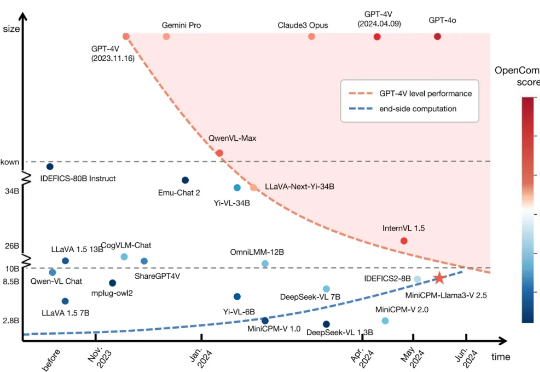

刚刚,面壁智能再放大招——MiniCPM-V 4.5多模态端侧模型横空出世:8B参数,越级反超72B巨无霸,图片、视频、OCR同级全线SOTA!不仅跑得快、看得清,还能真正落地到车机、机器人等。这一次,它不只是升级,而是刷新了端侧AI的高度。

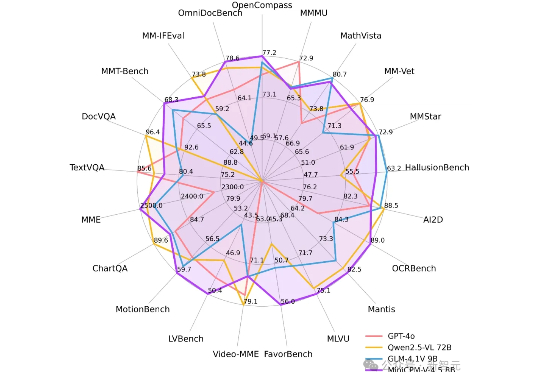

三天不开源,Qwen团队手就痒。 昨天深夜再次放出两个端侧模型: Qwen3-4B-Instruct-2507:非推理模型,大幅提升通用能力 Qwen3-4B-Thinking-2507:高级推理模型,专为专家级任务设计

7 月 1 日,国际顶级学术期刊《Nature》旗下子刊《Nature Communications》正式刊登了来自清华、面壁等研究团队联合研发的高效端侧多模态大模型MiniCPM-V 核心研究成果。

移动端侧模型迎来“新王”。

今年苹果在 AI 上宣布的诸多所谓新功能,例如实时翻译、快捷指令等,并无太多革命性;至于视觉智能 (visual intelligence),不仅功能落后 Google Lens 六七年,交互体验上也远未达到一众 Android 友商的内置 AI/Agent 产品在 2025 上半年水平。

今年的苹果,到底有没有新活?

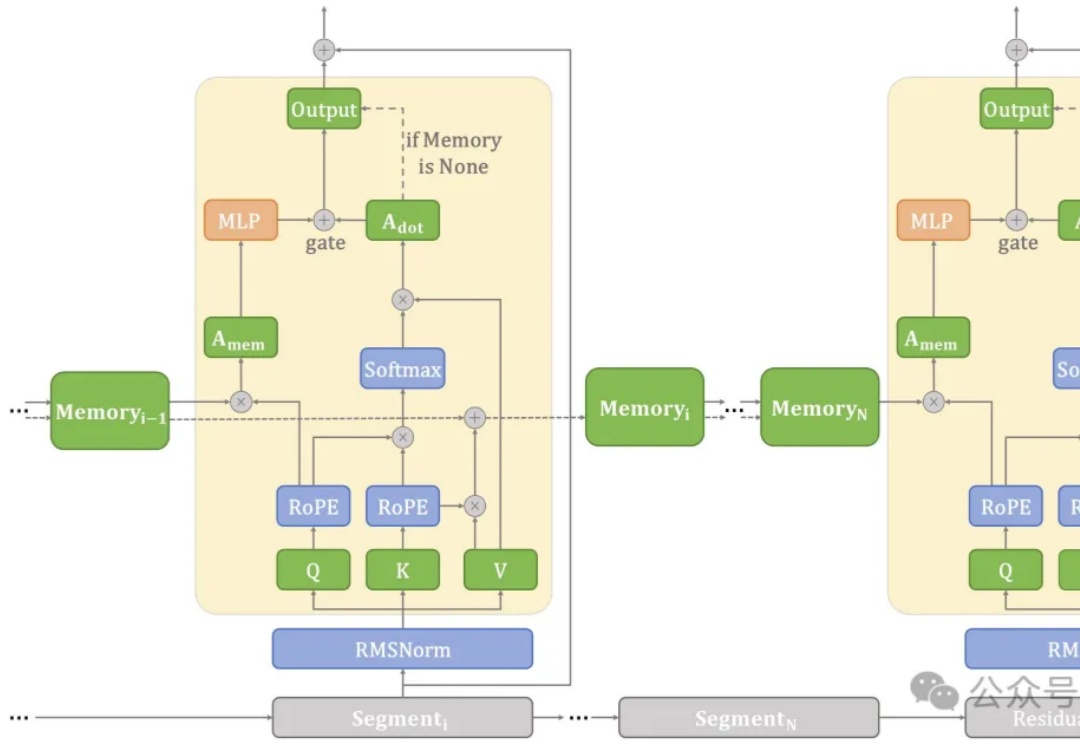

在端侧设备上处理长文本常常面临计算和内存瓶颈。

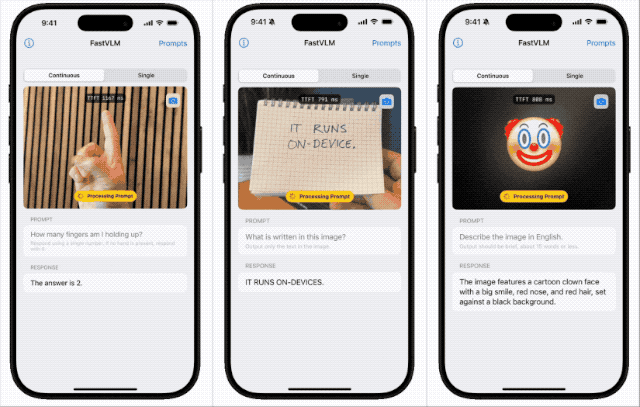

苹果近期开源本地端侧视觉语言模型FastVLM,支持iPhone等设备本地运行,具备快速响应、低延迟和多设备适配特性。该模型依托自研框架MLX和视觉架构FastViT-HD,通过算法优化实现高效推理,或为未来智能眼镜等新硬件铺路,体现苹果将AI深度嵌入系统底层的战略布局。

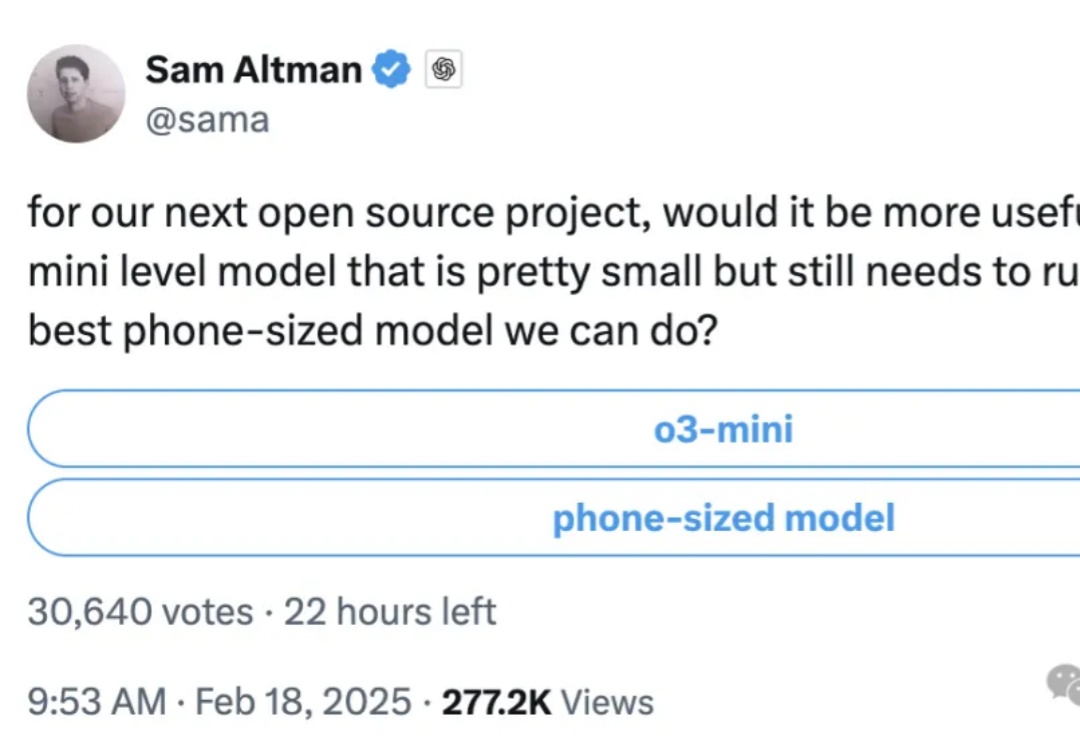

就在刚刚,奥特曼发了个推特,轻描淡写透露了个大消息: For our next open source project……