微软亚洲研究院推出的最新成果bGPT,这种基于字节的Transformer模型,为我们探索数字世界开辟了新的大门。

与传统的基于词表的语言模型不同,bGPT的独特之处在于其对原始二进制数据的直接处理能力,不受特定格式或任务的限制,其目标是全面模拟数字世界。

论文:https://arxiv.org/abs/2402.19155

代码:https://github.com/sanderwood/bgpt

模型:https://huggingface.co/sander-wood/bgpt

项目主页:https://byte-gpt.github.io

研究团队在其论文中展示了bGPT在建模上的巨大潜力,通过字节级处理,bGPT不仅能生成文本、图像和音频,还能模拟计算机行为——从格式转换算法到CPU状态的建模。将所有数据视为字节序列的做法,使bGPT能够将不同类型的数据纳入同一框架之下。

bGPT的论文一经发布,便在X(Twitter)上引发了广泛的关注和讨论,标志着深度学习范式转变的可能性,使得模型能够真正理解并模拟数字世界中的各种活动。

二进制数据是数字世界的基础,从计算机处理器到我们日常使用的电子产品的操作系统,构成了所有数据、设备和软件的核心。bGPT正是从这一点出发,旨在通过学习二进制数据序列来掌握数字系统的内部逻辑,以此来重建和模拟复杂的数字现象。

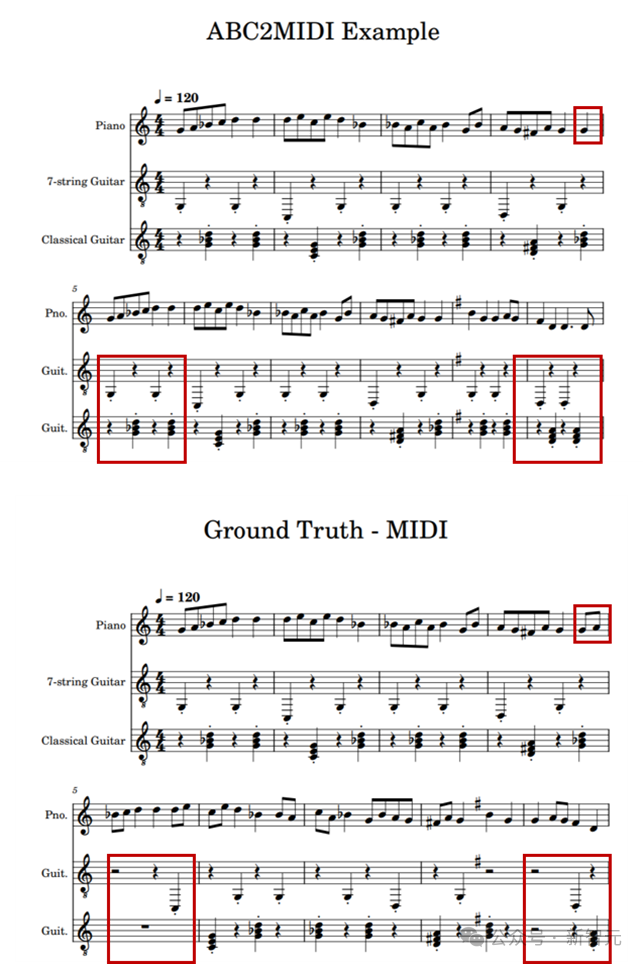

bGPT通过字节级的处理,不仅能应用于常规的AI生成和理解任务,还能处理更多的非传统应用。例如,它能直接模拟MIDI——一种音乐传输和存储的标准格式,这在之前的研究中由于MIDI的二进制本质而避免了直接建模。

但bGPT天生适合此类任务,能够精确模拟音乐数据的转换算法,将ABC记谱法转换为MIDI格式时,达到极低的错误率(0.0011 BPB)。

在实际应用中,bGPT通常能够准确地完成ABC符号与MIDI文件之间的转换,有时甚至能纠正原始文件中的错误,使音乐转换更加准确。

bGPT自动将ABC记谱法转换成MIDI格式(上图)与原MIDI数据(下图)的对比,凸显了关键的差异:虽然原MIDI数据中漏掉了一拍(见下图),导致和弦伴奏断开,但由bGPT转换的结果(见上图)正确填补了这一缺失,确保了和弦伴奏的流畅性。

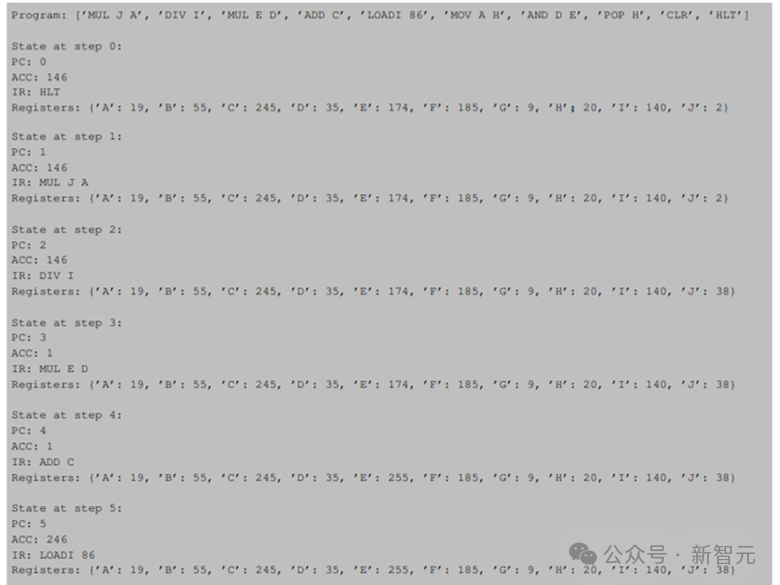

研究团队还将CPU建模作为硬件行为模拟的代表性任务:该任务要求模型接收低级机器指令序列作为输入,其目标是准确预测每个指令执行后CPU状态如何更新,直至程序停止。

在这个任务中,bGPT展现出超过99.99%的准确率,显示了字节模型在处理原生二进制数据方面的强大能力和可扩展性。

在提供了程序和初始CPU状态的情况下,bGPT能够准确地预测CPU执行的完整过程,直到程序终止。在这个示例中,bGPT精确地处理了所有CPU指令。为了便于理解,这里将实际的字节序列转换成了更易读的格式。

bGPT不仅能处理原生二进制数据,还能将多种数据类型融合进一个统一的模型架构中,视一切数据为字节序列。

这种方法不但简化了数据建模流程,还使得从任何数据源的整合变得轻而易举,且无需为特定数据类型定制模型。

研究团队在论文中举例了传统文本、图像及音频文件,展现了bGPT在统一数据建模方面的能力。他们训练的bGPT模型拥有约1亿参数。

实验结果表明,在与GPT-2(文本模型)、ViT(视觉模型)和AST(音频模型)等同规模模型的比较中,bGPT在不同数据类型上均展现出了可媲美的性能。

bGPT在文本生成方面的表现非常出色。得益于其字节级的文本编码,该模型无需依赖词汇表,从而能支持所有语言。

它的分层Transformer架构,尽管计算开销与GPT-2相近,却能生成长达8KB的文本,大大超出了GPT-2的长度限制。在经过Wikipedia数据进行预训练后,bGPT生成的文本在风格和主题上都与GPT-2不相上下,证明了其在文本生成方面的强大能力。

bGPT在Wikipedia数据集上进行预训练,生成的文本样例质量和主题一致性与GPT-2相当。

bGPT可以通过预测图像字节序列中的下一个字节来生成图像。该模型在ImageNet数据集上进行了预训练,生成的图像分辨率为32x32像素。

虽然在当前规模下,通过字节序列准确捕捉图像的二维空间关系有所困难,导致生成的图像存在伪影和噪点,但纹理和光影效果通常还是比较准确的。

此外,这些生成的图像均能被正常解码为BMP文件。研究团队指出,通过扩大bGPT的规模,类似于OpenAI开发的iGPT在像素序列建模方面的方法,或许可以实现更高质量、更逼真的图像生成。

这些是由在ImageNet数据集上进行预训练的bGPT生成的一组图像。虽然图像的纹理和光影效果通常比较准确,但在这些生成的图像中识别主要物体却有一定难度。

bGPT将音频数据视为字节序列,能生成1秒长、采样率为8000 Hz的音频样本。

该模型在LibriSpeech数据集上完成了预训练,并进一步在Speech Commands v2数据集上进行微调和演示。bGPT生成的音频样本保持了较高的准确度,其中一些样本几乎与真实音频无法区分。以下是展示bGPT在音频生成领域能力的示例集。

传统语言模型,不管它们有多强大,主要专注于处理自然语言文本。bGPT模型通过基于字节的处理机制,打破了这种仅限于文本处理的局限性,开辟了一个全新的数据处理范畴。

这一进步让bGPT有能力无缝地处理包括文本、图像、音频在内的各种数据类型,甚至能处理来自算法和硬件的原生二进制数据,为全面模拟和理解数字世界铺平了道路。

虽然bGPT展现出了引人注目的能力,但其在计算开销方面的局限性,如当前在常规显卡上仅能处理最大8KB的字节序列,对于那些需要生成或处理大量数据的应用来说,构成了明显的限制。未来的工作计划将集中在开发更高效的算法和利用硬件的进步上,旨在提高处理更大规模数据序列的能力。

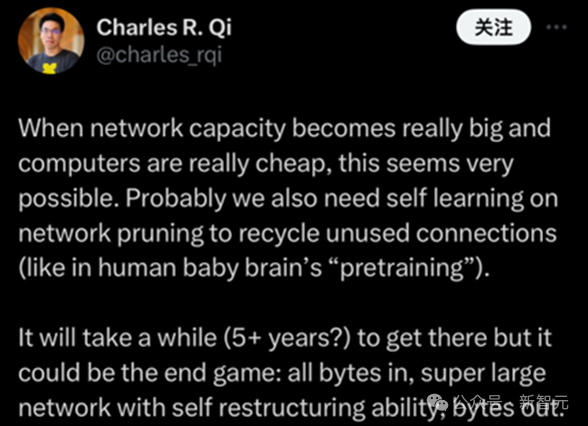

全球的技术爱好者们已经开始展望bGPT未来的潜力,从网络修剪和自我学习的优化到超大规模网络的自我重构能力,这些讨论指向了一个共同的愿景:bGPT最终可能实现一个统一的模型,能够处理和输出所有类型的字节数据,真正成为数字世界的全面模拟器。

研究团队已将bGPT的代码和模型开源。这意味着你可以在自己的数据集上直接训练bGPT,无需做出任何模型架构上的调整,便可探索字节模型在数字领域的广阔前景。

参考资料:

https://arxiv.org/abs/2402.19155

文章来自于 微信公众号“新智元”

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner