网友:波士顿动力要整点新舞步,才能让Figure 01下热搜。

「借助 OpenAI 的能力,Figure 01 现在可以与人全面对话了!」

本周三,半个硅谷都在投的明星机器人创业公司 Figure,发布了全新 OpenAI 大模型加持的机器人 demo。

这家公司在 3 月 1 日刚刚宣布获得 OpenAI 等公司的投资,才十几天就直接用上了 OpenAI 的多模态大模型。

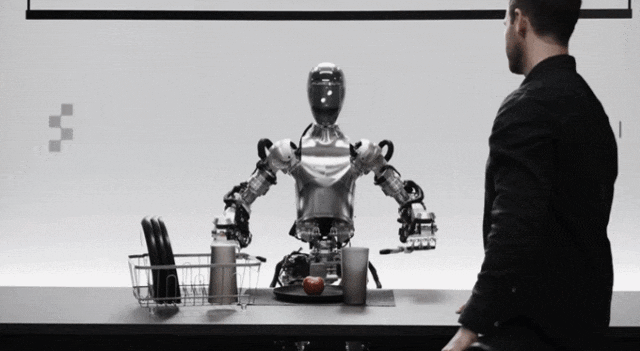

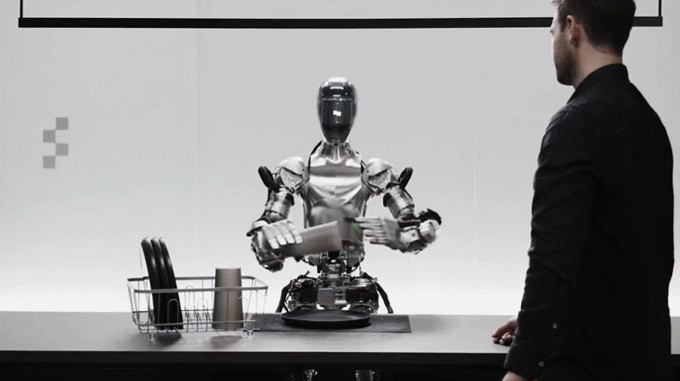

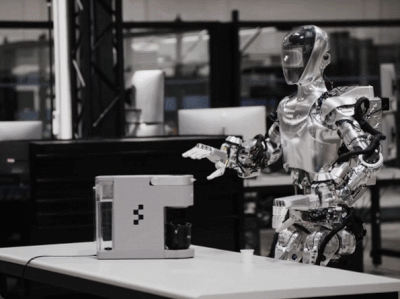

如你所见,得到 OpenAI 大模型能力加持的 Figure 01 现在是这个样子的。

它可以为听从人类的命令,递给人类苹果。

将黑色塑料袋收拾进框子里。

将杯子和盘子归置放在沥水架上。

需要强调的是:你看到的这一切,只用到了一个神经网络。

完整的demo视频如下所示:

广大网友在看到如此惊艳的 demo 后,对机器人的发展速度感到震惊,我们似乎正处在这场汹涌的进化浪潮中。甚至有人感叹,已经准备好迎接更多的机器人了。

还有网友调侃道:「波士顿动力:好的,伙计们,这是一场真正的竞争。让我们回到实验室,设计更多舞蹈套路。」

Figure创始人Brett Adcock表示,视频中Figure 01展示了端到端神经网络框架下与人类的对话,没有任何远程操作。并且,机器人的速度有了显著的提升,开始接近人类的速度。

Figure机器人操作高级AI工程师Corey Lynch介绍了此次Figure 01的技术原理。他表示,Figure 01现在可以做到以下这些:

他接着解释道,视频中机器人的所有行为都是学到的(再次强调不是远程操作),并以正常速度(1.0x)运行。

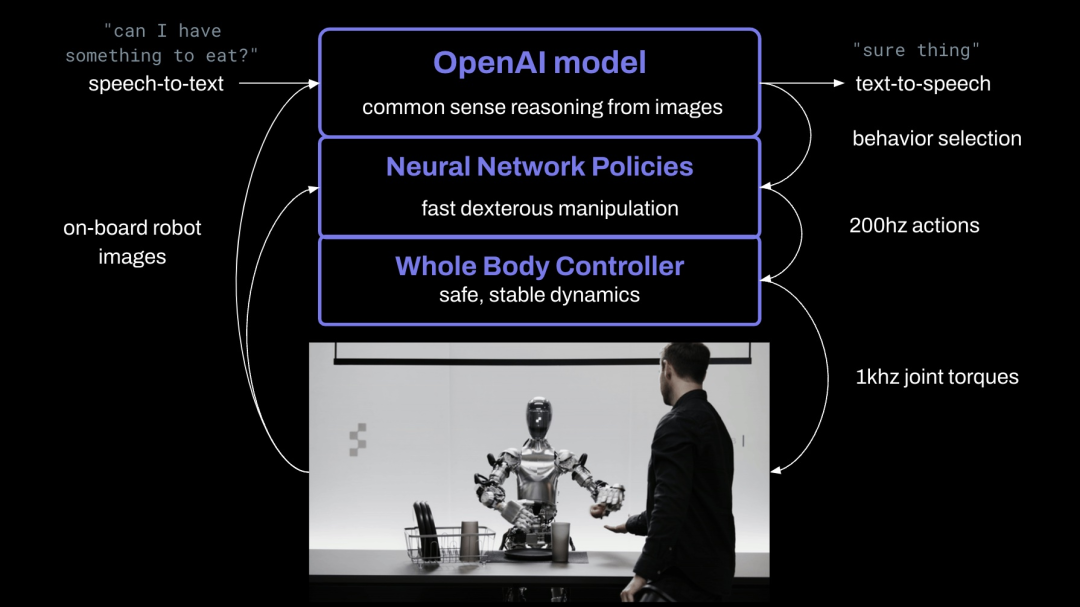

在具体实现过程中,他们将机器人摄像头中的图像输入,并将机载麦克风捕获的语音文本转录到由 OpenAI训练的大型多模态模型中,该模型可以理解图像和文本。该模型对整个对话记录进行处理,包括过去的图像,从而获得语言响应,然后通过文本到语音的方式将其回复给人类。

此外,该模型负责决定在机器人上运行哪些学习到的闭环行为以完成给定的命令,从而将特定的神经网络权重加载到GPU上并执行策略。

将Figure 01 连接到大型预训练多模态模型为其提供了一些有趣的新功能。Figure 01 + OpenAI 现在可以:

理解对话历史的大型预训练模型为Figure 01提供了强大的短期记忆。

考虑一个简单的问题:「你能把它们放在那里吗?」

其中 「它们」指的是什么?「那里」又是哪里?正确回答这个问题需要反思记忆的能力。

通过预训练模型分析对话的图像和文本历史记录,Figure 01快速形成并执行计划:1)将杯子放在沥水架上,2)将盘子放在沥水架上。

关于学到的低级双手操作,所有行为均由神经网络视觉运动transformer策略驱动,将像素直接映射到动作。这些网络以10hz 的频率接收机载图像,并以200hz的频率生成 24-DOF 动作(手腕姿势和手指关节角度)。

这些动作充当高速「设定点」,以供更高速率的全身控制器跟踪。这是一个有用的关注点分离,其中:

最后他表示,即使在几年前,自己还认为人形机器人规划和执行自身完全学得行为的同时与人类进行完整的对话是几十年后才能看到的事情。显然,现在已经发生了太多变化。

最近,生成式 AI 的竞争正在走向长文本、多模态,各家科技公司和机构也没有忘记投资下个热点——具身智能。

具身智能,对于计算机视觉、机器人等领域来说是一个很有挑战的目标:假设 AI 智能体(机器人)不仅能接收来自数据集的静态图像,还能在三维虚拟世界甚至真实环境中四处移动,并与周围环境交互,那我们就会迎来技术的一次重大突破,从识别图像等机器学习的简单能力,转变到学习如何通过多个步骤执行复杂的类人任务。

被生成式 AI 龙头 OpenAI 看好的具身智能,最有希望通向具身智能的公司,似乎就是这家 Figure。

3月1日,Figure 宣布完成惊人的 6.75 亿美元 B 轮融资,公司估值达到 26 亿美元。一眼望去,感觉半个硅谷都投了它:微软、英特尔、OpenAI Startup Fund、Amazon Industrial Innovation Fund 、英伟达、贝索斯、「木头姐」的方舟投资、Parkway Venture Capital、Align Ventures 等。

该公司的产品 Figure 01,据称是世界上第一个具有商业可行性的自主人形机器人,身高 1.5 米,体重 60 公斤,可承载 20 公斤货物,采用电机驱动。它的可工作时长是 5 小时,行走速度每秒 1.2 米,可以说很多指标已经接近人类。

自 2023 年 1 月以来,人们对 Figure 的关注度一直在上升。虽然到目前为止,公司一共才发布过四个 demo 视频。其中的一个展示了 Figure 01 是如何制作咖啡的:

据Figure表示,机器人练习这些动作的方法是端到端的,神经网络的训练时间是10小时。

在 2 月 27 日的视频里,Figure 01 自主完成了一个典型的物流环节任务——搬运空箱。

当然,速度还是比人类慢了很多。不过在这些任务中,Figure 01 都是完全自主地执行任务。所谓「完全自主」,是指只需将机器人放在地面上(无论放在屋里什么地方),在没有其他用户输入的情况下,直接按开始就行。

在训练过的大型视觉语言模型( VLM )帮助下,人形机器人会先识别、定位目标箱子,然后推理合适的拿放姿势。接下来,Figure 01 会导航自己到目标跟前,检测抓取点和手部力量,尝试抓取成功并将箱子放到传送带上。

这些技术亮点也是 Figure 和一直希望回归机器人领域的 OpenAI 达成合作协议的重要原因之一——将 OpenAI 的研究与 Figure 的机器人经验结合起来,为人形机器人开发下一代 AI 模型。OpenAI 也希望将自己的高性能多模态大模型扩展到机器人领域。

除了接受大笔风投之外,Figure 也在积极拓展落地场景。目前,Figure 01 已经开始在宝马位于南卡罗来纳州斯帕坦堡的汽车工厂接受测试,人们计划让机器人替代人类从事一些危险度高的任务。

参考链接:

https://twitter.com/i/status/1767913661253984474

https://www.figure.ai/

文章来自于微信公众号 “机器之心”,作者 “关注生成AI用例的”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md