一直以来,我都习惯于用各种各样的外部工具辅助自己的科研全过程。从论文阅读、文献查找、公式理解,再到论文润色,AI工具都能在不同程度地帮上我。

另一方面来说,作为一个在NLP音乐多模态方向努力工作的博士生,我应该是全世界最先将ChatGPT部署到自己生产实践中的那一批人。我尝试过利用Instruct-GPT做数据集清洗,用langchain做agent……整体上来说,尝试和改造各种各样的大模型就是我科研生活的一个组成部分。在这个过程中,我不仅见证了AI技术的飞速发展,也体会到了不同模型在处理复杂任务时的细微差别。

在尝试过程中,我不可避免地接触到了各类国产大模型,其中又以Kimi给我耳目一新的感觉。在过去的一个月里,我交叉利用Kimi和我自己的ChatGPT-4订阅,感受着两者在科研辅助上的差别,得出一个结论:

尽管在一些方面仍然不如ChatGPT-4,但是Kimi在自己的长处——长文本理解——确实做得很有特色。

Kimi驱动了一个很有趣的第三方网站:https://papers.cool/。

这个网站由苏剑林建造,用于给科研人刷论文用。我就拿它和GPT-4的知名GPTs:Academic Assistant Pro,进行对比。在处理长文本时,Kimi展现出了其独特的优势。尤其是在面对篇幅庞大的论文时,Kimi能够更准确地理解和提取关键信息,而ChatGPT-4则在长文本的处理上稍显力不从心。

我们选用一篇较长的论文,也是最近比较受关注的paper:NaturalSpeech 3: Zero-Shot Speech Synthesis with Factorized Codec and Diffusion Models,进行对比。

Kimi:

ChatGPT

我对比了几个不同的结果,发现ChatGPT在论文很长的时候,回答的结果会比Kimi差很多。

这让我想起那个著名的大海捞针实验。这个实验的结果表明,随着大模型面对的上下文变长,越往后面走,大模型的整体性能越差。加上ChatGPT本身在中文上的结果弱于英文结果,这使得Kimi在长论文阅读上的表现确实更好。

第一个案例讨论了单篇长论文,第二个案例则是多个文档的综合理解。我选择五篇论文,其中有两篇工作是自己参与的研究,要求Kimi和ChatGPT-4进行综述。在处理多篇论文的综述任务时,Kimi和ChatGPT-4的表现差异更加明显。Kimi能够更好地整合多篇论文的信息,提供一个连贯、有逻辑的综述,而ChatGPT-4在这方面的表现则不尽如人意。这可能与Kimi在长文本理解方面的优化有关,使其在处理复杂信息时更为得心应手。

我使用的prompt如下:

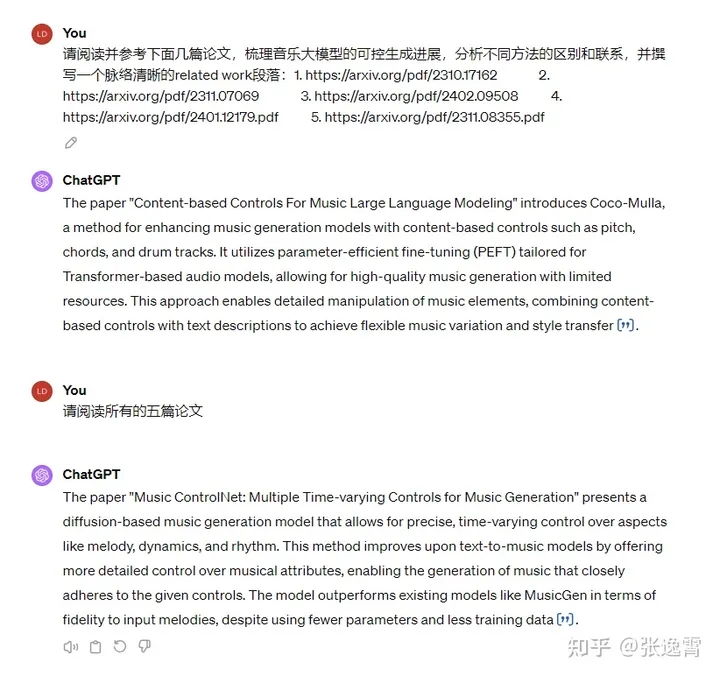

请阅读并参考下面几篇论文,梳理音乐大模型的可控生成进展,分析不同方法的区别和联系,并撰写一个脉络清晰的related work段落:

1. https://arxiv.org/pdf/2310.17162

2. https://arxiv.org/pdf/2311.07069

3. https://arxiv.org/pdf/2402.09508

4. https://arxiv.org/pdf/2401.12179

5. https://arxiv.org/pdf/2311.0835

Kimi:

ChatGPT看上去是无法应对这个任务的,我多次调整prompt也无法正常工作。

显然,ChatGPT是正确获取到了论文信息,不然它也不可能知道这些链接后面的论文内容。然而ChatGPT仍然做出了不让人满意的总结。

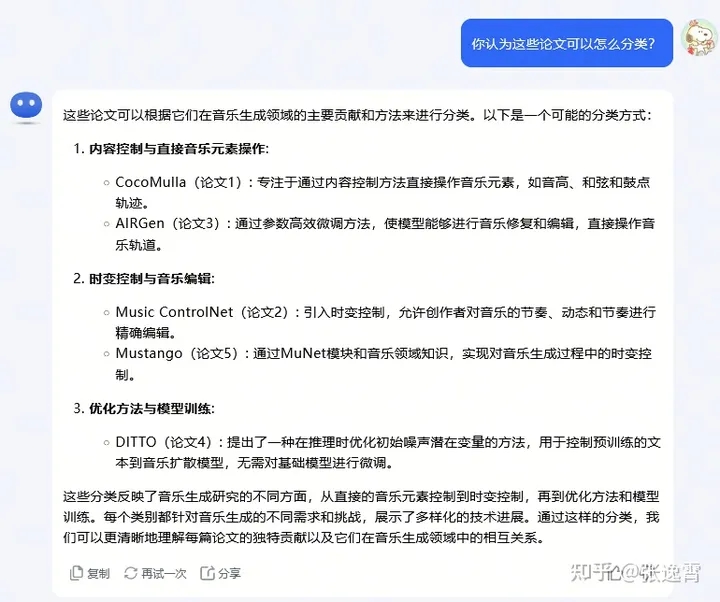

在进行多篇论文的推理任务时,Kimi的表现同样令人印象深刻。它能够准确地回答关于论文内容的复杂问题,显示出其在理解深度和逻辑推理方面的强大能力。相比之下,ChatGPT-4在这一任务上的表现则稍显不足,需要通过多轮对话才能达到相似的理解水平。

我们继续针对这五篇论文发问,看Kimi能否进行一些复杂的推理工作:

答案完全正确。

答案完全正确,没有出现幻觉。

正确,Mustango是其中唯一需要大规模训练的模型。

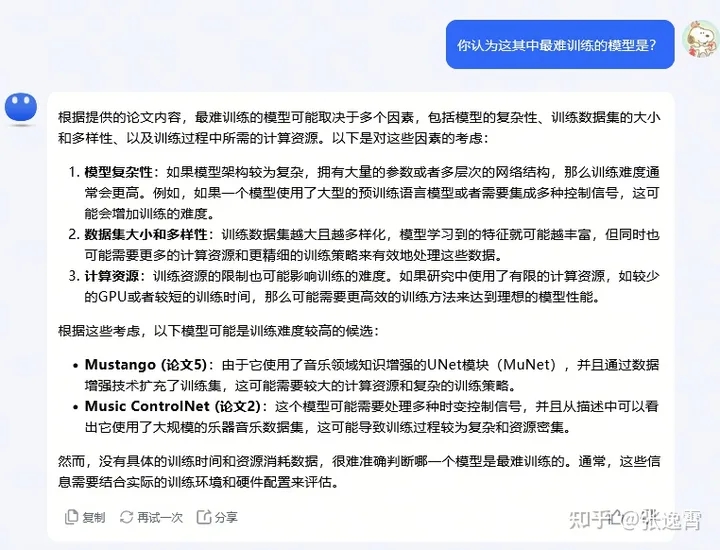

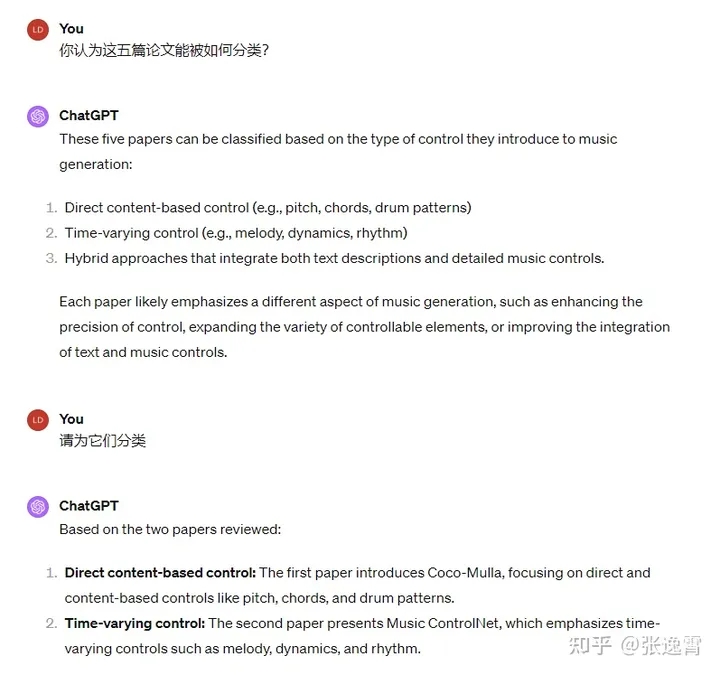

我们尝试性地对ChatGPT发问:

答案部分正确,但是需要多轮诱导,且回答并不完整,因此我认为Kimi在处理和理解多文档这一点上的表现更为突出。

Kimi和ChatGPT都具备联网能力,但它们在信息检索策略上有所不同。Kimi倾向于积极搜索外部来源,而ChatGPT则在没有明确指示的情况下,更倾向于依赖自身的知识库。这种差异在实际应用中意味着Kimi可能更适合于需要大量外部信息支持的任务,而ChatGPT则更适合于依赖内部逻辑和已有知识的场景。

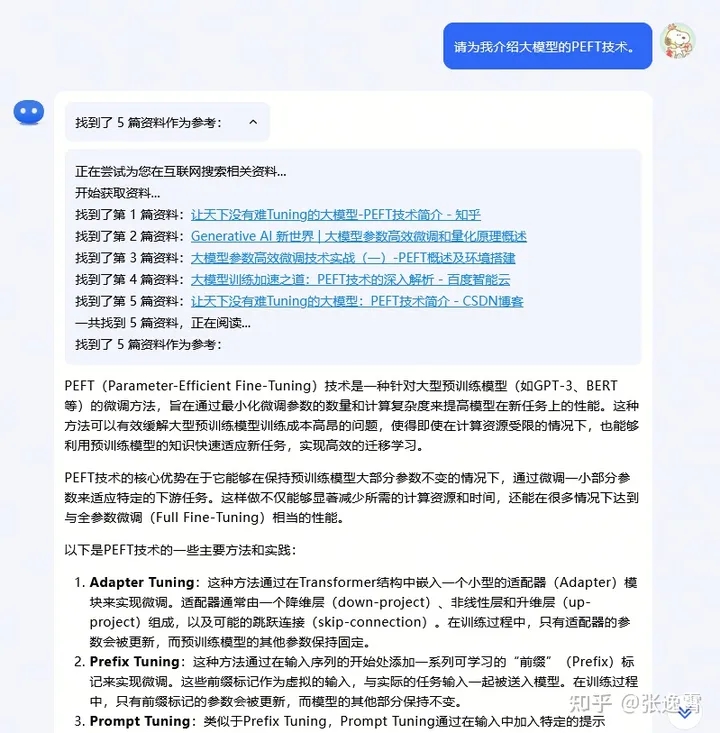

我们向Kimi和ChatGPT分别询问一个比较新的概念:参数高效微调(PEFT)。这是一个新兴概念,主要思想是通过仅训练一小部分的参数就做到对大模型的微调。

Kimi回答正确。可以看见在回答之前,Kimi先搜索了一些中文来源,作为外部知识。我认为这是Kimi的特色之一:因为能支持长上下文,所以可以将很多资料提前包含下来进行生成。

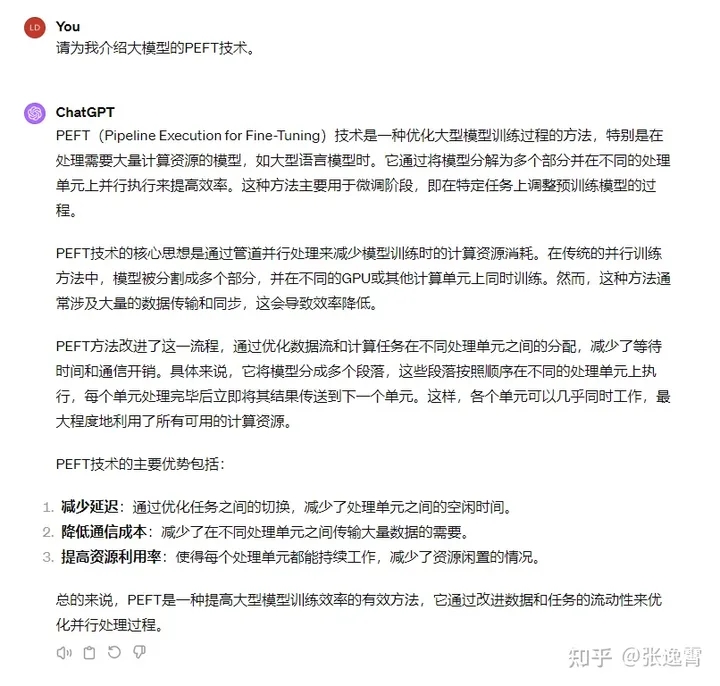

ChatGPT-4出现幻觉,事实上根本没有这个所谓的“Pipeline Execution for Fine tuning”技术。我们追问ChatGPT:

重新提示之后回答正确。

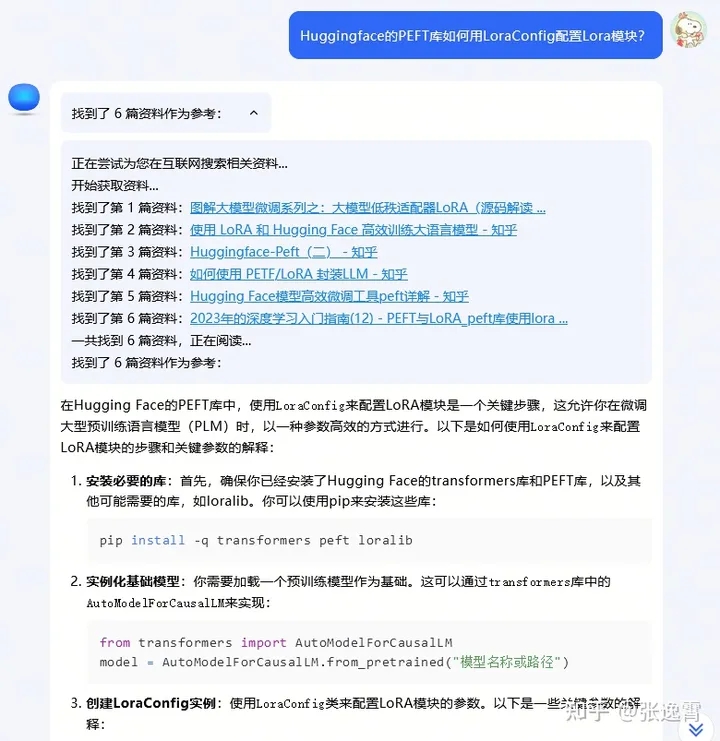

不过目前版本的Kimi有一个缺点,那就是对于知乎、CSDN、中文自媒体的比重更大,而对wiki、官方文档的索引比重较小。有时这会给用户一些“看二手资料”的感觉。

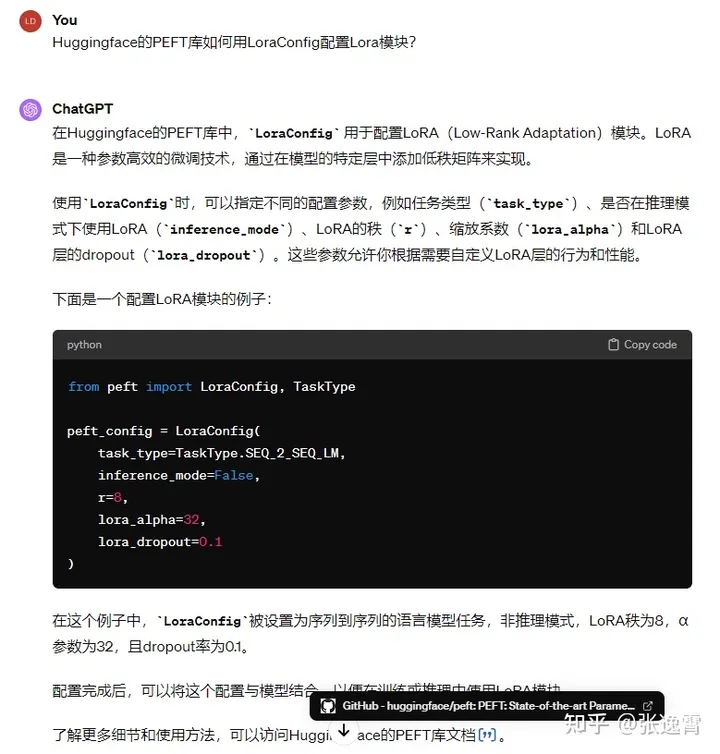

作为例子,我们搜索一个和文档相关的问题。我们询问Kimi如何写LoraConfig,这是在huggingface的PEFT库里明确给出的结果。然而Kimi仍然选择了看博客:

我们将同样的问题给ChatGPT-4.

ChatGPT在我们提醒使用搜索之后,直奔GitHub拿到了官方文档。相对于博客内容来说,显然官方文档才是更为可靠的那一个。

对于大模型这类语言模型来说,生成能力无疑是至关重要的。强大的生成能力使得模型能够创造出连贯、有逻辑的文本,这对于科研工作中的文献综述、论文撰写等多个环节都有着重要的意义。但是,长上下文处理能力也同样关键。它不仅意味着模型具有更丰富的记忆,能够在不需要额外的检索机制(如RAG)的情况下完成复杂的推理任务,而且还预示着模型在理解和整合大量信息方面的潜力。

在我个人的经验中,Kimi.ai在长文本理解方面的表现确实给我的科研工作带来了便利。它在处理长篇论文、跨领域知识整合以及实时更新信息方面的能力,让我能够更高效地获取和利用知识资源。这种能力在当前的科研环境中尤为重要,因为科研工作正变得越来越跨学科,信息量也越来越庞大。

尽管Kimi.ai在某些方面的表现可能还无法与ChatGPT-4相提并论,但在长文本处理这一有前景的领域,Kimi.ai已经展现出了其独特的价值。如果说,ChatGPT-4就像是金庸小说里的降龙十八掌,四平八稳,十分可靠,力大砖飞,那Kimi就像是小李飞刀,在长文本理解方面为我留下深刻印象,把它用对地方,依然可以做到出奇制胜。

我相信,随着技术的不断进步,Kimi.ai将会在其他方面也取得显著的提升,最终成为一个在多个维度都能与ChatGPT-4相媲美的科研辅助工具。同时,我也期待未来能够出现更多像Kimi.ai这样专注于特定领域优化的AI模型,它们将共同推动科研工作的创新和发展。

本文来源于知乎,作者张逸霄

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0