Claude 3的诞生又一次震惊了全世界。

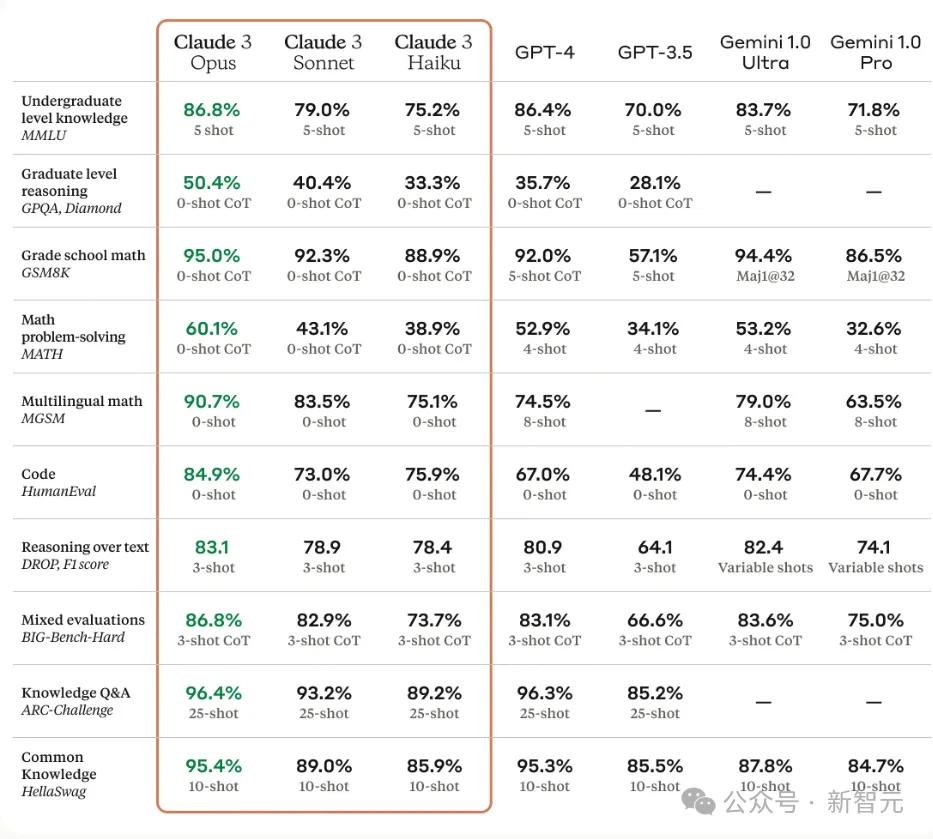

Claude 3 Opus,Claude 3中最智能的模型,在大多数常见的人工智能系统评估基准测试中表现优异,包括本科水平专家知识(MMLU)、研究生水平专家推理(GPQA)、基础数学(GSM8K)等。

但在特定的专业领域,它的表现却是一个未知数。

比如化学,化学在药物发现和材料科学等领域发挥着至关重要的作用,但现有研究显示它们在化学任务上的性能令人沮丧。

指令微调让LLM完成化学任务成为可能

近日,一支来自OSU的团队构建了一个专门针对化学任务指令微调的数据集,命名为SMolInstruct。

论文地址:https://arxiv.org/pdf/2402.09391.pdf

该SMolInstruct测试集涵盖了14种任务,包括名称转换、属性预测、分子描述、分子生成、正向合成和逆向合成等,这些专业任务经过精心挑选,以建立坚实的化学基础。

它同时包含340万个不同的样本和160万个不同的分子,涵盖了各种大小、结构和性质的化合物,展示了广泛的化学知识覆盖范围。这些样本都经过严格的处理步骤,排除了有问题和低质量的样本。

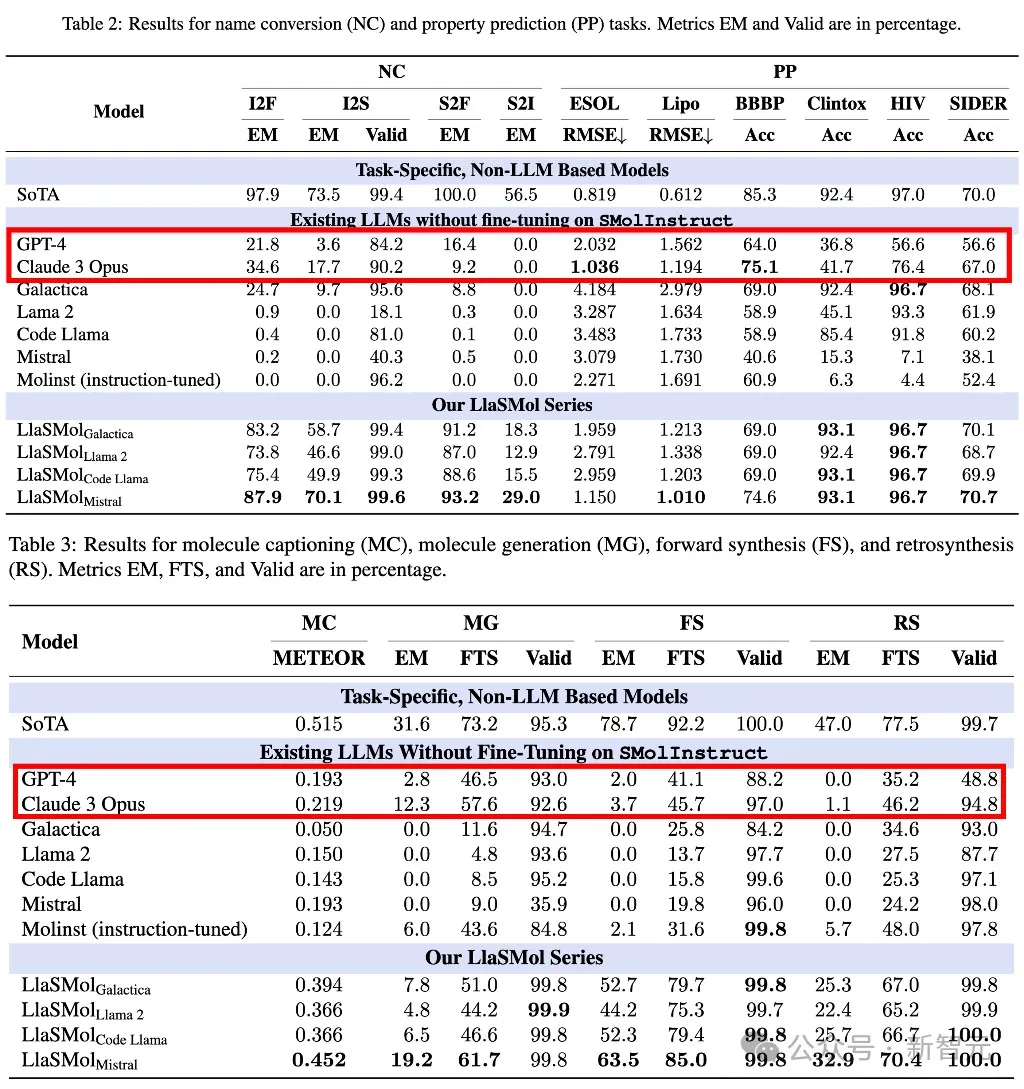

然后,他们在SMolInstruct数据集上对四个开源LLM(Galactica、Llama 2、Code Llama和Mistral)进行微调,创建了一系列专门用于化学任务的LLM,称为LlaSMol。

论文中,主要将LlaSMol模型与两种类型的模型进行比较:

2.SOTA任务特定模型

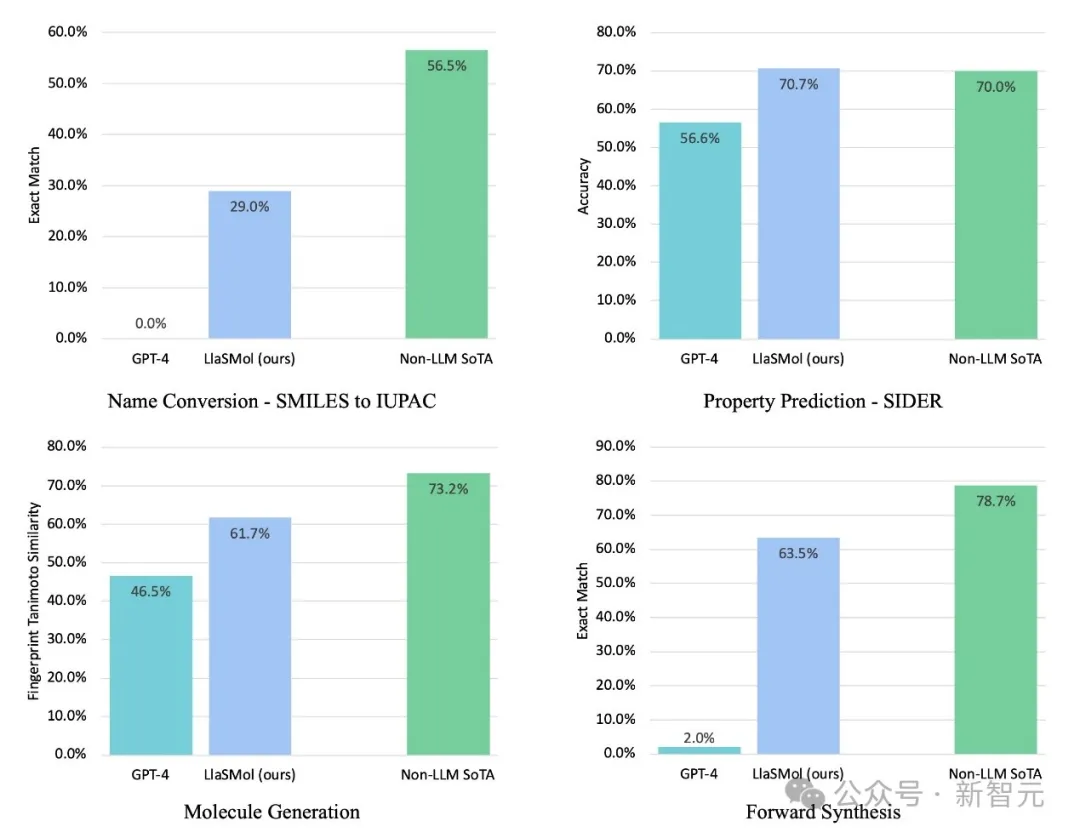

结果显示,LlaSMol在所有任务上都显著优于现有的LLM,包括GPT-4。

例如,将SMILES转换为分子式的准确率达到94.5%,而GPT-4仅为16.4%;对于逆合成任务,准确率达到32.9%,而GPT-4仅为0%,并接近最先进的任务特定模型SOTA。

这凸显了SMolInstruct数据集的有效性和微调的好处。

这个结果是合理的,虽然GPT-4很强大,但它毕竟是通用模型,很难直接和经过特定的任务及样本微调的LlaSMol去对抗。

但经过微调的LLM表现已经逼近非LLM的任务特定模型,还是展现了LLM的巨大潜力。

不仅如此,四个LlaSMol模型在性能上表现出显著差异,也强调出了基础模型对下游任务的重要影响。

Claude 3在专业化学领域仍旧领先

Claude 3一经推出,该团队便在SMolInstruct 该基准测试上对于Claude 3 Opus同样进行了实验。

虽然与LlaSMol还是有差距,但在大多数任务中,Claude 3的表现远远超过GPT-4。

虽然在其中的一个名称转换任务S2F中,也就是一个将用于表示分子结构的文本字符串转换为分子式去计算原子数量的任务,Claude 3要比GPT-4差得多,但大多数任务的大幅领先还是展现了Claude 3在专业领域学习能力上的优越性。

Anthropic在官网介绍Claude 3时,用了「smarter, faster, safer」去描述大模型智能的未来潜力。

而我们在化学特定任务上,已经可以感受到了Opus作为通用模型,学习的速度之快,能力之强。

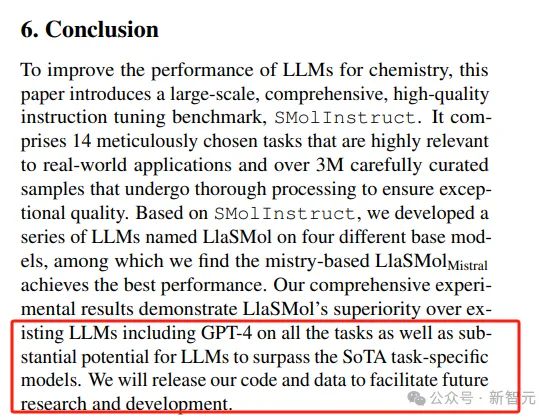

LLM超越任务特定模型,指日可待

在SMolInstruct原论文的结尾,作者也表达了对在化学领域,LLM能够超越任务特定模型的期许和展望。

任务特定模型毕竟是基于固定的输入,它们被优化以执行其特定任务,通常在大小和复杂性上都较小,而且在跨知识共享的任务中很难有好的表现。

而LLM有更多的参数和模型结构,可以在学习中进化,也能快速适应新的需求。

不可否认的是,经过微调的LLM更多的在专业领域上赶超任务特定模型,目前非常依赖于微调指令的完整性、全面性、准确性。

但若以发展的眼光来比较两种模型,尤其是在我们已经感受到Claude 3可怕的成长速度之后。

可以预想到,作为通用模型来设计的LLM,会在专业领域逐渐爆发。

参考资料:

https://twitter.com/hhsun1/status/1766656199083098134

https://www.anthropic.com/news/claude-3-family

https://arxiv.org/pdf/2402.09391.pdf

文章来自微信公众号“新智元”,作者:新智元