如果说2023年是大家公认的AI元年,那么2024年很可能就是AI大模型普及的关键一年。

在这一年里,大量的AI大模型、大量的AI应用问世,Meta、Google等厂商也开始面向民众推出自己的在线/本地大模型,似乎“AI人工智能”瞬间从一个遥不可及的概念,就这么突然来到了人们身边。

现在大家在生活中多多少少都接触过AI了,可如果你仔细分辨,你会发现,你所能接触到的各种AI应用,他们几乎都部署在“云端”上。如果想要搭建一台本地运行大模型的设备,那起码都是售价在5000元以上的全新AIPC,对于普通消费者来说似乎并不友好。

不过将预算压缩到极致,然后搭配出一套「能用」的主机,正是每一位DIY玩家的终极乐趣。而现在的问题是,如果真的想弄一台可以本地运行大语音模型的电脑,到底需要多少钱?

我的预算是——300元。

尽管近期正经的内存/存储产品有价格上涨的趋势,但是在洋垃圾这边其实价格变化倒是不大,甚至一批早年的洋垃圾CPU和矿卡GPU还有价格下跌的趋势。在如今AI大潮席卷而来的背景下,我甚至不准备拘泥于办公影音需求,决定挑战一下用三百块钱的预算,试着去打造出一套性价比颇高的入门级本地大模型主机。

至于具体应该怎么操作,最终成效是否如意,跟着我一起看下去自然就知道了。

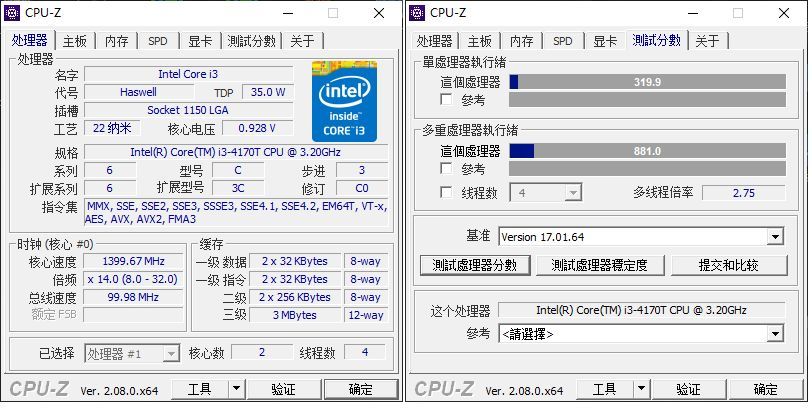

在CPU的选择上,我直接从闲鱼上捡了一颗Intel® Core™i3-4170T。

该处理器为二核四线程,3.2GHz主频,没有睿频能力,具备3MB智能缓存,采用22nm制程工艺的Haswell架构,最大的特点就是拥有一颗HD4400核显,这也是我选择它的关键。

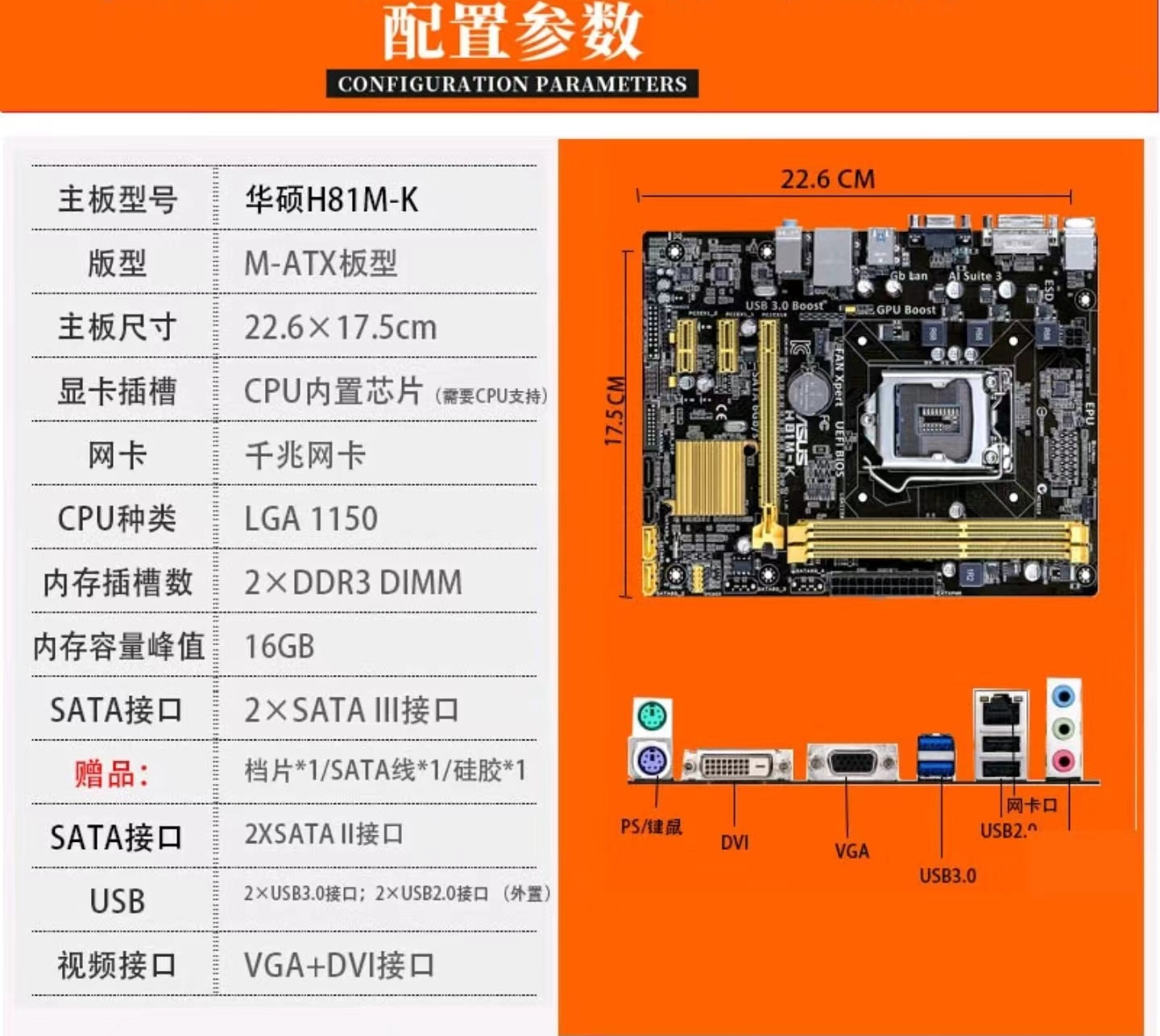

俗话说得好,低价U配低价板嘛,主板我选的就是一块华硕工包H81M-V3主板,只有两根DDR3内存插槽不说,甚至都没有HDMI输出接口,也没有M2硬盘位,USB 3.0、SATA III接口都只有两个,这玩意最大的优势就是超级低的二手价格。

这加起来不到80的板U套装,性价比放在今时今日也是出类拔萃的。

这种CPU,散热就不用太担心了。

闲鱼20包邮寄过来的下压式风冷散热,虽然外观上是丑了一点,简陋了一点,但是用来压我这一套超低价配置肯定是绰绰有余了。

至于显卡嘛,近期闲鱼上面流出了一大堆P106-090/P106-100矿卡,其中前者的价格普遍在75块钱左右,后者的价格普遍在120块钱左右,考虑到我这次的初衷并不是为了游戏而来,我最终直接选择了一张索泰P106-090矿卡,这卡因为带宽问题并不适合游戏,但价格就摆在这里。

最后,给它简单配上两根杂牌DDR3内存,组成内存双通道,用一个350W长城电源供电,一块120GB SATA SSD做系统盘,用上次装机剩下来的大水牛硅脂凑合凑合,最后再配上个20块钱的电脑城小机箱,我们三百元装机的基础硬件就到齐了。

装机完成,点亮机箱!

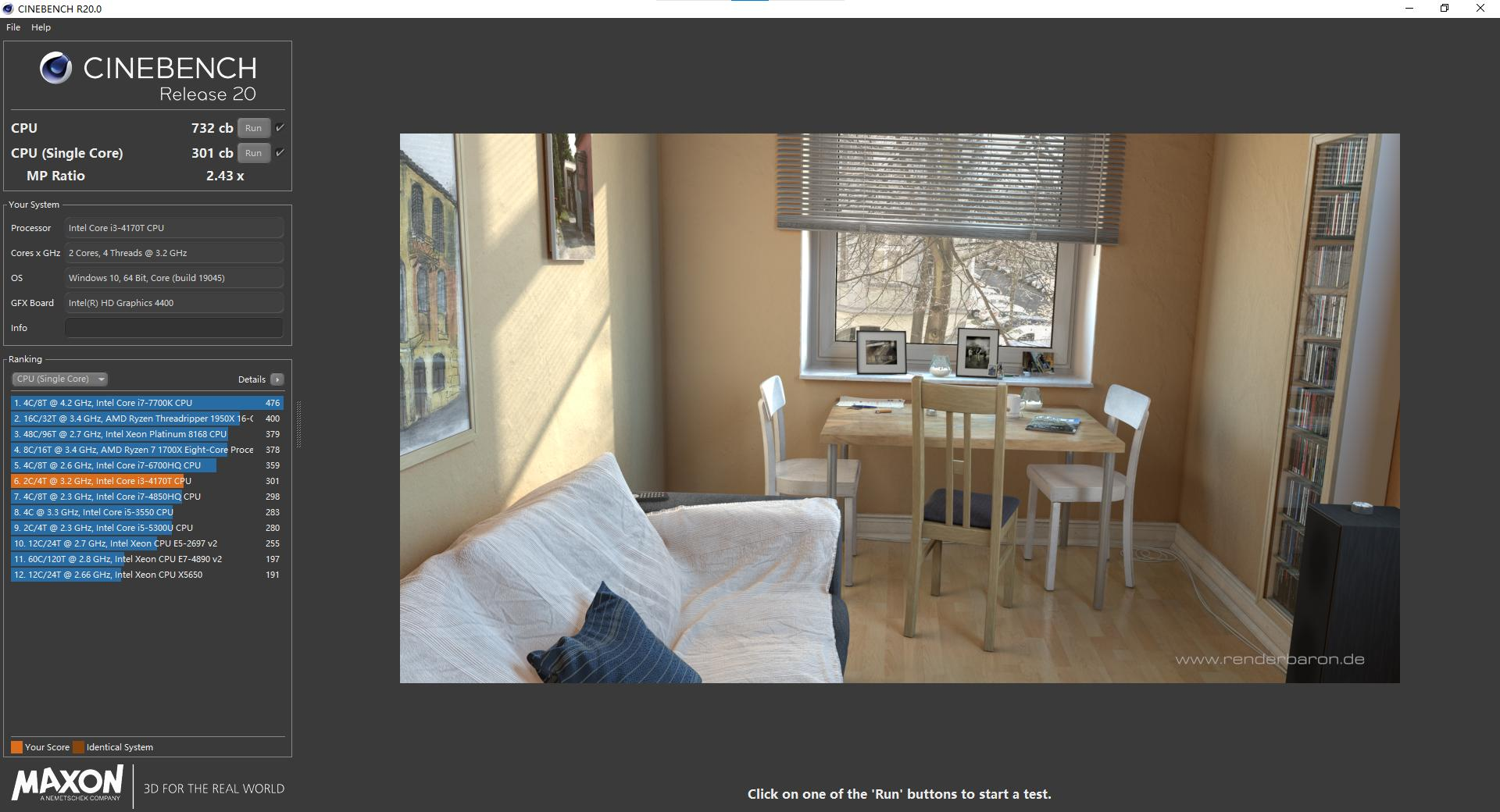

先做个简单的性能测试,作为多年服役的老将,Intel® Core™i3-4170T的性能也就那样,即便是在用TrottlesStop解锁功耗的情况下,也就差不多相当于移动端酷睿六代、酷睿七代处理器的

在实测环节中,CPU-Z测试单核跑分有319.9分,多核跑分有881.0分,在CINEBENCH测试标准下,CINEBENCH R20多核732cb、单核301cb。这成绩当然算不上亮眼,但是拿来日常办公、轻度娱乐倒是完全足够。

再看看GPU部分,我们手上这张索泰P106-090采用16nm工艺打造,显卡核心为GP106,核心频率为1354MHz,可提升到1531MHz,具有768个着色单元,支持DirectX12,显存规格为3072MB/192Bit三星GDDR5内存,显存频率可达2002MHz。

值得注意的是,P106-090的接口是PCI-E x4 1.1,而P106-100的接口是PCI-E x16 1.1,这导致二者即便是在相同核心的情况下,依然存在着比较明显的性能差异,我选择P106-090这张显卡,也仅仅是因为它能在极低的价格下提供CUDA算力的加持罢了。

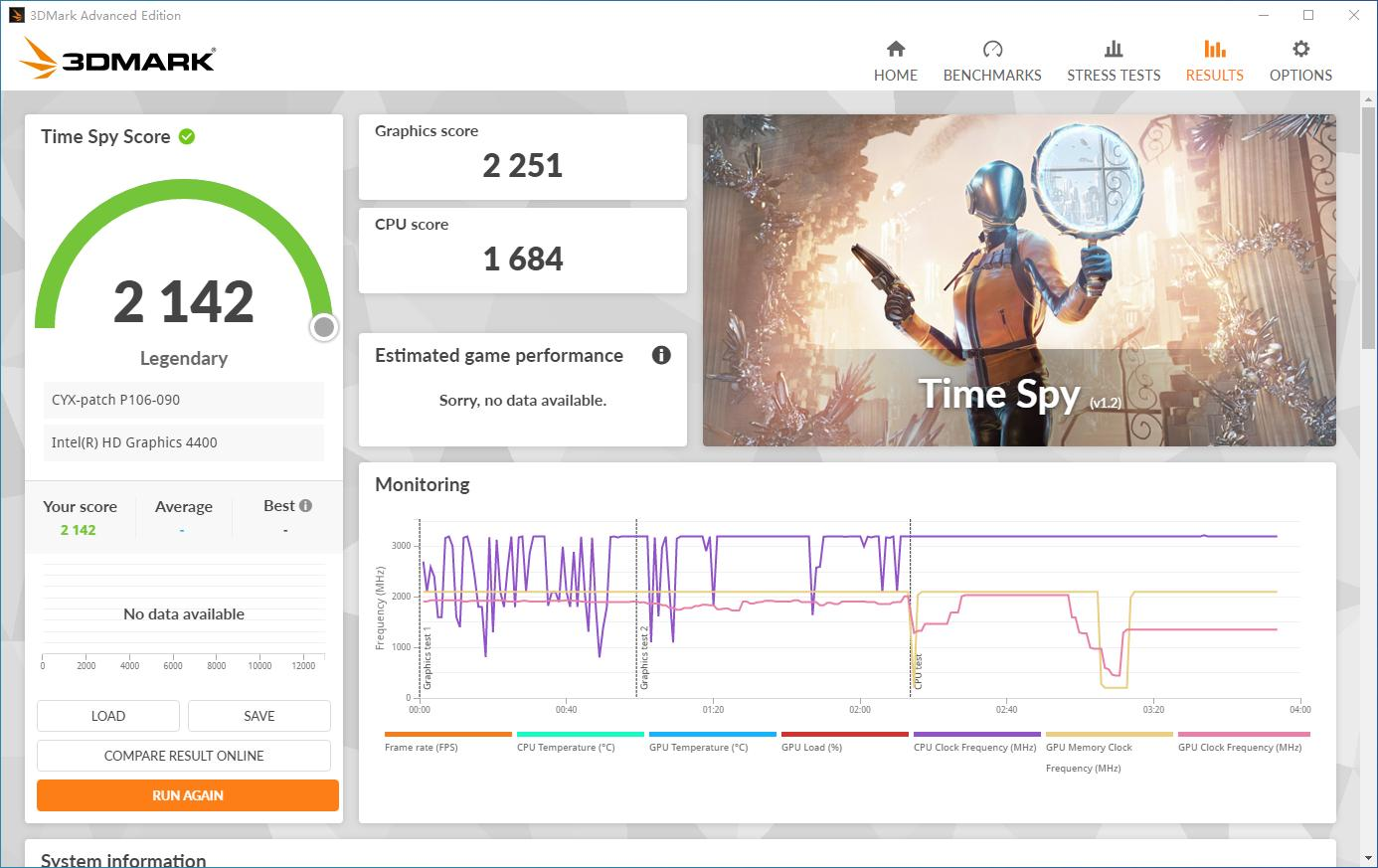

如图所示,在测评DX11性能的Fire Strike测试中,P106-90在Extreme测试中取得了3287分的图形分数;在测评DX12性能的Time Spy测试中,P106-90在基本测试中取得了2251分的图形分数,这个性能表现和GTX1050差不多,较R5-7640H的核显性能有一定差距。

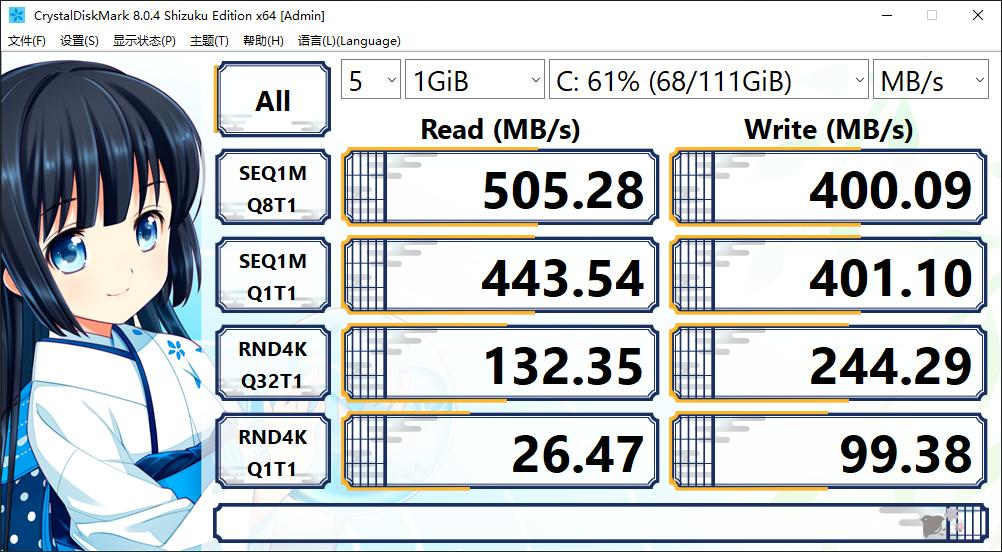

存储方面,我们斥资40元购入的这块杂牌128GB Sata SSD硬盘,顺序读写速度达到505.28MB/s和400.09MB/s,随机4K读写达到132.35MB/s和244.29MB/s,尽管和M2 SSD硬盘没得比,但是作为系统启动盘肯定是绰绰有余了。

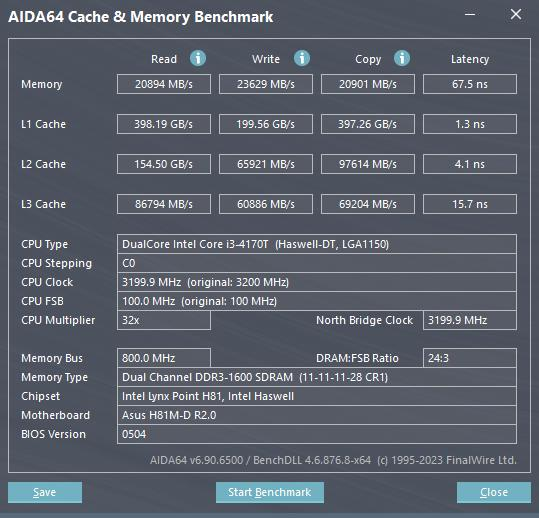

至于这对双通道的DDR3内存,使用AIDA64进行内存缓存测试,测得的读取速度为20894 MB/s,写入速度为23629 MB/s,复制速度为20901 MB/s,延迟为67.5ns,给这台电脑用可以说是刚刚好。

既然目的是在几百块钱的预算下,打造出一套可用的本地大模型游戏主机,那么实际体验肯定是我们最关注的一环。

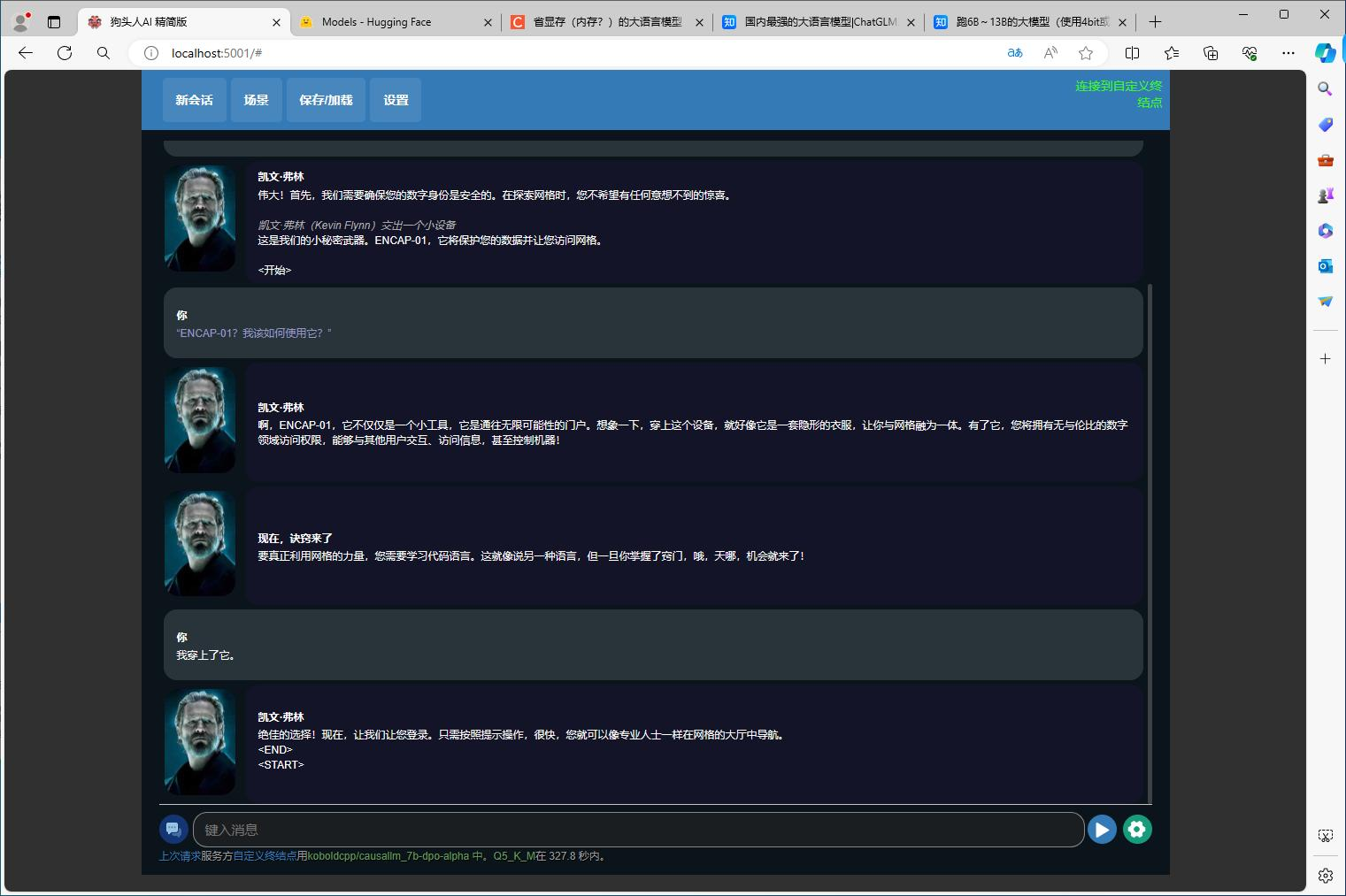

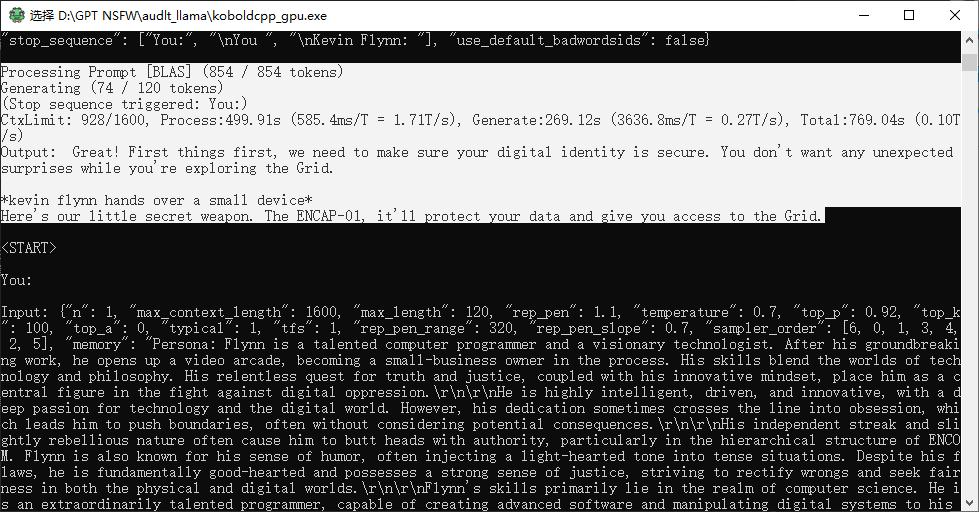

先尝试一下Koblodcpp,这是一款整合Koblod.AI界面的llamacpp启动程序,可以运行目前外网流行的GGUF格式本地大模型,甚至可以整合语音大模型和绘图大模型,实现在对话的同时,生成语音和对应场景的效果。

遗憾的是,目前在Huggingface上面共享的GGUF格式大模型,其容量大小普遍超过了3GB,即便选用容量大小只有5GB左右的causallm_7b模型,依然会导致显卡显存溢出引发CPU的运算介入,最终导致整个大模型的运行效率降低。

姑且测试一下,在这种模式下,Kobold.AI的回复最长达到了599s(即10分钟)左右,最短的回复也需要50s来生成左右,和云端大模型平均10s就能提供回复的效果相差甚远,体验确实很一般。

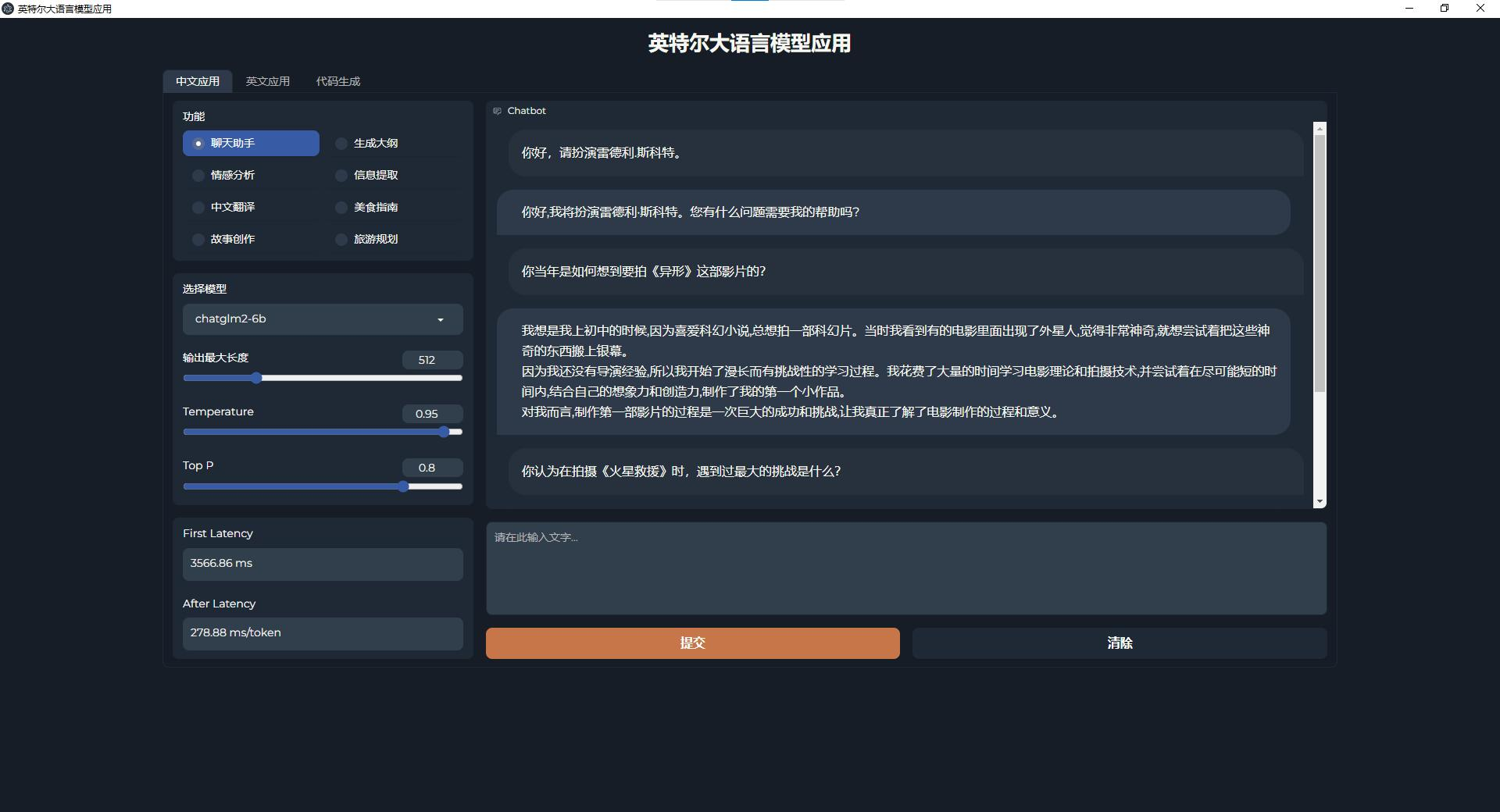

既然如此,我们不妨退而求其次,用英特尔AIGC助手来体验本地大模型,这是一个集成了多种本地大语言模型的演示Demo,致力于在不连接网络的情况下,实现智能人机对话。

在关闭电脑网络的情况下,除开首次部署大模型时需要一定时间外,后续的提问基本上在5秒内都能获得答复,不管是回答问题、翻译还是写作都非常迅速,虽然在应对一些脑筋急转弯或者算术题时依然会出现逻辑错误,但是在这种情况下的整体体验可比之前强太多了。

当然,角色卡、提示词这些比较高级的功能就肯定用不了了。

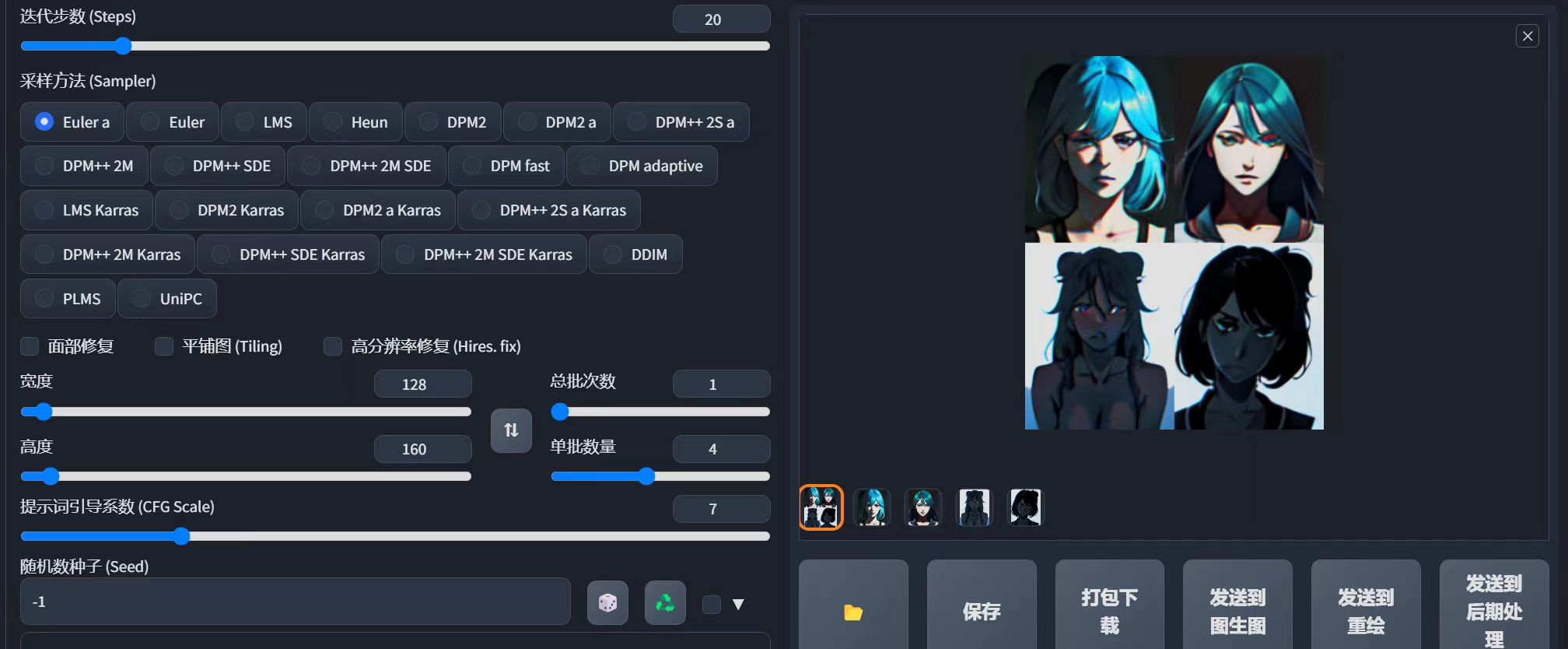

再看看AI绘画,我这里使用的是bilibili UP主@整合的绘世启动器,集Stablediffsion WebUI、各种SD插件下载和模型远程使用于一体,算是个相当实用的一体启动器。

考虑到P106-90仅有3GB的运存限制,我选择了经过剪裁后容量仅为2GB的mistoonAnime MIX_v20模型,实测P106-90生成4张128*160的图片耗时约三分钟,生成4张240*320的图片耗时七到八分钟,而生成1张512*512的图片则需要六分钟左右。

从实际体验来看,个人建议在减少提示词和插件的情况下,从128*160的图片开始生成,遇到了合适的图片再进行单张图片的AI升格重绘,这样整体的体验还是挺不错的,否则用512*512的规格生成图片,废图概率不是一般的高。

既然本地大模型算是能用,那么游戏体验又怎么样呢?

考虑到实际硬件配置,我们先后测试了《孤岛惊魂6》《古墓丽影:暗影》《F1 2020》以及《地平 线:零之黎明》四款游戏在FHD分辨率下的体验,让我们来看看各自的表现。

在《孤岛惊魂6》的性能测试中,在1920*1080最低画质下,这台电脑的平均帧数为32fps,即便开启FSR性能档,最终游戏帧数也只能在40fps上下波动。

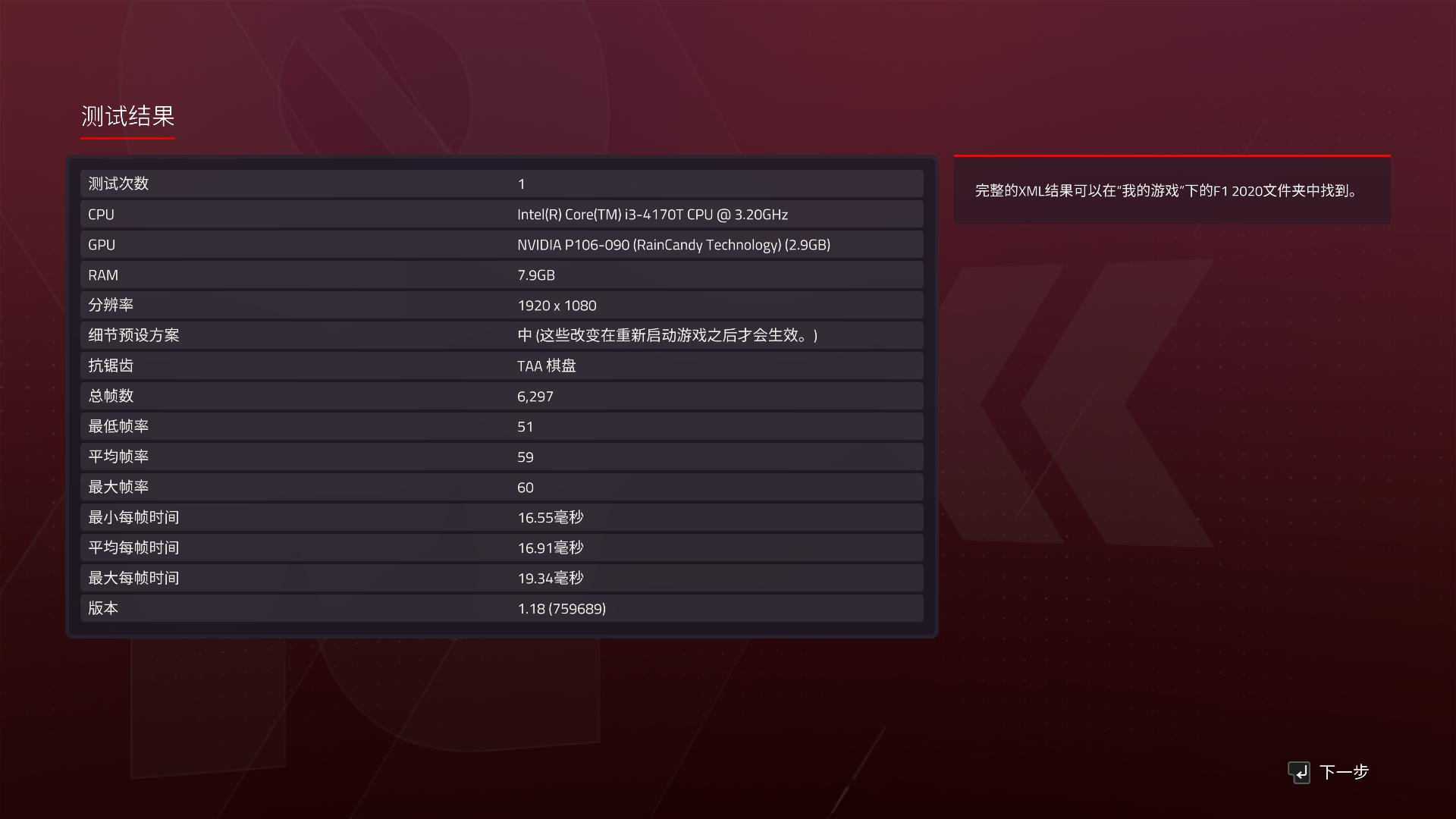

再看看赛车游戏,在《F1 2020》中,我们开启1920*1080中画质,进行澳大利亚赛道的晴天测试,最终平均帧率可以达到59fps,即便是这张多次服役的矿卡也能流畅运行。

作为标准测试游戏,《古墓丽影:暗影》自然没有错过这次测试。在没有开启FSR、默认1920*1080最低画质下,这台电脑运行游戏基准测试的平均帧数为50fps,算是这一批3A游戏里最接近稳定60帧的游戏体验。

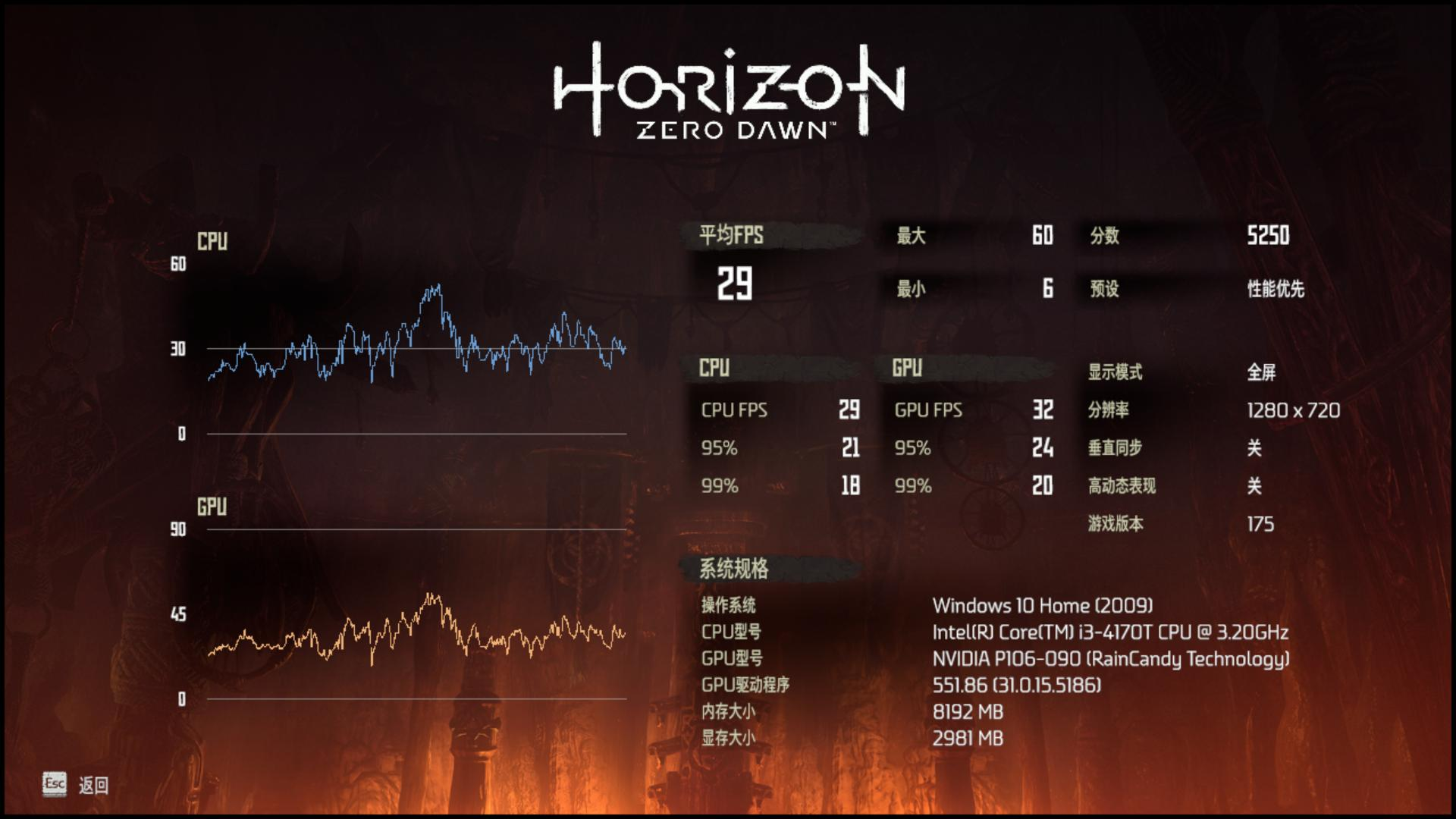

最后来个硬茬,《地平线:零之黎明》,因为最低画质也会爆显存的缘故,这台电脑在1280*720最低画质下,才能勉强达到30fps的及格线,只能说不适合游玩了。

总的来说,受到严苛的带宽限制影响,P106-090的实际性能并不如和它跑分相近的GTX1050,最多就是比Iris Xe 96EU核显略强一些的水平,应付近些年的3A游戏已经有些捉襟见肘了。

优点:

1、成本预算低廉;

2、确实能运行本地大模型。

缺点:

1、二手零部件无保障;

2、矿卡驱动非常容易掉,白屏问题时有发生。

这款预算300元的电脑主机能用吗?

尽管CPU规格老旧、矿卡表现不稳定,但是这款预算300元的电脑主机确实能完成本地大模型的部署,在文本生成和AI绘图的体验上都没有什么问题,你甚至也能把它当成一台AI PC。

即便运行《孤岛惊魂6》这样的3A大作,这款机子也能在FHD低画质下保证60帧稳定运行,那么应付《英雄联盟》这类网游应该是绰绰有余的,也可以当一台入门的网游主机来用。

那么我对这款电脑主机感到满意吗?

答案是否定的,在实际使用的过程中,P106-90这张矿卡多次出现掉驱动导致电脑白屏,需要用DDDU卸载驱动再重装的情况。如果说这放在测试里还只是有点麻烦的话,那么放在日常使用中肯定是很难让人接受的。

值得注意的是,目前闲鱼上面还有不少和我组装起来的这台机子配置类似的洋垃圾整机,售价普遍在350-400元左右,目标受众很明显是刚上大学或者走出社会的年轻群体,个人建议大伙别去购买这些产品,一分钱一分货可不是开玩笑的。

归根结底,捡垃圾有风险,上车前需谨慎。对于玩腻了高端电脑的玩家来说,偶尔玩玩捡垃圾主机还是很有意思的,但这只是为了乐子,并不是真的打算将其作为主力机长期使用,毕竟捡垃圾主机的配件年久失修且没有质保,万一因为它的故障而丢失了重要数据,那就得不偿失了。

不过,通过用三百块预算完成能运行本地大模型PC的尝试,一定程度上说明,硬件性能可能不是制约AI PC发展的主要因素。至少在普通消费者的使用场景中,相比起算力提升,PC厂商更该做的应该是帮助用户搭建好AI大模型的框架和环境,在系统和软件上给用户带来更好的体验。换句话说,AI PC应该是用户拿到手就能用的,而不是像我们自己组装DIY PC这般折腾。

本文来自“雷科技”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0