120秒超长AI视频模型来了!不但比Sora长,而且免费开源!

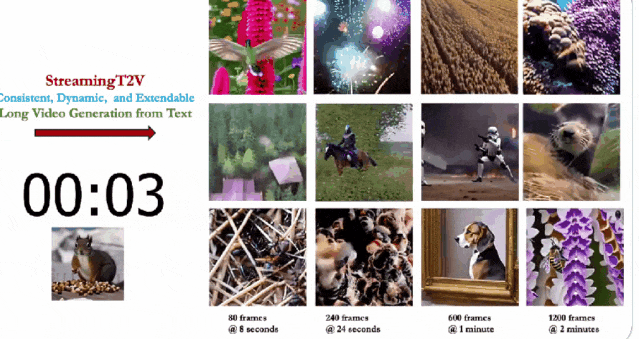

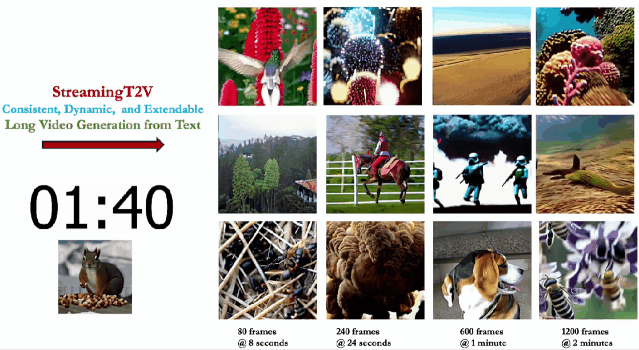

近日,Picsart AI Resarch等团队联合发布了StreamingT2V,可以生成长达1200帧、时长为2分钟的视频,同时质量也很不错。

论文地址:https://arxiv.org/pdf/2403.14773.pdf

Demo试用:https://huggingface.co/spaces/PAIR/StreamingT2V

开源代码:https://github.com/Picsart-AI-Research/StreamingT2V

并且,作者表示,两分钟并不是模型的极限,就像之前Runway的视频可以延长一样,StreamingT2V理论上可以做到无限长。

在Sora之前,Pika、Runway、Stable Video Diffusion(SVD)等视频生成模型,一般只能生成几秒钟的视频,最多延长到十几秒,

——这不,120秒的超长AI视频说来就来了。

这下虽说不能马上撼动Sora的统治地位,但至少在时长上扳回一城。

更重要的是,StreamingT2V作为开源世界的强大组件,可以兼容SVD和animatediff等项目,更好地促进开源生态的发展

通过放出的例子来看,目前兼容的效果还稍显抽象,但技术进步只是时间的问题,卷起来才是最重要的~

总有一天我们都能用上「开源的Sora」,——你说是吧?OpenAI。

A beautiful girl with short hair wearing a school uniform is walking on the spring campus

不过可能由于小编的要求比较复杂,导致生成的效果多少有点惊悚,诸位可以根据自己的经验自行尝试。

上图是DynamiCrafter-XL和StreamingT2V的视觉比较,使用相同的提示。

X-T切片可视化显示,DynamiCrafter-XL存在严重的块不一致和重复运动。相比之下,StreamingT2V则可以无缝过渡、不断发展。

现有方法不仅容易出现时间不一致和视频停滞,而且随着时间的推移,它们会受到物体外观/特征变化,和视频质量下降的影响(例如下图中的SVD)。

原因是,由于仅对前一个块的最后一帧进行调节,它们忽略了自回归过程的长期依赖性。

在上图的视觉比较中(80帧长度、自回归生成视频),StreamingT2V生成长视频而不会出现运动停滞。

AI长视频能做什么

各家都在卷的视频生成,最直观的应用场景,可能是电影或者游戏。

用AI生成的电影片段(Pika,Midjourney,Magnific):

Runway甚至搞了个AI电影节:

不过另一个答案是什么呢?

世界模型

长视频创造的虚拟世界,是Agent和人形机器人最好的训练环境,当然前提是足够长,也足够真实(符合物理世界的逻辑)。

也许未来的某一天,那里也会是我们人类的生存空间。

参考资料:

https://github.com/Picsart-AI-Research/StreamingT2V

文章来自微信公众号“新智元”,作者;alan

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md