今年 1 月份,2024 年度 IEEE 冯诺伊曼奖项结果正式公布,斯坦福大学语言学和计算机科学教授、AI 学者克里斯托弗・曼宁(Christopher Manning)获奖。

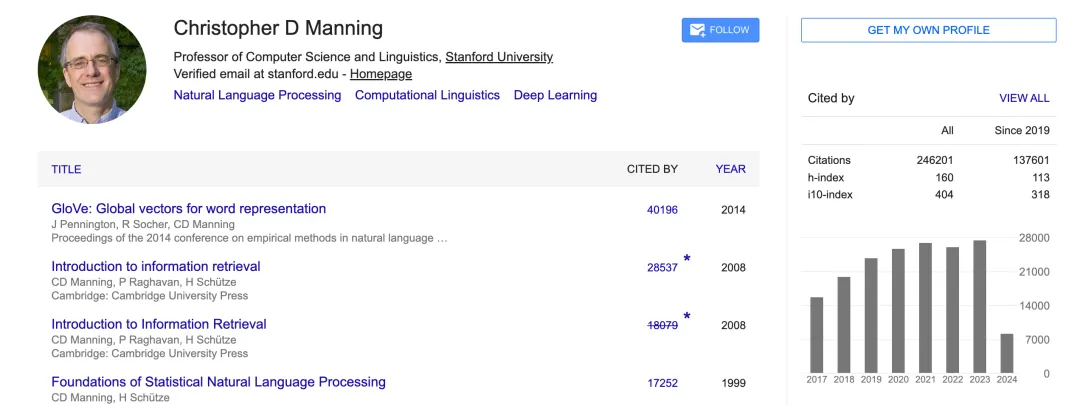

曼宁教授是将深度学习应用于 NLP 领域的早期领军人物,在词向量 GloVe 模型、注意力、机器翻译、问题解答、自监督模型预训练、树递归神经网络、机器推理、依存解析、情感分析和总结等方面都有著名的研究。他还专注于解析、自然语言推理和多语言语言处理的计算语言学方法,目标是让计算机能够智能地处理、理解和生成人类语言。

可以说,在过去的四十多年里,他凭借对语言的终身热爱,一直在探索如何弥合人类和计算机的语言鸿沟。

此外,他还是斯坦福大学 Human-Centered 人工智能研究所(HAI)的共同创始人、以及 2024 年 IEEE John von Neumann 奖章获得者。

最近,他所在的斯坦福大学发布了一篇专题文章,介绍了他的学术探索之路。

多年之后,曼宁教授仍记得自己想要研究语言的那一刻,并自述了当时对语言学的启蒙过程:

「有一天,在高中英语课上,我偶然发现了我老师的一本书,这本书涉及人类语言结构和语言学,」他说。「我开始阅读它,了解到了国际音标,它提供了一套用于表示任何语言发音的通用符号。当时,我已经花了很多个小时学习英语单词的拼写,为了拼写考试,其中的许多单词在学习时都是很随意且奇怪的。此外,我还学习了一些法语和拉丁语。这是我当时看到的第一件能够捕捉到语言学指导思想的事物,通过研究人类语言的共性并尝试在所有人类语言中产生一种共同的科学,是可以实现有用成果的。这也是我第一次开始作为本科生学习语言学的原因。」

四十年后,曼宁教授凭借对人类语言的持续热爱,以及先驱式地致力于帮助计算机学习、理解和生成语言,他成为自然语言处理(NLP)和机器学习领域的著名开创性人物。

斯坦福大学语言学和计算机科学教授 Dan Jurafsky 对曼宁教授的先驱生涯评价道:

「我会称 Chris 为一个极其有影响力的人物,在自然语言处理领域可能是最有影响力的人物。他绝对是该领域获得引用最多的人,几十年的研究影响了包括我们最近的模型在内的一切。每个自然语言处理的学者都知道他的作品。」

曼宁出生在澳大利亚昆士兰州的班达伯格市,他的父亲在 Fairymead 糖厂工作,负责维护、设计和建造机械。到了上高中时,全家已经搬到了澳大利亚首都堪培拉,他在那里得到了他的第一台计算机:先是借用了一台 TRS-80,最终得到了一台 Commodore Amiga。

在 80 年代中期,作为一名在澳大利亚国立大学(ANU)学习语言学、计算机科学和数学的本科生,曼宁已经对这些领域的交叉点感到兴奋,并逐渐确信:早期的 NLP 时代,即手写词汇表和语法规则的时代,即将结束。

当曼宁教授回忆起当时场景时,他说:「我开始相信,正如我一直以来所相信的,我们需要做的是找到一种方法让计算机学习东西,而不是为它们手写出语法、规则和词汇表,我们应该让它们从语言数据中学习。最终,在我看来,我应该尝试了解更多关于计算语言学 / 自然语言处理的知识,而在那时,美国正是去学习这些知识的地方。」

在日本短暂教授英语后,曼宁教授接受了澳大利亚国立大学(ANU)语言学导师 Avery Andrews 的建议,申请了斯坦福大学。

他为了应对当时该校并未提供自然语言处理(NLP)的课程这一情况,选择作为语言学博士生入学,研究人类语言的句法,同时开始在附近的 Xerox PARC 工作,在那里他学习了计算语言学,并与一群开始使用数字文本进行统计 NLP 研究的人一起工作。

值得注意的是:这种数字文本当时才刚刚开始出现。

远在万维网出现之前,关于如何利用文本数据进行语言学研究,曼宁教授提供了当时他的视角:

「虽然这是在万维网之前的事情,但你开始能够获得像报纸文章、议会记录和法律材料这样的文本,所以你可以找到几百万字的文本,计算机中心会将这些数据写入 10.5 英寸的磁带,然后将这些磁带物理运送给他们的客户。像施乐(Xerox、IBM 和 AT&T 这样从事计算语言学的公司可以从新闻机构购买这些磁带,或者从允许他们使用数据的商业客户那里获得这些磁带的访问权。这真的很令人兴奋,因为这意味着我们第一次可以通过实际拥有大量文本数据来进行语言学研究,我们可以搜索这些数据中的模式,尝试自动学习人类语言的结构。」

在这段时间里,他对 1980 年代末开始的关于概率机器学习模型的新工作也感到着迷,并洞察到了其潜力。这些统计模型是当今机器学习的基本组成部分,它们考虑了现实世界数据固有的不确定性,并将之纳入预测中,从而允许对复杂系统有更准确的理解。

曼宁教授认为他成功的关键是愿意迅速投入到他认为将成功的重要新方法中。虽然他不是第一个看到从大量文本数据中学习并构建这些语言的概率模型的潜力的人,但由于在职业生涯的早期就参与了这项工作,他才得以达成今天的成就。

完成博士学位后,他成为卡内基梅隆大学(Carnegie Mellon University)第一位教授统计 NLP 的教员,在两年后选择与妻子 Jane 一起返回澳大利亚,在悉尼大学教授语言学。

然而,到了 1999 年,他作为助理教授回到了斯坦福大学,同时在语言学和计算机科学系任职。1980 年代中期就已经被积极探索的人工神经网络到了 2010 年,再次变得重要,曼宁教授再次拥抱了新技术的前景。

他强烈主张可以在自然语言处理中使用这些神经网络来理解句子,包括它们的结构和含义,最终曼宁教授和他的学生真的推动了这个想法,并成为这些神经网络在自然语言理解发展和使用中的关键。

在当时,他开始认真地使用这些网络来建模语言,着手构建能够解决语言理解问题的系统,比如判断某人所说的是积极的还是消极的,并最终做了很多关于使用神经网络方法学习人类语言的早期工作,这涉及到让这些模型理解、生成和翻译语言。

曼宁教授在 2010 年代关于将单词表示为实数向量,以及使用简单的注意力函数对单词之间的关系进行建模的工作,成为了今天使用的像 ChatGPT 这样的大型语言模型的前置基础。

关于他对计算机科学的巨大贡献,斯坦福大学计算机科学教授 Percy Liang 表示:「今天,我们显然应该在 NLP 中使用深度学习,但在 2010 年代初,这个想法遭到了激烈的抵制。但他仍做了重要的早期工作,展示了深度学习如何比之前需要大量特征工程的机器学习模型工作得更好。这最终促使了我们今天认为理所当然的现代 NLP 系统的发展。Chris 有远见,思考了它最终将如何具有变革性。」

曼宁教授至今的其他重要贡献包括:一系列帮助定义计算语言学领域的教科书、在 YouTube 上的在线 CS224N 视频课程、一个提供跨不同语言的一致性语法注释的框架 ---Universal Dependencies、为理解语言结构在语言处理中的作用的持续且必要的研究、以及致力于使 NLP 软件对所有人可访问的早期承诺。

斯坦福大学语言学和计算机科学教授 Jurafsky 对在曼宁教授在神经网络方面的研究表示:「现在人们可以简单地去网上,下载一个软件,然后构建一个神经网络。但是 20 或 30 年前,这并不是常态。Chris 和他的实验室在几十年前就建立了公开可访问的 NLP 软件库,并将其在线发布,并且一直推动这种方式成为世界的标准。今天,开源 NLP 软件的概念已经成为常态。」

目前曼宁教授也表示自己将继续努力创建具有对世界及其多种语言更深入理解的深度学习模型。

因为对他来说,人类语言是一件大众仍然不真正理解的惊人事物。但令人惊讶的是,婴儿不知怎么就弄明白了,小孩子最终能够从大约 5000 万个人类语言词汇中学会成为优秀的语言使用者。

而他们给最好的大语言模型展示了数万亿个词汇。从结果上来看,人类仍然更聪明。这是一个迷人的问题,构建计算机模型似乎是开始思考这个问题的一个富有成效的窗口。

本文来自微信公众号“机器之心”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI