猛然间,大模型圈掀起一股“降价风潮”。

前脚,智谱、DeepSeek等大模型厂商将API价格一降再降,输入100万tokens仅需1元。

紧接着,GPU租赁的价格也被打了下来。

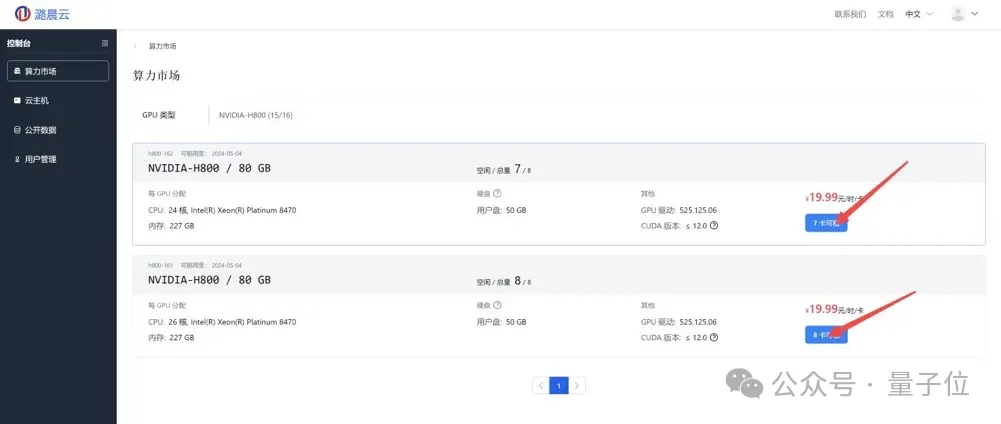

现在潞晨云官方进行限时大额算力补贴,NVIDIA H800的租用价格,低至6.99元/卡/时;NVIDIA A800为5.99元/卡/时,4090甚至低至1.39元/卡/时。

不只有租赁服务,平台上还支持快速简易部署Llama 3微调、训练、推理。

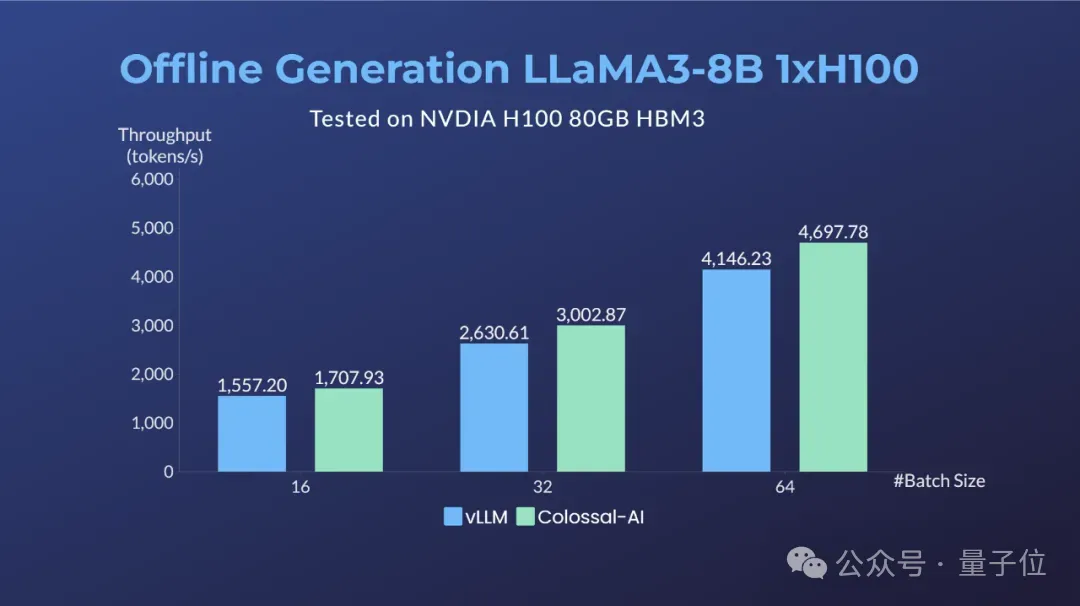

其中在64卡H100集群上,经过Colossal-AI优化,相比微软+英伟达方案,可提升LLaMA3 70B的训练性能近20%,推理性能也优于vLLM等方案。

Open-Sora也能玩转。

如上最新动向来自潞晨云(https://cloud.luchentech.com)。

他们不仅将个人开发者、中小企业用户玩转大模型的成本大幅降低,而且上手门槛也不高。

具体来看实操演示~

潞晨云提供一键部署功能,只需简单操作即可快速启动计算环境。

在最开始时需要先创建云主机。比如对Llama3微调训练,可在8卡H800上完成,在算力市场中选择即可。

此处选择Colossal-llama3训练微调镜像,单击创建按钮,创建云主机。

确认当前路径名,并修改config文件,输入教程中的Llama3训练脚本,本脚本已预置已处理数据集为例进行微调。

首先编译安装Colossal-AI,其次创建训练需要的文件夹,接着修改hostfile,在镜像中安装IP address指令,查看镜像内IP地址。输入IP address指令将机内IP地址复制并更新到hostfile中,就完成了Llama3微调的全部流程。

如果是对Llama 3推理,可在云主机上选择单张H800作为算力资源。

Colossal-Inference现已适配支持了LLaMA-3推理加速。

模型权重已准备好,无需额外安装。然后运行生成脚本:

单卡H100对LLaMA3-8B进行Benchmark结果与vLLM对比(例:输入序列长度128,输出长度256)。

而且支持常用的计算环境配置保存为私有镜像,随时调用,减少重复配置的时间,并保证环境的一致性和稳定性。

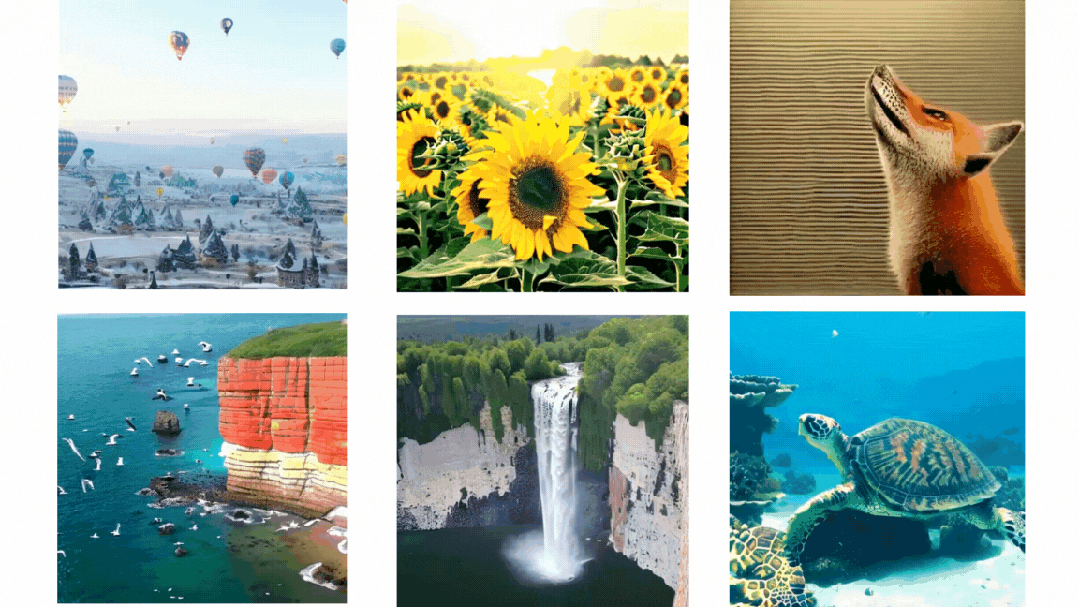

除了大火的语言模型外,潞晨云也支持视频生成模型部署。

前段时间,潞晨开源全球首个类Sora架构视频生成模型「Open-Sora 1.0」。

现在在潞晨云上即可部署Open-Sora推理。

Open-Sora推理可以在单卡H800上完成,可在算力市场中选择1卡H800。

潞晨云Open-Sora镜像中内置了运行环境,同时预置了Open-Sora权重,支持开箱即用。

值得一提的是,潞晨云是按秒计费模式,有效降低了不必要的成本支出,特别适合短期或动态计算任务。

除了复杂机器学习模型训练、海量数据分析外,还支持高性能图形渲染,能为广泛应用场景提供强大的计算支持和优化方案。

用户在此还能利用市场波动实现成本优化,通过算力市场提供潮汐定价机制,用户可根据需求和预算选择不同的算力资源,

最近他们正在搞特别活动,提供百万补贴并定期发放代金券。

用户在社交媒体和专业论坛(如知乎、小红书、微博、CSDN等)上分享使用体验,有效分享一次可得100元代金券。每月最佳分享可额外再获500元代金券。

在平台分享AI应用镜像等,可根据后续平台用户的调用时长,获得现金奖励。同时还在社群中不定时发放特价资源、代金券等优惠活动。

感兴趣的童鞋,戳下方链接即可了解更多详情!

https://cloud.luchentech.com

本文来自微信公众号”量子位“

04:01