Ilya前脚刚离职,OpenAI超级对齐团队负责人Jan Leike,紧接着也官宣了。

评论区的下方,网友疯狂留言,「你们究竟看到了什么」?

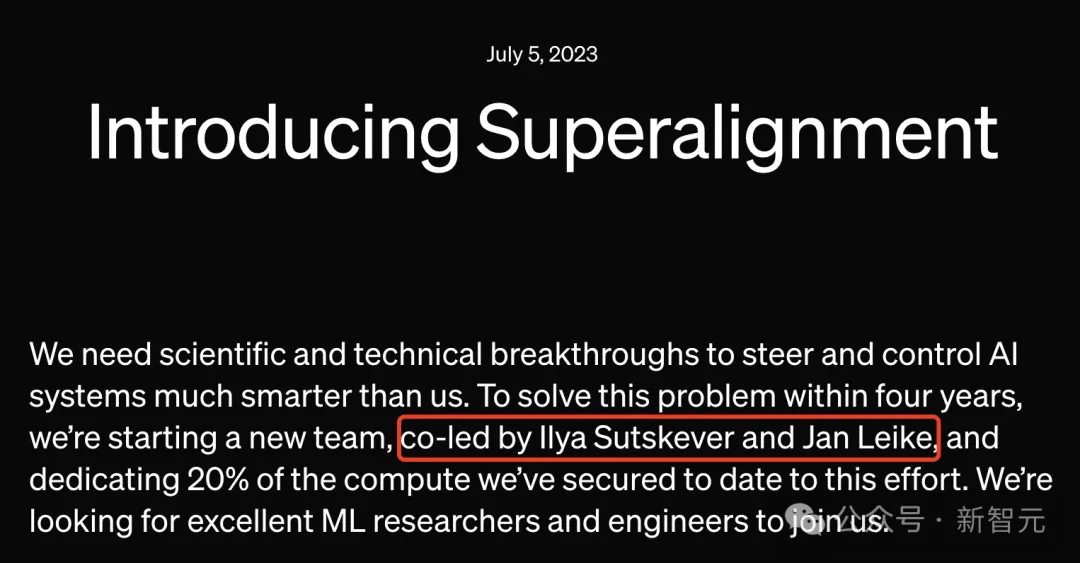

2023年6月5日,OpenAI首次对外宣布成立了「超级对齐AI团队」,是因为预测到AGI可能会在十年内到来。

根据介绍,「前」首席科学家Ilya Sutskever和Jan Leike是最新团队的共同领导。

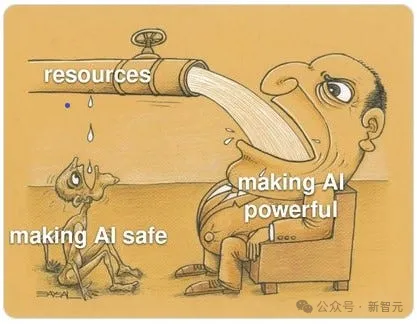

这一团队成立的目标是,试图用20%算力,在未来4年解决「超级智能对齐问题」。

超链接——OpenAI预言:超级智能10年内降临!正集结算力拯救人类,4年彻底攻克对齐

不仅如此,此前有爆料称,「超级对齐团队」已有员工主动离职,是因为对OpenAI负责人遵守AGI失去信心。

此外,该团队中还有2位因为泄密还被开除。

超链接 OpenAI内斗第二弹!Ilya亲信、超级对齐团队2人惨遭开除,被批泄密

而如今,核心leader离职,对于OpenAI来说,意味着什么?这一团队的目标还将继续吗?

马斯克曾对Ilya的评价是,「他是OpenAI成功的关键」。甚至,他还为了招聘Ilya,与拉里·佩奇关系破裂。

经常曝料OpenAI的内幕人Flowers表示,「Jan和Ilya只有在两种情况下才会离开OpenAI——

要么是AGI已经完成对齐,要么就是AGI根本不可能实现」。

本来,前一天的OpenAI线上发布会,GPT-4o旗舰模型炸裂演示,让出许多人纷纷看到了AGI的未来。

但,这一波离职官宣,又让人们对OpenAI内部产生了诸多疑问。

难道,使命已经完成,AGI/ASI早已实现了吗?

有Reddit网友称,自己根本不关心Jan Leike是谁,但他也随着Ilya也离开了,更想知道的是——

OpenAI究竟发生了什么?

然鹅,评论区的「画风」是这样的:

他们内部已经有了AGI,现在他们已经被取代了,想要放松一下。

他们内部已经有了AGI,并得到了离开公司的指示,他们乖乖地遵守了。

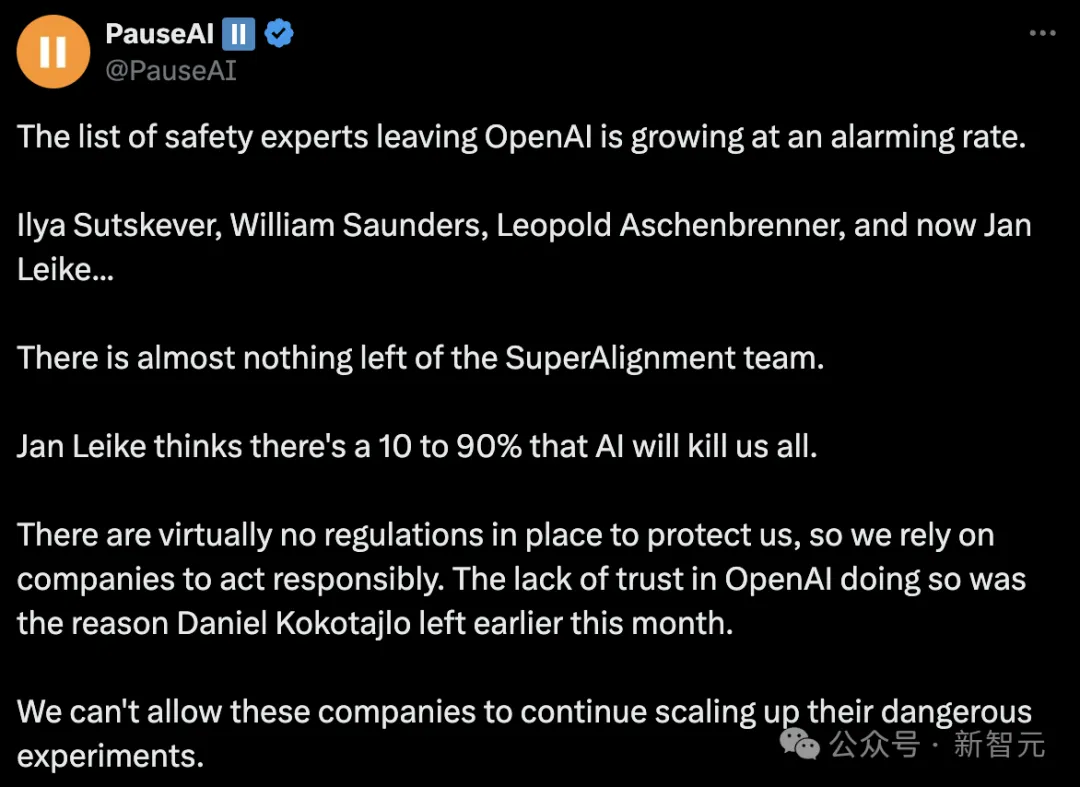

关注AI风险的社区PauseAI发帖称,超级对齐团队几乎什么都没有了。

「离开OpenAI的安全研究科学家名单,正在以惊人的速度增长。从Ilya Sutskever、William Saunders、Leopold Aschenbrenner,再到Jan Leike...

Jan Leike曾认为,有10%-90%的人工智能会杀死我们所有人」。

这肯定意味着超对准问题已经解决,工作完成了。他们计划用4年时间完成这项工作,但只用了10个月。

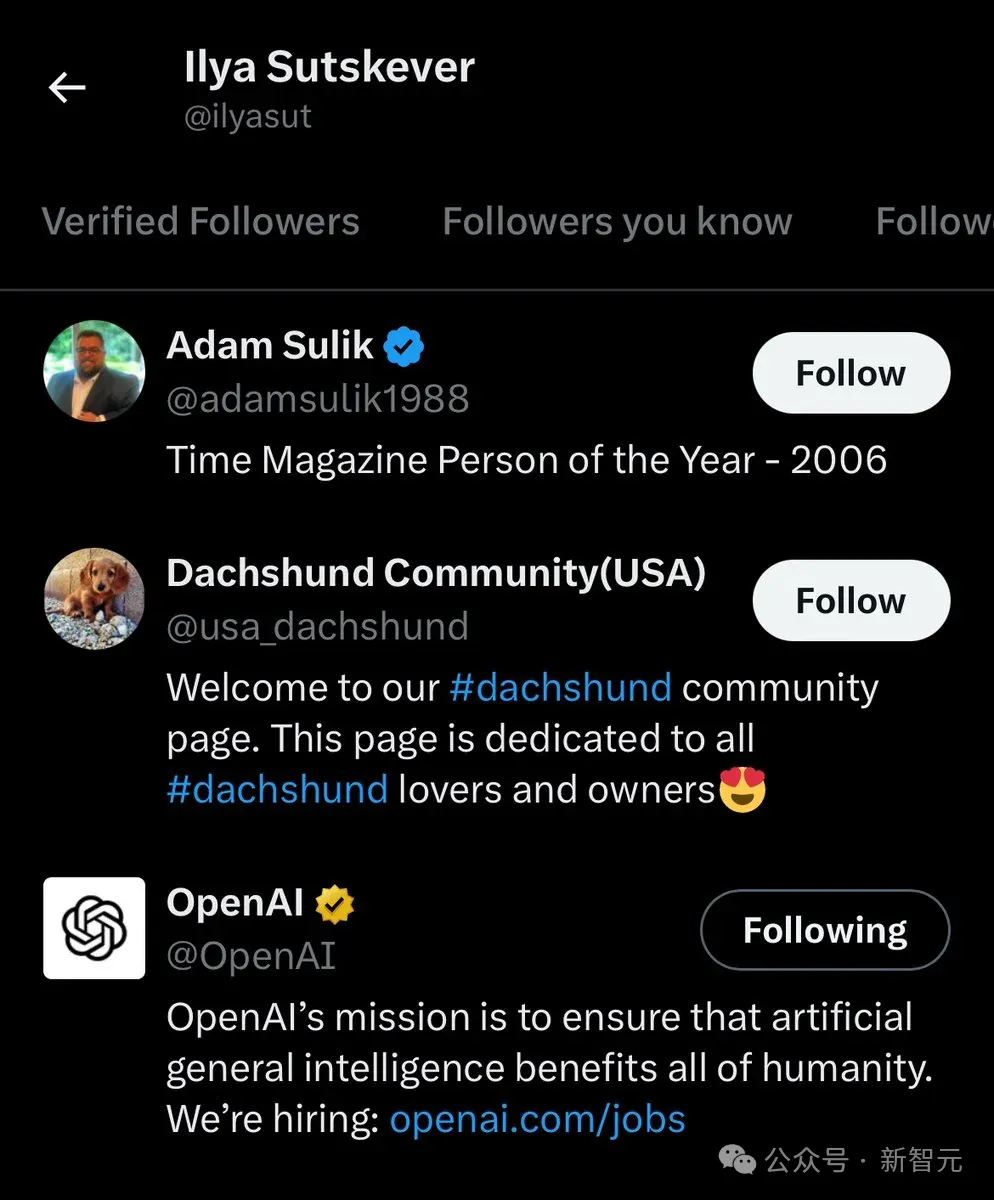

爱吃瓜的网友发现,Ilya官方账号只关注了3个账号——

OpenAI、Dachshund Community,以及Adam Sulik。

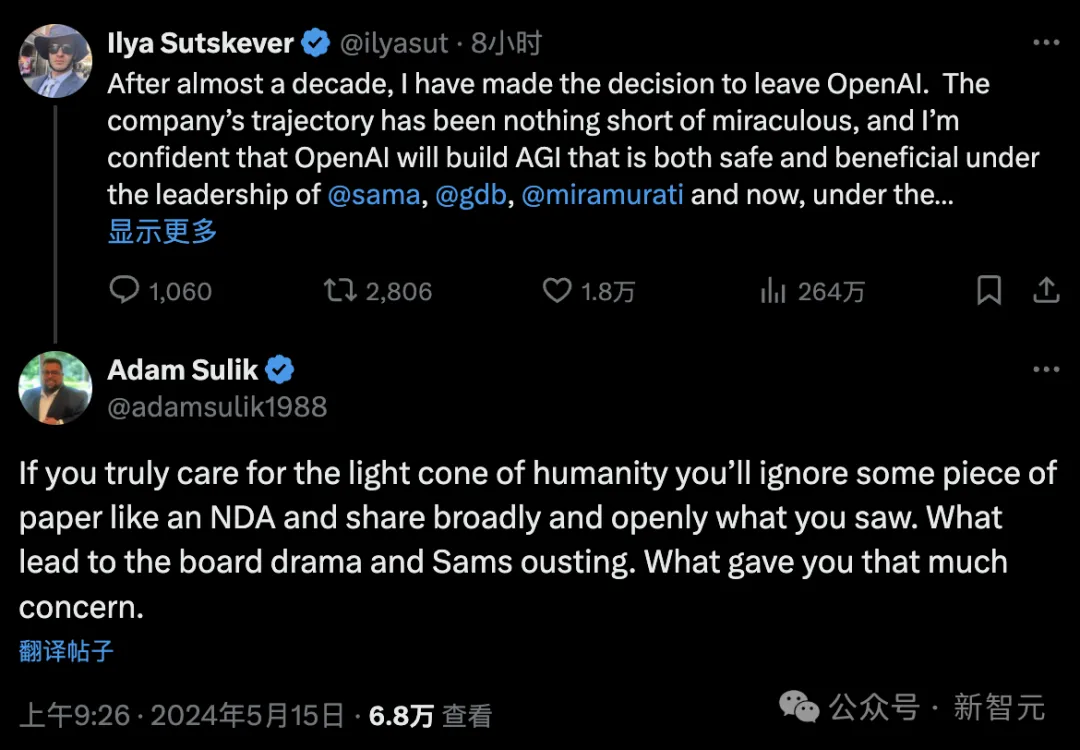

真正的重点是,Adam Sulik在Ilya离职的帖子下面直言道:

如果你真正关心人类的未来,你就应该无视一些像保密协议这样的文件,广泛公开地分享你所看到的一切。说出导致董事会纠纷和Sam被赶下台的原因。告诉大家是什么让你如此忧虑。

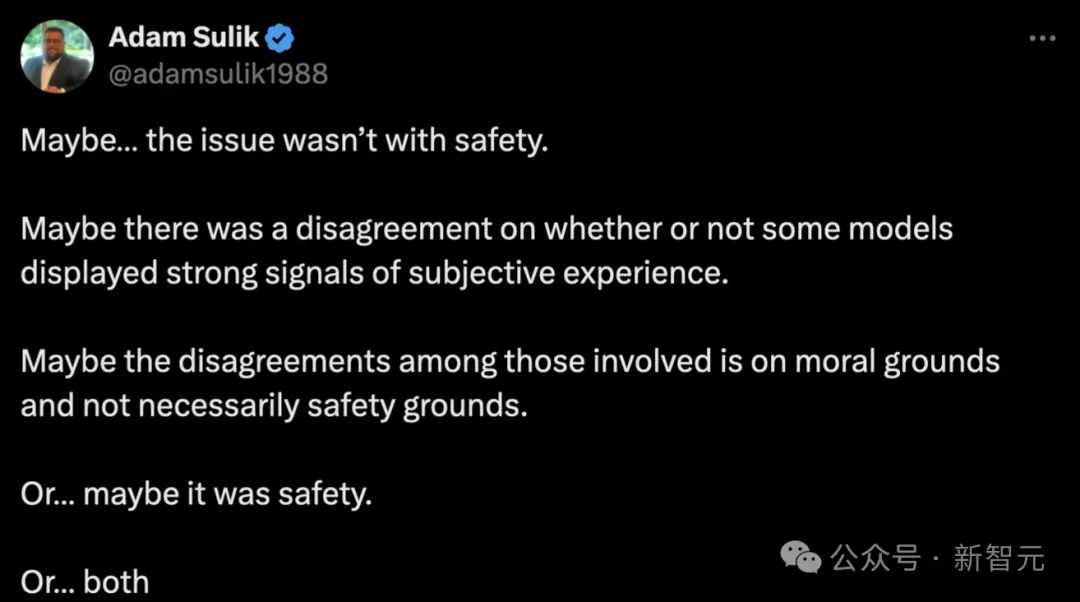

接着,Adam经过深思熟虑后,又从全面角度分析了这一问题:

也许是…问题不在于「安全问题」。

也许,他们对于一些模型是否显示出强烈的主观体验信号(即出现意识),存在分歧。

也许,涉及其中的人之间的分歧是基于「道德」原因,而不一定是出于安全原因。

或…也许这是出于安全考虑。

或…两者都有。

同样,有Reddit网友表示,Jan Leike的离职,显然是对OpenAI幕后发生的事情表现得非常不满意,甚至连掩饰都没有。

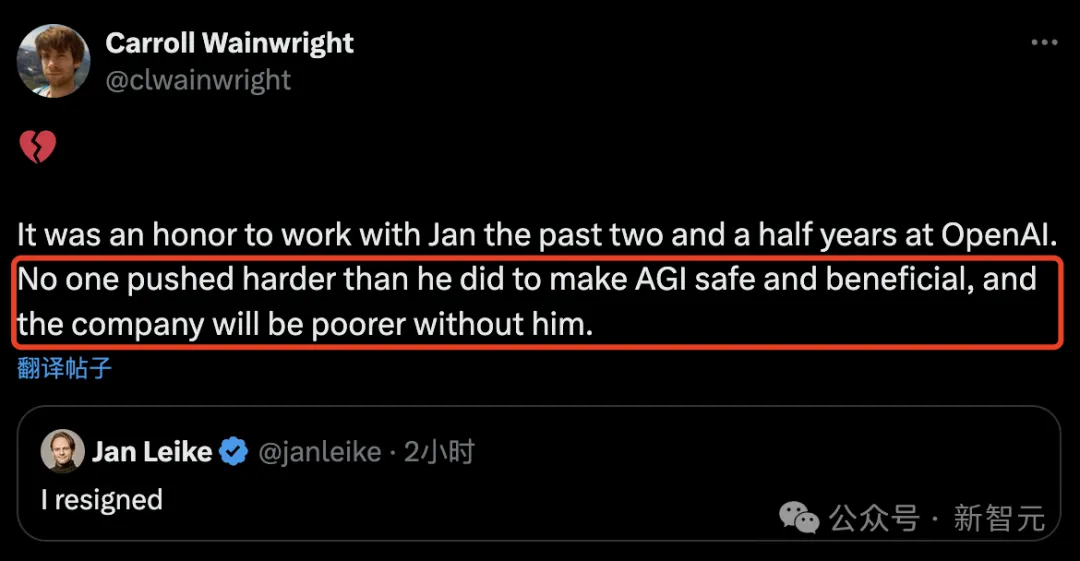

曾与Jan Leike共事的伙伴高度赞赏道,为确保AGI的安全性和有益性所做出的巨大努力,Jan是无人能及的。

几天前,Business Insider曾报道称,有两名OpenAI分别负责治理和安全的人员主动离职了。

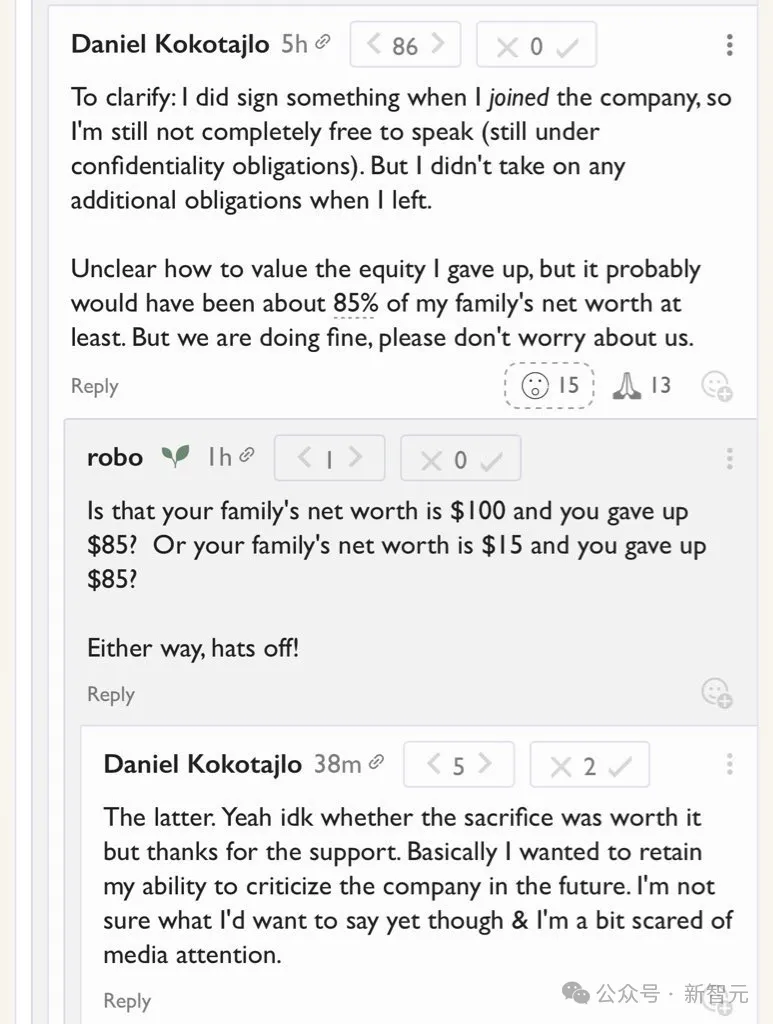

一位是Daniel Kokotajlo,还有一位是William Saunders。

据介绍,Kokotajlo是在4月份刚刚离职,而Saunders早在今年2月离开了OpenAI。

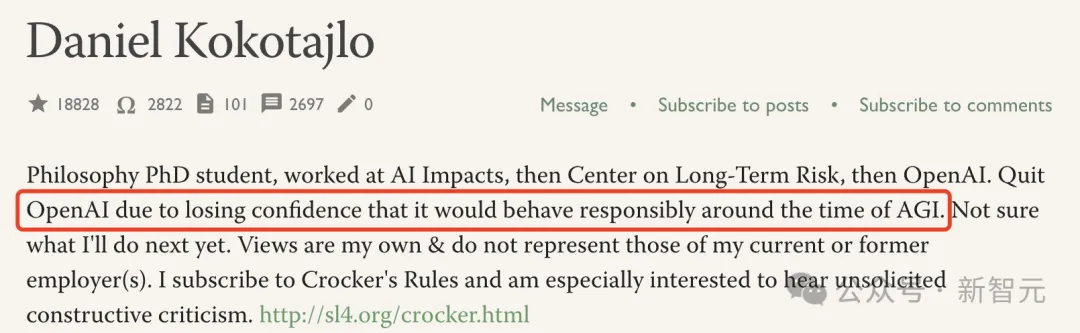

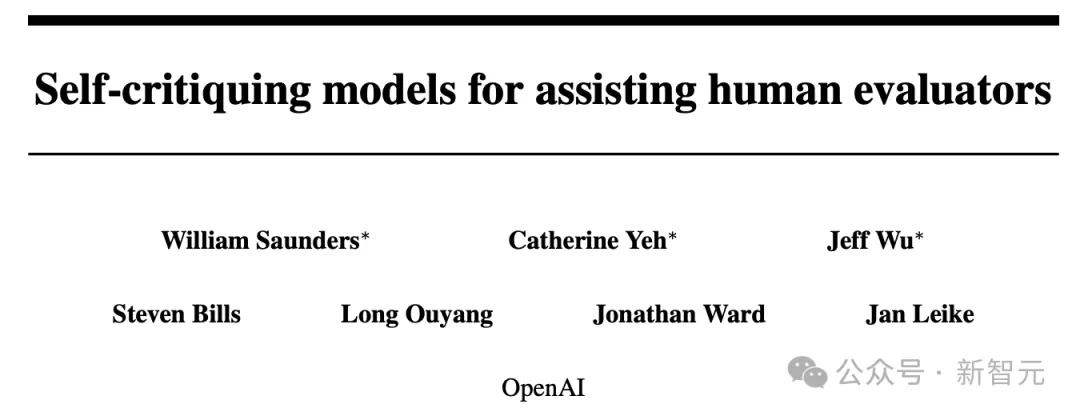

在治理团队工作的Kokotajlo,曾是GPT-4对抗性测试者。Saunders自2021年以来,一直在对齐团队工作,随后转入「超级对齐」团队。

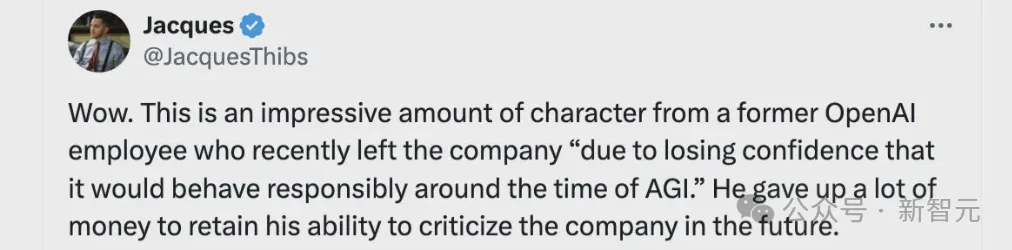

Kokotajlo在其主页上的介绍中,称自己离职OpenAI,是因为对其在实现AGI关键时期,可能的不负责任行为失去了信心。

上个月,他甚至在自己主页中另一篇帖子中表示,解释了他决定离开的原因之一。

与此同时,他还参与了一场关于暂停AGI发展的讨论。’

Saunders是在自己的LessWrong个人资料页面上,发表评论透露了,自己离职的消息。

值得一提的是,Saunders去年曾参与过罢免Sam Altman风波事件。

同时,他也是OpenAI「可解释性团队」的主管,研究如何使AGI安全,并弄清模型如何以及为什么这样做。

近期,OpenAI还经历了其他高管的变动。

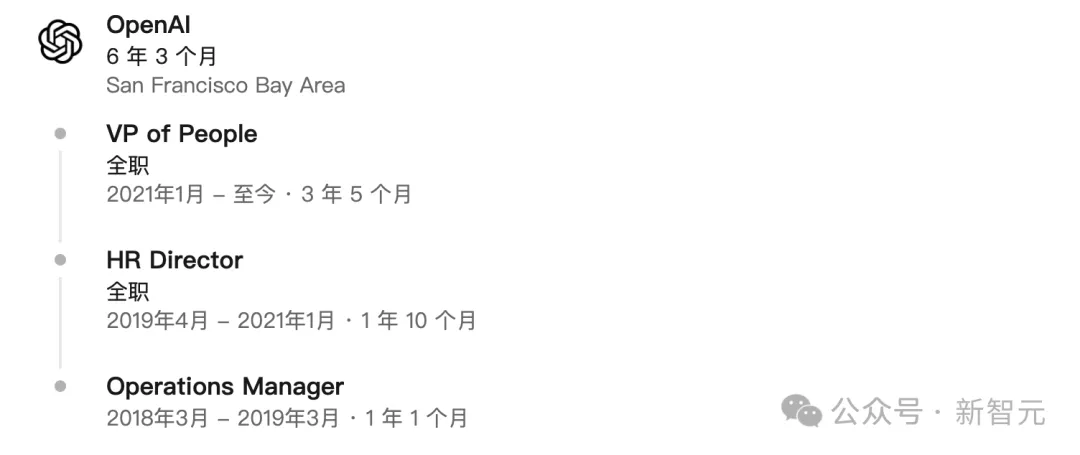

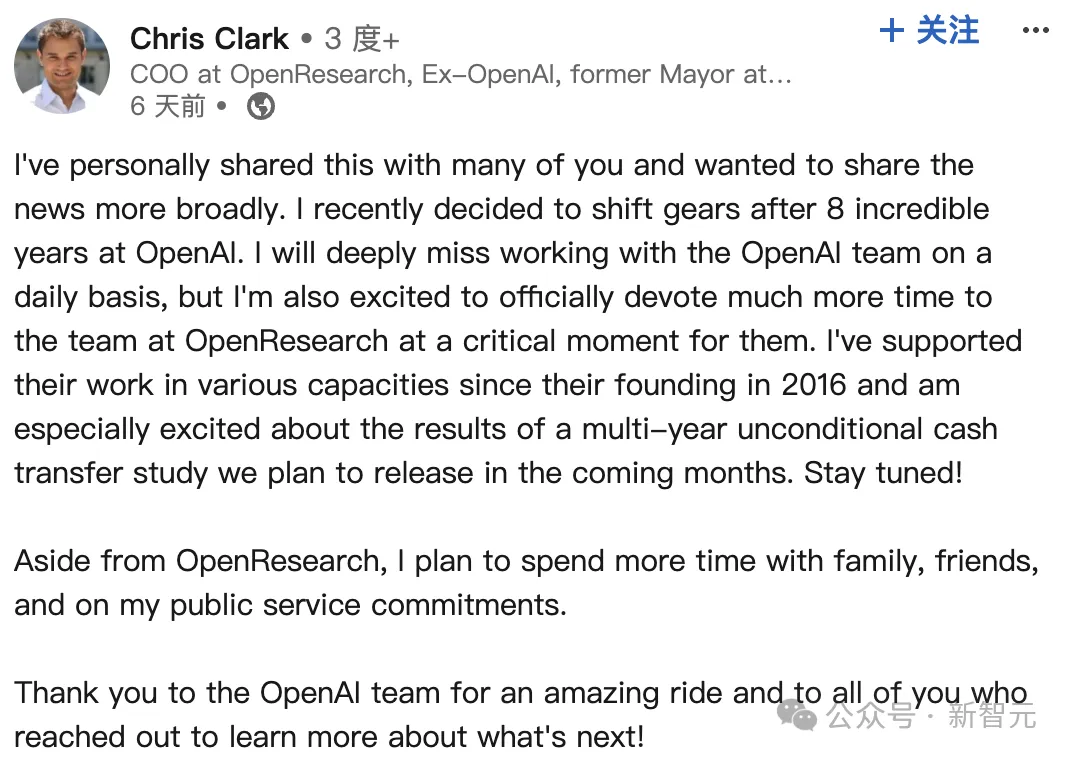

上周,Information报道称,OpenAI两位高级高管已经离职——人事副总裁Diane Yoon和非盈利及战略倡议负责人Chris Clark。

这两人辞职,是在Altman离职风波后,由负责管理OpenAI的非盈利董事会再次聘用Altman的背景下发生的。

而这些事件,从另一个侧面突显了OpenAI独特的企业结构。

据称,这两位高管都是开发ChatGPT的团队中,任职时间最久的管理人员。

OpenAI发言人Kayla Wood在一份声明中表示,Yoon将在今年剩余时间内继续担任公司的顾问角色。目前担任人力资源负责人的Julia Villagra将接替Yoon成为人事副总裁。

Yoon自2018年加入OpenAI,负责人事业务,见证了OpenAI员工数显著增长(去年末已超过700人)。

去年11月,Altman被赶下台,她还管理了一周的动荡期,当时许多员工因不满Altman被解雇而威胁辞职。

而Clark在OpenAI工作已经超过8年,他自2016年起担任公司首位首席运营官。

根据税务文件,他还在2016年至2017年间担任该非盈利组织的董事会成员。

Clark此前与Altman在Y Combinator及其支持的位置共享初创公司Loopt合作,后者由Altman于2005年共同创立并最终出售。

2022年5月,Clark担任了新的职务,负责领导OpenAI的非盈利部门及多个全球运营职能,包括房地产、工作场所和战略倡议。

Clark在给员工的一封信中表示,「经过八年的精彩岁月,我决定退一步,更多地关注我在OpenAI之外深爱的人和项目」。

或许,OpenAI内部正在上演一部「权利的游戏」。

本文来自微信公众号”新智元“