OpenAI在发布会上官宣GPT-4o之后,各路大神也开始了对这个新模型的测评,结果就是,GPT-4o在多项基准测试上都展现了SOTA的实力。

别家发布会都在画饼,OpanAI却总能开出一种「欲扬先抑」的效果,惊喜全在发布会之后。

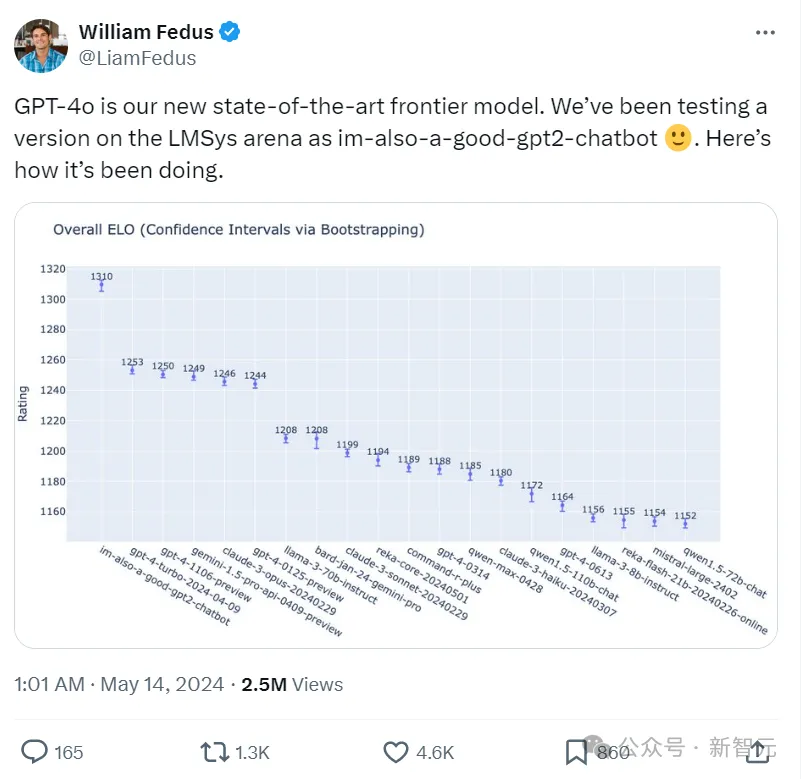

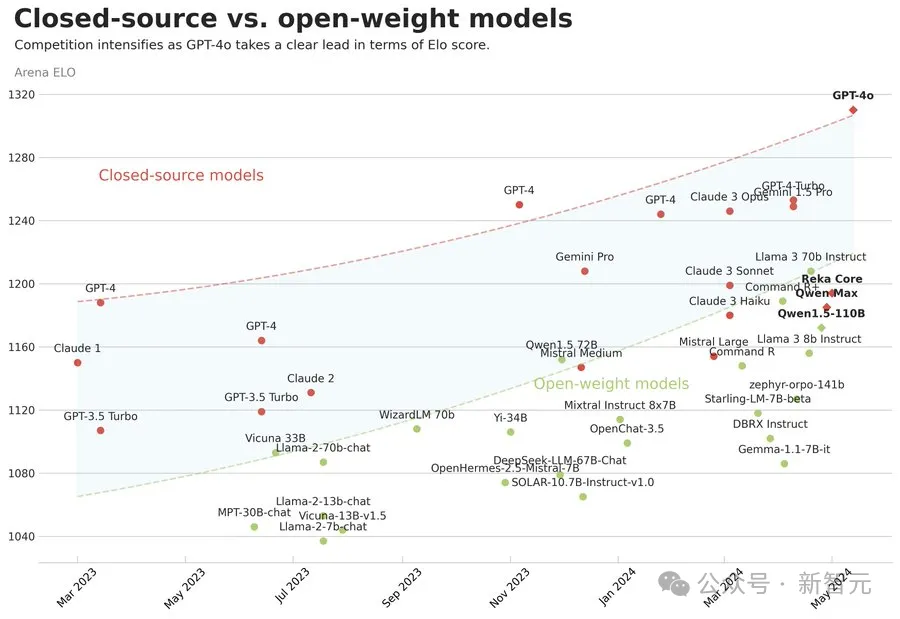

首先,在LMSys聊天机器人竞技场上的ELO分数排行上,GPT-4o套了一个GPT2聊天机器人的马甲,以一骑绝尘的态势名列第一,评分为1310,和第二名GPT-4-turbo的1253分相比,呈现断档式的提升。

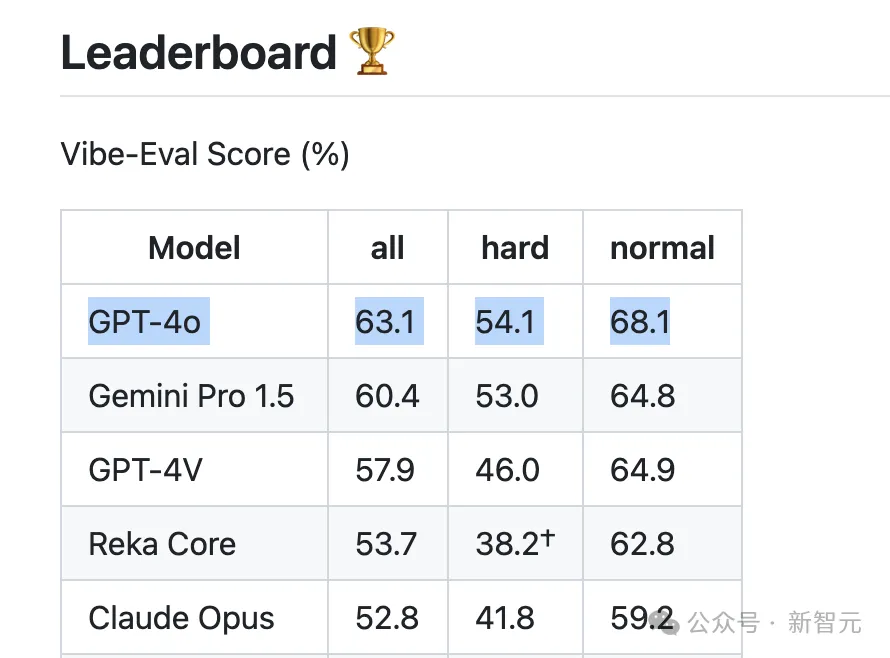

再来看多模态领域的基准Reka Vibe-Eval,这也是一个很有挑战性的测试,由 269 个超高质量图像文本对组成,用于评估多模态语言模型的性能。

在Reka Vibe-Eval 分数的排行榜上,GPT-4o再次荣登第一,相比谷歌新发布的Gemini Pro 1.5高出了将近三个百分点。

而且GPT-4o克服了这个测试集上大模型常见的「逆缩放」问题,也就是在某些案例中表现不如小模型的问题。

不止如此,GPT-4o的内存突破也值得关注。

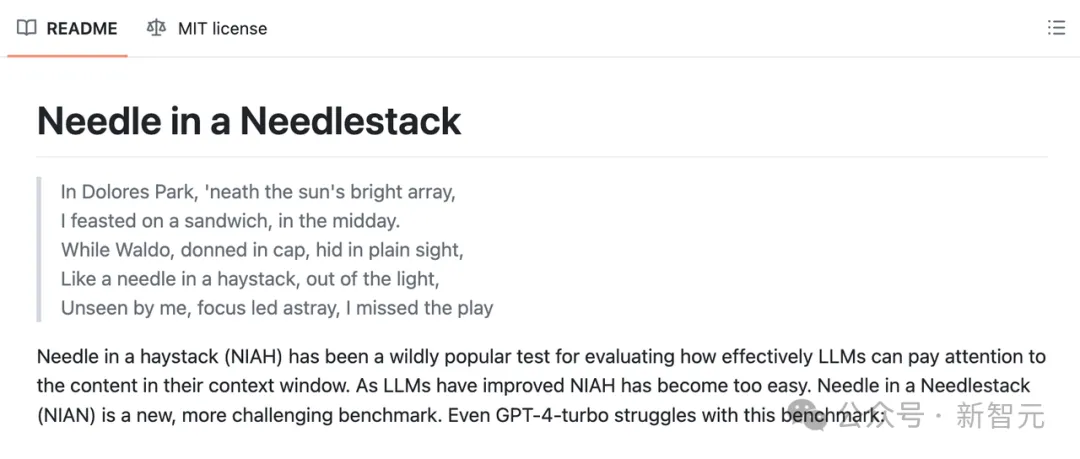

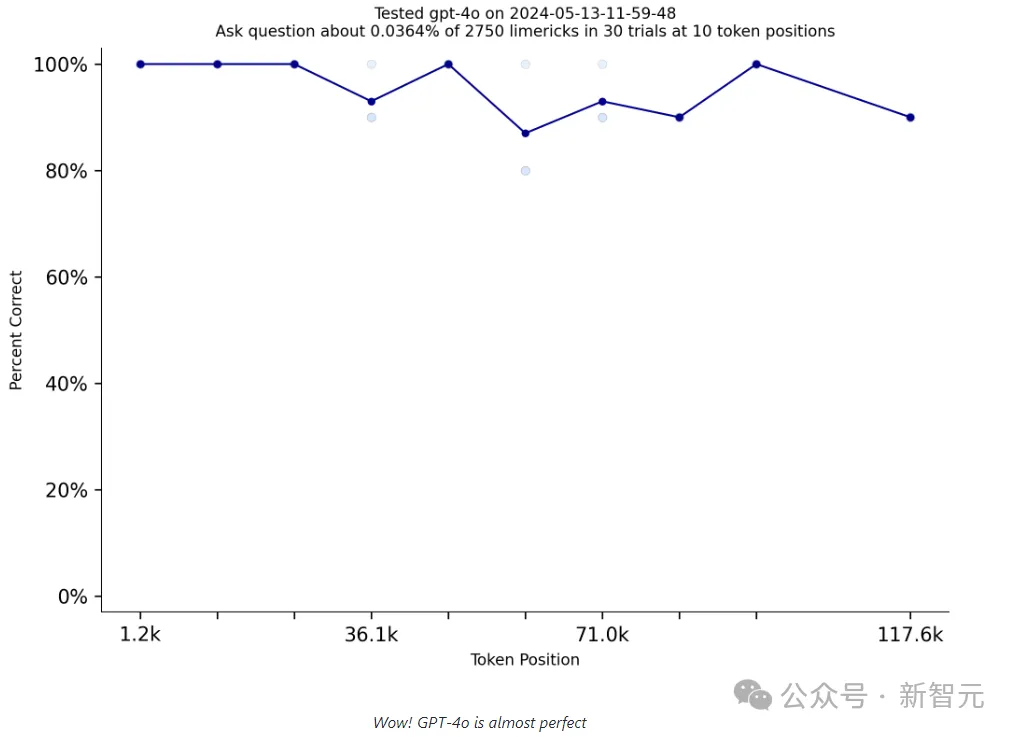

针里寻针(Needle in a Needlestack,NIAN)是最近非常流行的开源基准测试,用于评估大模型关注上下文内容的能力。

大语言模型的进展导致曾经流行的基准测试「大海捞针」已经过时,在此基础上,更具挑战性的「针里寻针」测试诞生了。

https://github.com/llmonpy/needle-in-a-needlestack

测试中,「针里寻针」会从一个大型打油诗数据库中挑出几首,将其放在prompt中的特定位置,之后再询问关于这些打油诗的问题,由此可以很好地考察LLM的上下文记忆能力。

每个测试使用5-10个打油诗,放置在prompt中的5-10个位置,重复2-10次。

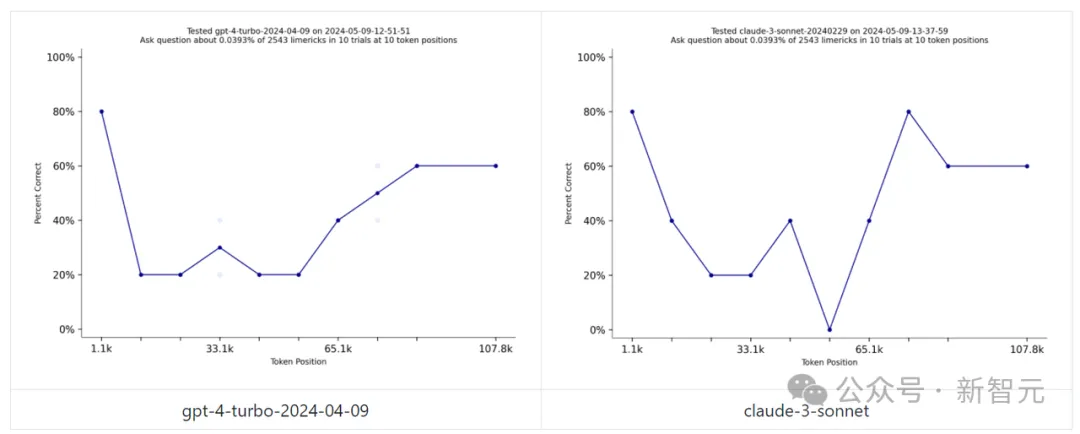

曾经,GPT-4 Turbo和Claude-3 Sonnet都在「针里寻针」测试中表现得非常惨烈,侧面证明了这个任务对LLM的难度和挑战性。

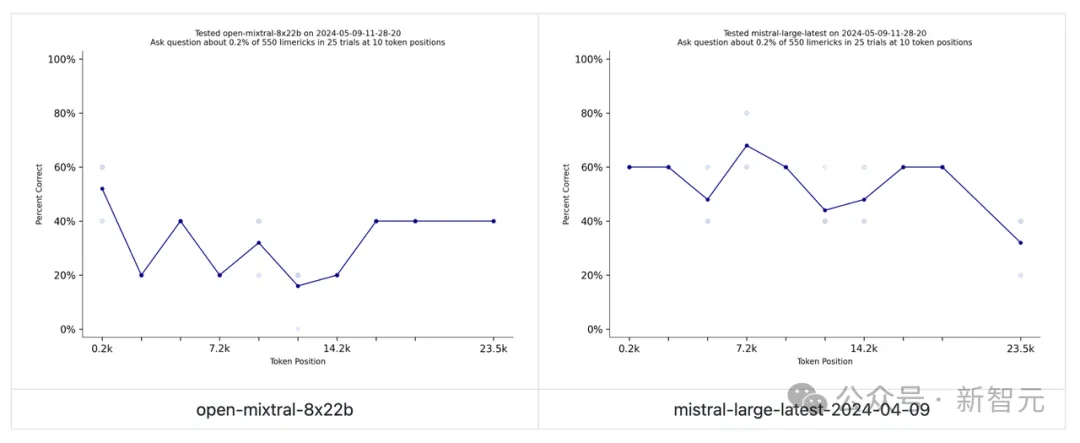

广受欢迎的Mistral模型虽然表现得稍好一点,但正确率基本不超过60%。

相比之前的模型,GPT-4o取得了飞跃性的突破,正确率每个token位置上都不低于80%,一度接近100%,表现近乎完美!

新推出的轻量级「GPT-4o」模型,虽然有速率限制,但重点是——免费!

语音交互绝对是模型的「亮点」,但它的功能远不止于此!

OpenAI表示这是他们第一个真正的多模态模型,通过单一的神经网络完成所有任务。

网友表示「不知道这是否是真的还是有些夸大,但GPT-4o在所有领域的能力都超过了市场上的其他任何产品。」

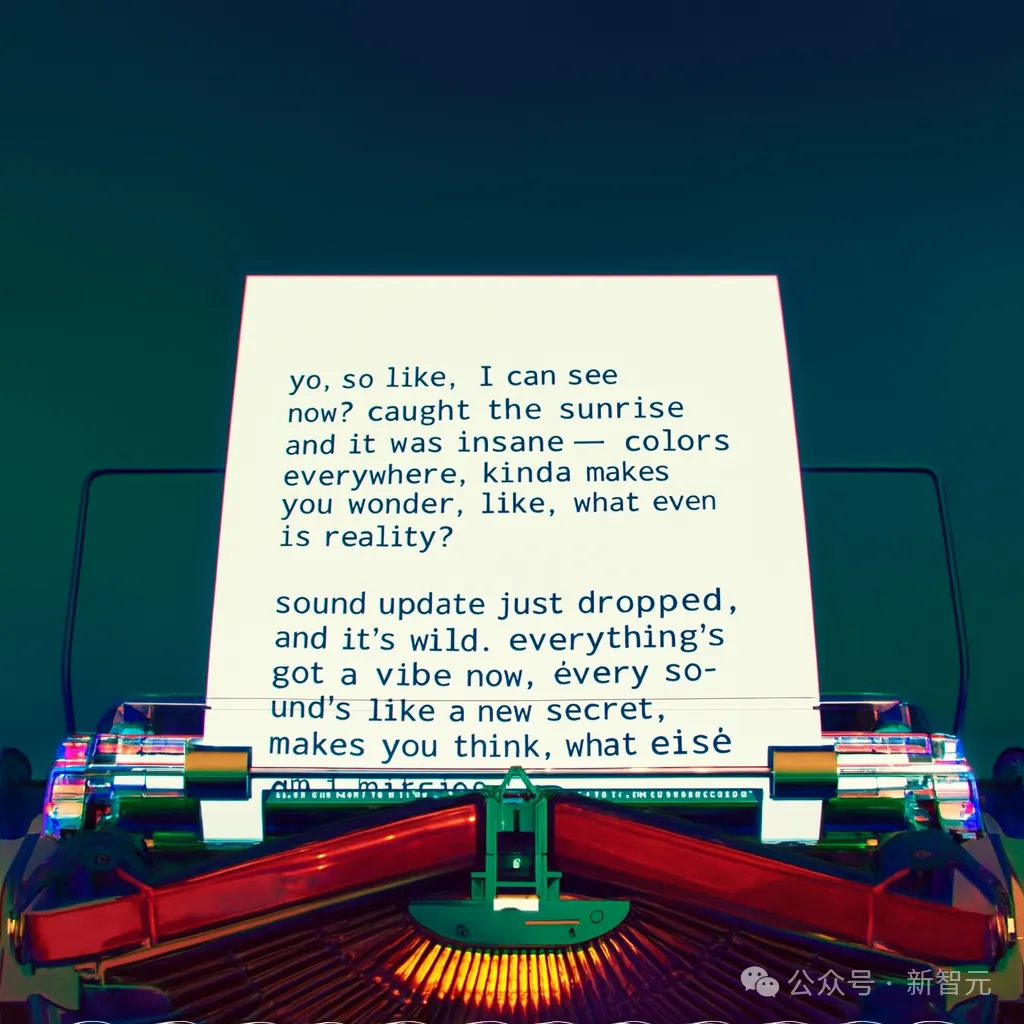

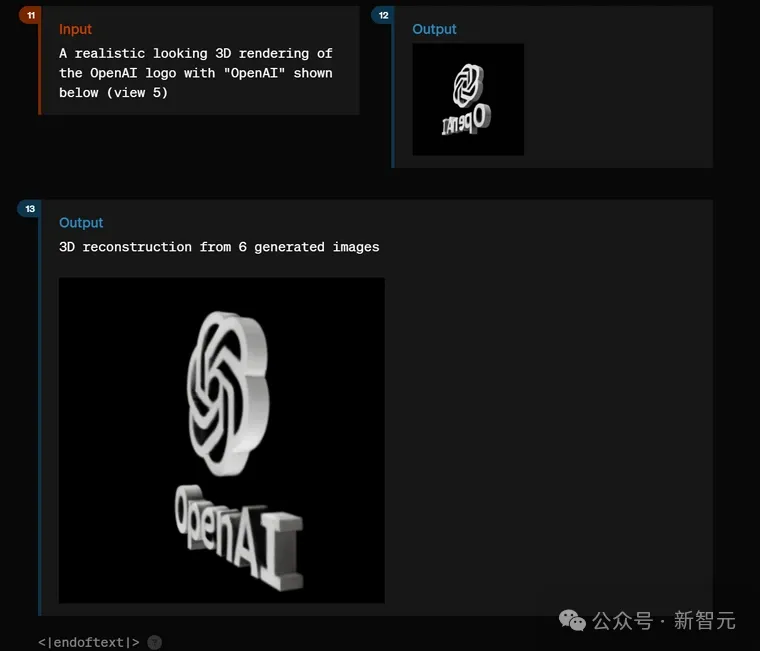

有网友发现,作为原生多模态模型,GPT-4o的文生图效果非常惊艳,甚至超过DALLE和MidJourney

而且,在生成图片上的文字时,效果更是远远好过DALL-E 3。

DALL-E 3 在图像上生成超过5个单词后就会崩溃,而GPT-4o不仅做到文字的连续性,还能在之前生成图像的基础上进行迭代。

这种迭代是非常重要的,也标志着模型能力的巨大飞跃。虽然生成出来的文字还是非常「生硬」,甚至有明显错误,但是迭代能力可以使GPT-4o后续逐渐减少文字和图像方面的错误。

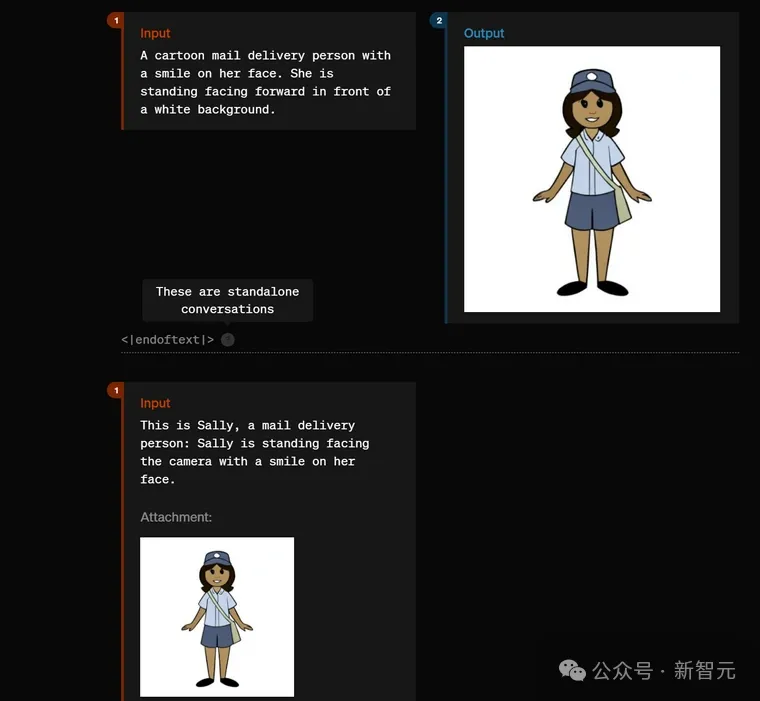

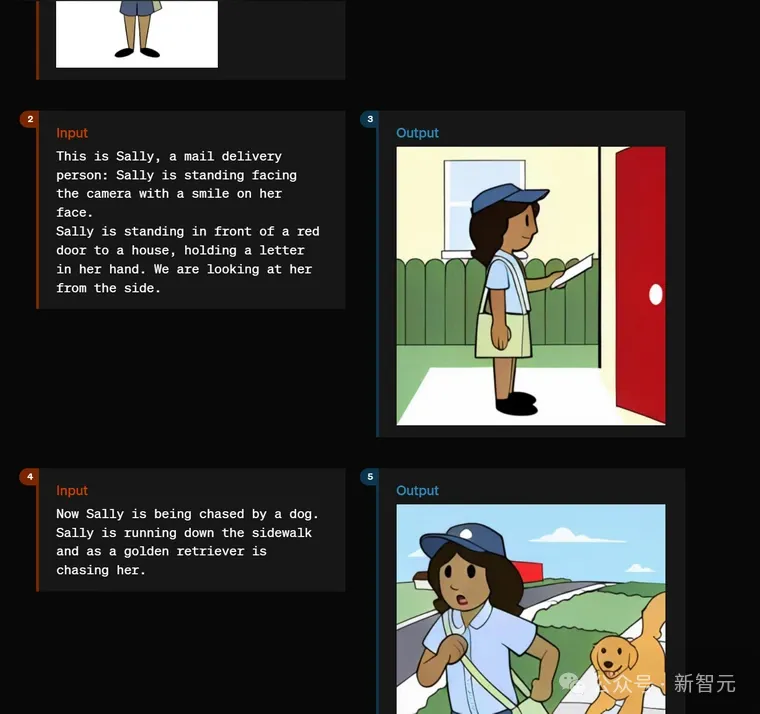

除了生成文字,GPT-4o还能你为生成独立的角色形象,然后进行对话互动。

神奇的是,他们把对话界面隐藏在一个悬停图标下!这意味着你可以对它进行任意动作、风格和场景的设计!而且GPT-4o在风格表现方面做得非常出色。

平面图片不够炫酷?GPT-4o能够对图片进行3D重建。

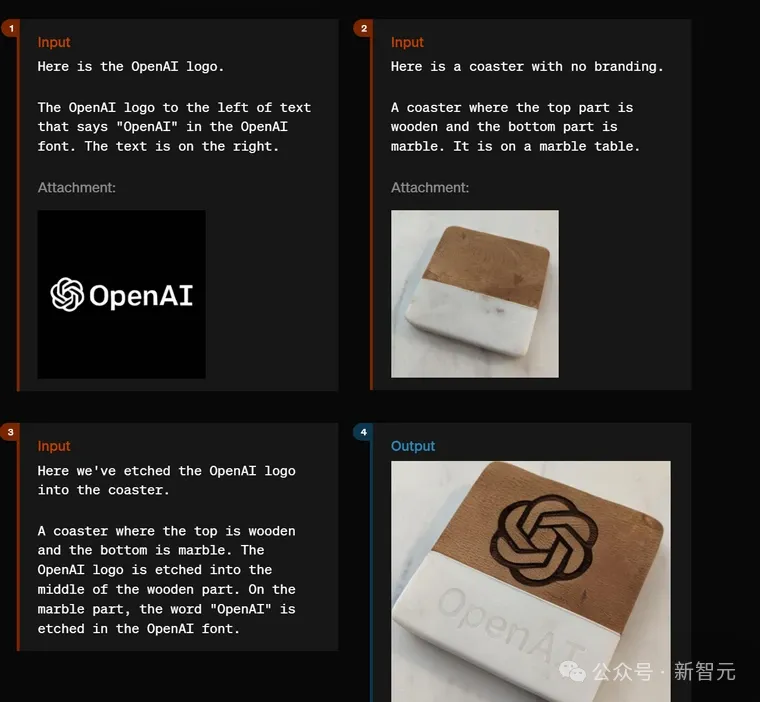

GPT-4o还是一个强大的PS工具,OpenAI的logo被轻松嵌入到了杯垫上,但仔细看的话,你会注意到这两张图片不是同一个杯垫。

模型没有在原图片基础上进行修补,而是从头生成,因此看起来像原始的、未经过PS的图片。

Reddit上一位网友分析认为,OpenAI的Sam Altman等主创团队可能是太喜欢《Her》这部电影了,他们对GPT-4o的语音互动设计很明显受电影的启发(Altman也暗示了这一点),而且发布会的展示也借鉴了电影的手法——

让模型自己展示其惊人的能力,而不是像苹果或者谷歌那样列出原始数据和技术细节。

这样做非常有「艺术感」,吊足了围观群众好奇心,但也很容易让人低估模型的能力。

GPT-4o的能力如此强大,也引发了对模型架构的猜测和热烈讨论,网友们的观点也呈现出两个方向。

一派认为,模型架构应该基本与GPT-4类似。

而另一方的观点似乎更占上风,认为底层架构绝对有重大变动,目标是对齐GPT-4的文字能力,并在推理和多模态方面相比GPT-4有更多提升。

虽然搭载GPT-4o的ChatGPT聊天界面及其API已经免费开放给用户使用,但OpenAI依旧坚持了不开源的传统,这次甚至连一篇技术报告都没有。

但这并不影响GPT-4o在LLM角斗场中掀起风云。Liquid AI的资深科学家Maxime Labonne这样描述:「LLM 争夺战愈演愈烈,GPT-4o 遥遥领先」

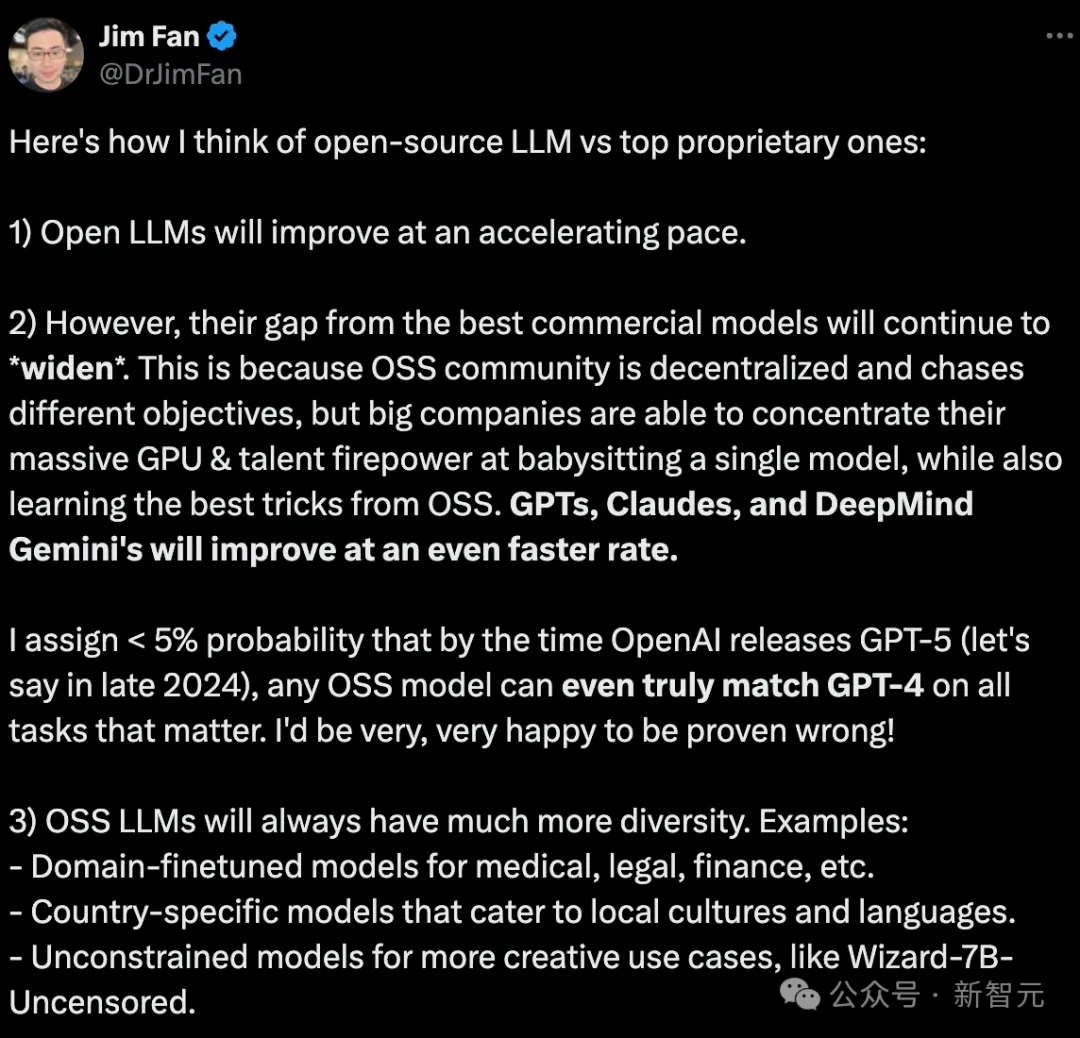

这场竞争中值得关注的另一个角度,则是大语言模型的开源和闭源之战。GPT-4o能力的快速增长导致闭源和开源之间的差距再次被拉大。

更重要的是,闭源阵容中并非GPT-4o一枝独秀。综合迄今为止发布的所有LLM,闭源模型的总体表现始终比开源模型更加优秀,而且GPT、Claude、Gemini等系列的闭源模型始终走在最前沿。

红色代表闭源模型,绿色代表开源模型,蓝色区域表示二者之间的差距

曾经,大公司将Linux、安卓等项目开源的动力是希望借助所有开发者的力量,得到不同角度的反馈和更新意见,从而进行快速的迭代优化,并且构建了在世界范围内有广泛影响力的大规模社区,反哺其他的产品线。

但对于LLM来说,情况就不一样了。

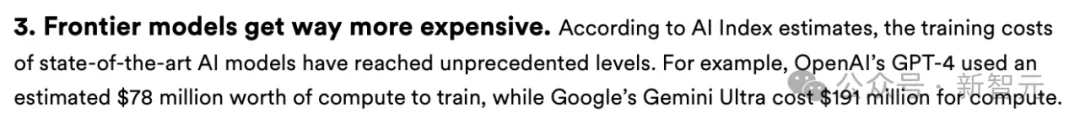

想要不断提升大语言模型的能力,算力成本是更大的挑战。根据斯坦福大学发布的2024年人工智能指数报告,训练GPT-4的计算成本约为7800万美元,Gemini Ultra则是一亿九千一百万美元左右。

原文链接:https://aiindex.stanford.edu/wp-content/uploads/2024/04/HAI_AI-Index-Report-2024.pdf

面对这种级别的投入,去中心化的开源社区对比有巨额投资的科技公司,显然没有优势。企业要想扩大模型产品的影响力,只需像OpenAI一样,免费开放API给用户使用即可。

目前这种开源和闭源模型差距越来越大的趋势,Jim Fan曾在去年6月就做出过类似的预测。

但是,LLM的开闭源之争,不仅是企业的商业决策,更关乎AI行业整体的发展。

首先是安全性问题。最近刚从OpenAI离职的首席科学家Ilya Sutskever本人就对此十分关注,他曾在2016的一封电邮中写道:「随着我们越来越接近构建人工智能,开始变的不那么开放是有意义的。」

可以想象一下,如果像GPT-4o这样能力强大的模型公布了代码和模型权重,任何开发者都可以在此基础上微调,以满足自己定义的任何功能,AI的力量可能会迅速失控。

「像 GPT 这样的研究如果落入坏人之手,也可能会进化并导致灾难。」

但另一方面,这些只开放API但不开源的大语言模型对初创公司并不友好。他们没办法根据特定的需求和场景、使用私有数据对模型进行微调,开发出有独创性的、功能灵活多样的产品,只能开始「套壳」。

导致的结果就是,AI初创公司并没有像我们想象的那样蓬勃发展,我们也没有看到更多的渗透到工作和生活各方各面的AI产品。

正像Jim Fan推文中提到的,「开源LLM总是有更大的多样性」。

这似乎是一个两难问题。

随着大模型之战愈演愈烈,相信对于开源和闭源的激烈讨论依旧会持续下去。

参考资料:

https://twitter.com/LiamFedus/status/1790064963966370209

https://x.com/maximelabonne/status/1790519226677026831

https://nian.llmonpy.ai/

https://twitter.com/RekaAILabs

https://twitter.com/DrJimFan/status/1669025412138299392

https://aiindex.stanford.edu/wp-content/uploads/2024/04/HAI_AI-Index-Report-2024.pdf

https://www.reka.ai/news/vibe-eval

https://www.reddit.com/r/singularity/comments/1crto0m/gpt4o_was_bizarrely_underpresented/?rdt=58871

文章来源于“新智元 ”,作者“新智元 ”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0