在当今数字化时代,3D 资产在元宇宙的建构、数字孪生的实现以及虚拟现实和增强现实的应用中扮演着重要角色,促进了技术创新和用户体验的提升。

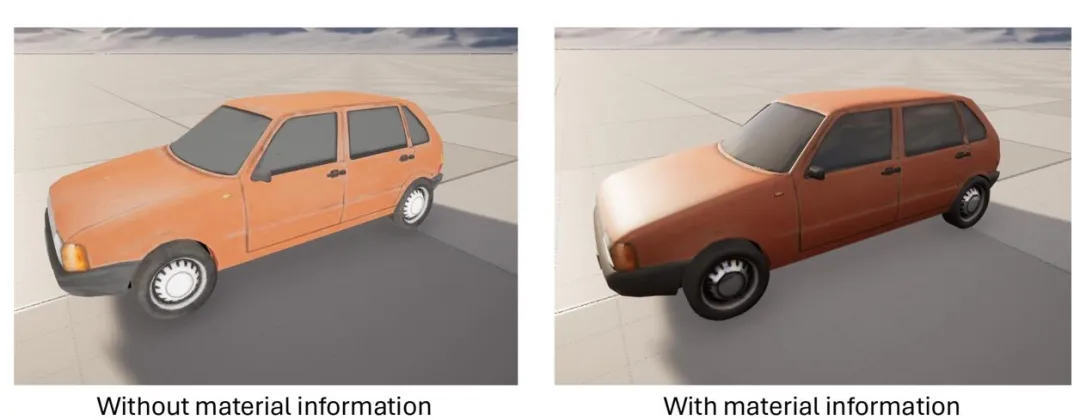

现有的 3D 资产生成方法通常利用生成式模型基于空间变化双向反射分布函数(SVBRDF, Spatially Varying Bidirectional Reflectance Distribution Function)在预设光照条件下推断表面位置的材质属性特征。然而,这些方法很少考虑到人们对身边常见物体的表面材质认知构建出的强大且丰富的先验知识(如汽车轮胎应为外缘的橡胶胎面包裹住金属的轮毂),且忽略了材质应该与物体本身的 RGB 色彩进行解耦。

因此,如何将人类对物体表面材质的先验知识有效地融入到材质生成过程中,从而提高现有 3D 资产的整体质量,成为了当前研究的重要课题。

针对这一问题,近日,中国科学院自动化研究所、北京邮电大学及香港理工大学等京港两地的研究团队发布了名为《MaterialSeg3D: Segmenting Dense Materials from 2D Priors for 3D Assets》的论文,构造了首个针对多种类复杂材质物体的 2D 材质分割数据集 MIO,其包含了多种语义类别下的、单一物体的、各个相机视角的像素级材质标签。该研究提出了一种能够利用 2D 语义先验在 UV 空间中推断出 3D 资产表面材质的材质生成方案 ——MaterialSeg3D。

3D 建模师通常根据生活常识或真实世界的物体原型来定义资产表面的材质。相比之下,基于生成式模型构建 3D 资产的方法使用 SVBRDF 来推断材质信息,但由于缺乏准确的高质量 3D 资产样本,这些方法难以生成高泛化性和高保真度的物理材质通道信息。此外,这类方法也未能利用公开网站中的海量 Web Image 数据来丰富物体表面材质信息的先验知识。

因此,本文聚焦于如何将 2D 图片中关于材质的先验知识引入解决 3D 资产材质信息定义的任务中。

MIO 数据集

这篇论文首先尝试从现有 3D 资产数据集中提取材质分类的先验知识,但由于数据集样本过少且风格单一,分割模型难以学习到正确的先验知识。

相比 3D 资产,2D 图像则更为广泛地存在于公开网站或数据集上。然而,现有的带注释 2D 图像数据集与 3D 资产渲染图的分布存在较大差距,无法直接提供足够的材质先验知识。

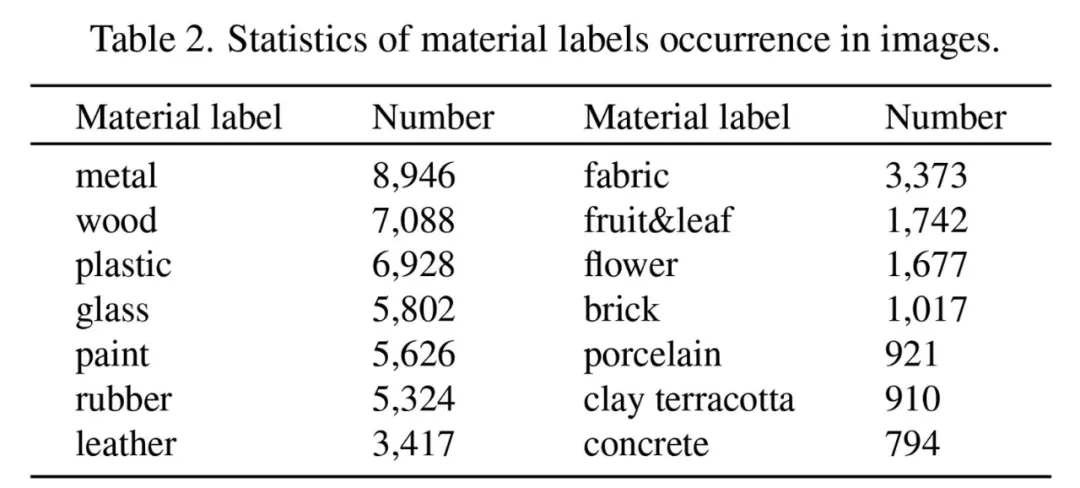

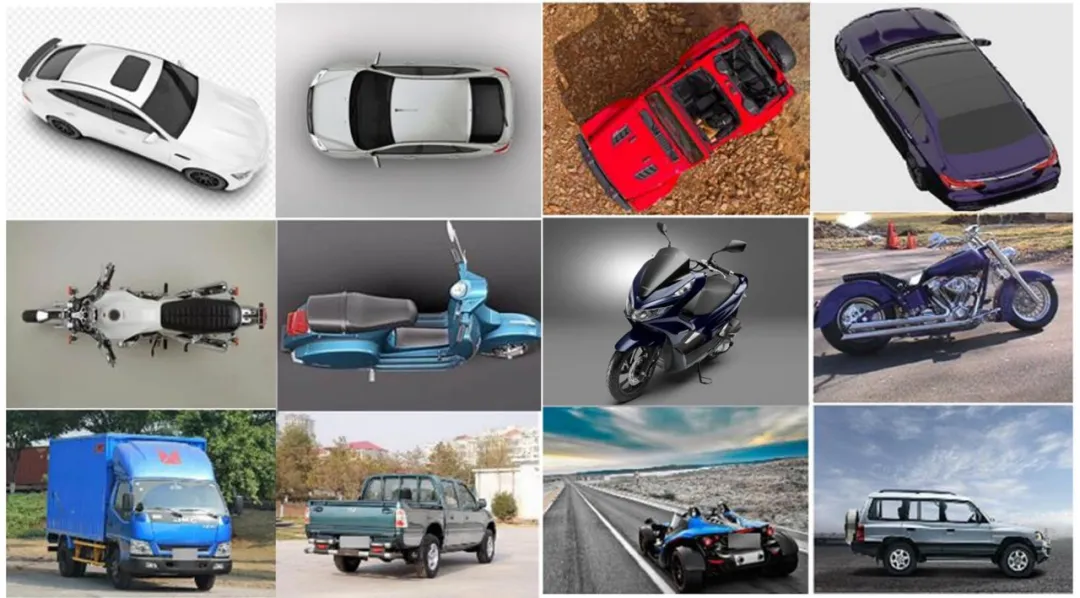

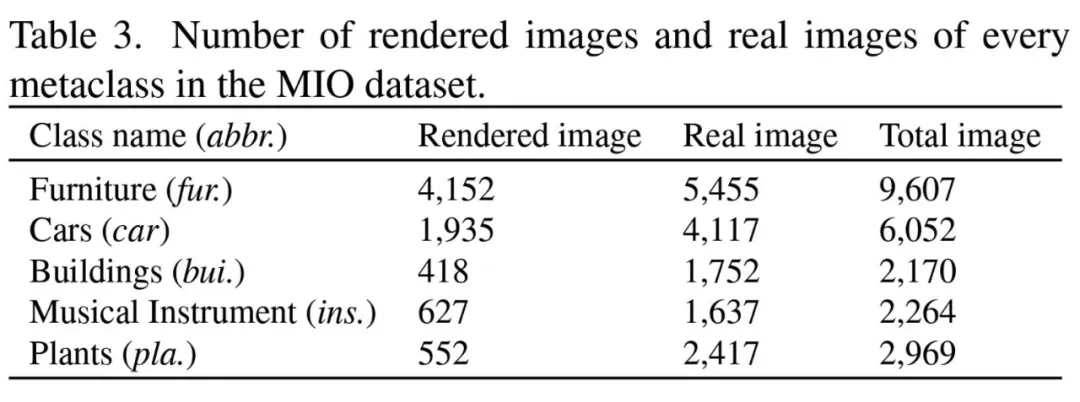

因此,本文构建了一个定制数据集 MIO(Materialized Individual Objects),是目前最大的多类别单一复杂材质资产的 2D 材质分割数据集,包含了从各种相机角度采样的图像,并由专业团队精确注释。

材质类注释和 PBR 材质球体映射的可视化示例。

在构造该数据集时,本文遵循以下规则:

MIO 数据集的独到之处在于,它不仅仅构造了每种材质类别的像素级标签,还单独构建了每个材质类别与 PBR 材质取值间的一一映射关系。这些映射关系是由 9 名专业 3D 建模师经过讨论后确定的。本文从公共材质库收集了超过 1000 个真实的 PBR 材质球作为备选材质,并依据建模师的专业知识进行筛选与指定,最终确定了 14 个材质类别并将其与 PBR 材质的映射关系作为数据集的标注空间。

MIO 数据集共包含 23,062 张单个复杂物体的多视角图像,分为 5 个大的元类:家具、汽车、建筑、乐器和植物,具体又可以分为 20 种具体的类别,特别值得一提的是,MIO 数据集中包含大约 4000 张俯视图图像,提供了在现有 2D 数据集中很少出现的独特视角。

MaterialSeg3D

有了 MIO 数据集作为可靠的材质信息先验知识来源,这篇论文随后提出了名为 MaterialSeg3D 的全新 3D 资产表面材质预测新范式,为给定的资产表面生成合理的 PBR 材质,从而能够真实地模拟物体的物理特性,包括光照、阴影和反射,使 3D 物体在各种环境下都表现出高度的真实性和一致性,为现有 3D 资产缺乏材质信息的问题提出有效解决方案。

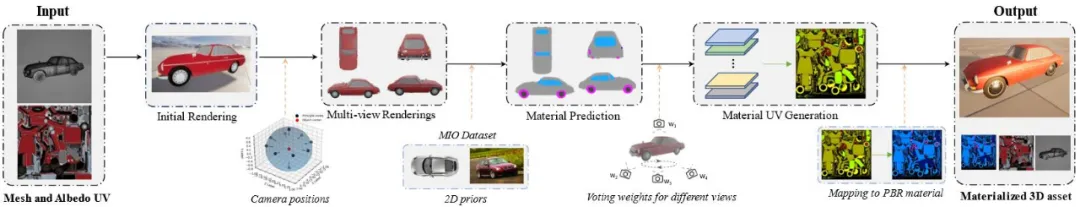

MaterialSeg3D 整个处理流程中包括三个部分:3D 资产的多视图渲染、多视图下的材质预测和 3D 材质 UV 生成。在多视图渲染阶段,确定了俯视图、侧视图和 12 个环绕角度的相机姿势,以及随机的俯仰角度,生成 2D 渲染图像。在材质预测阶段,利用基于 MIO 数据集训练的材质分割模型,对多视角渲染图进行像素级的材质标签预测。在材质 UV 生成阶段,将材质预测结果映射到临时 UV 图上,通过加权投票机制处理得到最终的材质标签 UV,并转化为 PBR 材质贴图。

可视化的效果与实验

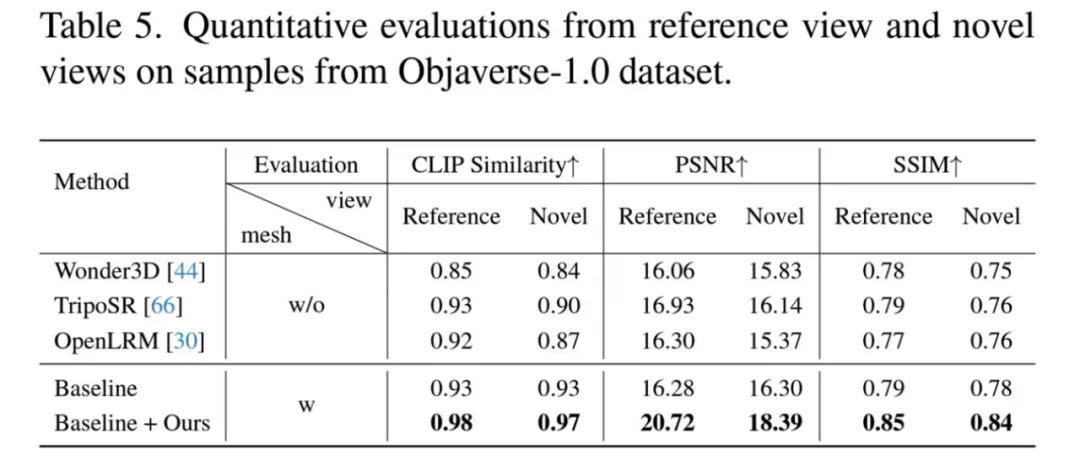

为评估 MaterialSeg3D 的有效性,本文进行了与近期相似工作的定量与定性实验分析,重点关注单图像到 3D 资产的生成方法、纹理生成以及公共 3D 资产三个方面。对于单图像到 3D 资产的生成方法,与 Wonder3D、TripoSR 和 OpenLRM 进行了比较,这些方法将资产的某一参照视图作为输入,直接生成具有纹理特征的 3D 对象。通过可视化图片观察到,MaterialSeg3D 处理后的资产在渲染的真实性方面相较之前的工作有显著改善。论文还比较了现有的纹理生成方法,如 Fantasia3D、Text2Tex 以及 Meshy 网站提供的在线功能,这些方法可以根据文本提示信息生成纹理结果。

在此基础上,MaterialSeg3D 在不同的光照条件下能够生成精确的 PBR 材质信息,使渲染效果更加真实。

定量实验采用 CLIP Similarity、PSNR、SSIM 作为评价指标,选择 Objaverse-1.0 数据集中的资产作为测试样本,并随机选择三个相机角度作为新视图。

这些实验证明了 MaterialSeg3D 的有效性。其能够生成公共 3D 资产缺失的 PBR 材质信息,为建模师和后续的研究工作提供更多优质资产。

总结与展望

这篇论文针对 3D 资产表面材质生成问题进行了探索,构建了定制的 2D 材质分割数据集 MIO。在这一可靠数据集的支持下,提出了新的 3D 资产表面材质生成范式 MaterialSeg3D,能够为单个 3D 资产生成可解耦的独立 PBR 材质信息,显著增强了现有 3D 资产在不同光照条件下的渲染真实性和合理性。

作者指出,未来的研究将专注于扩展数据集中物体元类的数量、通过生成伪标签扩大数据集规模以及对材质分割模型进行自训练,以便该生成范式能够直接应用于绝大多数种类的 3D 资产。

文章来源于:微信公众号机器之心

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda