AI算力资源越发紧张的当下,斯坦福新研究将GPU运行效率再提升一波——

内核只有100行代码,让H100比使用FlashAttention-2,性能还要提升30%。

怎么做到的?

研究人员从“硬件实际需要什么?如何满足这些需求?”这两个问题出发,设计了 一个嵌入式CUDA DSL工具,名为ThunderKittens(暂且译为雷猫)。

雷猫可简化AI内核的编写,同时充分利用底层硬件能力。

具体来说,雷猫的主要抽象是寄存器和共享内存中的小型张量块(tile),和目前GPU中对小矩阵乘法的优化相匹配。

通过操作这些tile,开发者可相对简单地编写代码,充分利用张量核心、异步数据传输和共享内存等硬件特性。

使用雷猫实现的注意力机制内核,代码量少且能实现很高的硬件利用率,性能超过直接使用底层库(如Cutlass)。

详细讨论过程以及雷猫是怎么设计出的,研究人员以“GPUs Go Brrr”为题,发在了斯坦福Hazy Research的Blog网站上。

网友们对此讨论也十分热烈。

有网友表示读这篇Blog时,让他想起了初次了解超标量CPU架构时的惊讶感受:

GPU真的达到了新高度。

还有网友表示:

这篇文章重新点燃了我在CS 149并行编程课中所感受到的快乐。

斯坦福研究人员以H100为例,探讨了优化GPU的方法。

首先,回顾一下H100的硬件细节,这对于接下来的讨论非常重要。

一个H100 SXM GPU包含:

(1)80GB的HBM3内存,带宽为3TB/s(实际带宽略低)。

(2)50MB的L2缓存,带宽为12TB/s,在GPU上分为两个25MB的部分,通过交叉开关连接(这个交叉开关表现不佳)。

(3)132个流式多处理器(SM),每个包含:

除了这些,一个GPU还包括内存控制器、指令缓存……但对于这项研究而言不重要。

重要的是,所有的计算都发生在流式多处理器中,大部分计算是在寄存器中。

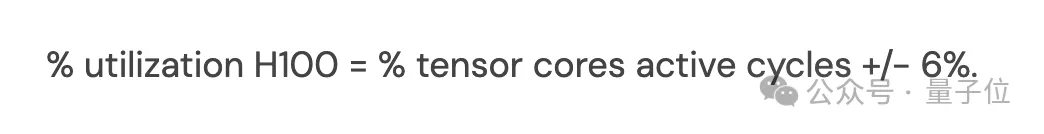

H100 GPU拥有989 TFLOPs的半精度矩阵乘法计算能力,以及约60 TFLOPs的“其他”计算能力。因此,每个周期内张量核心被使用时,至少能达到94%的硬件利用率。而张量核心不被使用时,硬件的利用率不会超过6%。

换句话说:

H100的利用率=张量核心活跃周期的百分比+/- 6%。

所以要充分发挥H100的能力,关键是保持张量核心持续运算。

然鹅,要保持张量核心持续运行并不容易。

研究人员发现GPU硬件具有一些特性,对于保持矩阵乘法的运行非常重要:

这些特性在非H100 GPU上也有所适用,在H100上更加典型,就拿RTX 4090来说,相比H100处理起来简单得多。

所以接下来还是以H100为例,展开探讨这几点特性。

H100引入了一套新的指令集,名为“warp group matrix multiply accumulate”(在PTX中为wgmma.mma_async,在SASS中为HGMMA/IGMMA/QGMMA/BGMMA)。

要理解这些指令的特点,需回顾以往张量核心的使用方式。

早期GPU中的张量核心指令如wmma.mma.sync和mma.sync,要求SM一个子单元内的32个线程的一个warp同步传输数据块至张量核心并等待结果。

wgmma.mma_async指令则不同。它允许128个连续线程跨SM所有子单元协作同步,并从共享内存及寄存器(可选)异步启动矩阵乘法。这使得这些warp在等待矩阵乘法结果时可以处理其他任务。

研究人员通过微观基准测试,发现这些指令是充分发挥H100计算能力所必需的。没有这些指令,GPU的峰值利用率大约只有63%。

他们推测,这是由于张量核心需要从本地资源维持一个深度硬件pipeline。

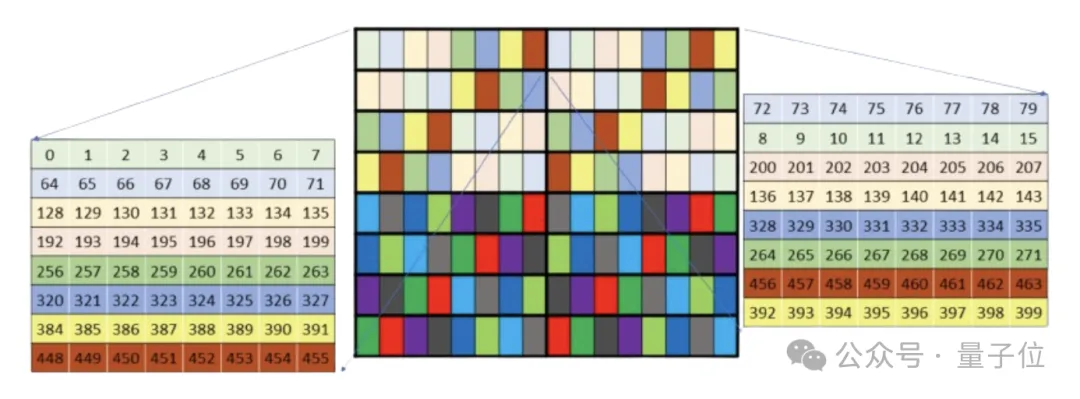

然而,这些指令的内存布局极其复杂。未重排的共享内存布局合并性差,需要额外的L2带宽。重排的内存布局记录不准确,研究人员花费了大量时间才弄明白。

最终发现,这些布局只适用于特定矩阵形状,并与wgmma.mma_async指令的其他部分不兼容,例如硬件仅在未重排的布局下转置子矩阵。

此外,未重排的wgmma布局内存合并性差且有bank conflicts。尽管TMA和L2缓存在如flash attention这类内核上能较好地掩盖这些问题,但要充分利用硬件,必须精心控制内存请求的合并和避免bank conflicts。

尽管有这些问题,但这些指令对于充分利用H100是必不可少的。没有它们,GPU的潜在性能就损失了37%。

共享内存的单次访问延迟约为30个周期(这也与研究人员观察的相符),这看似不多,但在这段时间内,SM的张量核心几乎能完成两次完整的32x32方阵乘法。

以前的研究,如Flash Attention,研究人员更多关注的是HBM-SRAM的瓶颈。但随着HBM速度的提升和张量核心的快速发展,即使是共享内存的相对较小延迟也变得尤为关键。

由于共享内存被分为32个独立的存储单元,处理不当可能会引发bank conflicts,即同一个内存bank同时被多个请求访问,这种情况会导致请求被序列化。研究人员实验后认为,这会显著拖慢内核速度,且wgmma与mma指令需要的寄存器布局容易受到bank conflicts的影响。

解决方法是通过各种“重排”模式调整共享内存的配置,避免bank conflicts,但细节要处理得当。

此外研究人员发现,尽可能避免在寄存器和共享内存之间的移动数据非常重要。可能的话,可使用内置硬件(如wgmma和TMA指令)进行异步数据传输。实在没法子了,再使用warp进行同步数据传输。

H100还有一个有趣的特性,其张量核心和内存都足够快,以至于仅生成用于获取数据的内存地址就占用了芯片的大量资源,特别是加入复杂的交错或重排模式时,这种情况更为明显。

研究人员表示,英伟达提供了张量内存加速器(TMA),似乎就是已经意识到了这个问题。

TMA允许用户在全局和共享内存中指定多维张量布局,命令其异步提取张量的一部分,并在完成后触发一个屏障。这大大节省了地址生成的开销,并简化了pipelines的构建。

研究人员认为,TMA对于充分发挥H100的潜力至关重要,可能比wgmma.mma_async更为关键。

它不仅节省了寄存器资源和指令派发,还提供了如异步在全局内存上执行归约等实用功能——这在处理复杂的反向内核时尤其有用。

虽然TMA的重排模式解读有一定难度,需要进行一些逆向工程,但研究人员表示,相比之下,他们在这上面遇到的问题要少得多。

占用率指的是在GPU的相同执行硬件上同时调度的线程数。每个周期,SM的某一子单元的warp scheduler会尝试向准备就绪的warp线程发出指令。

研究人员认为,英伟达采用这种模型可以更容易地保持硬件的满负荷运行。例如,当一个线程warp等待执行矩阵乘法时,另一个可以被指派执行使用快速指数运算的指令。

在某些方面,H100对占用率的依赖程度低于前几代硬件。

它的异步特性使得即使单一指令流也能使多个硬件部分同时持续运行,包括读取内存、执行矩阵乘法、进行共享内存的归约,同时还能在寄存器上进行计算。

但高占用率容易隐藏缺陷或同步问题,一个设计良好的pipeline即使在占用率不高的情况下也能运行得相当快。

据研究人员观察,英伟达在设计GPU时确实考虑到了占用率。且由于存在足够多的同步操作和足够多的错误可能性,根据他们的经验,提高占用率通常能显著增加硬件的实际利用率。

此外,相比H100,A100和RTX 4090更依赖同步指令调度,占用率更重要。

鉴于以上情况,如何才能更轻松地编写所需的内核类型,同时充分发挥硬件的全部潜力?

雷猫(ThunderKittens)登场了。

这是一个嵌入在CUDA中的DSL,本是斯坦福研究人员设计出来给自己内部使用的,后来发现还真挺好使。

Ps:起这么个名,一是他们觉得小猫很可爱,二来他们觉得大伙儿在代码中输入kittens::会很有趣。

具体来说,雷猫包含四种模板类型:

tiles通过高度、宽度和布局进行参数化;寄存器向量通过长度和布局进行参数化;而共享向量仅通过长度进行参数化,通常不会遇到bank conflicts问题。

此外,研究人员提供了一系列操作来处理这些张量,既可在warp级别使用,也可用于多个warp协作,包含初始化器,如将共享向量清零;一元操作,如exp;二元操作,如mul;行/列操作,例如行求和。

雷猫作为一个嵌入到CUDA中的库,其提供的抽象层在遇到不支持的功能时能够很好地处理。如果雷猫缺少某些功能,可以直接扩展它来实现你想要的效果。

以Tri的flash attention算法为例,在实际应用中,即使是使用英伟达的Cutlass库,实现起来也是相当复杂。

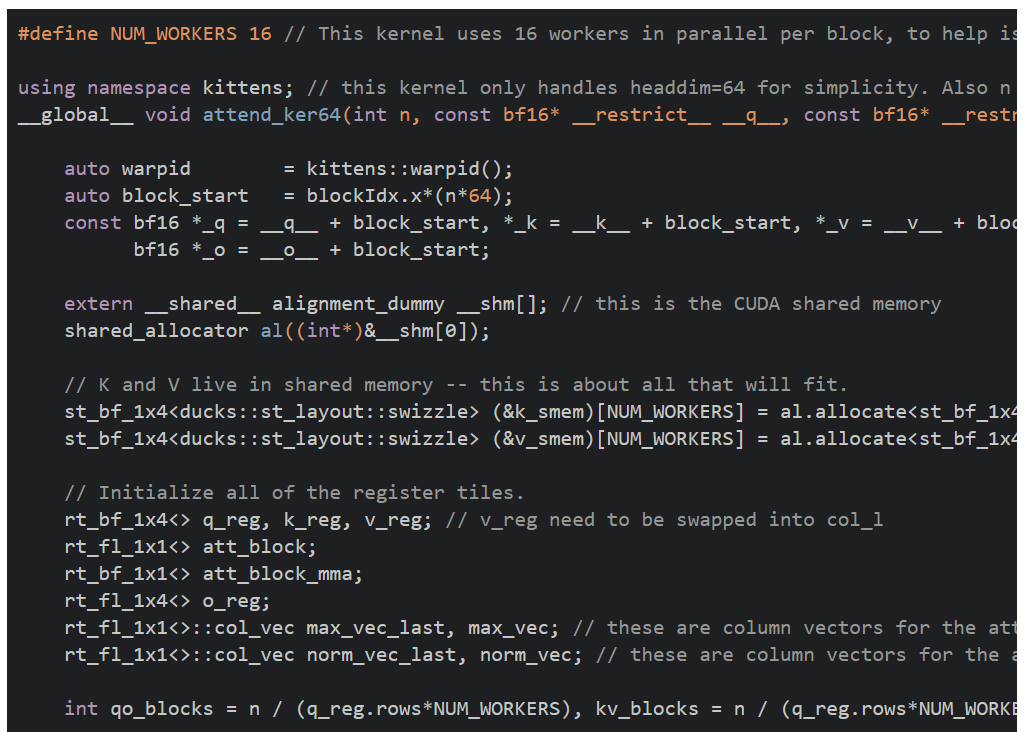

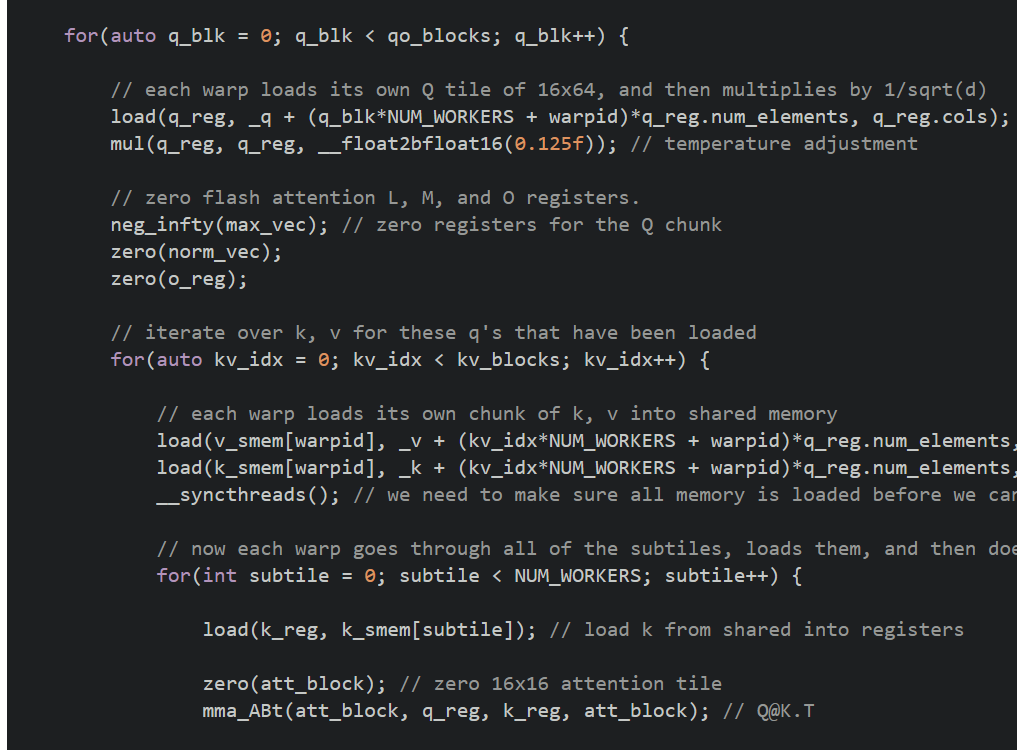

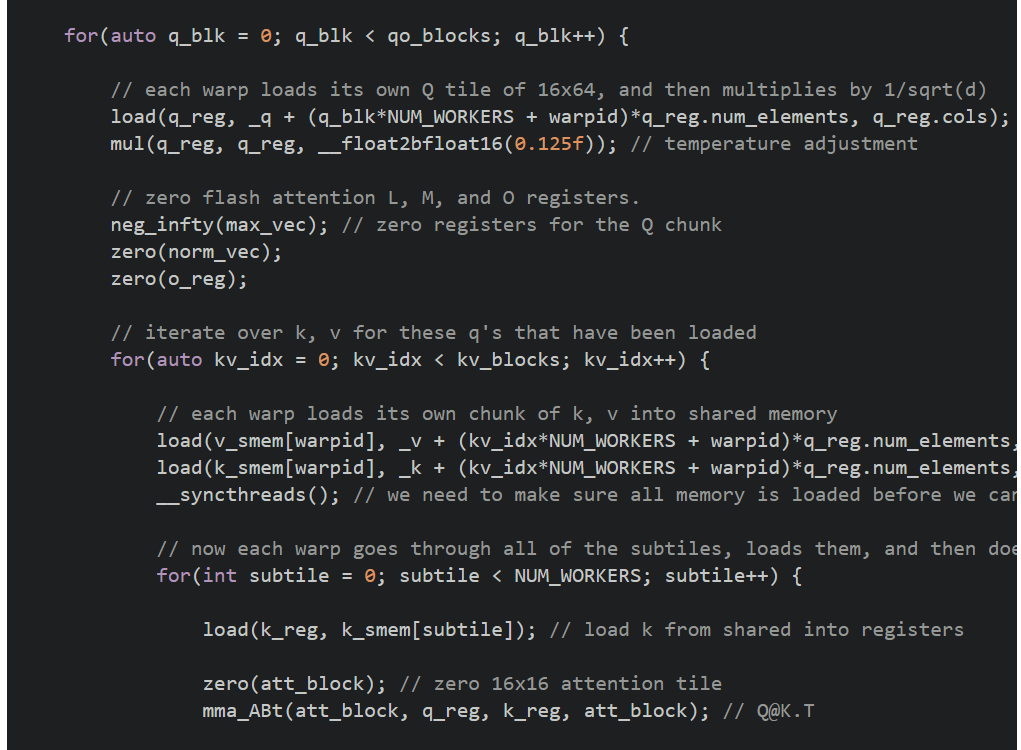

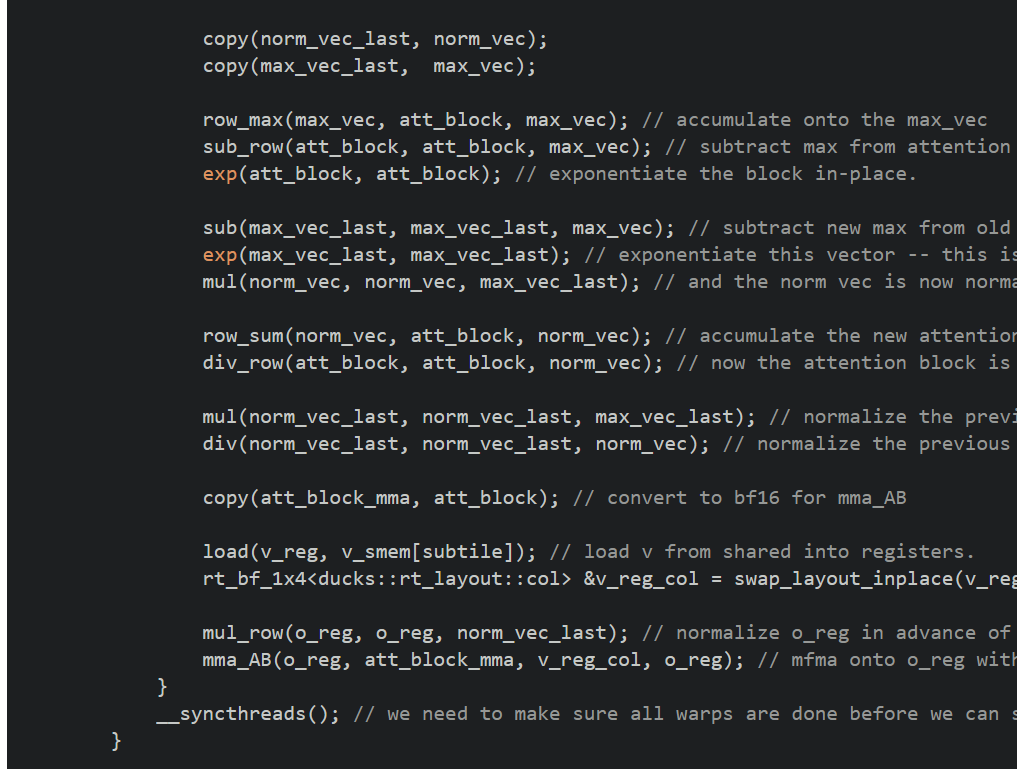

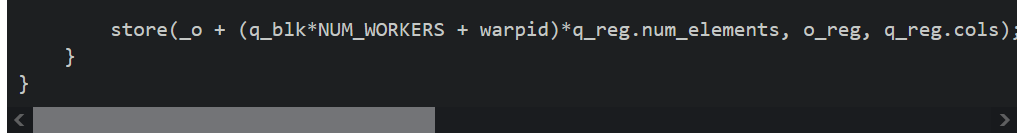

以下是一个在RTX 4090上使用雷猫编写的简单flash attention内核的示例。

总共约60行CUDA代码,硬件利用率达到了75%。代码复杂性主要在于算法本身,而非交织模式或寄存器布局。

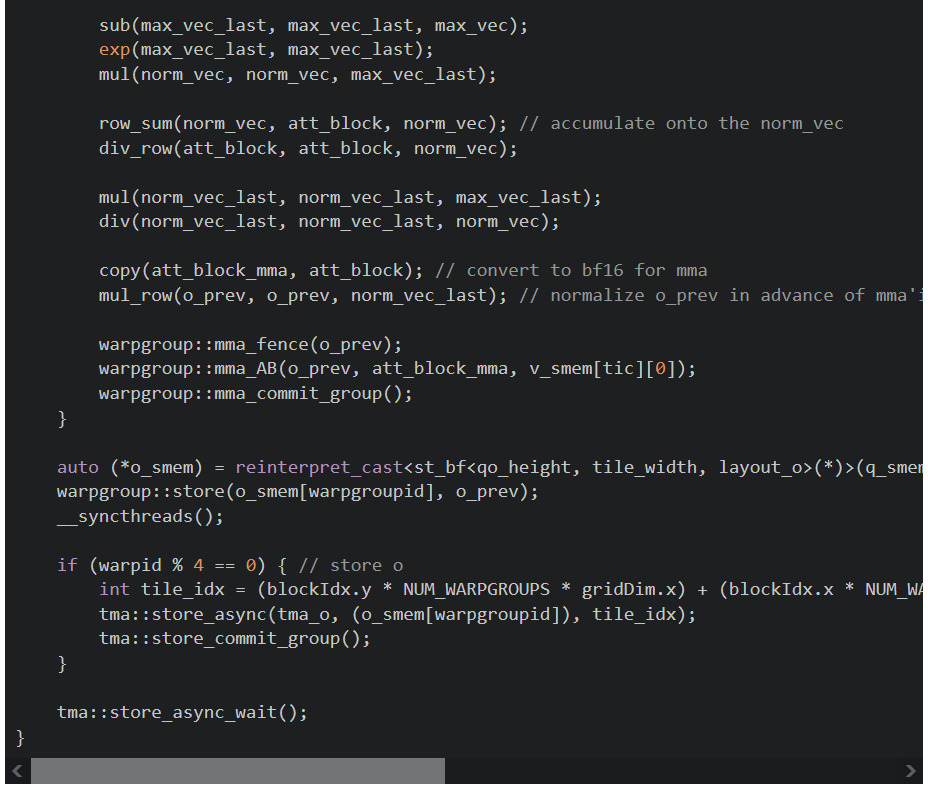

关于TMA、WGMMA、交织模式和描述符的复杂性,这里展示了一个使用雷猫编写的,针对H100的FlashAttention-2算法的前向传递示例。

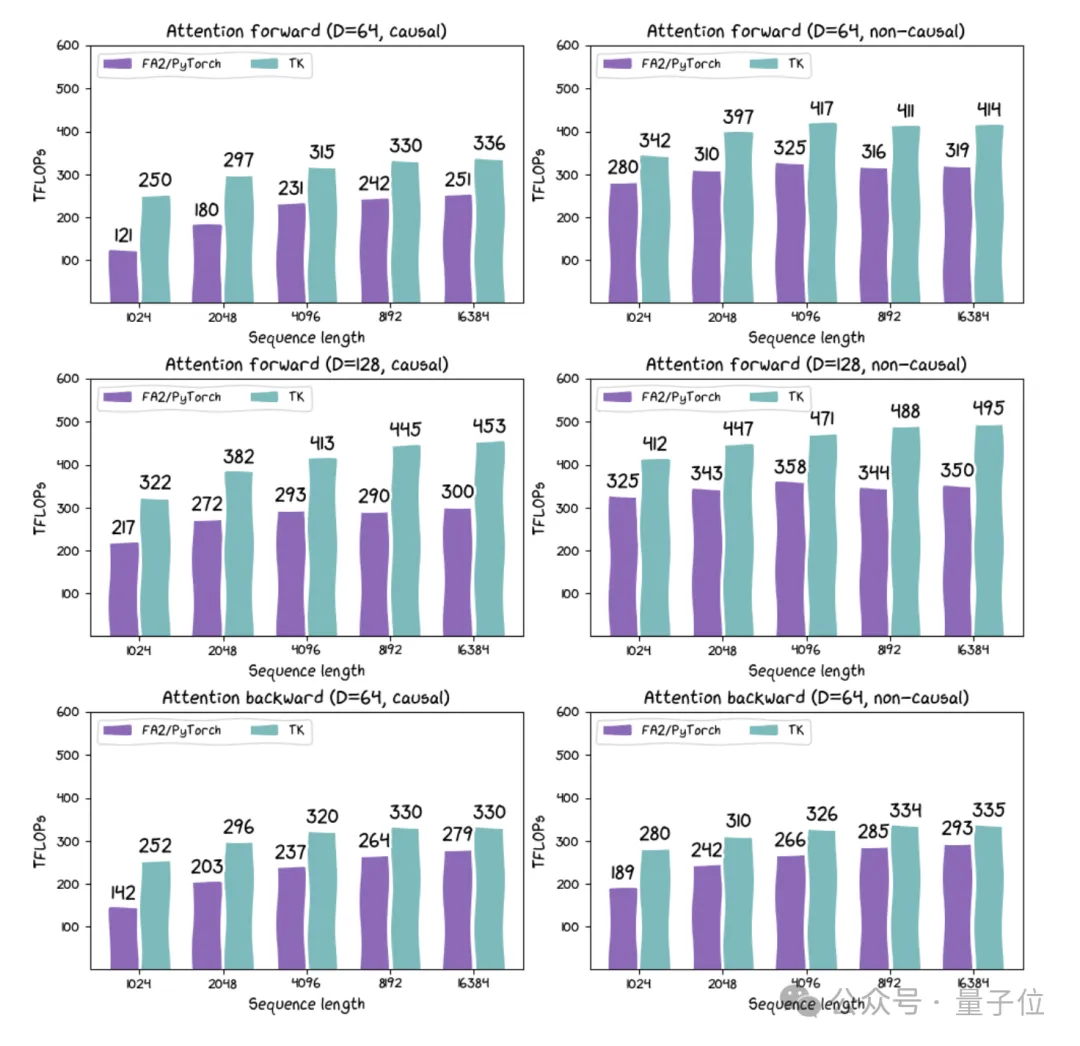

那么,它的表现如何?

这个内核只有100行代码,实际上它在H100上的性能比FlashAttention-2高出约30%。雷猫负责包装布局和指令,提供了一个可以在GPU上使用的迷你pytorch环境。

此外,研究人员还发布了基于线性注意力和其他新架构的内核。其中基于线性注意力的内核的运行速度可达215 TFLOPs,如果考虑到算法中固有的重计算,速度可超过300 TFLOPs。

尽管线性注意力在理论上效率更高,但此前在实际硬件上表现并不佳。因此,研究人员认为这可能促进一系列高吞吐量应用的发展。

最后,雷猫研究团队总结了开发雷猫的一些思考。在他们看来,雷猫之所以有效,是因为它的目标并不是试图做所有事:

CUDA的确比雷猫表达能力更广,雷猫小而简单,功能有限。但雷猫的small tiles抽象设计符合AI和硬件的发展趋势。

虽然雷猫不支持小于16的维度,但研究人员认为这并不重要,因为硬件也不倾向于支持过小的维度。

如果你的矩阵乘法小于16x16,你确定你正在做的是AI吗?

从理论出发,研究人员认为需要进行一种框架转变。

“寄存器当然不应该像旧CPU那样32位字。CUDA使用的1024位宽向量寄存器确实是朝着正确方向迈出的一步。但对我们来说,寄存器是16x16的数据tile。我们认为AI需要这样的设计,毕竟,它仍然只是矩阵乘法、归约和重塑。我们认为硬件也需要这样的设计,小型矩阵乘法迫切需要超出系统级MMA的硬件支持。”

研究人员认为,应该根据硬件特性来重新定义AI的设计理念。例如,循环状态应该有多大?应该足够大以适应一个SM。计算的密度应该有多高?不应低于硬件的需求。

我们未来工作的一个重要方向是利用我们对硬件的了解来帮助我们设计与之匹配的AI。

参考链接:

[1]https://hazyresearch.stanford.edu/blog/2024-05-12-tk

[2]https://github.com/HazyResearch/ThunderKittens

[3]https://news.ycombinator.com/item?id=40337936

文章来自于微信公众号量子位,作者西风

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI