人工智能应用的兴起推动了对算力和存储容量的需求。对企业、个人和政府而言,以安全的方式处理和存储这些数据至关重要。这意味着,对先进数据中心的需求将不断增长,我们认为这提供了具吸引力的投资机会——无论是在数据中心本身还是其所依赖的基础设施方面。

数据中心提供处理人工智能大量工作所需要的基础设施,在满足不断升级需求方面发挥着日益重要的作用。过去十年,开发人员稳步提高主机托管数据中心以及超大规模数据中心的容量;超大规模数据中心是专门建设的设施,旨在满足大型科技公司和云服务提供商的大规模和高性能要求。

未来几年,人工智能将推动超大规模公司进入新的资本支出周期,并要求大力投资数据中心基础设施。为了继续以安全可靠的方式存储信息,数据中心基础设施需要不断升级,以应对人工智能所需的额外电力,并确保数据不会因过热、断电或火灾而丢失。

人工智能两大应用:训练与推理

人工智能模型主要分为两类,每类模型具有独特的数据中心要求:

尽管目前有关人工智能训练模型的消息更受关注,我们认为主机托管运营商的潜力在于人工智能推理领域。事实可能将证明,这是一个比人工智能训练市场大10至15倍的潜在市场。推理数据中心所需的功率密度是人工智能训练的一半,并可能需要在全球20~30个地点进行复制。

电力需求:数据中心的瓶颈

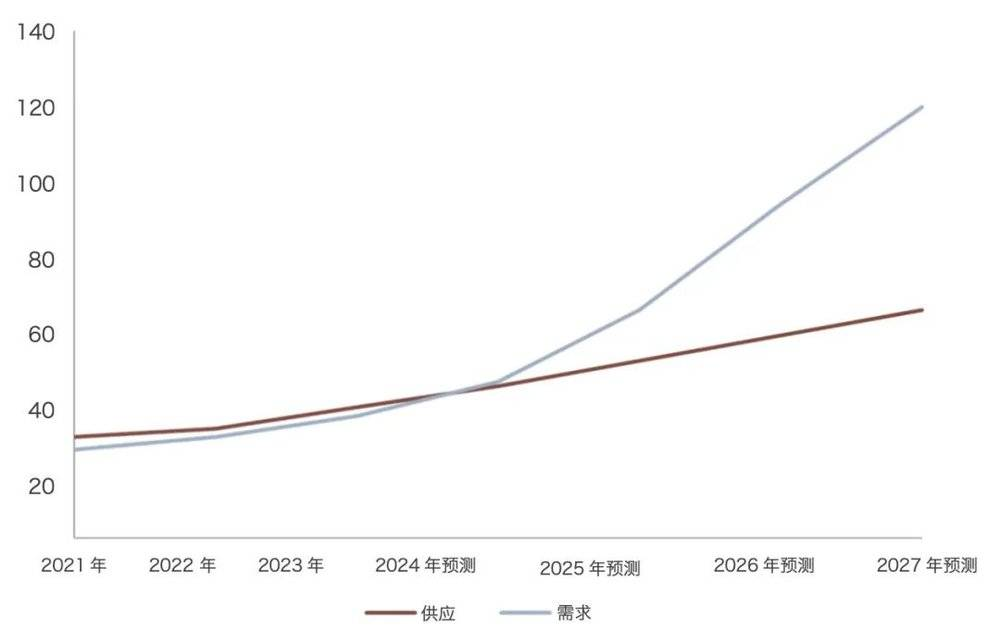

数据中心建设面临两个关键挑战:土地可用性和电力限制。需求远远超过可用供应——我们预计这种趋势在可预见的未来将持续下去。

电力供应的问题尤为严重,因为公用事业通常能够处理电力需求的线性增长,而人工智能数据中心所需的阶跃式增长则带来独特的挑战(见图1)。2023年,全球数据中心市场电力消耗量达60吉瓦。预计到2027年,这一数字将翻一番,达到122吉瓦,相当于复合年增长率(CAGR)约为20%。

图1——电力需求激增

数据中心电力供需情况,实际和预测数据,吉瓦。

资料来源:Oppenheimer & Co Inc,涵盖2021年1月1日至2023年12月31日的数据。根据历史数据做出之后几年的预测。

人工智能应用程序的普及是数据中心电力需求激增的关键原因之一。人工智能服务器的能源密度显著高于传统中央处理器(CPU)服务器。它们依赖于图形处理器(GPU)服务器,所需电力比传统CPU服务器多五倍,继而产生多于五倍的热量。

预计未来15年,数据中心80%的电力将被人工智能消耗,因此获取电力的能力成为关键的差异化因素。

目前,数据中心每个机架的平均功率密度约为10千瓦。由于使用GPU,人工智能应用要求更高的功率密度,这意味着超大规模数据中心预计未来几年内每个机架的平均功率密度将达到40-50千瓦。

随着人工智能的普及,数据中心运营商将需要升级其电力基础设施(即从本地电网到每个芯片这一过程的电力管理),但这可能需要几年时间才能够实施。加快这一进程的一种方式是在已有所需基础设施的地区进行建设,即便这意味着对现有结构进行改造或更换。

数据中心设计的未来

鉴于产生的热量增加,较高的用电量还包括更多的供暖、通风和空调(HVAC)设备。因此,数据中心需要对其热系统(即冷却系统、气流管理)进行投资。这是因为人工智能应用程序在运行过程中会产生大量热量,需要数据中心维持最佳运行温度,以防止硬件故障并确保可靠的性能。

目前,大多数数据中心都使用空气冷却。然而,服务器密度的不断增加正超出空气冷却系统的冷却能力,每个机架的空气冷却能力限于15~25千瓦,超出后就会失去效力。由于功率密度的增加超过该限额,运营商将需要开始考虑将液体冷却技术作为更可行的选择。

直到最近,数据中心设计仍通过局部冷却技术满足功率密度要求。现在,更多的关注集中在更大规模的液体冷却解决方案上,以满足生成式人工智能所需的更大机架密度,但许多数据中心运营商尚未改变其基准设计,因为他们认为这些设计可以满足当前的人工智能要求。

因此,数据中心液体热管理的潜在市场总规模可能在未来五年内增加约五倍。提供冷却系统或相关设备的公司能够成为具吸引力的投资标的。

行业利好因素

2023年,我们已经看到不断增长的需求,这是数据中心有史以来前所未有的增长时期。全球租赁的增量容量超过6吉瓦,其中北美地区占大部分(约4至5吉瓦)。该租赁量是2022年所记录量(当年已创历史新高)的两倍,是2019年记录量的八倍。

供应限制和强劲需求继而推高了数据中心运营商的租金。继2023年租金同比上涨18.6%后,房地产专家世邦魏理仕(CBRE)预计2024年租金将再次出现两位数百分比的上涨(图2)。

图2——租金收入

一级市场数据中心平均要价租金,美元/千瓦/月,以及年同比变化。

资料来源:世邦魏理仕研究,2023年。租金报价为次年3级数据中心(具有多个电力和冷却系统路径)250~500千瓦的要价。

由于人工智能技术的广泛应用,未来几年数据中心行业将呈指数级增长。对大规模数据处理能力和高性能计算基础设施的需求,成为推动这一增长主要原因。此外,为确保人工智能硬件的可靠性和效率,对液体冷却等有效冷却解决方案的需求也会上升。

如果数据中心公司能够适应并扩展其基础设施,以满足这些不断发展的需求,便能够占据有利位置以充分利用人工智能部署带来的机会。通过接纳这些变化并抓住这一机遇,它们可以在塑造创新的未来,以及确保所存储数据的安全方面发挥关键作用。

文章来源于“巴伦周刊”,作者“Rachele Beata”