WWDC 上,苹果终于发布了自己的 AI 功能——苹果智能(Artificial Intelligence),苹果、微软和谷歌在 AI 落地上的不同策略也可见一斑,有些选择集成,有些选择了模块化。

为什么会这么选?哪种策略可能赢得未来?

知名科技与商业战略博客 Stratechery 最近有篇文章详细探讨了巨头们在 AI 上的不同商业策略和利弊。Founder Park 进行了编译,略作调整。

原文:

https://stratechery.com/2024/ai-integration-and-modularization/

在上周的 Stratechery 采访中,现任微软 CEO 萨提亚·纳德拉在回答关于谷歌和人工智能的问题时说:

我认为,总是有人可以去做垂直整合。我常常回看,从前有盖茨/格罗夫模型*,然后有苹果和新的谷歌模型,即垂直整合模型。我觉得两者都有戏。

*编者注:盖茨/格罗夫模型是指微软和英特尔早期采用的商业模式,强调垂直整合、市场领导和技术创新,后来的科技公司如如苹果(Apple)等也受益于这些理念。

罗纳德·科斯是最早探索一体化与模块化问题的经济学家之一,他在《企业的本质》一文中提出了这一问题。科斯总结道:

在决定公司规模时,边际主义原则非常有用。关键问题是:是否值得将新的交易活动纳入公司管理?在边际上,公司内部管理这些活动的成本会等同于外部管理的成本,或者通过市场价格机制管理这些活动的成本。

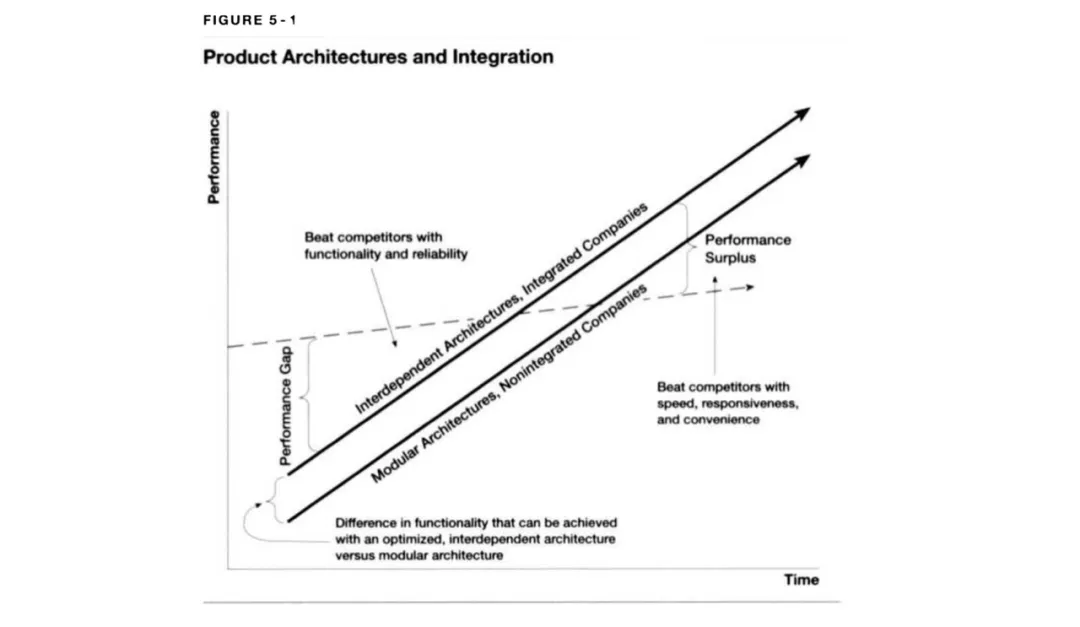

克莱顿·克里斯滕森教授将集成化与模块化的分析扩展到了更大的创新领域。他在《创新者的解决方案》中写道:

图 5-1 左侧显示,当存在性能差距时,公司必须通过制造最好的产品来竞争。在这种竞争中,相比于采用模块化架构的竞争对手,采用专有架构的公司更具竞争优势,因为模块化的标准化要求剥夺了工程师的优化性能的自由度。

为了缩小每代新产品的性能差距,工程师需要以更高效的方式组装系统各部分,在现有技术中追求最大性能。当公司必须通过制造最佳产品来竞争时,他们就不能简单地组装标准化组件,因为从工程角度看,接口标准化(意味着设计自由度较低)会迫使他们远离技术前沿。当产品不够好时,放弃能做到的最好的就意味着落后。

与采用专有架构的公司竞争时必须进行集成,整合控制系统的各个关键组件,并对其进行设计和制造。比如,在大型计算机行业早期,当功能和可靠性不足以满足主流客户需求时,你不可能作为大型计算机的独立制造商存在,因为设计和制造是相互依赖的。同样,作为大型机操作系统、核心内存或逻辑电路的独立供应商也不可能,因为这些关键子系统也必须相互依赖和迭代设计。

基于「集成解决方案最终会超越客户并被模块化替代方案取代」这类观点,克里斯滕森经常预言苹果将失去智能手机的领先地位。但我认为这在消费市场不可能,因为模块化的成本超出了经济学的衡量标准:

「垂直整合分析的问题在于只考虑了财务成本。还有其他更难量化的成本。模块化会带来设计和使用产品体验的成本,这些成本无法克服,也无法衡量。企业买家和他们的分析师完全忽视了这些,但消费者不会。一些消费者本质上了解且重视质量、外观、感受和细节,并且愿意为超过财务成本的溢价买单。」

*引自作者《克莱顿·克里斯滕森错了》一文

就智能手机和计算机而言,这是对的。基于 Windows 的模块化计算机在前 30 年曾占据主导地位,但如今,Mac 在消费者中占主导,微软在 Copilot+ PC 中承认了这一点。

然而,智能手机和个人电脑是物理设备。在 AI 中,集成化是否也成立?

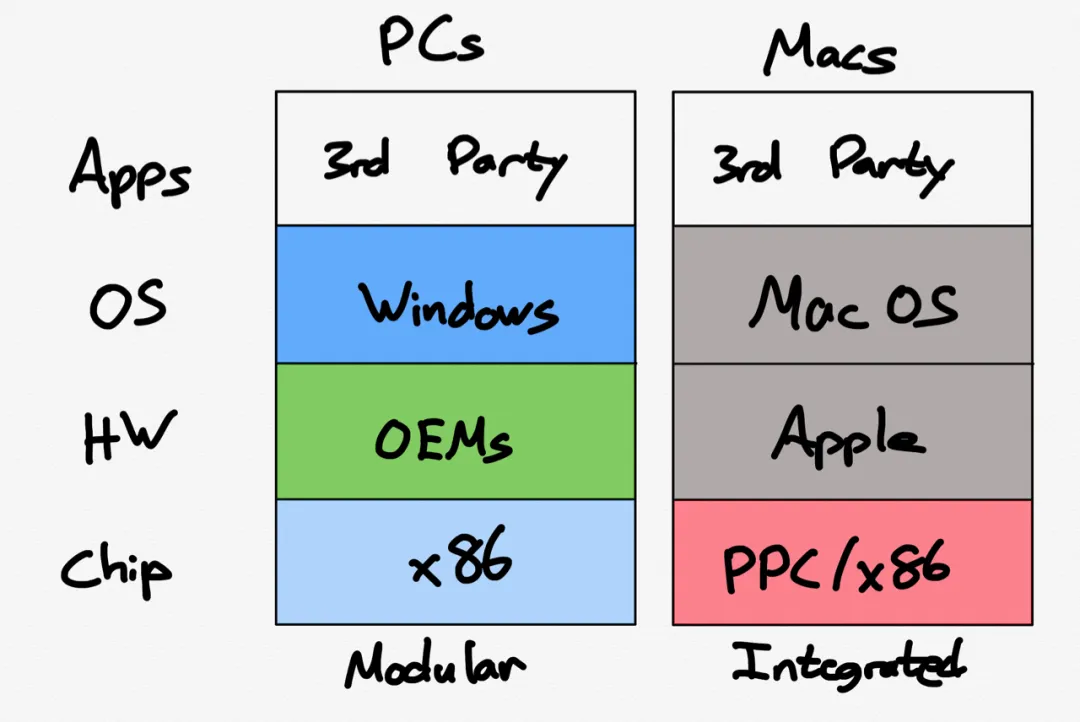

PC 中的集成化与模块化对比如下:

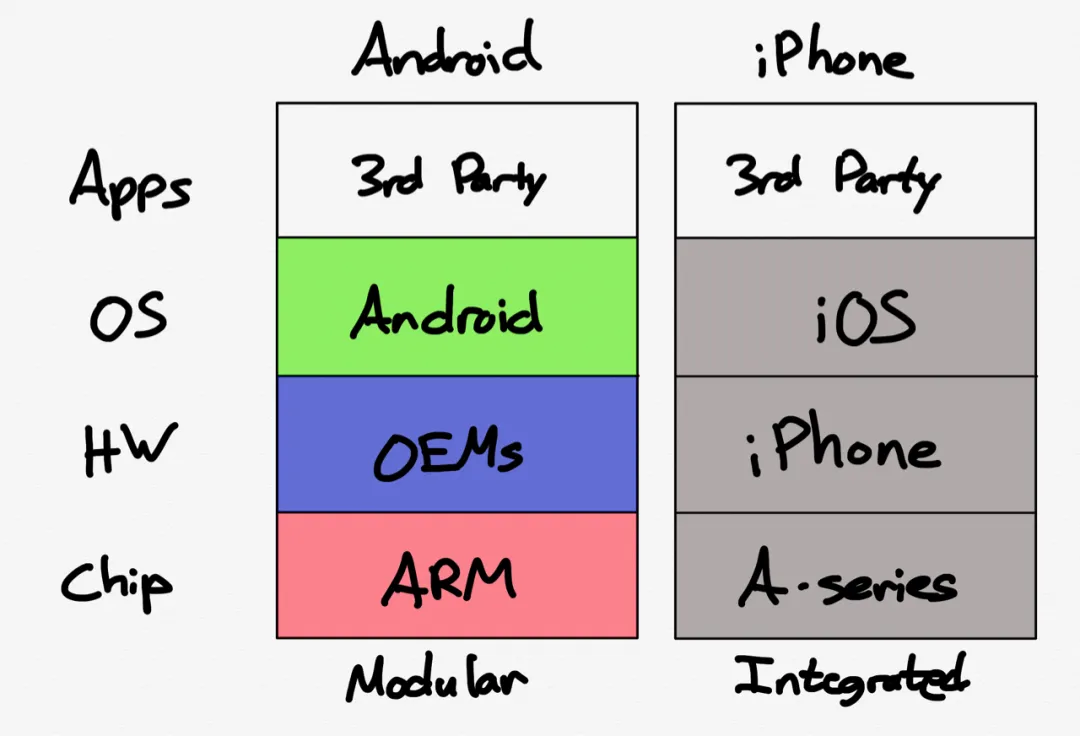

苹果在 90 年代曾短暂尝试模块化,几乎破产。最终,公司走了相反的路,沿着 iPhone 的路,一路集成到处理器:

这两张图像得惊人。扎克伯格希望这种模式能在 Meta 头显上重现,而 Meta 将作为「开放的替代方案」*。

*编者注:扎克伯格认为,在开放模式中,用户可以安装模组、做更多的事、获得更加多样化的硬件和软件等等。因此,Meta 的目标是再次让开放模式定义下一代计算。

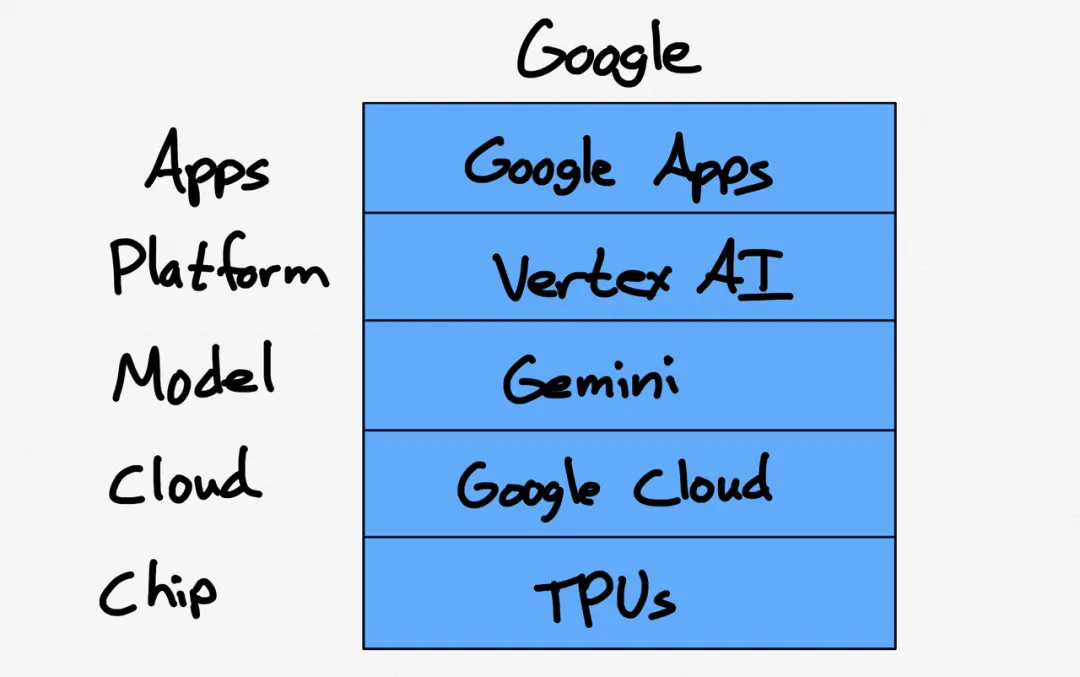

不过,正如纳德拉指出的,在 AI 这块,谷歌是综合性玩家:

谷歌在其 TPU 处理器上训练和运行 Gemini 模型,这些处理器只能在谷歌的谷歌云上使用。开发者可以通过谷歌的 AI 开发平台 Vertex AI 访问 Gemini;在某种程度上,Vertex AI 与谷歌的内部的开发环境相似,谷歌在该平台上构建面向消费者的 AI 应用。有证据表明这种「从上到下都是谷歌」的集成化正在获得回报,Gemini 1.5 行业领先的 200 万 token 的窗口,肯定是谷歌基础设施团队和模型开发团队共同创新的结果。

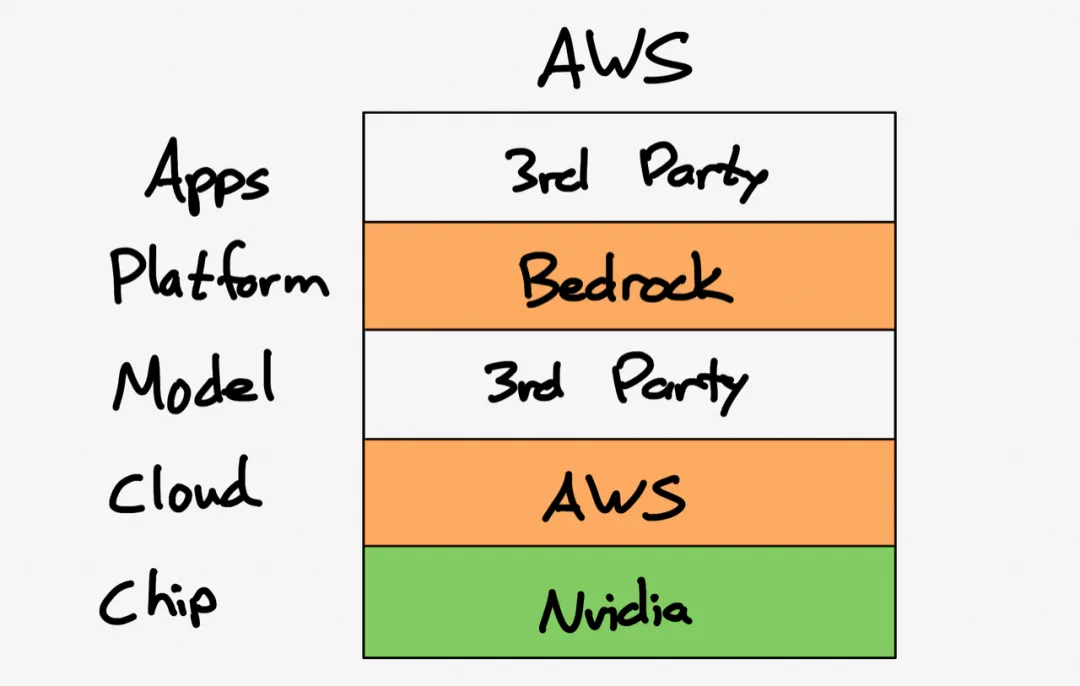

另一个极端是 AWS,它没有自己的模型;相反,它的重点是它的 Bedrock 托管开发平台,这个平台允许使用任何模型。亚马逊的另一个重点是开发自己的芯片,尽管它们的绝大多数 AI 业务都运行在 Nvidia GPU 上。

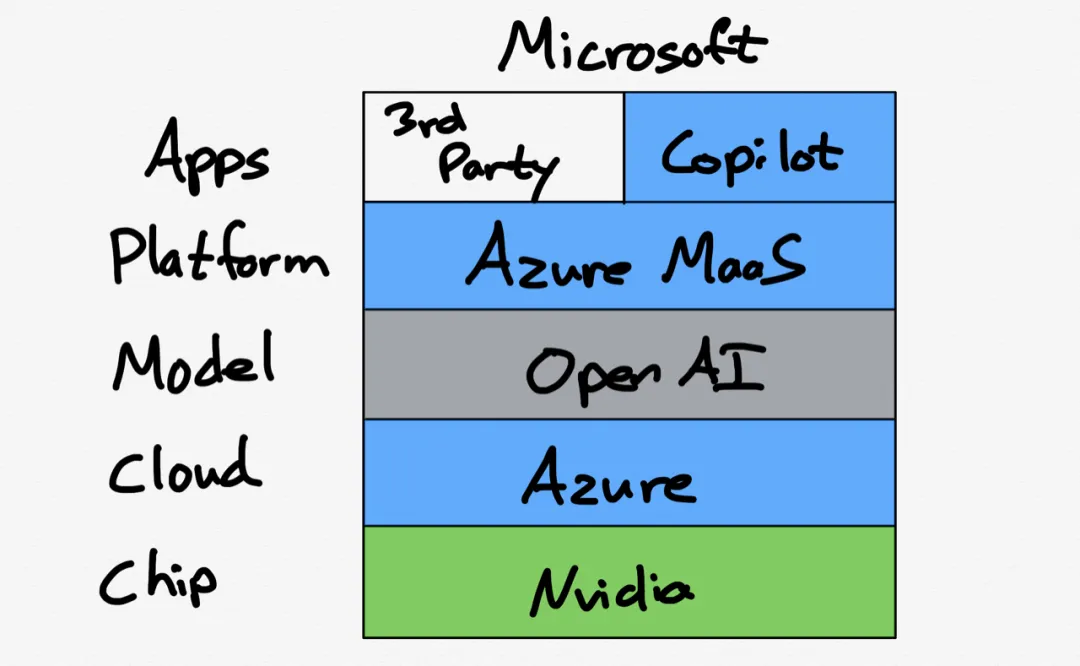

微软则位于中间,因为它与 OpenAI 建立了紧密的联系。公司去年推出了 Azure 模型即服务,但主要还是依赖 OpenAI 的 GPT 系列模型为外部客户和内部应用提供服务。微软也发布了自己的推理芯片,但绝大多数工作仍运行在 Nvidia 的芯片上。

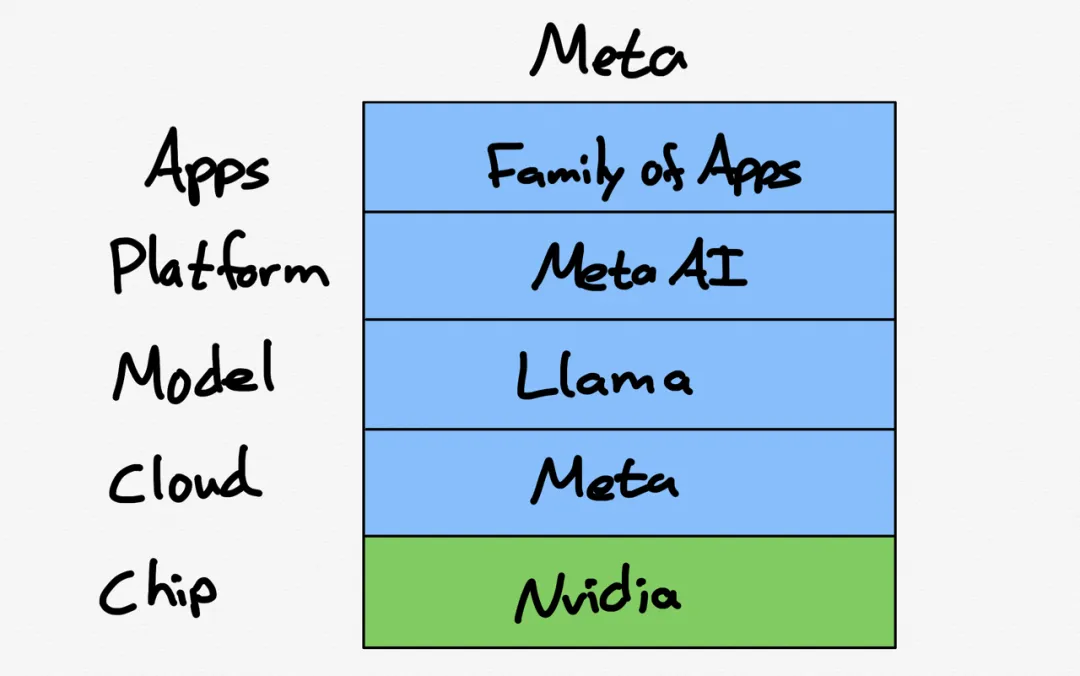

最后是 Meta,它只为自身开发;这意味着最重要的集成点在应用程序和模型之间。例如,Llama 3 为了优化低推理成本,愿意承担更高的训练成本。这也意味着 Meta 可以完全跳过托管服务层。

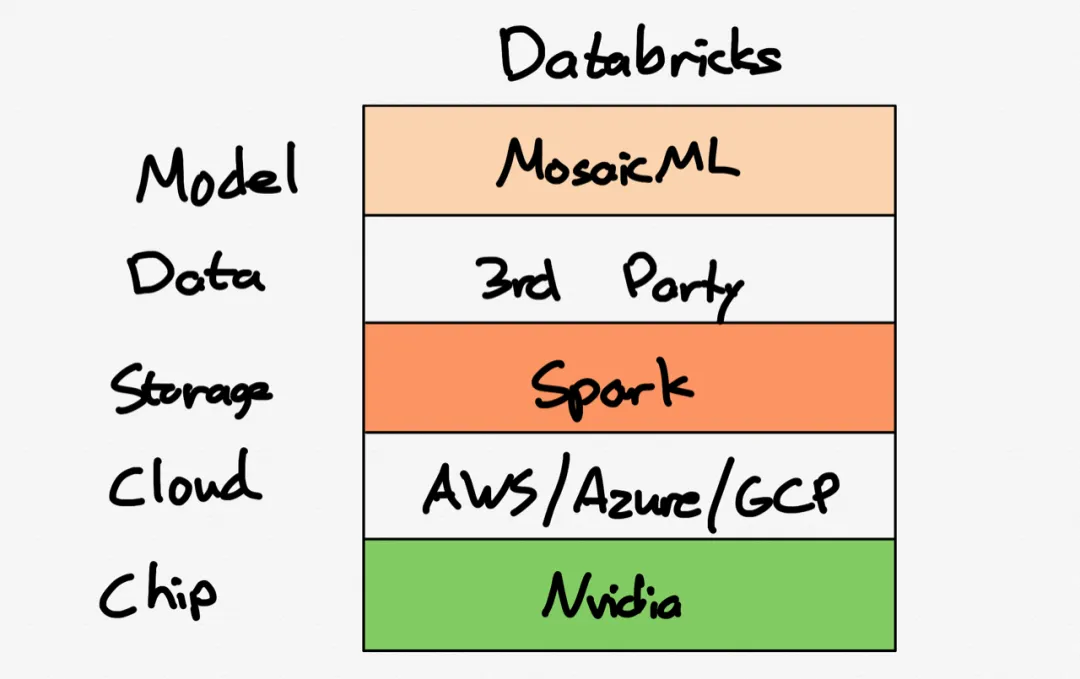

另外一家值得关注的公司是 Databricks(我在本月初与它的 CEO 聊了聊)。通过收购 MosaicML,Databricks 可以帮客户在自己的数据上训练自己的大语言模型,这些数据当然存储在 Databricks 上,而 Databricks 本身则在超大规模云服务提供商上运行。」

Databricks 值得关注,因为数据和模型是其集成的关键点。它将数据放在首位。

从以上分析中得出的第一个结论是,谷歌的战略确实是独一无二的:他们是 AI 界的「苹果」。更大的问题是「这是否重要」:集成化已被证明在以下两方面是可持续的差异化因素:

(1)在消费者市场中,买家是用户,因此他们重视集成带来的用户体验收益;以及(2)当这些用户体验到的好处体现在设备上时。

谷歌当然正在为消费市场打造产品,但这些产品不是设备,而是互联网服务。你可能已经注意到了,前面的讨论并没有真正提到互联网服务。谷歌和 Meta 是互联网时代的两大赢家,它们的服务都是建立在普通硬件上的。虽然这些服务的扩展得益于两家公司深入的基建工作,但谷歌的定制化方法至少与 Meta 的开放方法一样有效。值得注意的是,这两家公司都在集成他们的模型和应用程序,OpenAI 的 ChatGPT 也是。

谷歌面临的第二个问题是,他们是否还擅长制造产品?苹果之所以如此引人注目,部分原因是,他们不仅是一家集成公司,而且能做到,在不断发布突破性新产品(如 Apple Watch 和 AirPods)的同时,还能长期保持高标准。可能是因为,比起用户免费访问的聚合平台,销售硬件更需要每年都做到完美,来证明消费者的高额支出是合理的,这更能激励企业表现出色并保持执行力。

在这里,我也要强调在谷歌「真正登月计划」*的潜力:它的 Pixel 手机是垂直整合的 iPhone 的竞争对手。

*编者注:谷歌「真正登月计划」是 Ben Thompson 在 Stratechery 上提出的概念,指谷歌追求的高风险、高回报的创新项目,如开发先进的 AI 模型(如 Gemini)等,这些项目利用到谷歌庞大的数据资源和基础设施。

谷歌的一系列登月计划——从 Waymo 到 Google Fiber、Nest、Project Wing、Verily 和 Project Loon 等——大多是科学项目,这些项目大部分将谷歌搜索的利润转移开来,让股东无法受益。Waymo 可能是最引人注目的,但即使成功也不过是一个汽车服务,与谷歌「组织世界信息并使其普遍可用和有用」的使命相距甚远。

但是,如果使命宣言一直都是「登月计划」怎么办?如果谷歌的 AI 助手非常强大且自然,任何人都可以无缝使用它,会发生什么呢?

这无疑是唯一真正让苹果害怕的事。Android 相对于 iOS 虽然有其优势,但对大多数人来说并不是特别重要,甚至对于那些在意这些优势的人(比如我),它们也不足以让我们放弃 iOS 优越的用户体验。

推动平台市场份额发生显著变化的唯一因素是范式转变,虽然我怀疑 Pixie(谷歌传闻中的 Pixel-only AI 助手)的 v1 版本是否足以让 iPhone 用户转投 Pixel,但至少有一条路确实能做到这一点。

当然,Pixel 必须首先在 Android 领域取得成功,这需要谷歌在市场推广上进行大规模投资,特别是开设商店、补贴运营商和提升产能。这不便宜,这就是为什么谷歌还没有真正投资让 Pixel 成为智能手机领域重要玩家的原因。

然而,潜在的回报是巨大的:一个到处都有 Pixie 的世界意味着谷歌不仅能通过销售硬件赚钱,还能为企业和学校提供服务,并利用谷歌的基础设施为企业提供相同功能的云服务。此外,这是一个谷歌真正一体化的世界:该公司已经在其手机和数据中心制造芯片,制造模型,并利用世界上最大的数据集来完成这一切。

*引自 Google's True Moonshot 原文:https://stratechery.com/2023/googles-true-moonshot/

谷歌最近的重组显示出这种趋势,尽管谷歌 I/O 并没有暗示这一战略转变即将到来;相反,重点放在了新的 AI 驱动的搜索体验上,结果显然是喜忧参半。

事实上,谷歌因为 AI 回答不准确而被无情地嘲笑,这说明了为何面向消费者的 AI 可能会对公司产生颠覆性影响:现有的大公司很难应对这种颠覆性技术,因为一开始这些技术通常不适合他们的核心业务。时间会证明这是否会推动谷歌在智能手机策略上的转变,或者让公司变得更加谨慎。

企业市场是另一回事:尽管我对谷歌的企业宣传印象深刻,因为它可以利用谷歌的基础设施整合优势,而不必担心对现有产品造成干扰,但要克服数据引力却很难。许多企业客户会觉得,在他们已经存储数据的云上使用 AI 服务更方便(当然,谷歌也支持非 Gemini 模型和 Nvidia GPU)。谷歌在企业市场的成功可能在于吸引那些以 AI 为先、数据量少的新一代初创公司;这些新公司可以自由选择基础设施和集成方案。

亚马逊的云计算服务 AWS 提供了许多模块化的工具和服务,企业可以根据自己的需要自由组合和使用,这本身就像人工智能价值链一样,一切都是模块化的,最终都是商品。因此,亚马逊可能看中「数据引力」的重要性,更愿意在已存储数据的同一平台上使用 AI 服务。

然而,很难区分这种观点是对战略格局的正确判断,还是因为它恰好符合亚马逊的优势和劣势,包括其针对标准化任务进行了优化的基础设施。

微软处于中间位置,但这并不完全是出于选择。去年 10 月,在微软的财报电话会议上,纳德拉谈论了公司如何围绕 OpenAI 优化其基础设施:

我们采取的方法是全栈方法,无论是 ChatGPT、Bing Chat 还是我们所有的 Copilot,都共享同样的模型。因此,我们在做的是对我们使用的、训练的以及正在大规模推理的模型非常、非常、非常高效地利用。这种优势会一直渗透到内部利用和第三方利用,而且随着时间的推移,堆栈优化会一直延伸到芯片的设计和优化,因为开发人员所在的抽象层比低级内核要高得多。

我们将拥有所有可用的 Copilot 和 Copilot 堆栈。这并不意味着我们没有人为开源模型或专有模型进行培训。我们还有很多开源模型。我们进行了一系列微调,进行了一系列 RLHF。所以人们使用它的方式有很多种。但问题是,我们对一个经过训练的大型模型和一个用于所有第一方 SaaS 应用程序以及 Azure AI 服务中的 API 进行推理的大型模型进行了规模利用……

所以,我觉得我们的基本策略是技术上的,我们提供了 Copilot 和完整的 Copilot 堆栈。这并不意味着我们不做开源模型或训练专有模型,我们也有很多开源模型,进行了一系列 RLHF。所以人们使用它的方式有很多种。但关键是,我们有一个大模型已经训练好了,并且用这个大模型来做推理,覆盖了我们所有的第一方 SaaS 应用和 Azure AI 服务的 API…

我们从云计算业务中学到的教训是——我们不是在经营各种不同的业务,而是整个微软的产品组合都依赖于一个统一的技术栈。我觉得这点非常重要,因为在这次 AI 转型中,如果企业在资本支出上不严格控制,可能会有麻烦。

然后,一个月后,OpenAI 发生了混乱的 CEO 人事变动事件。微软不得不面对这样一个现实:将你的战略固定在你无法控制的合作伙伴上非常危险。因此,微软的大部分言论和行动都转向了将模型抽象化,希望通过提供统一的接口和服务,让用户无需了解模型的内部工作原理即可使用模型,特别是通过自己的云平台 Azure 提供托管的 AI 服务,这种方式更类似于亚马逊的策略。

我猜微软其实更想走整合的路线,或许现在仍在尝试这么做(比如通过收购来建立自己的模型团队),但为了安全起见,他们不得不分散风险,对冲赌注。

这一切对英伟达来说都是好消息。

大语言模型崛起后,英伟达的「CUDA 护城河」已经被削弱。当前,AI 开发的绝大多数工作已经不再主要依赖 CUDA 库,而是在大语言模型上进行。这意味着,从理论上讲,其他 GPU 提供商,比如 AMD 或那些超大规模计算服务商的内部研发,更有可能削弱英伟达的市场主导地位和利润率。

不过,英伟达并没有满足于现有的优势:公司正在使其 GPU 变得更加灵活,并承诺下一代芯片的配置将是当前一代的两倍,包括重新重视以太网网络。这种策略将最大限度地扩大英伟达的潜在市场,带来更多收入,并将这些收入重新投入到每年一更新的迭代周期中,确保英伟达在竞争中继续保持领先。

至少在短期内,我怀疑克服这种性能优势的唯一方法,将是通过像谷歌这样的真正的垂直整合;换句话说,虽然谷歌的 TPU 仍将是一个强大的替代品,但我怀疑超大规模内部芯片工作在可预见的未来是否会成为主要威胁。如果没有全栈集成,这些努力基本上就会沦为试图制造比 Nvidia 更好的芯片,但这很难,就连 AMD 也发现,其 GPU 销售额的很大一部分是由于 Nvidia 的稀缺性造成的。

我认为,至少在短期内,克服英伟达这种性能优势的唯一方法是,像谷歌这样真正的垂直整合。换句话说,虽然谷歌的 TPU 仍然是一个强有力的替代品,但我怀疑,超大规模计算服务商的内部芯片研发可能在可预见的未来对英伟达构成主要的威胁。如果没有全栈集成,这些努力基本上就只是试图制造比英伟达更好的芯片,这可不容易。就连 AMD 也发现,他们相当大一部分 GPU 销售是因为英伟达的供应不足。

这也解释了 Meta 为什么会开源 Llama:Meta 专注于能从整合中受益的产品,但开源也带来了广泛使用的好处,特别是在优化和补充软件方面。开源可以获得这些好处,也不会影响 Meta 对产品的投入(而且,别忘了 Meta 还从为 Llama 模型提供服务的超大规模计算服务商那里获得一部分收入)。

苹果公司似乎和亚马逊一样,认为 AI 会成为一种功能或应用程序;但和亚马逊一样,我们还不确定这究竟是战略远见,还是只是因为这样想对它们有利。

不过,这确实涉及到了最大的问题:大语言模型已经非常了不起,但要将现有的功能完全产品化,还需要多年的努力;更好的大语言模型是否不仅能颠覆搜索,还能颠覆整个计算领域?如果答案是肯定的,那么谷歌的集成方法将更具优势,原因如克里斯滕森所说:实现接近通用人工智能(AGI)的目标,无论具体指什么,都需要最大化效率和优化,这将使整合的方法更具优势。

我对此持怀疑态度:我认为模型肯定会有所不同,但差异不会大到足以不能被视为商品。最有价值的将是构建平台,把模型像处理器一样对待,为开发人员提供性能改进,而他们无需了解底层的工作原理。这意味着最大的收益将来自横向扩展——包括 API 层、模型层和 GPU 层——而不是垂直整合。

谷歌需要证明我是错的。

文章来自于微信公众号 “Founder Park”,作者 “Founder Park”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner