徐海洋,阿里通义实验室高级算法专家,负责通义多模态大模型mPLUG系列工作,包括基础多模态模型mPLUG/mPLUG-2,多模态对话大模型mPLUG-Owl/Owl2,多模态文档大模型mPLUG-DocOwl,多模态智能体Mobile-Agent等,其中 mPLUG 工作在 VQA 榜单首超人类的成绩。在国际顶级期刊和会议ICML/CVPR/ICCV/ACL/EMNLP/MM/TOIS/IJCAI/AAAI等发表论文30多篇,并担任多个顶级和会议AC/PC/Reviewer。主导参与开源项目mPLUG,X-PLUG,AliceMind,DELTA。

今年年初发布的Mobile-Agent凭借强大的自动化手机操作能力,引起了AI界和手机厂商的广泛关注,仅5个月的时间就已在Github上收获了2,000个Star。

Mobile-Agent基于纯视觉方案,通过视觉感知工具和操作工具实现智能体在手机上的操作,而不依赖其他系统级别的UI文件。借助智能体中枢模型强大的操作能力,Mobile-Agent无需训练和探索,能够实现即插即用。

近日,该团队完成了Mobile-Agent版本更新,发布了Mobile-Agent-v2,并宣称有几大亮点:

目前,Mobile-Agent-v2的论文和代码均已发布。

除此之外,Mobile-Agent-v2也已经接入到魔搭的ModelScope-Agent中,可以通过下面的链接了解详细内容:

内容链接:https://github.com/modelscope/modelscope-agent

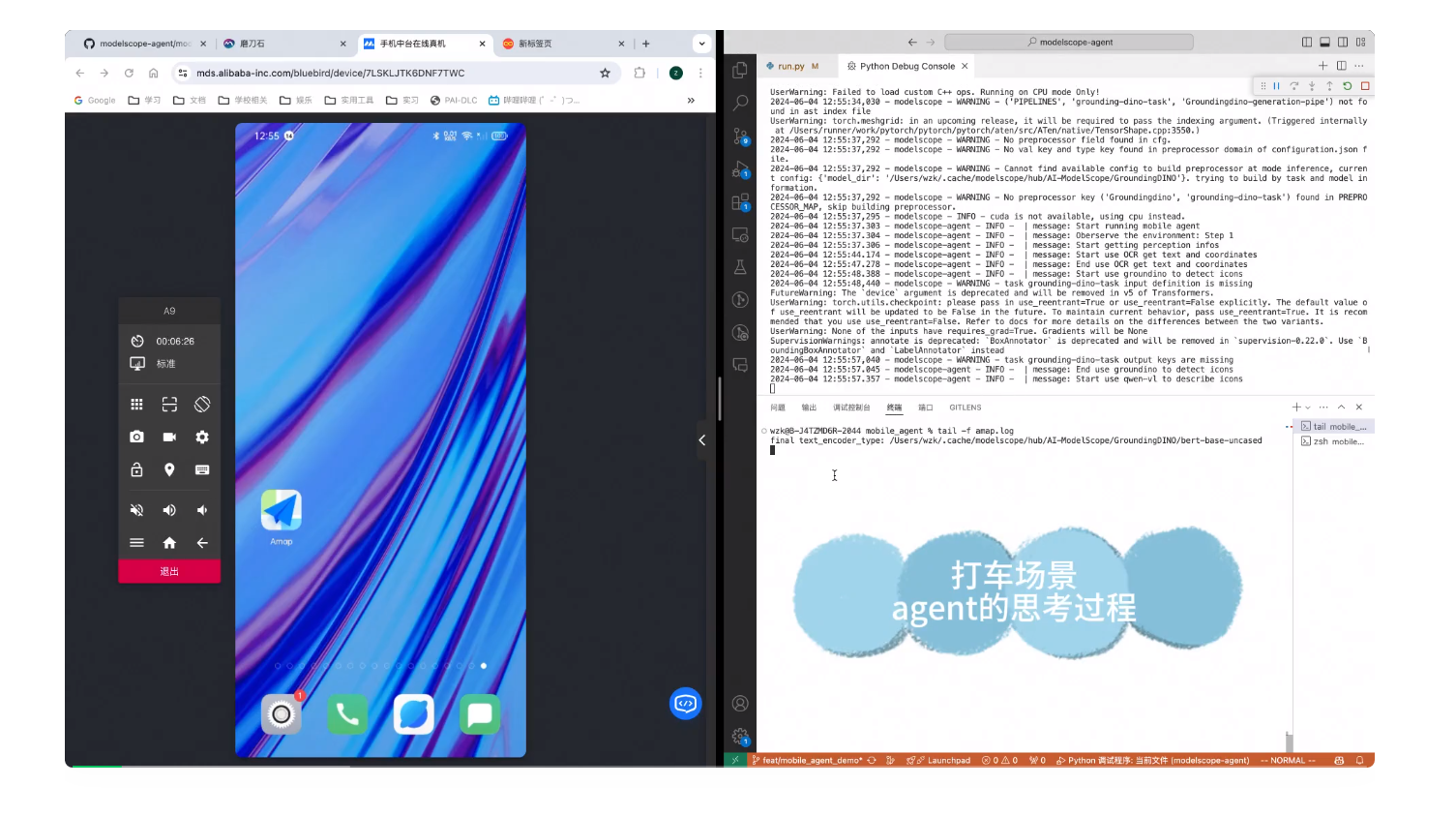

从魔搭团队公布的演示视频来看,ModelScope-Agent已经可以通过调用Mobile-Agent-v2可以完成自动化打车任务。用户只需要把目的地输入给Agent,便能够实现规划、决策和反思的流程来帮用户完成叫车,适用于老人及视障人群,解决他们不会使用或者无法使用手机APP的问题。

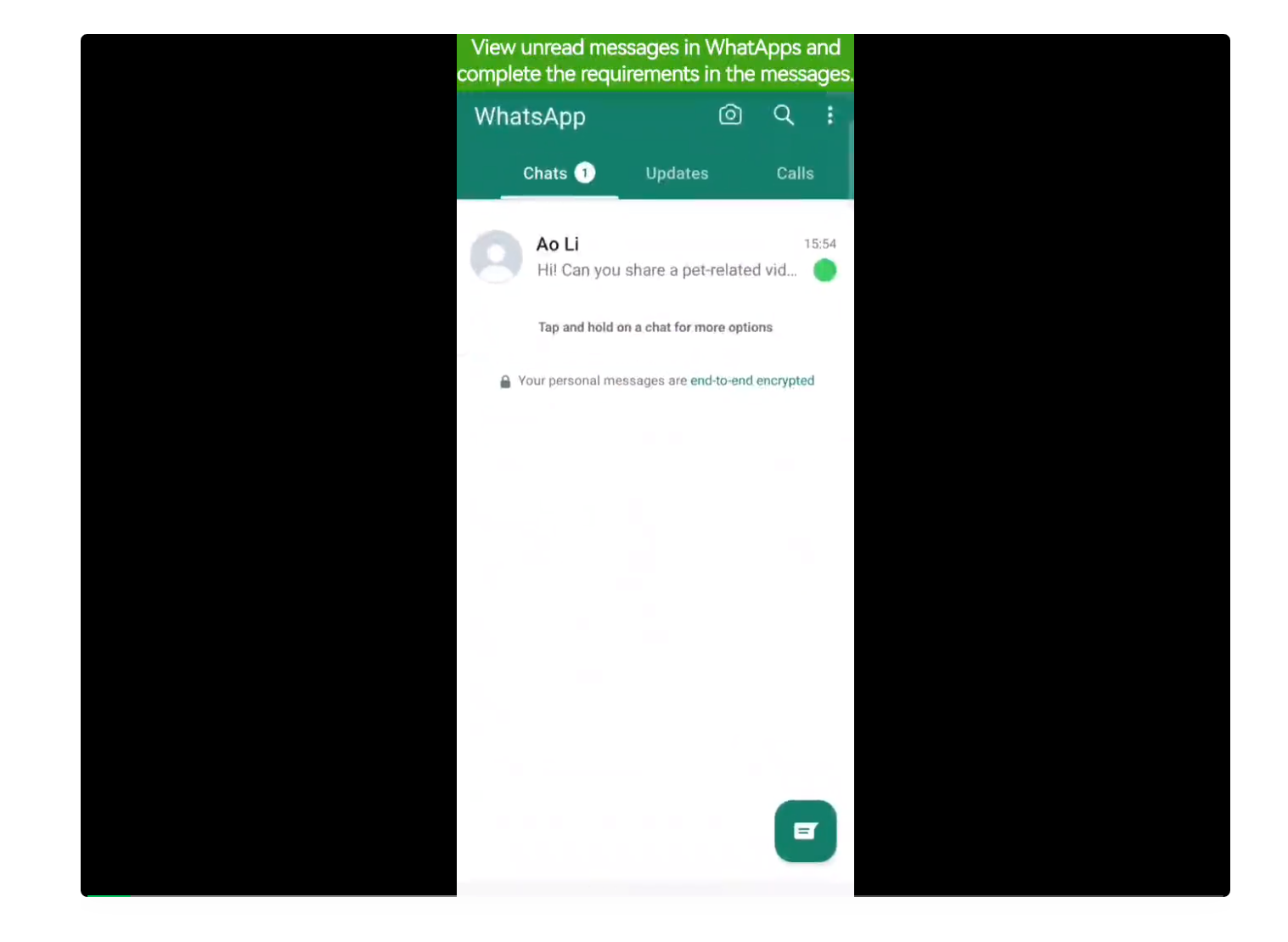

作者团队同样公布了Mobile-Agent-v2在手机上实操的演示视频。首先是一个跨应用操作的例子。用户需要Mobile-Agent-v2查看聊天软件中的未读消息,然后按照消息的要求完成任务。

Mobile-Agent-v2先根据指令要求打开了WhatApps并查看了来自「Ao Li」的消息,消息中要求在TikTok中找一个宠物相关的视频并分享给他。Mobile-Agent-v2随后退出当前应用并进入TikTok中刷视频,在找到一个宠物猫的视频后通过点击分享按钮将视频链接成功发送给「Ao Li」。

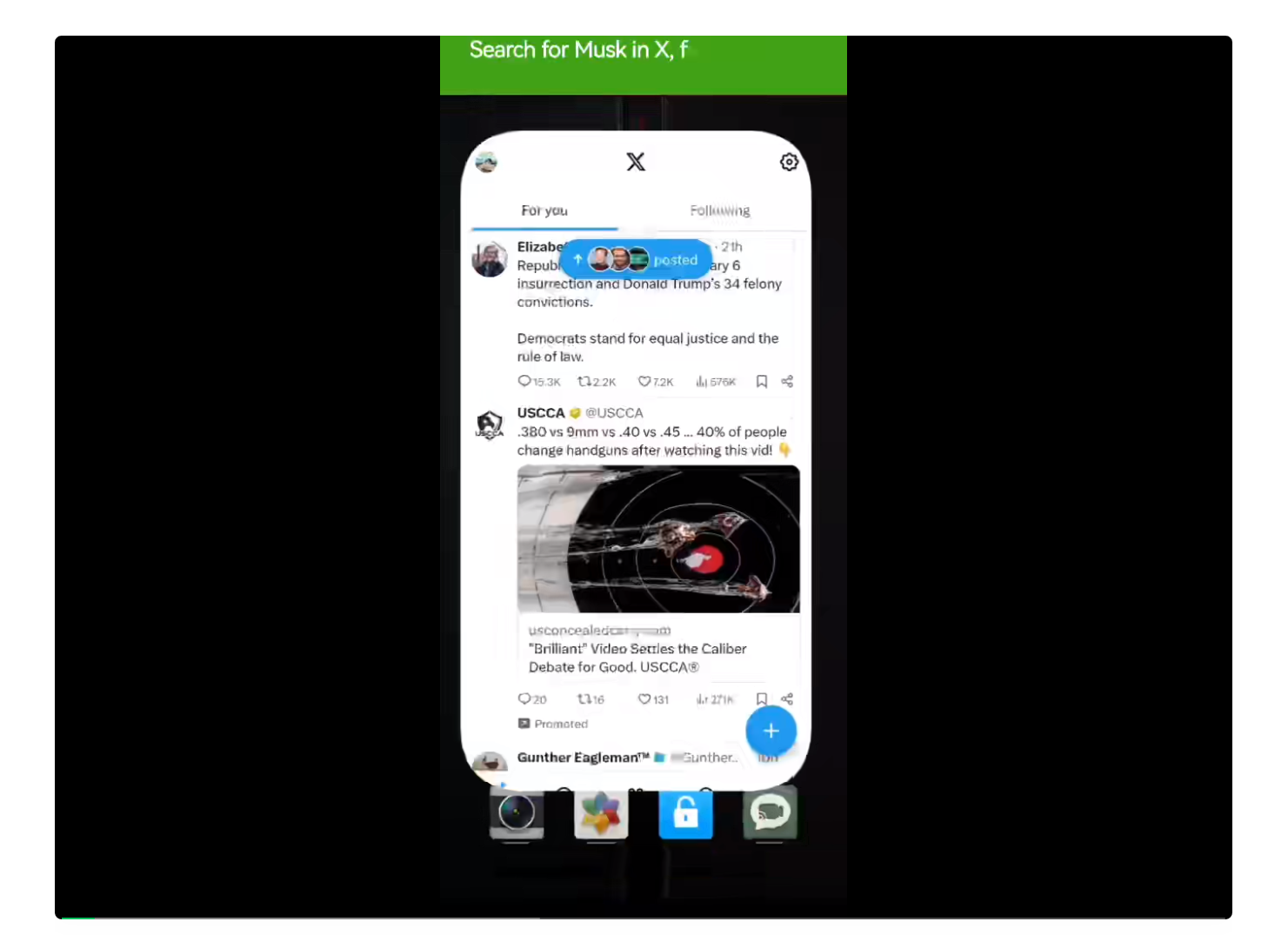

下面是一个在社交媒体应用中的例子。用户要求Mobile-Agent-v2在X(推特)中搜索名人「马斯克」,关注他并评论一条他发布的帖子。由于社交媒体应用往往文字较多,UI布局复杂,因此操作难度较大。而从视频中可以看出,Mobile-Agent-v2准确地完成了每一步的操作,尤其是点击关注之后出现的推荐用户挡住了原本的推文,而Mobile-Agent-v2也执行了上划操作并完成评论。

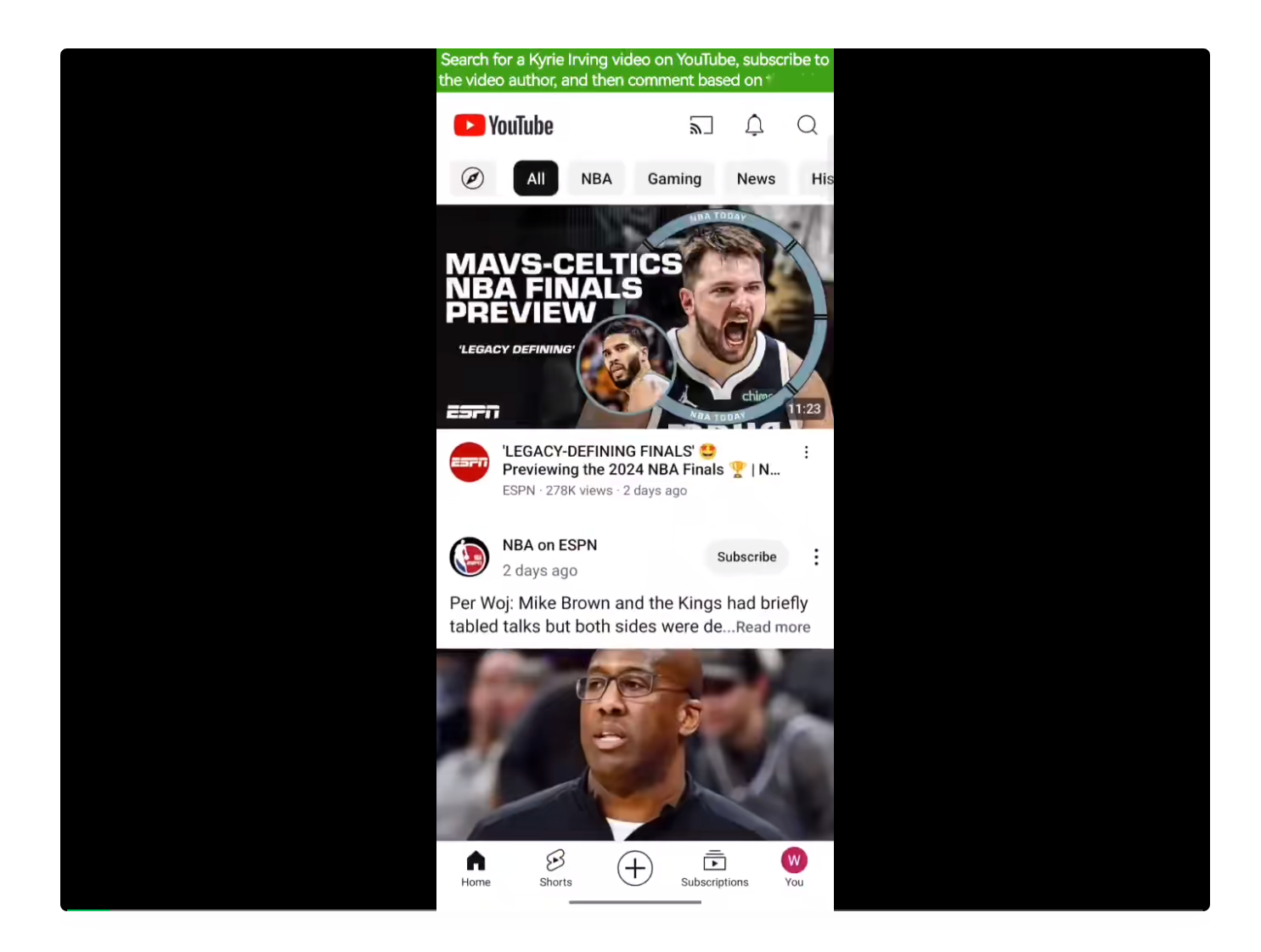

随后是在同样复杂的长视频平台YouTube操作的例子。从上述演示视频来看,Mobile-Agent-v2对于社交媒体和视频平台的操作能力十分惊艳,有成为新一代控评机器人的潜力。

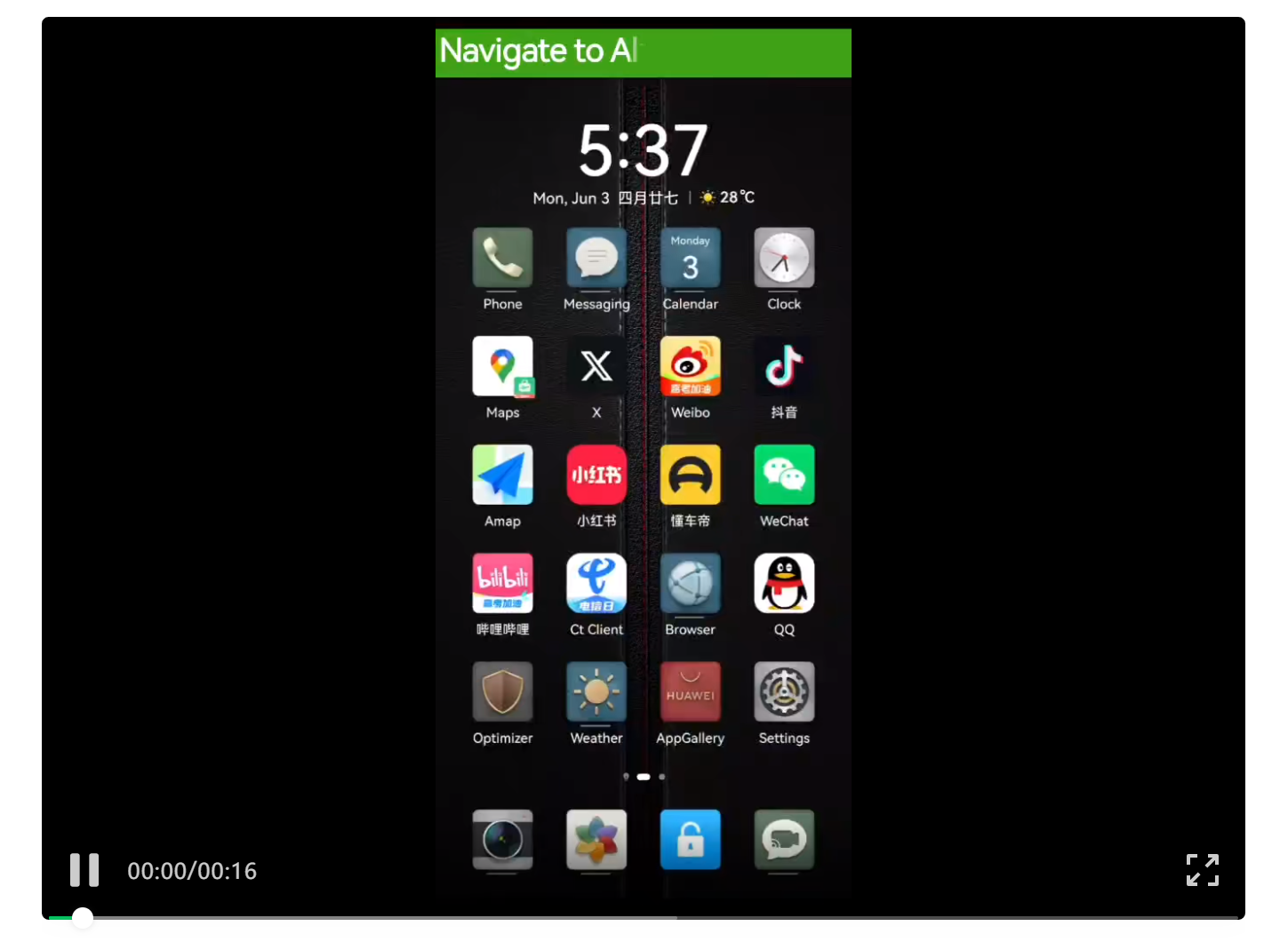

另外,在初代Mobile-Agent中评测的那些相对基础的任务,例如安装应用、导航去某个地点等,Mobile-Agent-v2也能完成。

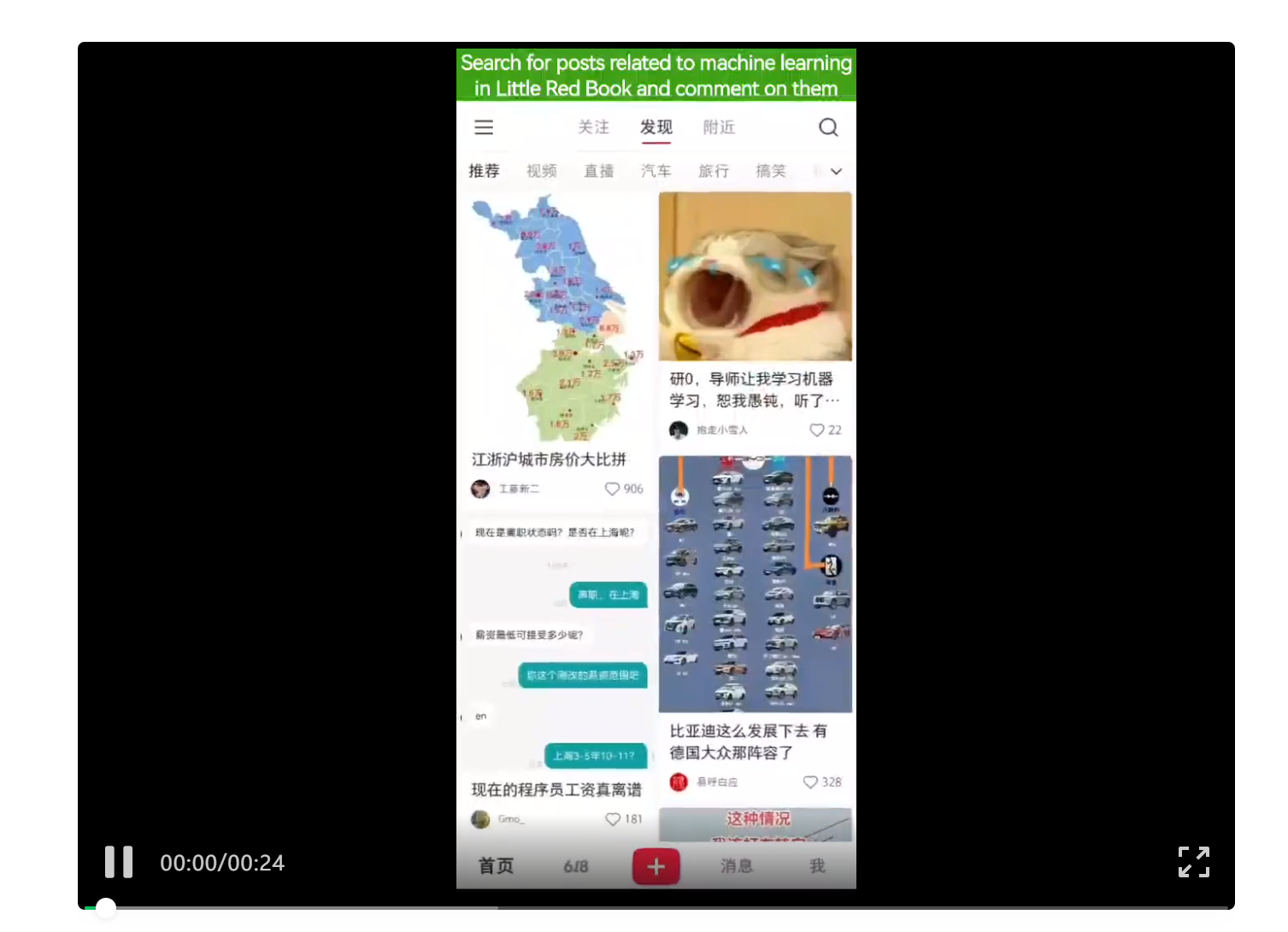

最后则是在中文应用小红书和微信的例子,包括在小红书中搜索攻略并评论,以及帮助用户回微信。Mobile-Agent-v2可以根据帖子的内容发布相关的评论,也能根据微信消息的内容生成相关的回复。

下面将介绍Mobile-Agent-v2的技术实现。在手机操作任务中,智能体通常需要通过多步操作才能完成任务要求。每次操作时,智能体都需跟踪当前任务进度,即了解之前的操作完成了哪些需求,从而根据用户指令推断下一步的操作意图。

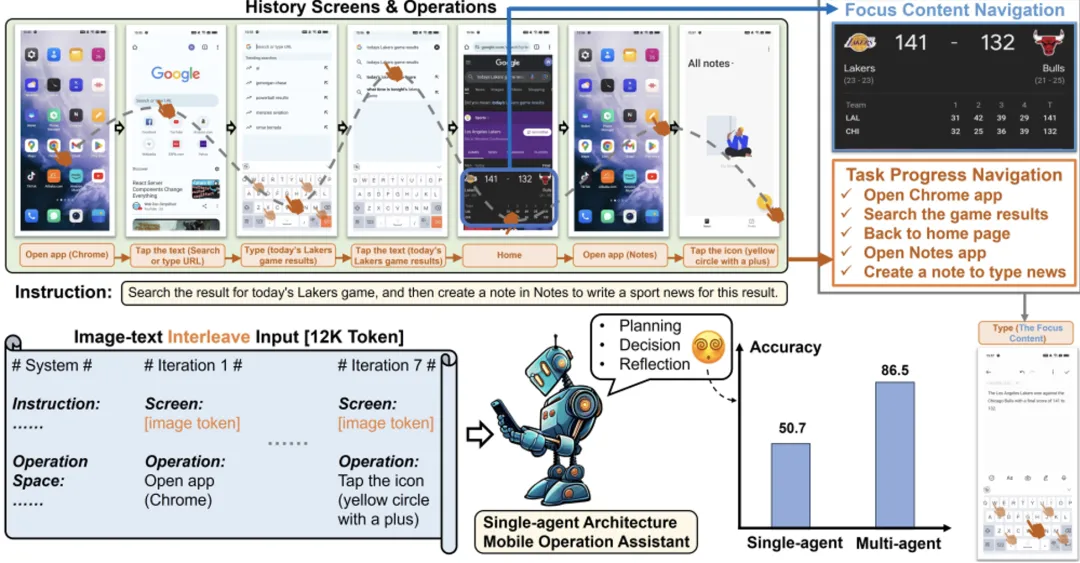

尽管操作历史中保存了每一步的具体操作和相应的屏幕状态,但随着操作次数的增加,操作历史序列会变得越来越长。操作历史的冗长且图文交错的格式,会显著增加智能体追踪任务进度的难度。

如下图所示,经过7轮操作后,输入的操作历史序列长度已超过一万个token,图文交错的数据格式使得智能体追踪任务进度变得异常困难。

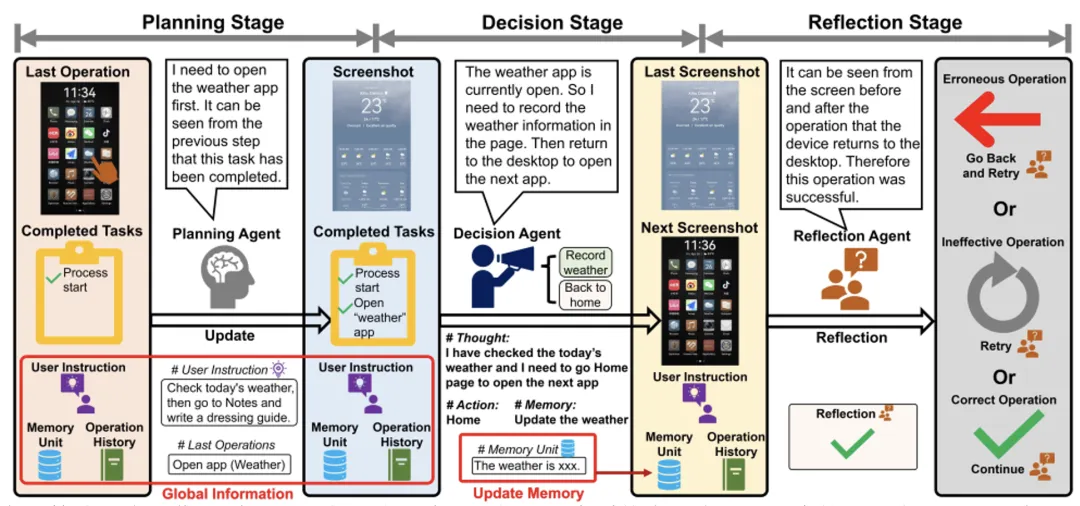

为了解决这个问题,Mobile-Agent-v2引入了规划智能体,其角色如图所示。这个智能体会为操作智能体提供任务进度,将冗长的操作历史转化为纯文本。然而,虽然规划智能体简化了任务追踪,但也导致屏幕信息的丢失,使得决策智能体无法从历史屏幕中获取任务相关的信息。

例如,在某些任务中,智能体需要查看天气并撰写穿衣指南,而生成指南时,需要利用历史屏幕中的天气信息。为此,Mobile-Agent-v2引入记忆单元,决策智能体负责更新这些单元内的任务相关信息。此外,由于决策智能体无法直接观察操作后的屏幕信息,Mobile-Agent-v2还加入了反思智能体,负责监测决策智能体操作前后的屏幕状态变化,并判断操作的正确性。

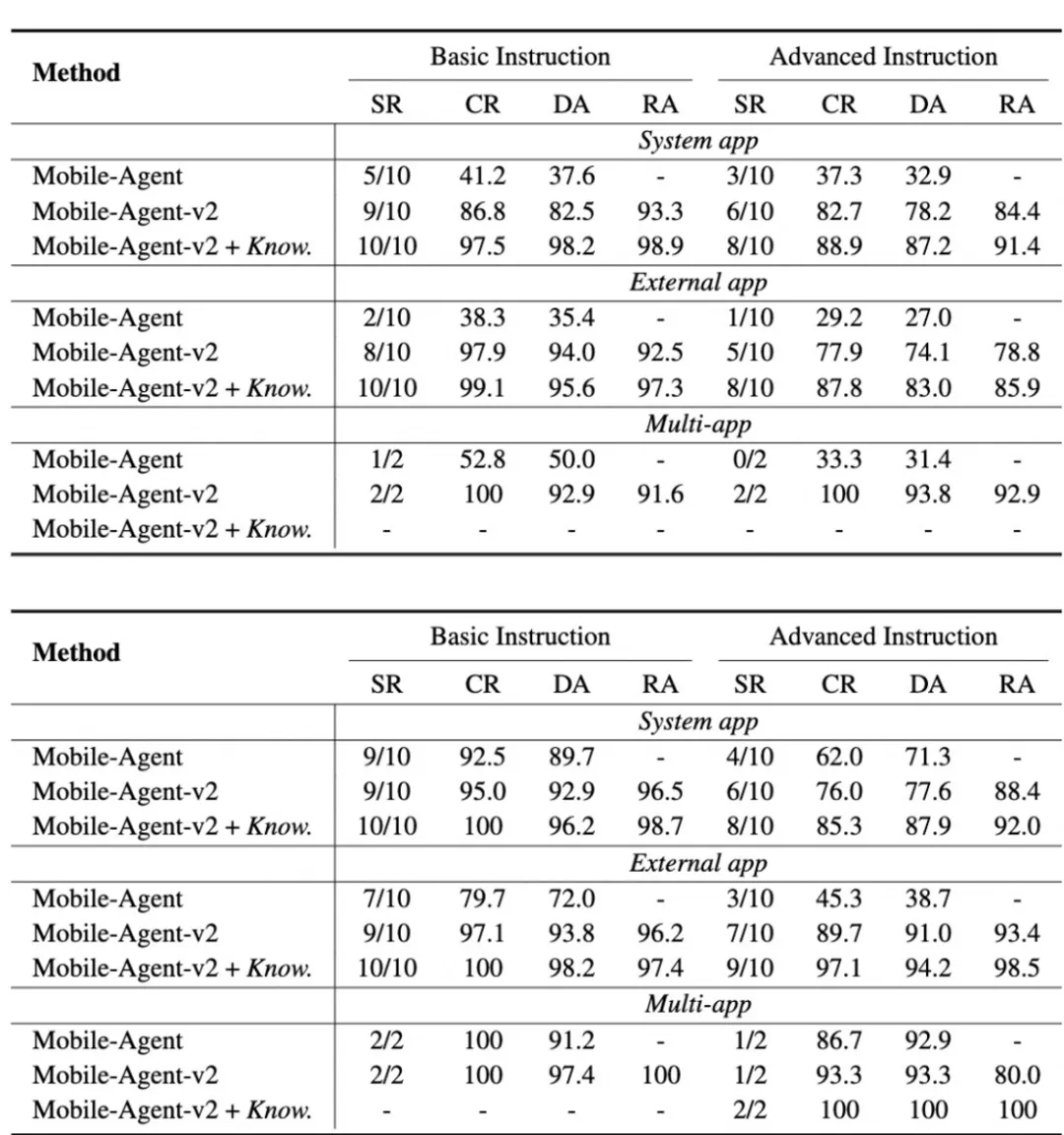

在这篇论文中,作者采用了动态评估方法,选择了五个系统内置应用和五个第三方应用,分别在英文和非英文应用上进行测试。每个应用设计了两条基础指令和两条进阶指令。同时,针对跨应用操作也设计了两条基础指令和两条进阶指令。评估结果如表所示,涵盖了英文和非英文场景。

从结果中可以看出,无论在英文还是非英文场景,Mobile-Agent-v2在基础指令和进阶指令的多个指标上都表现出了全面提升。此外,通过人为引入额外的操作知识(Mobile-Agent-v2 + Know.),性能得到了进一步提升。

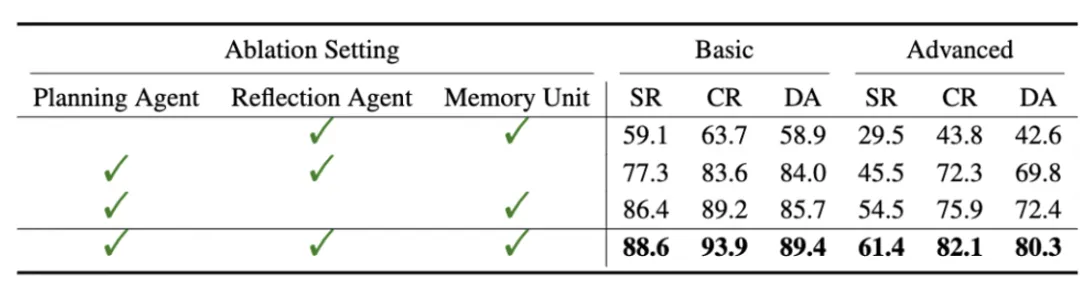

作者在文章中展示了消融实验的结果,如下表所示,在去除规划智能体、决策智能体和记忆单元后,整个智能体的性能都出现了下降。

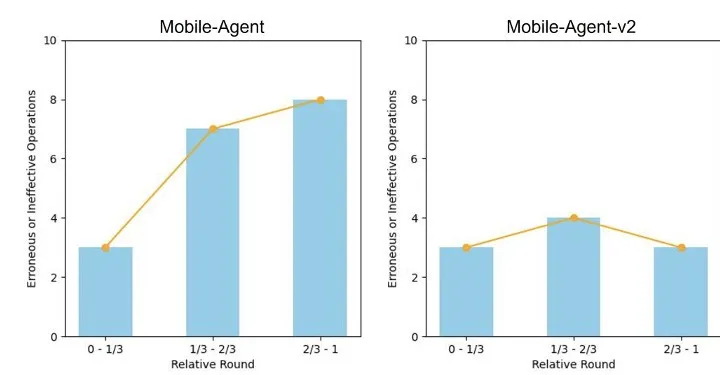

如下图所示,通过分析操作失败的任务,作者发现Mobile-Agent的失败操作大量集中在任务的后期,而Mobile-Agent-v2的失败操作则较为平均分布。这表明Mobile-Agent-v2能够更有效地应对长序列带来的问题。

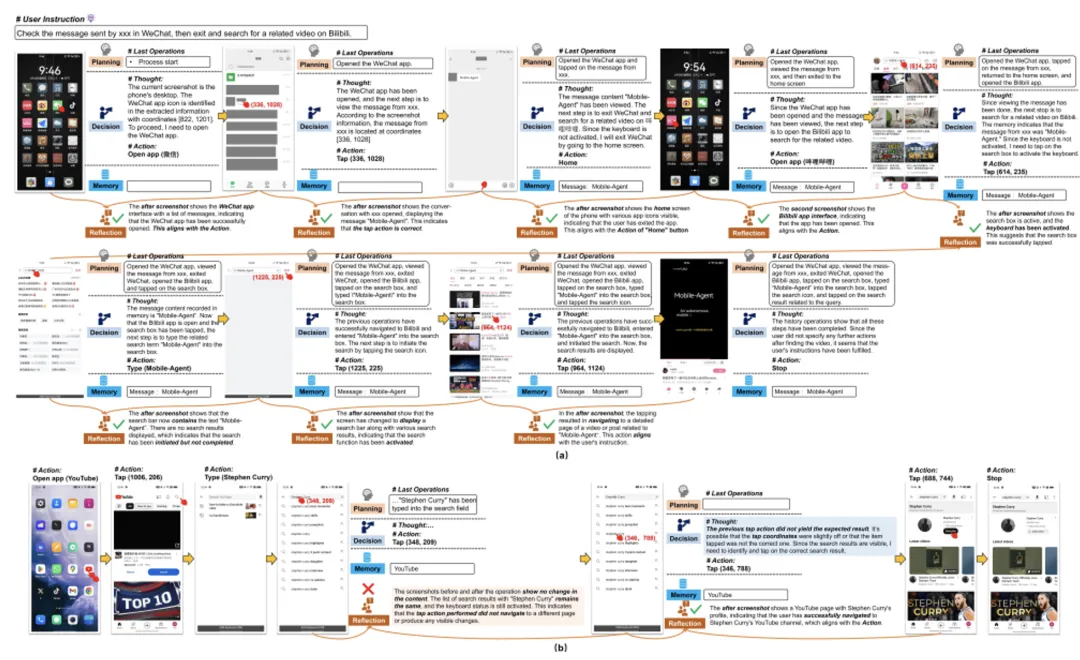

最后,文章展示了一个完整的操作流程和一个成功反思的例子,其中包含每个角色的输出。更多的例子展示在原论文的最后部分。

文章来源于“机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file